来源:专知

本文为论文介绍,建议阅读5分钟

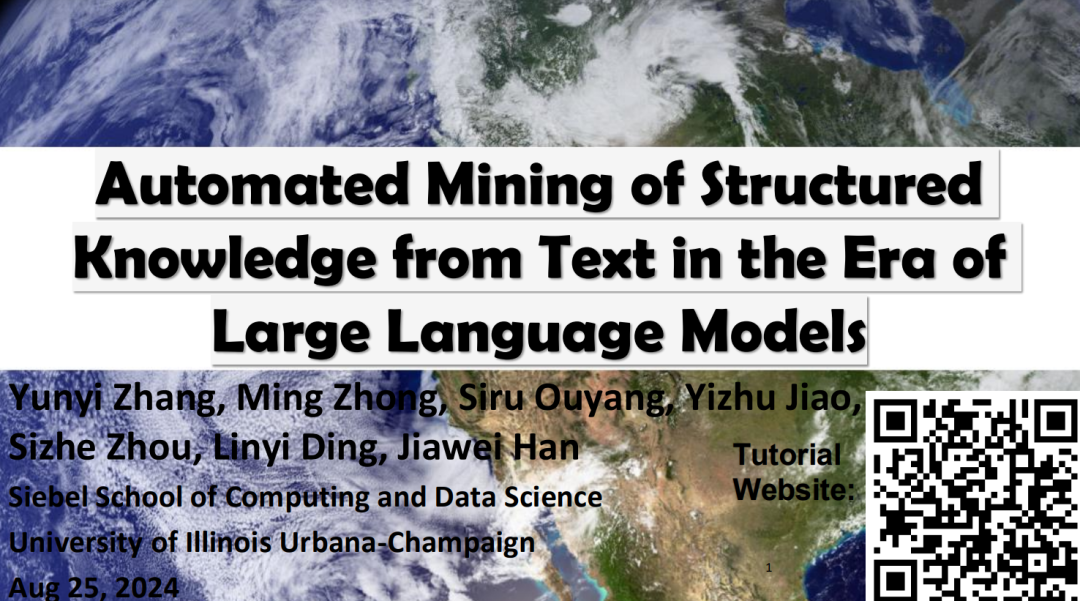

在本教程中,我们将介绍使用语言模型进行结构化知识挖掘的最新进展,重点介绍弱监督学习方法。

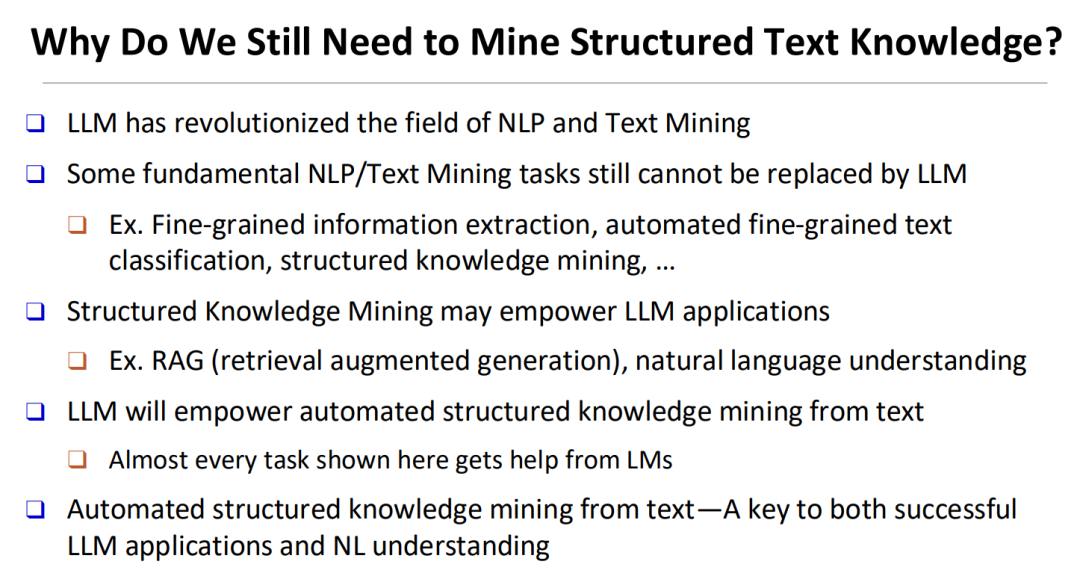

每天都会生成大量的非结构化文本数据,涵盖从新闻文章到科学论文等内容。如何从这些文本数据中挖掘结构化知识依然是一个关键的研究问题。最近,大语言模型(LLMs)凭借其卓越的文本理解能力和指令跟随能力,为文本挖掘领域带来了新的希望。通常有两种利用LLMs的方法:一是通过人工标注的训练数据对LLMs进行微调,这需要大量的人工投入,难以扩展;二是在零样本或少样本的情况下提示LLMs,这种方法无法充分利用海量文本数据中的有用信息。因此,在大语言模型时代,如何从海量文本数据中自动挖掘结构化知识仍然是一个挑战。

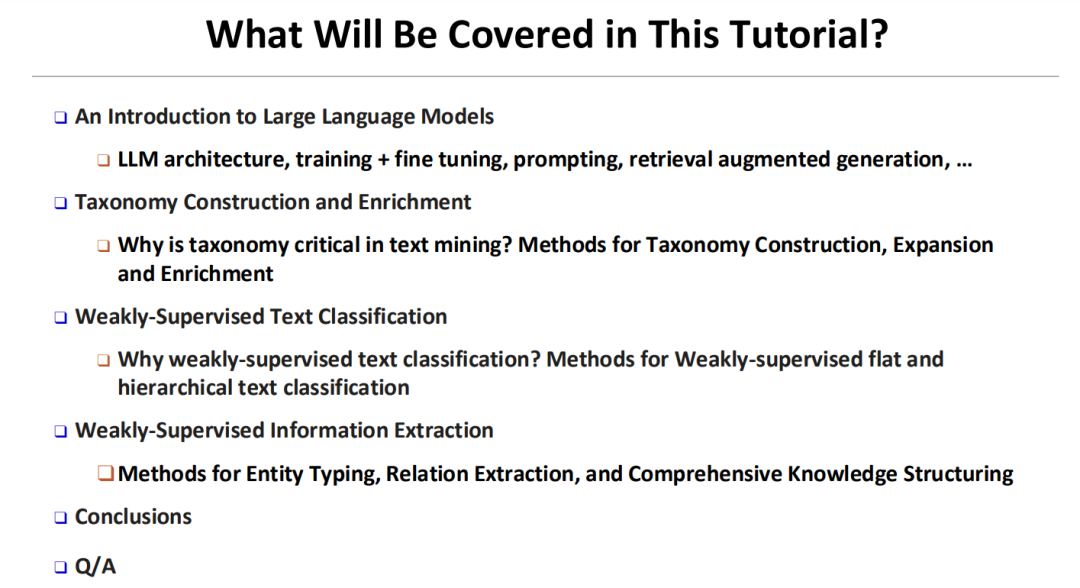

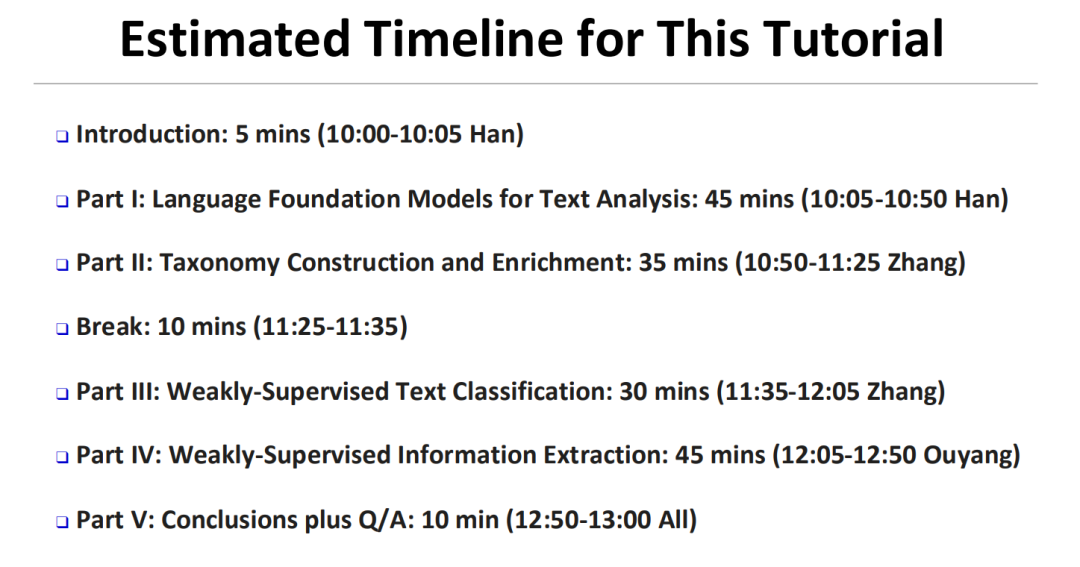

在本教程中,我们将介绍使用语言模型进行结构化知识挖掘的最新进展,重点介绍弱监督学习方法。我们将涵盖以下主题:

大语言模型的介绍,它是近期文本挖掘任务的基础;

本体构建,自动从海量语料库中丰富本体;

在平面和层次化标签空间中的弱监督文本分类;

弱监督信息抽取,提取实体和关系结构。

https://yzhan238.github.io/kdd24-tutorial/

幻灯片

介绍

第一部分:文本分析中的语言基础模型

第二部分:分类体系的构建与丰富

第三部分:弱监督文本分类

第四部分:弱监督信息抽取

结论

关于我们

数据派THU作为数据科学类公众号,背靠清华大学大数据研究中心,分享前沿数据科学与大数据技术创新研究动态、持续传播数据科学知识,努力建设数据人才聚集平台、打造中国大数据最强集团军。

新浪微博:@数据派THU

微信视频号:数据派THU

今日头条:数据派THU

4243

4243

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?