摘要联邦学习(FL)和分割学习(SL)是两种流行的分布式机器学习方法。两者都遵循模型到数据的场景;客户端无需共享原始数据就能训练和测试机器学习模型。由于机器学习模型架构在客户机和服务器之间分离,SL提供了比FL更好的模型私密性。此外,分割模型使SL成为资源受限环境的更好选择。然而,由于跨多个客户端基于中继的训练,SL的执行速度比FL慢。在这方面,本文提出了一种新的方法,称为分裂学习(SFL),它融合了两种方法,消除了它们固有的缺点,并结合了差分隐私和PixelDP的细化架构配置,以增强数据隐私和模型鲁棒性。我们的分析和实证结果表明,对于多个客户端,(纯)SFL提供了与SL相似的测试准确性和通信效率,同时显著减少了其每个全局epoch的计算时间。此外,与SL一样,它在FL上的通信效率随着客户端数量的增加而提高。此外,在扩展的实验设置下,进一步评估了具有隐私性和鲁棒性措施的SFL的性能.

分布式协作机器学习(DCML)由于其默认的数据隐私优势而很受欢迎。与数据集中存储和访问的传统方法不同,DCML支持机器学习,而无需将数据从数据保管人传输到任何不受信任的一方。此外,分析师无法获得原始数据;相反,机器学习(ML)模型被转移到数据管理器进行处理。此外,它可以在多个系统或服务器和分布式设备上进行计算。

最流行的DCML方法是联邦学习[13,19]和分裂学习[9]。联邦学习(FL)在分布式客户端上使用本地数据训练一个完整(完整)的ML模型,然后在服务器上聚合本地训练的完整ML模型,以形成一个全局模型。FL的主要优点是它允许在许多客户端之间并行地进行高效的ML模型训练。

FL的主要缺点是每个客户端都需要运行完整的ML模型,而资源受限的客户端(如物联网中可用的客户端)无法运行完整的模型。如果ML模型是深度学习模型,这种情况很普遍。此外,在训练过程中,从模型的隐私角度来看,还有一个隐私问题,因为服务器和客户端可以完全访问本地和全局模型。

为了解决这些问题,引入了分割学习(SL)。SL将完整的ML模型拆分为多个较小的网络部分,并在服务器上分别训练它们,并使用其本地数据进行分布式客户端。仅分配网络的一部分在客户端进行训练可以减少处理负载(与FL中运行完整网络相比),这在资源受限设备[24]上的ML计算中非常重要。此外,客户端不能访问服务器端模型,反之亦然。

SL中的训练时间开销。尽管SL有优势,但有一个主要问题。SL中基于中继的训练使客户端资源处于空闲状态,因为在一个实例中只有一个客户端与服务器进行交互;导致与许多客户的培训开销显著增加。

为了解决语言学习和语言学习中的这些问题,本文提出了一种新的结构,称为分裂学习(splitfed learning, SFL)。

SFL考虑了FL和SL的优点,同时强调了数据的私密性和模型的鲁棒性。与FL和SL的抽象比较见表1。我们的贡献主要有两个方面:首先,我们第一个提出了SFL。在SFL中,基于差异隐私的度量[1]和PixelDP[18]在架构级上增强了数据隐私和模型的鲁棒性。其次,为了证明SFL的可行性,我们通过考虑四个标准数据集和四个流行模型,比较了FL, SL和SFL的性能测量。基于我们的分析和实证结果,SFL提供了一个出色的解决方案,它提供了比FL更好的模型私密性,并且比SL更快,在模型精度和通信效率方面与SL表现相似.

总的来说,SFL对于资源受限的环境是有益的,在这些环境中,完整的模型训练和部署是不可行的,并且需要快速的模型训练时间来定期更新基于不断更新的数据集(例如数据流)的全局模型。这些环境具有不同领域的特征,包括健康,例如,通过网关和金融连接多个医疗物联网3的网络中的实时异常检测,例如,保护隐私的信用卡欺诈检测。

2 Background and Related Works

联邦学习[13,19,2]在每个客户机的本地数据上并行训练一个完整的ML网络/算法,训练一定数量的本地epoch,然后将本地更新发送到服务器进行聚合[19]。这样,服务器就形成了一个全局模型,并完成了一个全局epoch4。然后,全局模型的学习参数被发送回所有客户端,以进行下一轮的训练。这个过程一直持续到算法收敛为止。

在本文中,我们考虑联邦平均(FedAvg)算法[19]用于FL中的模型聚合。FedAvg考虑了模型更新的梯度的加权平均。

分割学习[24,9]将深度学习网络W分割为多个部分,这些部分在不同的设备上进行处理和计算。在简单的设置中,W分为WC和WS两部分,分别称为客户端网络和服务器端网络。数据所在的客户端只提交到网络的客户端部分,服务器只提交到网络的服务器端部分。通信包括将客户端网络的分裂层(称为切割层)的激活(称为粉碎数据)发送到服务器,并从服务器端操作接收粉碎数据的梯度。在SL[9]中,多个客户机之间的学习过程同步是在集中式模式或点对点模式下完成的。

3 The Proposed Framework

本节将介绍框架SFL。我们首先给出了SFL的概述。然后我们详细介绍了三个关键模块:(1)差分私有知识扰动,(2)用于鲁棒学习的PixelDP,以及(3)SFL的总成本分析。

3.1 Overall Structure

SFL结合了FL的主要优势,即分布式客户端之间的并行处理,以及SL的主要优势,即在训练期间将网络划分为客户端和服务器端子网络。参见图

用于SFL体系结构的表示。与SL不同的是,所有客户端并行地执行计算,并与主服务器和馈电服务器进行交互。客户端可以是计算资源较低的医院或医疗物联网,主服务器可以是云服务器或具有高性能计算资源的研究人员。引入联邦服务器在客户端进行FedAvg本地更新。此外,fed服务器在每一轮网络训练中同步客户端全局模型。美联储服务器的计算,主要是计算FedAvg,成本不高。因此,联邦服务器可以托管在本地边缘边界内。或者,如果我们通过加密信息在联邦服务器上实现所有操作,即基于同态加密的客户端模型聚合,那么主服务器可以执行联邦服务器的操作。

同声传译的工作流程。所有客户端并行地在其客户端模型(包括噪声层)上执行前向传播,并将粉碎的数据传递给主服务器。然后,主服务器在其服务器端模型上处理前向传播和后向传播,并使用每个客户机的破碎数据(在某种程度上)分别并行处理。然后,它将粉碎数据的梯度发送到各自的客户端进行反向传播。之后,服务器通过FedAvg更新其模型,即在每个客户端破碎数据的反向传播期间计算梯度的加权平均。在客户端,在接收到其粉碎数据的梯度后,每个客户端在其客户端本地模型上执行反向传播并计算其梯度。DP机制用于使这些梯度私有并将它们发送到联邦服务器。联邦服务器执行客户端本地更新的FedAvg,并将它们发送回所有参与的客户端。

基于服务器端聚合。本文提出了SFL的两种变体。第一个被称为splitfedv1 (SFL V1),在算法1和2中描述。下一个算法被称为splitfedv2 (SFL V2),它的动机是通过去除算法1中服务器端计算模块中的模型聚合部分来提高模型精度的直觉。在算法1中,所有客户端的服务器端模型分别并行执行,然后在每个全局历元进行聚合以获得全局服务器端模型。

相比之下,SFL V2根据客户端粉碎的数据顺序处理服务器端模型的前后传播(服务器端模型没有FedAvg)。客户端顺序在服务器端操作中随机选择,并且在每次向前向后传播中更新模型。此外,服务器同步接收来自所有参与客户端的粉碎数据。客户端操作与SFL V1中相同;fed服务器执行客户端本地模型的FedAvg,并将聚合的模型发送回所有参与的客户端。这些操作不受客户端顺序的影响,因为本地客户端模型是通过加权平均方法聚合的,即FedAvg。文献中也有其他一些SFL版本,但它们是在我们的方法之后开发的,并受到了我们的方法的影响[10,7]。

基于数据标签共享。由于SFL中的分离ML模型,我们可以在两种设置中进行ML;(1)向服务器共享数据标签;(2)不向服务器共享任何数据标签。算法1考虑数据标签共享的SFL。在没有共享数据标签的情况下,SFL中的ML模型可以划分为三个部分,假设设置简单。每个客户端将处理两个客户端模型部分;一个是W的前几层,另一个是W的最后几层和损失计算。W的其余中间层将在服务器端计算。SL的所有可能配置,包括垂直分区数据、扩展香草和多任务SL[24],都可以在SFL中作为其变体类似地执行。

3.2 Privacy Protection

SFL固有的隐私保护能力是由于两个原因:首先,它采用了模型到数据的方法,其次,SFL在分割网络上进行ML。ML学习中的网络分割使客户端/被馈电服务器和主服务器能够通过不允许主服务器获得客户端模型更新来维护完整的模型隐私,反之亦然。主服务器只能访问被粉碎的数据(即被切割层的激活向量)。好奇的主服务器需要反转所有客户端模型参数,即权重向量,以推断数据和客户端模型。如果我们将客户端ML网络的全连接层配置为足够大数量的节点[9],那么推断客户端模型参数和原始数据的可能性是极不可能的。但是,对于较小的客户端网络,出现此问题的可能性可能很高。此问题可以通过修改客户端[23]的损失函数来控制。由于同样的原因,客户端(只能访问来自主服务器的粉碎数据的梯度)和馈入服务器(只能访问客户端更新)不能推断服务器端模型参数。由于在FL的客户端和服务器端没有网络分割和单独的训练,与FL相比,SFL在训练期间提供了更好的架构配置,以增强ML模型的私密性。

客户端的隐私保护。我们在前一节讨论了所提议模型的固有私密性。但是,可能会有高级对手利用共享破碎数据或参数(权重)的底层信息表示来侵犯数据所有者的隐私。如果任何服务器/客户端变得好奇,但仍然诚实,就会发生这种情况。为了避免这些可能性,我们在研究中采用了两种方法;(i)客户端模型训练的差异隐私和(ii)客户端模型中的PixelDP噪声层。

美联储服务器上的隐私保护。考虑算法2,我们提出了在客户端k上实现差分隐私的过程。我们假设:σ表示噪声尺度,C0表示梯度范数界。现在,首先,在t时间后,客户端k从服务器接收到梯度dAk,t,然后,它为每个本地样本xi计算客户端梯度O 'k (WCk,i,t),和

主服务器上的隐私保护。上述DP措施并不能阻止从破碎数据到主服务器的潜在泄漏,尽管它对第一个全局epoch之后的破碎数据有一些影响。因此,为了避免隐私泄露,并进一步加强数据隐私和模型对潜在对抗性ML设置的鲁棒性,我们基于PixelDP[18]的概念在客户端模型中集成了噪声层。

这种扩展的测量方法利用差分隐私中涉及的噪声应用机制,在保持实用性的同时,将校准的噪声添加到客户端模型层的输出(例如,激活向量)。

在此过程中,我们首先计算了过程的灵敏度。函数a的灵敏度定义为给定输入和输出的一些距离度量(分别为p范数和q范数),由输入的变化所能产生的输出的最大变化:

其中,APk,i表示Ak,i的私有版本,?0是用于拉普拉斯噪声的私有预算。这种方法允许将被粉碎的数据的私有版本转发到主服务器;因此,保护破碎数据的隐私。破碎数据的私有版本是由于应用于客户端模型中噪声层的DP机制的后处理免疫。由于经过校准的噪声,噪声粉碎后的数据比原始数据更具私密性。此外,PixelDP不仅可以为被破坏的数据提供隐私,还可以提高模型对对抗示例的鲁棒性。但是,为今后的工作保留了详细的分析和数学保证,以保持拟议工作的主要重点。

通过PixelDP实现健壮性。使用随机DP机制对对抗示例进行鲁棒ML的主要直觉是创建DP评分函数。例如,通过DP计分函数输入任何数据样本,输出是相对于输入特征的DP。DP函数期望输出的稳定边界由引理[18]给出:

4 Experiments

在客户端之间对均匀分布和水平分割的图像数据集进行了实验。

所有程序都是使用PyTorch库(PyTorch 1.2.0)用python 3.7.2编写的。为了更快地进行实验和开发,我们使用了在Dell EMC的PowerEdge平台上构建的高性能计算(HPC)平台,该平台具有用于计算和InfiniBand网络的合作gpu。我们在HPC提供的集群的不同计算节点上运行客户端和服务器。对于HPC上的一个slurm作业,我们请求以下资源:10GB RAM,一个GPU (Tesla p100 - sm2 - 16gb),一个每个节点最多一个任务的计算节点。节点的架构是x86 64。在我们的设置中,我们认为所有参与者在每个全局epoch更新模型(即在训练期间C = 1)。我们选择ML网络架构和数据集是基于它们的性能和它们在我们的研究中按比例参与的需求。对于其余的网络架构(AlexNet、ResNet和VGG16), LeNet的学习率保持在0.004和0.0001。我们根据模型在初始观察期间的表现来选择学习率。例如,对于FMNIST上的LeNet,我们观察到训练和测试准确率分别为94.8%和92.1%,学习率为0.004,而在200个全局epoch中,学习率为0.0001,分别为87.8%和87.3%。我们建立了一个类似的计算环境进行对比分析。

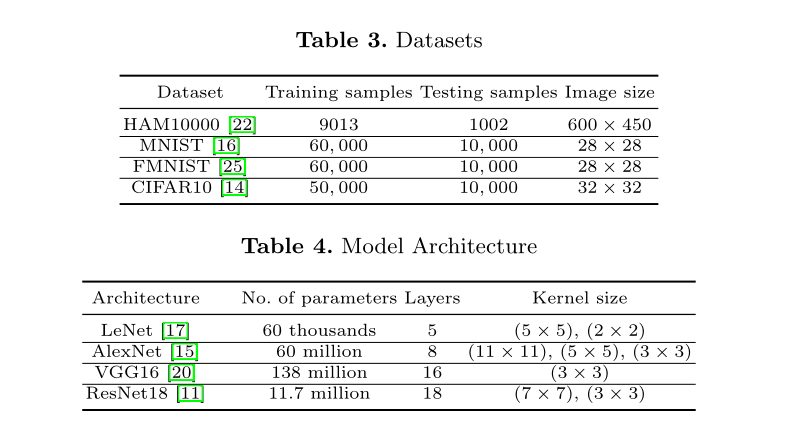

我们在实验中使用了四个公共图像数据集,如表3所示。HAM10000数据集是一个医疗数据集,即拥有10000张训练图像[22]的Human Against Machine。它由着色皮肤病变的彩色图像组成,并有来自不同人群的皮肤镜图像,以不同的方式获取和存储。它有7个重要诊断类型的病变:Akiec, bcc, bkl, df, mel, nv, vasc。

MNIST、Fashion MNIST和CIFAR10是标准数据集,都有10个类。关于ML模型,我们在实验中考虑了四种流行的架构。这四种架构属于卷积神经网络(CNN)架构,并在表4中进行了总结。我们将实验限制在CNN架构上,以保持本文中提出的工作的凝聚力。我们将在未来的工作中对循环神经网络等其他架构进行进一步的实验评估。

在SL、SFLV1和SFLV2的所有实验中,网络层被分为以下几层:LeNet的第二层(二维MaxPool层之后),AlexNet的第二层(二维MaxPool层之后),VGG16的第四层(二维MaxPool层之后),ResNet18的第三层(二维BatchNormalization层之后)。为了公平的比较,在对SFLV1和SFLV2与FL和SL进行比较评估时,我们不考虑在SFLV1和SFLV2中添加基于隐私的差分措施和PixelDP。

进一步深入到单个案例中,作为示例,我们介绍了ResNet18在HAM10000数据集上的正常(集中学习)、FL、SL、SFL V1和SFL V2在类似设置下的性能。对于HAM10000上的ResNet18, FL、SL、SFL V1和SFL V2的测试精度收敛性基本相同,在200个全局epoch的观测窗口内达到76%左右(见图2)。但如果SL不能收敛,则SFL V1和SFL V2很难收敛。在我们单独的实验中,我们观察到了CIF AR10上VGG16的情况。

到目前为止,我们在结果中考虑了测试的平均准确性。图4说明了在每个全局epoch的五个客户端的性能(即精度)的变化。在这方面,我们计算变异系数(CV),这是标准偏差与平均值的比率,它测量离散度。此外,我们计算了五个客户端在每个全局epoch生成的五个精度的CV。根据我们在HAM10000上对ResNet18的结果,SL、FL、SFLV1和SFLV2在训练时的cv范围在0.06到2.63之间,在epoch 2之后的测试时的cv范围在0.54到6.72之间;纪元1时,CV略高。结果表明,整个客户的个人客户水平表现一致,因为CV系数值低于10在文献中被认为是一个良好的范围。

在一些数据集和架构中,模型的训练/测试精度仍在提高,并在高于200的全局epoch显示出更好的性能。例如,从200个epoch到400个epoch,我们注意到在100个用户的FMNIST上,使用LeNet的FL的训练和测试准确率从83%左右增加到86%左右。然而,由于一些网络架构(如FL HAM10000上的AlexNet)在HPC(共享资源)上花费了大量的训练时间,我们将观测窗口限制在100或200个全局epoch。

4.2 Effect of Number of Users on the Performance

4.3 SFL with Differential Privacy at the Client-side Model with a PixelDP Noise Layer

我们实施了“隐私保护”一节中所述的不同隐私措施。为了说明,使用AlexNet对分布在五个客户机上的MNIST数据进行了SFLV1实验。对于50个全局epoch,每个客户端每个全局epoch有5个局部epoch,测试精度曲线收敛如图5所示。

此外,为了说明,我们改变了ε0的值,ε0是放置在AlexNet的第一卷积层之后的PixelDP噪声层使用的隐私预算,看看对整体性能的影响。此外,在所有实验中,我们将ε保持在0.5(客户端模型训练的隐私预算),以检查严格客户端模型隐私下SFL V1的行为。正如预期的那样,与无差异私人训练相比,DP测量精度曲线的收敛是渐进和缓慢的。ε0 = 0.5、1、2、5和不含PixelDP时,在全局历元50时的测试精度分别为40%、64%、73%、77%和78%。显然,准确率随着隐私预算的增加而增加,即ε + ε0。总的来说,效用随着隐私预算的减少而降低。由于SFLV2中的客户端体系结构与SFLV1相同,因此可以采用与SFLV1相同的方式来实现差异隐私的应用。

5 Conclusion

通过将联邦学习(FL)和分裂学习(SL)结合在一起,我们提出了一种新的分布式机器学习方法,称为分裂学习(SFL)。SFL通过网络分割和不同的私有客户端模型更新提供了模型私密性。通过跨客户端执行并行处理,它比SL更快。我们的结果表明,与SL相比,SFL在模型精度方面提供了相似的性能。因此,作为一种混合方法,它支持使用资源受限设备的机器学习(如SL中通过网络分割实现)和快速训练(如FL中通过并行处理客户端实现)。进一步分析了基于差分隐私和PixelDP的隐私和鲁棒性度量的SFL的性能,探讨了其在数据隐私和模型鲁棒性方面的可行性。隐私与效用的详细权衡分析,以及为保证数据隐私而集成同态加密[8]等方面的研究留作后续工作。

本文提出了一种名为分裂学习(SFL)的新方法,它结合了联邦学习和分割学习的优势,以提高数据隐私和模型鲁棒性。SFL在多个客户端上实现了与SL相似的测试准确性和通信效率,同时显著减少了计算时间。与SL相比,SFL在资源受限的环境中提供了更快的模型训练,且在FL的基础上提高了通信效率。文章还探讨了SFL的隐私保护措施,包括差分隐私和PixelDP,以增强数据隐私和模型的鲁棒性。

本文提出了一种名为分裂学习(SFL)的新方法,它结合了联邦学习和分割学习的优势,以提高数据隐私和模型鲁棒性。SFL在多个客户端上实现了与SL相似的测试准确性和通信效率,同时显著减少了计算时间。与SL相比,SFL在资源受限的环境中提供了更快的模型训练,且在FL的基础上提高了通信效率。文章还探讨了SFL的隐私保护措施,包括差分隐私和PixelDP,以增强数据隐私和模型的鲁棒性。

9676

9676

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?