深度学习优化函数详解系列目录

本系列课程代码,欢迎star:

https://github.com/tsycnh/mlbasic

深度学习优化函数详解(0)-- 线性回归问题

深度学习优化函数详解(1)-- Gradient Descent 梯度下降法

深度学习优化函数详解(2)-- SGD 随机梯度下降

深度学习优化函数详解(3)-- mini-batch SGD 小批量随机梯度下降

深度学习优化函数详解(4)-- momentum 动量法

深度学习优化函数详解(5)-- Nesterov accelerated gradient (NAG)

深度学习优化函数详解(6)-- adagrad

上一篇文章讲解了犹如小球自动滚动下山的动量法(momentum)这篇文章将介绍一种更加“聪明”的滚动下山的方式。动量法每下降一步都是由前面下降方向的一个累积和当前点的梯度方向组合而成。于是一位大神(Nesterov)就开始思考,既然每一步都要将两个梯度方向(历史梯度、当前梯度)做一个合并再下降,那为什么不先按照历史梯度往前走那么一小步,按照前面一小步位置的“超前梯度”来做梯度合并呢?如此一来,小球就可以先不管三七二十一先往前走一步,在靠前一点的位置看到梯度,然后按照那个位置再来修正这一步的梯度方向。如此一来,有了超前的眼光,小球就会更加”聪明“, 这种方法被命名为Nesterov accelerated gradient 简称 NAG。

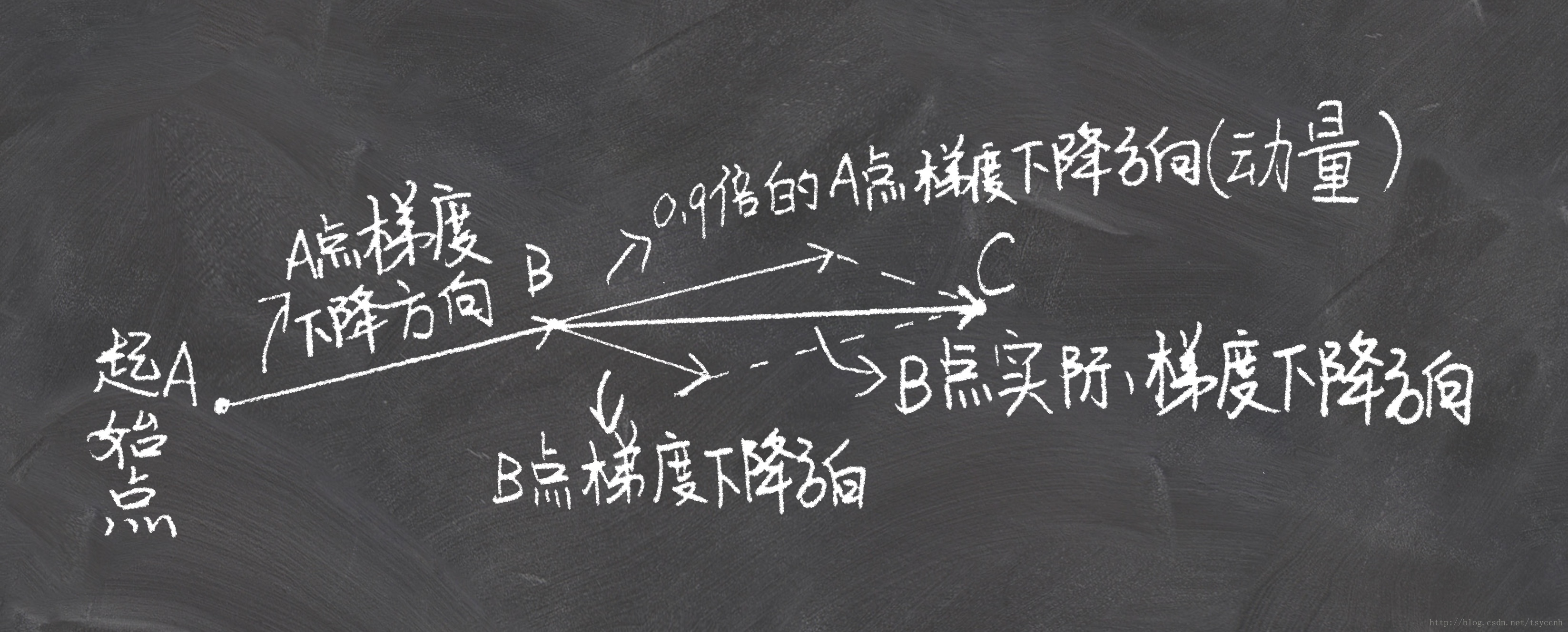

↑这是momentum下降法示意图

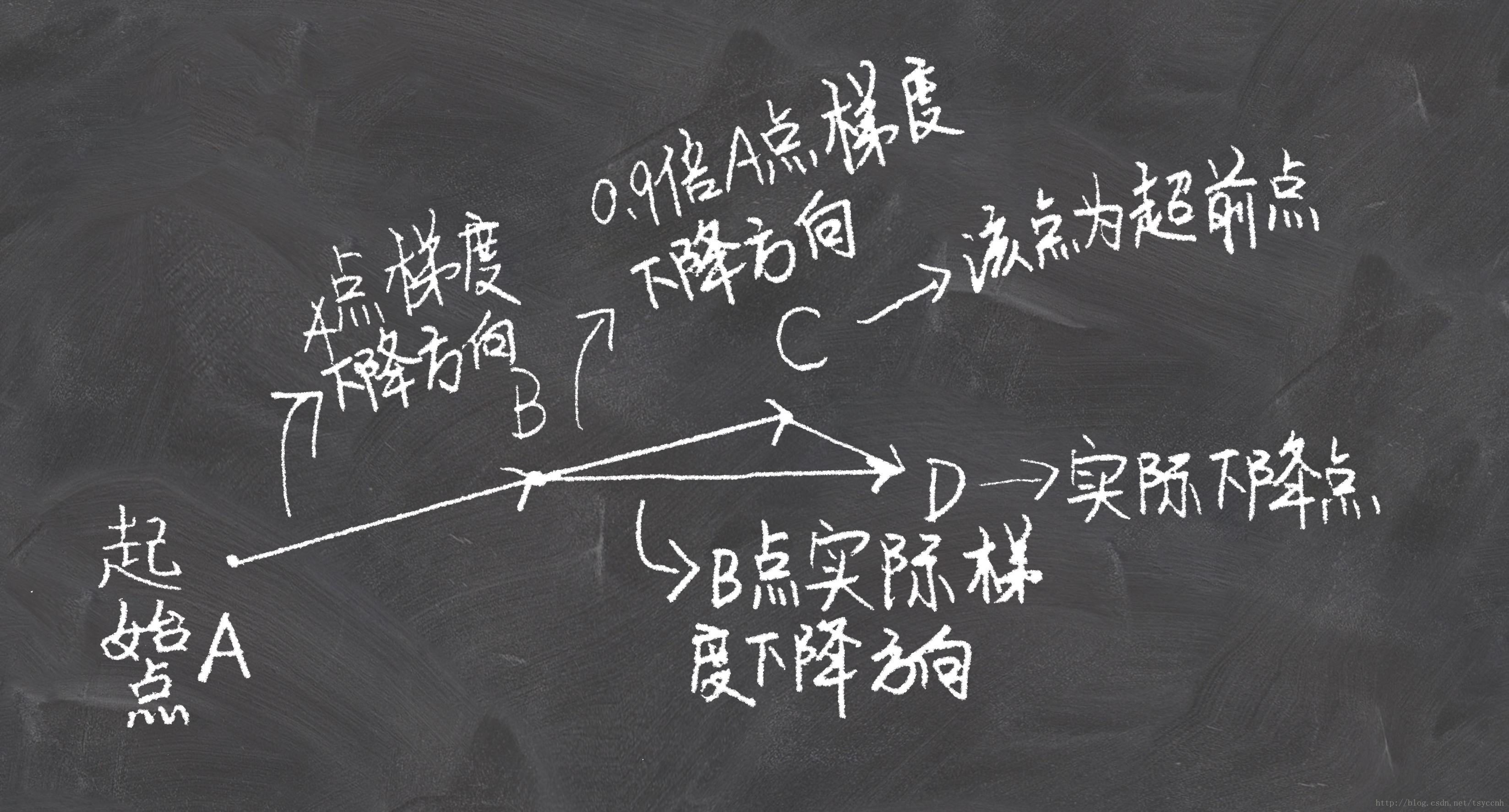

↑这是NAG下降法示意图

看上面一张图仔细想一下就可以明白,Nesterov动量法和经典动量法的差别就在B点和C点梯度的不同。

公式推导

上图直观的解释了NAG的全部内容。

第一次看到NAG的梯度下降公式的时候我是懵的,梯度下降的流程比较明白,公式上不太理解。后来推导了好半天才得到NAG的公式,下面就把我推导的过程写出来。我推导公式的过程完全符合上面NAG的示意图,可以对比参考。

记 v t v_t vt 为第t次迭代梯度的累积

v 0 = 0 v_0=0 v0=0

v 1 = η ∇ θ J ( θ ) v_1=\eta \nabla_{\theta}J(\theta)

本文深入探讨了Nesterov Accelerated Gradient(NAG),一种比动量法更智能的深度学习优化技术。NAG通过提前一小步计算梯度,使模型能以更前瞻的角度调整下降方向,从而提高收敛速度和稳定性。文章通过公式推导和实验对比展示了NAG相对于动量法的优势。

本文深入探讨了Nesterov Accelerated Gradient(NAG),一种比动量法更智能的深度学习优化技术。NAG通过提前一小步计算梯度,使模型能以更前瞻的角度调整下降方向,从而提高收敛速度和稳定性。文章通过公式推导和实验对比展示了NAG相对于动量法的优势。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1916

1916

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?