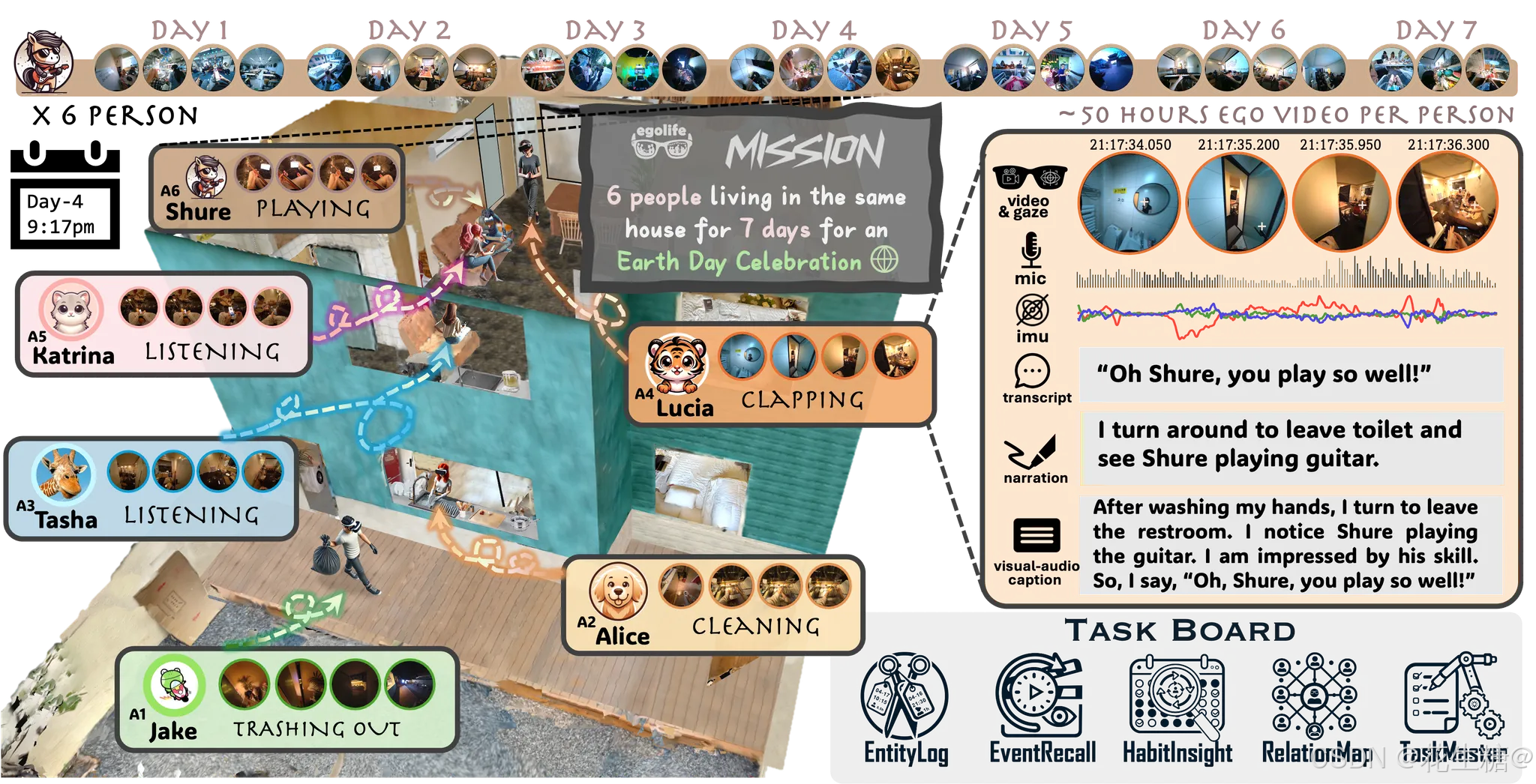

在可穿戴计算与具身智能的交汇点上,新加坡南洋理工大学联合全球顶尖实验室推出的EgoLife项目,正以第一视角认知引擎+分层记忆架构重新定义个人数字助手的技术边疆。这套系统不仅实现了对日常生活的全息记录,更通过时空关联的认知模型,将碎片化记忆转化为可检索的结构化知识。

在可穿戴计算与具身智能的交汇点上,新加坡南洋理工大学联合全球顶尖实验室推出的EgoLife项目,正以第一视角认知引擎+分层记忆架构重新定义个人数字助手的技术边疆。这套系统不仅实现了对日常生活的全息记录,更通过时空关联的认知模型,将碎片化记忆转化为可检索的结构化知识。

一、 核心技术架构

▎多模态融合感知层

基于Meta Aria眼镜的六维传感矩阵,系统每秒采集1.2GB异构数据流:

- 视觉感知:120° FOV鱼眼镜头+15个Exo摄像头组成的第三人称视角网络

- 声场解析:8通道麦克风阵列实现声源定位与语义分离

- 生物传感:眼动追踪精度达0.1°,IMU运动捕捉延迟<3ms

- 环境感知:毫米波雷达实时构建生活空间3D点云

▎认知决策中枢

EgoGPT与EgoRAG的双引擎架构,构建闭环认知增强系统:

-

实时理解引擎(EgoGPT)

∘ 视觉-音频跨模态

订阅专栏 解锁全文

订阅专栏 解锁全文

101

101

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?