为什么要训练模型?

早起接触LLM(大语言模型),虽然很强大,但有时候真的会遇到,AI会一本正经的胡说八道,这种大模型的编造回答,对于我们日常使用来说,具有很大的误导性,特别是如果我们要用在生产环境下,由于缺少精确性而无法使用。

为什么会造成这种结果,简单说就是模型是为通用性设计的,缺少相关知识,比如:医疗、农业、历史等等,所以导致回复的结果存在胡编乱造的情况,根据香农理论,减少信息熵,就需要引入更多信息。

从这个角度来说,就有两个途径:

- 第一,重新利用相关专业知识再次训练加强模型,或进行模型微调,模型训练的成本巨大,微调也需要重新标记数据和大量的计算资源,对于个人来说基本不太现实;

- 第二,在问LLM问题的时,增加些知识背景,让模型可以根据这些知识背景来回复问题,这便是知识库的构建原理了。

这里为什么要叫“喂养” DeepSeek 本地模型?

因为大模型再强大也有它天然的局限性,比如:训练数据不可能包含你的私域数据,而打造自己的本地私域知识库,就需要检索这些数据,具体采用的是RAG(检索 增强 生成)方法。

一、概念理解

RAG 英文全称是Retrieval-Augmented Generation 即检索增强生成,采用RAG就需要把你的私域数据向量化,然后存储到向量数据库中,支持向量检索配合LLM大模型一起提供更专业的回复。

简单概述:就是利用你已有的文档、内部知识 生成向量知识库,在提问的时候结合库的内容一起给大模型,让其回答的更准确,它结合了信息检索和大模型技术;

(一)原理:

1. 首先,检索阶段,当用户输入一个问题时,系统会从外部数据库 或 文档中检索相关的信息或文档片段。

2. 然后,生成阶段,这些检索到的信息会和原始问题一起输入到生成模型中,生成最终的答案。

这样,模型不仅依赖于内部知识,还能利用外部实时 或 特定的数据。

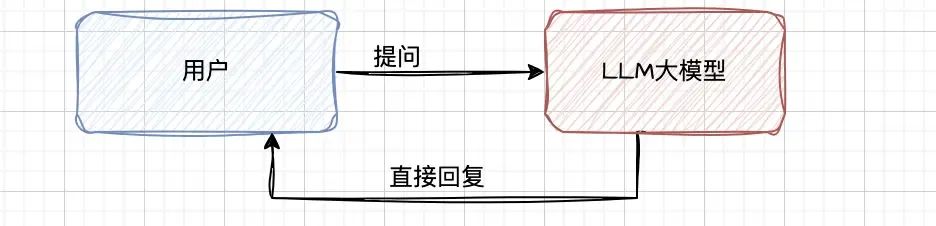

- 平常我们通过聊天窗口交互方式使用大模型,如下图:

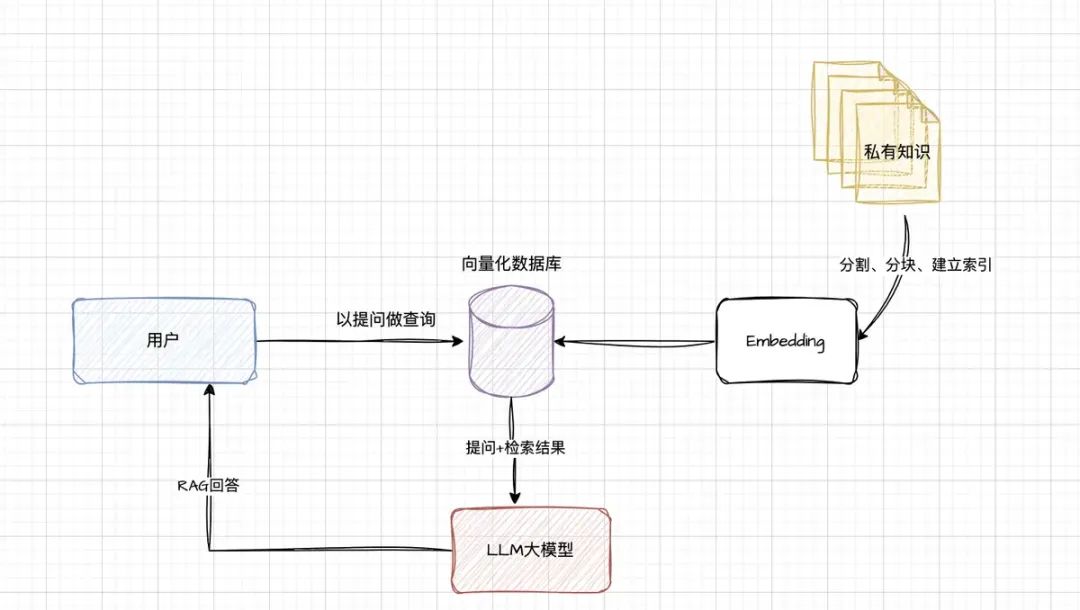

- 搭建了RAG架构后,如下图:

(1)框架说明:

-

建立索引: 需要将日常的业务知识,以文件形式给分成较短的块(chunk),然后进行编码,向量化存入到向量化的库中;nomic-embed-text-v1模型就是做这个事情的。

-

检索向量库: 根据用户的提问,在到向量库中去进行向量匹配,检索出相似的块(chunk),作为提问的上下文;

-

生成回复: 将用户的提问内容和检索的块结合,发送给大模型,大模型结合两者进行问题的回复;

(2)这样做有什么有点?

-

由于日常的业务知识是保存到本地的,所以减少信息泄露的风险;

-

由于提问结合了业务知识,所以减少了模型的幻觉,即减少了模型的胡说八道;

-

模型的回复结合了业务知识和实时知识,所以实时性可以更好;

-

不用重新训练模型,微调模型降低了成本;

二、本地大模型部署搭建

手把手教学,实现本地部署DeepSeek-R1 私有化AI助手-CSDN博客

三、如何训练?

需要安装以下工具:

-

Ollama: 用于下载和管理模型,前面文章介绍过;

-

DeepSeek-R1 : 我们本次要使用的LLM模型,前面文章也介绍过;

-

Nomic-Embed-Text向量模型: 用于将文本库进行切分,编码,转换进入向量库;

-

AnythingLLM: 开源AI私有化应用构建平台,即将多个模型搭配起来,共同构建一个私有化应用;利用强大的内置工具和功能快速运行本地 LLM,无需复杂的设置。 Ollama和DeepSeek-R1模型前面已经安装过了,就不再赘述,下面安装另外两个工具;

(一)Nomic-Embed-Text 模型安装

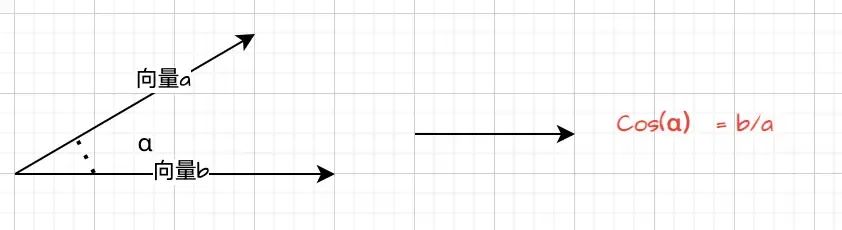

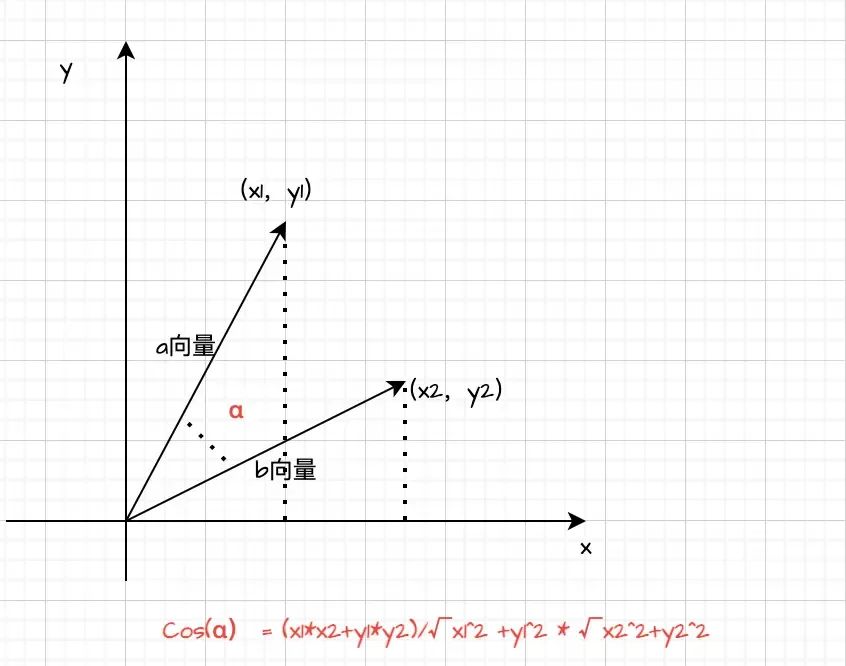

简单介绍下,Nomic-Embed-Text模型是一个强大的嵌入式文本处理工具,将我们的业务知识(专业点的叫法语料库)转成高纬度的向量空间中的点,以便后续进行相似度计算、分类、聚类、检索等。 听起来这个好像很高级,如果简单来看的话,其实底层原理也简单,文本相似度可以通过两个高纬度向量的余弦值大小来判断的,余弦值越大的,两个高纬度向量靠的越近,相关性大,反之亦然,当然也有复杂的算法。

余弦值计算

通过pull命令直接安装,大小为274MB,还是比较小的:

ollama pull nomic-embed-text

然后通过ollama list查询:

mac@MacdeMacBook-Pro models % ollama list

NAME ID SIZE MODIFIED

nomic-embed-text:latest 0a109f422b47 274 MB 17 minutes ago

deepseek-r1:1.5b a42b25d8c10a 1.1 GB 4 days ago

网上找一个使用的例子,大家可以直观的体会下:

from transformers import AutoTokenizer, AutoModel

import torch

# 加载模型和分词器

tokenizer = AutoTokenizer.from_pretrained("nomic-embed-text-v1")

model = AutoModel.from_pretrained("nomic-embed-text-v1")

# 输入文本

text1 = "今天天气好!"

text2 = "今天的天气真是好啊!"

# 将文本转换为模型输入格式

encoding = tokenizer(text1, text2, return_tensors="pt")

# 获取文本嵌入

with torch.no_grad():

outputs = model(**encoding)

# 计算文本嵌入的余弦相似度

cosine_similarity = torch.nn.functional.cosine_similarity(outputs.last_hidden_state[0], outputs.last_hidden_state[1])

print("文本相似度:", cosine_similarity.item())

(二)AnythingLLM安装

https://anythingllm.com/desktop

它是一个强大的灵活的平台,通过它可以连接多个LLM模型,构建本地私有的LLM应用,配置界面简单直观。

通过搭建本地模型,配合Embedder和向量数据库,可以直接构建一个隐私性更好,实时性更高的个人知识库DAG。

5896

5896

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?