英文原文:https://stable-diffusion-art.com/prompts-from-images/

您是否看到过您真正喜欢的 AI 图像并想知道提示是什么?我们将介绍几种从图像中获取提示的方法。您还将学习其他技术来增加重新创建图像的机会。

在本文中,您将学习如何

- 读取PNG元数据信息,其中有时会写有提示。

- 使用 CLIP interrogator 猜测提示。

- 再现图像的技巧。

文章目录

软件设置

我们将在本教程中使用 AUTOMATIC1111 稳定扩散 WebUI。它很受欢迎并且免费。您可以在 Windows、Mac 或 Google Colab 上使用此软件。

如果您是稳定扩散的新手,请查看快速入门指南。如果您是 AUTOMATIC1111 的新手,请查看 AUTOMATIC1111 指南。

方法1:通过读取PNG Info从图像中获取提示

如果AI图片是PNG格式的,可以尝试看看PNG元数据字段中是否写入了提示等设置信息。

首先,将图像保存到本地存储。

打开 AUTOMATIC1111 WebUI。导航至 PNG 信息页面。

将图像拖放到左侧的源画布上。

如果图片文件中有的话,您将在右侧看到提示、否定提示和其他生成参数。您可以选择将提示和设置发送到 txt2img、img2img、修复或 Extras 页面进行upscaling。

或者,您可以使用此免费网站查看 PNG 元数据,而无需使用 AUTOMATIC1111。

方法二:用CLIP询问器根据图像猜测提示

通常情况下,第一种方法不起作用。世代信息可能一开始就没有被写入。它可能已经存在,但网络服务器在图像优化期间将其剥离。或者它不是由稳定扩散产生的。

在这种情况下,您的下一个选择是使用 CLIP interrogator(询问器)。它是一类猜测图像标题的人工智能模型。它适用于任何图像,而不仅仅是 AI 图像。

什么是CLIP?

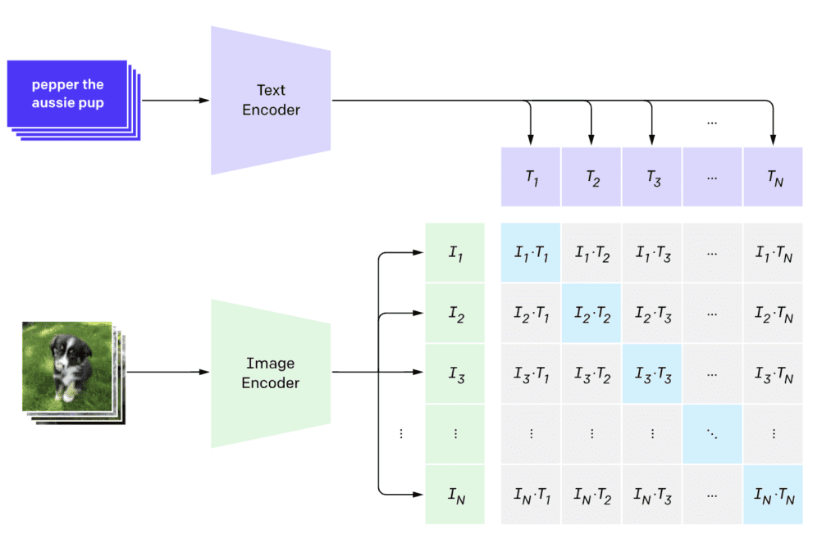

CLIP(对比语言-图像预训练)是一种将视觉概念映射到自然语言的神经网络。 CLIP 模型使用大量图像和标题对进行训练。

给定图像,CLIP 模型可以推断出描述该图像的标题。在我们的用例中,您使用标题作为提示。

WebUI 的原生 CLIP 询问器

如果您不想安装任何扩展,您可以在 img2img 页面上使用 AUTOMATIC1111 的本机 CLIP 询问器。它使用 BLIP,这是 Junnan Li 及其同事在文章“BLIP:Bootstrapping Language-Image Pre-training for Unified Vision-Language Understanding and Generation”中描述的 CLIP 模型。

要使用本机 CLIP 询问器:

- 打开 AUTOMATIC11111。

- 导航到 img2img 页面。

- 将图像上传到 img2img 画布。

4. 单击询问 CLIP 以获取提示。

a woman with a wreath of flowers on her head and necklace on her neck, looking at the camera, Elinor Proby Adams, portrait photography, a character portrait, arts and crafts movement

使用现实视觉模型测试此提示以及针对现实人物的负面提示,我们得到以下图像。

我们看到一个戴着花环和项链的女人,尽管成分不同。

CLIP询问器扩展

AUTOMATIC1111 的本机 CLIP 询问器不允许您使用不同的 CLIP 模型。如果您需要额外的功能,则必须使用 CLIP 询问器扩展。

https://github.com/pharmapsychotic/clip-interrogator-ext

使用 CLIP 询问器扩展。

- 打开 AUTOMATIC1111 WebUI。

- 导航至 Interrogator 页面。

- 将图像上传到图像画布。

- 在 CLIP 模型下拉菜单下选择 ViT-L-14-336/openai。这是 Stable Diffusion v1.5 中使用的语言嵌入模型。

- 单击“Generate”以生成提示。

这就是我们得到的。

there is a woman with a flower crown on her head, with depth of field, earthy tones, marigold, portrait of a cute woman, dryad, subject centered in frame, of a young woman, midsommar, portrait face, 65mm 1.5x anamorphic lens, inspired by Elsa Beskow, art : : professional photograph, druid portrait

我们使用与上一节相同的图像设置获得以下图像。

同样,它很接近但不完全相同。她的项链在提示中缺失,因此在图像中也缺失。由于 CLIP 询问器的结果变化很大,我不会说 ViT-L-14-336/openai 模型比 BLIP 更差。

SDXL 模型的 Interrogate CLIP

如果提示旨在与Stable Diffusion XL (SDXL) 模型一起使用,您可以在询问页面的 CLIP 模型下拉菜单中选择 ViT-g-14/laion2b_s34b_b88k。

这将给出以下提示。

there is a woman with a flower crown on her head, medium portrait top light, f / 1, extra – details, 1 8 yo, national geographic photo shoot, movie scene portrait closeup, inspired by William Morris, center frame portrait, lut, warm glow, bio-inspired, at home, f / 2 0, by Jane Kelly

这些是使用 SDXL 1.0 base + refiner 模型生成的图像。

提示和模型确实产生了更接近原始构图的图像。

使用稳定扩散再现 AI 图像的技巧

您应该始终首先尝试 PNG 信息方法(方法 1) 以从图像中获取提示,因为如果幸运的话,它会为您提供重新创建图像的完整信息。包括提示、型号、采样方法、采样步骤等。

您可以尝试使用 BLIP 和 CLIP 模型来实现稳定扩散 v1.5 和 XL 模型。 ViT-g-14/laion2b_s34b_b88k 可以很好地与 v1.5 模型配合使用,而不仅仅是 SDXL。

请随时修改提示。如上面的示例所示,提示可能不正确或缺少某些对象。相应地编辑提示以正确描述图像。

选择合适的检查点模型很重要。提示不一定包含正确的样式。例如,如果您想生成现实的人,请选择现实的模型。

最后,核心选项是使用图像提示。 SD v1.5 Plus 模型可以通过适当的提示忠实地再现图像。

本文介绍了如何从AI图像的PNG元数据获取提示,以及使用CLIPinterrogator进行猜测。还讲解了如何利用稳定扩散的不同版本和模型重现图像,包括使用BLIP和ViT-g-14/laion2b_s34b_b88k模型的技巧。

本文介绍了如何从AI图像的PNG元数据获取提示,以及使用CLIPinterrogator进行猜测。还讲解了如何利用稳定扩散的不同版本和模型重现图像,包括使用BLIP和ViT-g-14/laion2b_s34b_b88k模型的技巧。

2123

2123

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?