声明:版权所有,转载请联系作者并注明出处:

http://blog.csdn.net/u013719780?viewmode=contents

知乎专栏:

https://www.zhihu.com/people/feng-xue-ye-gui-zi

前面两篇文章详细讲解了线性判别分析LDA,说到LDA,就不能不提到主成份分析,简称为PCA,是一种非监督学习算法,经常被用来进行数据降维、有损数据压缩、特征抽取、数据可视化(Jolliffe, 2002)。它也被称为Karhunen-Loève变换。

1. PCA原理

PCA的思想是将

n

维特征映射到

1.1 最大方差理论

在信号处理中认为信号具有较大的方差,噪声有较小的方差,信噪比就是信号与噪声的方差比,越大越好。因此我们认为,最好的

k

维特征是将

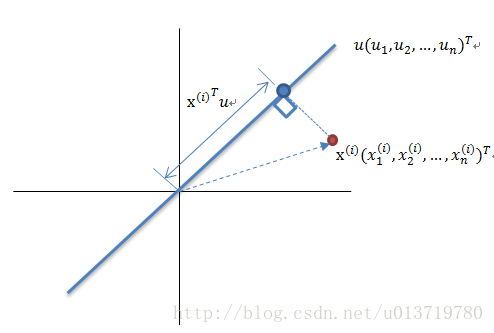

首先,考虑在一维空间 (k=1) 上的投影。我们可以使用

向。为了方便(并且不失一般性),我们假定选择一个单位向量,从而

如上图所示,红色点表示原样本点

x(i)

,

u

是蓝色直线的斜率也是直线的方向向量,而且是单位向量,直线上的蓝色点表示原样本点

假设原始数据集为

Xmxn

,我们的目标是找到最佳的投影空间

Wnxk=(w1,w2,…,wk)

,其中

wi

是单位向量且

wi

与

wj(i≠j)

正交, 何为最佳的

W

?就是原始样本点投影到

由于投影后均值为0,因此投影后的总方差为:

1mx(i)x(i)T

是不是似曾相识,没错,它就是原始数据集

X

的协方差矩阵(因为

记 λ=1m∑mi=1(x(i)Tw)2 , ∑=1mx(i)x(i)T , 则有

上式两边同时左乘

w

,注意到

所以

w

是矩阵

欲使投影后的总方差最大,即

λ

最大,因此最佳的投影向量

w

是特征值

我们可以用一种增量的方式定义额外的主成分,方法为:在所有与那些已经考虑过的方向正交的所有可能的方向中,将新的方向选择为最大化投影方差的方向。如果我们考虑

k

维投影空间的一般情形,那么最大化投影数据方差的最优线性投影由数据协方差矩阵

因此,我们只需要对协方差矩阵进行特征值分解,得到的前

k

大特征值对应的特征向量就是最佳的

PCA算法流程

算法输入:数据集

Xmxn

* 按列计算数据集

X

的均值

* 求解矩阵

Xnew

的协方差矩阵,并将其记为

Cov

;

* 计算协方差矩阵

COv

的特征值和相应的特征向量;

* 将特征值按照从大到小的排序,选择其中最大的

k

个,然后将其对应的

* 计算

XnewW

,即将数据集

Xnew

投影到选取的特征向量上,这样就得到了我们需要的已经降维的数据集

XnewW

。

注意,计算一个

nxn

矩阵的完整的特征向量分解的时间复杂度为

O(n3)

。如果我们将数据集投影到前

k

个主成分中,那么我们只需寻找前

1.2 最小平方误差理论

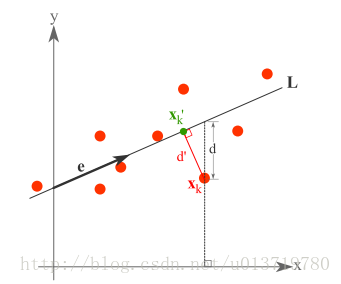

如上图所示,假设有这样的二维样本点(红色点),按照前文我们讲解的最大方差理论,我们的目标是是求一条直线,使得样本点投影到直线或者平面上的点的方差最大。本质是求直线或者平面,那么度量直线求的好不好,不仅仅只有方差最大化的方法。再回想我们最开始学习的线性回归等,目的也是求一个线性函数使得直线能够最佳拟合样本点,那么我们能不能认为最佳的直线就是回归后的直线呢?回归时我们的最小二乘法度量的是样本点到直线的坐标轴距离。比如这个问题中,特征是x,类标签是y。回归时最小二乘法度量的是距离d。如果使用回归方法来度量最佳直线,那么就是直接在原始样本上做回归了,跟特征选择就没什么关系了。

因此,我们打算选用另外一种评价直线好坏的方法,使用点到直线的距离 d′ 来度量。

现在有

m

个样本点

这个公式称作最小平方误差(Least Squared Error)。

初中我们就已经知道确定一条直线,只需要知道直线经过某一个点和其方向即可。

首先,我们确定直线经过的点,假设要在空间中找一点

x0

来代表这

m

个样本点,“代表”这个词不是量化的,因此要量化的话,我们就是要找一个

最小。其中 J0(x0) 是平方错误评价函数(squared-error criterion function),假设 x¯ 为 m 个样本点的均值,即

则

显然,上式的第二项与 x0 无关,因此, J0(x0) 在 x¯ 处有最小值。

接下来,我们确定直线的方向向量。我们已经知道直线经过点 x¯ ,假设直线的方向是单位向量 e⃗ 。那么直线上任意一点 x(i)′ 有:

其中, ai 是 x(i)′ 到点 x¯ 的距离。

我们重新定义最小平方误差:

我们首先固定 e⃗ ,将其看做是常量,然后令 J1 关于 ai 的导数等于0,则有:

这个结果意思是说,如果知道了 e⃗ ,那么将 (x(i)−x¯) 与 e⃗ 做内积,就可以知道了 x(i) 在 e⃗ 上的投影离 x¯ 的长度距离,不过这个结果不用求都知道。

然后是固定 ai ,对 e⃗ 求偏导数,我们先将 ai 代入 J1 ,得

其中 S=∑mi=1(x(i)−x¯)(x(i)−x¯)T ,与协方差矩阵类似,只是缺少个分母 n−1 ,我们称之为散列矩阵(scatter matrix)。

现在我们就可以用拉格朗日乘数法求解方向向量 e⃗ 了。令

令上式关于 e⃗ 的偏导数等于0,则可得

两边除以 n−1 就变成了对协方差矩阵求特征值向量了。

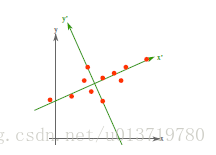

从不同的思路出发,最后得到同一个结果,对协方差矩阵求特征向量,求得后特征向量上就成为了新的坐标,如下图:

这时候点都聚集在新的坐标轴周围,因为我们使用的最小平方误差的意义就在此。另外,PRML书上从线性子空间的角度进行了详细的阐述,有兴趣的读者可以看看。

2. PCA算法优缺点:

优点:

它是无监督学习,完全无参数限制的。在PCA的计算过程中完全不需要人为的设定参数或是根据任何经验模型对计算进行干预,最后的结果只与数据相关,与用户是独立的。

用PCA技术可以对数据进行降维,同时对新求出的“主元”向量的重要性进行排序,根据需要取前面最重要的部分,将后面的维数省去,可以达到降维从而简化模型或是对数据进行压缩的效果。同时最大程度的保持了原有数据的信息。

各主成分之间正交,可消除原始数据成分间的相互影响。

计算方法简单,易于在计算机上实现。

缺点:

如果用户对观测对象有一定的先验知识,掌握了数据的一些特征,却无法通过参数化等方法对处理过程进行干预,可能会得不到预期的效果,效率也不高。

贡献率小的主成分往往可能含有对样本差异的重要信息。

特征值矩阵的正交向量空间是否唯一有待讨论。

在非高斯分布的情况下,PCA方法得出的主元可能并不是最优的,此时在寻找主元时不能将方差作为衡量重要性的标准。

3. 代码实现

from __future__ import print_function

from sklearn import datasets

import matplotlib.pyplot as plt

import matplotlib.cm as cmx

import matplotlib.colors as colors

import numpy as np

%matplotlib inline

def shuffle_data(X, y, seed=None):

if seed:

np.random.seed(seed)

idx = np.arange(X.shape[0])

np.random.shuffle(idx)

return X[idx], y[idx]

# 正规化数据集 X

def normalize(X, axis=-1, p=2):

lp_norm = np.atleast_1d(np.linalg.norm(X, p, axis))

lp_norm[lp_norm == 0] = 1

return X / np.expand_dims(lp_norm, axis)

# 标准化数据集 X

def standardize(X):

X_std = np.zeros(X.shape)

mean = X.mean(axis=0)

std = X.std(axis=0)

# 做除法运算时请永远记住分母不能等于0的情形

# X_std = (X - X.mean(axis=0)) / X.std(axis=0)

for col in range(np.shape(X)[1]):

if std[col]:

X_std[:, col] = (X_std[:, col] - mean[col]) / std[col]

return X_std

# 划分数据集为训练集和测试集

def train_test_split(X, y, test_size=0.2, shuffle=True, seed=None):

if shuffle:

X, y = shuffle_data(X, y, seed)

n_train_samples = int(X.shape[0] * (1-test_size))

x_train, x_test = X[:n_train_samples], X[n_train_samples:]

y_train, y_test = y[:n_train_samples], y[n_train_samples:]

return x_train, x_test, y_train, y_test

# 计算矩阵X的协方差矩阵

def calculate_covariance_matrix(X, Y=np.empty((0,0))):

if not Y.any():

Y = X

n_samples = np.shape(X)[0]

covariance_matrix = (1 / (n_samples-1)) * (X - X.mean(axis=0)).T.dot(Y - Y.mean(axis=0))

return np.array(covariance_matrix, dtype=float)

# 计算数据集X每列的方差

def calculate_variance(X):

n_samples = np.shape(X)[0]

variance = (1 / n_samples) * np.diag((X - X.mean(axis=0)).T.dot(X - X.mean(axis=0)))

return variance

# 计算数据集X每列的标准差

def calculate_std_dev(X):

std_dev = np.sqrt(calculate_variance(X))

return std_dev

# 计算相关系数矩阵

def calculate_correlation_matrix(X, Y=np.empty([0])):

# 先计算协方差矩阵

covariance_matrix = calculate_covariance_matrix(X, Y)

# 计算X, Y的标准差

std_dev_X = np.expand_dims(calculate_std_dev(X), 1)

std_dev_y = np.expand_dims(calculate_std_dev(Y), 1)

correlation_matrix = np.divide(covariance_matrix, std_dev_X.dot(std_dev_y.T))

return np.array(correlation_matrix, dtype=float)

class PCA():

"""

主成份分析算法PCA,非监督学习算法.

"""

def __init__(self):

self.eigen_values = None

self.eigen_vectors = None

self.k = 2

def transform(self, X):

"""

将原始数据集X通过PCA进行降维

"""

covariance = calculate_covariance_matrix(X)

# 求解特征值和特征向量

self.eigen_values, self.eigen_vectors = np.linalg.eig(covariance)

# 将特征值从大到小进行排序,注意特征向量是按列排的,即self.eigen_vectors第k列是self.eigen_values中第k个特征值对应的特征向量

idx = self.eigen_values.argsort()[::-1]

eigenvalues = self.eigen_values[idx][:self.k]

eigenvectors = self.eigen_vectors[:, idx][:, :self.k]

# 将原始数据集X映射到低维空间

X_transformed = X.dot(eigenvectors)

return X_transformed

def main():

# Load the dataset

data = datasets.load_iris()

X = data.data

y = data.target

# 将数据集X映射到低维空间

X_trans = PCA().transform(X)

x1 = X_trans[:, 0]

x2 = X_trans[:, 1]

cmap = plt.get_cmap('viridis')

colors = [cmap(i) for i in np.linspace(0, 1, len(np.unique(y)))]

class_distr = []

# Plot the different class distributions

for i, l in enumerate(np.unique(y)):

_x1 = x1[y == l]

_x2 = x2[y == l]

_y = y[y == l]

class_distr.append(plt.scatter(_x1, _x2, color=colors[i]))

# Add a legend

plt.legend(class_distr, y, loc=1)

# Axis labels

plt.xlabel('Principal Component 1')

plt.ylabel('Principal Component 2')

plt.show()

if __name__ == "__main__":

main()

335

335

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?