《水利部关于开展数字孪生流域建设先行先试工作的通知》提出加快建设数字孪生流域和数字孪生工程是指利用先进的信息技术和数据分析手段,对流域和水利工程进行数字化建模和仿真,实现全面预测、预警、预演、预案功能,按照“需求牵引、应用至上、数字赋能、提升能力”的要求,推进算法、算据、算力的建设,实现物理流域全要素和水利治理管理全过程的数字化映射和智能化模拟。具体一般包括“数据建设、算法建设、算力建设”

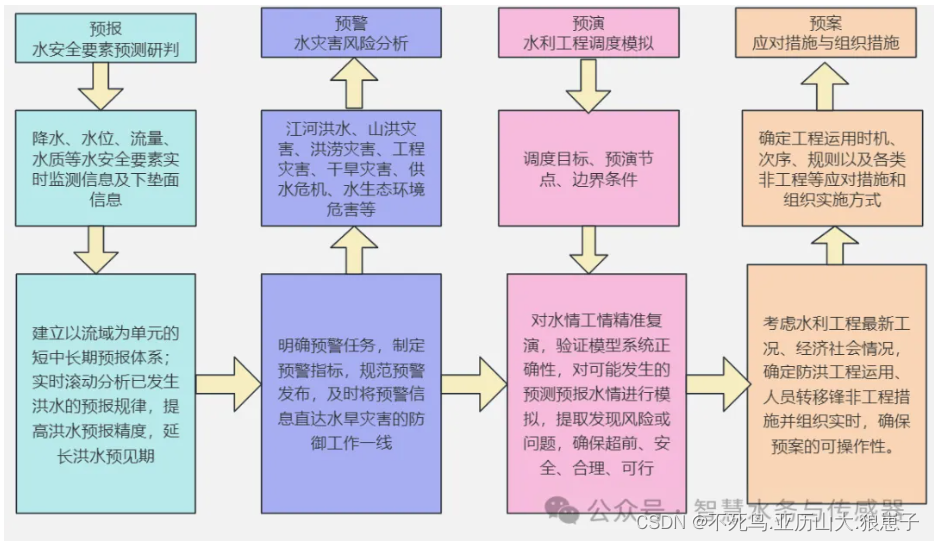

水资源”四预“架构体系建设的技术路线为预报→预警→预演→预案。

1 预报

预报是基础,根据业务需求,遵循客观规律,在总结分析典型历史事件和及时掌握现状的基础上,采用基于机理揭示和规律把握、数理统计和数据挖掘技术等数学模型的方法,对水安全要素发展趋势作出不同预见期的定量或定性分析,提高预报精度,延长预见期。

例如:智慧水利系统中使用的监测设备包括水位传感器、雨量计和气象站等收集实时的水文和气象数据,同时,系统还集成了卫星遥感数据和地理信息系统,以获取更全面的环境信息。

通过对历史洪水事件和相关数据的分析,系统建立了洪水预测模型,模型可以根据当前的数据输入,实时生成洪水预测结果。

2 预警

预警是前哨,根据水利工作和社会公众的需求,制定水灾害风险指标和阈值,拓宽预警信息发布渠道,及时将预警信息直达水利工作一线,为采取工程巡查、工程调度、人员转移等应急响应措施提供指引;及时将预警信息直达受影响区域的社会公众,为提取采取防灾避险措施提供信息服务。

例如,智慧水利预警系统通过监测水位、流量、水质等指标,结合模型算法,实现对洪水、山洪灾害、城市内涝、工程灾害、供水危机、水质异常等的预警。预警信息能够提前发现问题,并及时采取措施应对,减少损失和风险。

3 预演

预演是关键,在数字孪生流域中对典型历史事件、设计、规划或未来预报场景下的水利工程调度进行模拟仿真,正向预演出风险形势和影响,逆向推演出水利工程安全运行限制条件,及时发现问题,迭代优化方案,制定防风险措施。

例如,通过建立水文模型、水资源模型、水质模型等,模拟和预测不同决策方案对水利系统的影响。根据不同的供需情景进行仿真推演,预测水资源调度方案、工程项目建设方案、水工程调度应用、水污染事件处理等的效果。

4 预案

预案是目的,依据预演确定的方案,考虑水利工程最新工况、经济社会情况,确定水利工程运用次序、时机、规则、制定非工程措施,落实调度机构、权限及责任,明确信息报送流程及方式等,确保预案的可操作性。

例如:为应对水利系统突发事件和灾害提供指导和支持,制定洪水应急预案、干旱应对预案、水质事件应急预案等,明确应急措施和责任分工,提前准备应对措施,提高水利系统的抗灾能力。

5 总结

水利业务“四预”功能基于智慧水利总体框架,在数字孪生流域的基础上建设。预报、预警、预演、预案四者环环相扣、层层递进。

预报是基础、预警是前哨、预演是关键、预案是目的

水利业务“四预”功能的建设,保持数字孪生流域与物理流域交互的精准性、同步性、及时性,实现“预报精准化、预警超前化、预演数字化、预案科学化”

2300

2300

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?