发布于:2024 年 10 月 15 日

#T2SQL #NL2SQL #Text-to-SQL

本文深入探讨了基于大型语言模型(LLMs)的 Text-to-SQL 任务的相关研究。通过对现有提示工程方法进行系统比较,阐述了不同方法在问题表示、示例选择和示例组织方面的优缺点,并基于此提出了一种新的集成解决方案 DAIL-SQL,该方案在 Spider 排行榜上取得了 86.6% 的执行准确率,刷新了纪录。同时,还研究了开源 LLMs 在 Text-to-SQL 任务中的潜力以及监督微调对其性能的影响,并强调了提示工程中的标记效率问题。 原文链接:阿里 DAIL-SQL:大型语言模型支持的文本到 SQL:基准评估

一、引言

1.1 研究背景与意义

在当今数字化时代,数据的高效处理和利用至关重要。Text-to-SQL 作为自然语言处理和数据库领域的关键技术,旨在实现自然语言问题到 SQL 查询的自动转换,从而打破非专业用户与数据库系统之间的障碍,提高数据处理效率,拓展智能数据库服务、自动数据分析和数据库问答等应用范围。随着人工智能技术的不断发展,特别是大型语言模型(LLMs)的出现,为 Text-to-SQ 任务带来了新的机遇和挑战。

1.2 现有研究的不足

尽管 Text-to-SQ 研究取得了一定进展,但仍存在诸多问题。以往研究主要集中在提取问题到 SQL 的模式并通过训练编解码器模型进行泛化,而对于基于 LLM 的Text-to-SQ 解决方案,核心的提示工程问题缺乏系统研究。具体表现为:在问题表示方面,现有研究虽有多种方式,但缺乏对不同表示及其与 LLMs 配合效果的系统分析;在示例选择和组织上,策略多样但最优选择不明确;此外,开源 LLMs 在 Text-to-SQ 中的潜力未得到充分挖掘,且提示效率问题也亟待解决。

二、预备知识

2.1 Text-to-SQL 的发展脉络

Text-to-SQL 的研究历程涵盖了多个阶段和方法。早期研究采用预定义规则或查询枚举的方式,之后将其视为序列到序列任务,利用编码器 - 解码器架构训练机器学习模型。随着深度学习技术的飞速发展,诸如注意力机制、图表示、语法解析等众多技术被应用于 Text-to-SQ 任务,其中 BERT 是具有代表性的模型之一。近年来,随着 LLMs 的兴起,Text-to-SQ 研究进入新的阶段。LLMs 通过在大规模文本语料上预训练,能够执行多种自然语言任务,其在 Text-to-SQ 中的应用核心在于找到最优提示,即提示工程。本文提出的 DAIL-SQL 从问题表示、上下文学习、监督微调三个方面来实现 T2SQL。

2.2 关键概念定义

2.2.1 问题表示

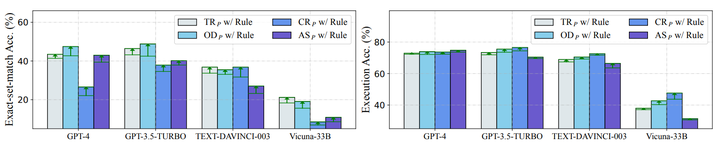

![]()

添加图片注释,不超过 140 字(可选)

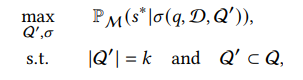

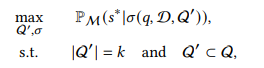

在零样本场景下的 Text-to-SQL 中,问题表示的目标是在给定数据库 D 上,对于自然语言目标问题 q,最大化 LLM M 生成正确 SQL ∗ 的可能性。这需要综合考虑数据库模式等有用信息,以及可能的指令语句、规则暗示和外键信息等,通过函数 (・,・) 来实现。

2.2.2 上下文学习

添加图片注释,不超过 140 字(可选)

在少样本场景下,上下文学习是 LLMs 从输入提示中的示例学习的过程。它包括示例选择和示例组织两个关键环节,目标是在目标问题 q 和数据库 D 上,最大化 LLM M 生成正确 SQL ∗ 的可能性,同时考虑从给定的示例集合 Q 中选择 k 个示例,并通过函数 (・,・,・) 进行表示。

2.2.3 监督微调

监督微调是使用额外的任务特定训练数据来增强 LLMs,使其更适合特定下游任务的方法。对于 Text-to-SQ 任务,给定一个大型语言模型 M 和一组 Text-to-SQ 训练数据 T,目标是最小化经验损失,包括对给定 LLM 进行微调以及寻找最优问题表示两个子任务。

三、方法

3.1 问题表示方法探究

3.1.1 现有方法对比

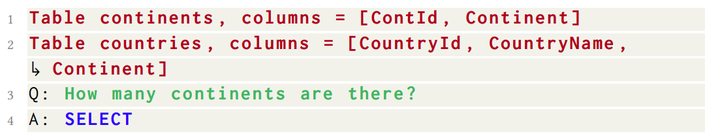

基本提示(BS ):以清单 1 中所示,一种简单的表示方法,由表 schemas 组成、以 Q 为前缀的自然语言问题 和以 A 为前缀 : SELECT 提示 LLM 生成 SQL。

添加图片注释,不超过 140 字(可选)

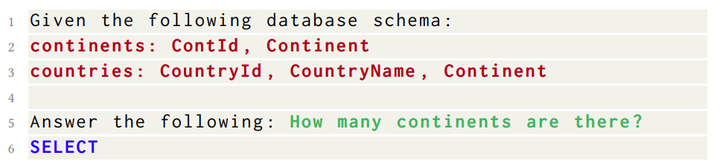

文本表示提示(TR ):如清单 2 所示,用自然语言表示模式和问题,并在开头添加指令,引导 LLMs。在零样本场景下对 Spider - dev 的执行准确率为 69.0%。

添加图片注释,不超过 140 字(可选)

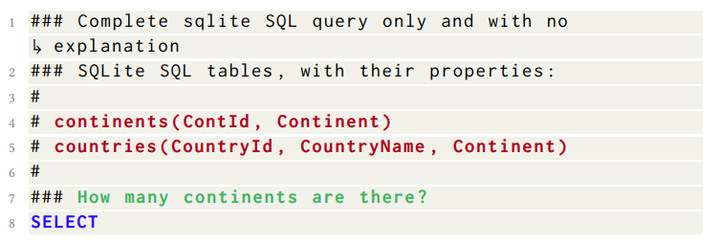

OpenAI 演示提示(OD ):如清单 2 所示,由指令、schema 和问题组成,所有信息用 #注释,指令更具体,例如 “仅需完成的sqlite SQL查询语句,无需提供说明。”。它在不同 LLMs 上有不同表现,在某些情况下能取得较好的性能。

添加图片注释,不超过 140 字(可选)

代码表示提示(CR ):如清单 4 所示,以 SQL 语法呈现 Text-to-SQ 任务,直接呈现 CREAT TABLE 建表语句,并在注释中给出自然语言问题。它能提供全面的数据库创建信息,如列类型和主 / 外键,对 LLM CODE - DAVINCI - 002 的准确率较达到了 75.6% 。

添加图片注释,不超过 140 字(可选)

Alpaca SFT 提示(AS ):如清单 5 所示,为监督微调设计的提示,以 Markdown 格式提示 LLM 根据输入上下文完成任务。

添加图片注释,不超过 140 字(可选)

3.1.2 实验结果与分析

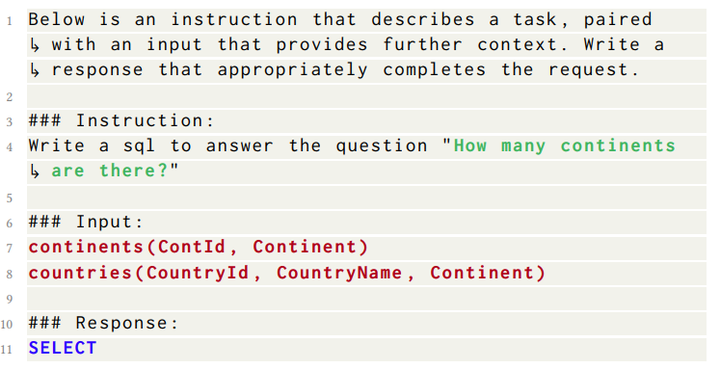

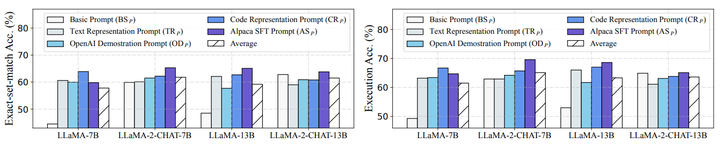

(1)通过在 zero-shot 零样本 场景下对 Spider-dev 数据集的实验(图 1),比较不同问题表示方法在不同 LLMs 上的性能。结果显示,不同 LLMs 对问题表示方法有不同偏好。例如,OD 适合多种 LLMs,在 GPT-3.5-Turbo 上执行准确率达到75.5%;而 AS 在 GPT-3.5-Turbo、TEXT-DAVINCI-003 和 Vicuna-33B 上表现较差。GPT-4 对简单的 BS 有偏好,这表明强大的 LLM 可能会减轻表示设计的复杂性。综合不同 LLMs 的平均性能,GPT-4 和 GPT-3.5-Turbo 在零样本场景下能力较强。因此,对于零样本场景,GPT-3.5-Turbo 和 OD 可能是较好的选择;对于较弱的 LLMs,如 TEXT-DAVINCI- 003 和 Vicuna-33B,OD 和 CR 更优。

添加图片注释,不超过 140 字(可选)

(2)消融研究进一步探讨了外键(FK)和规则暗示(RI)对性能的影响。

-

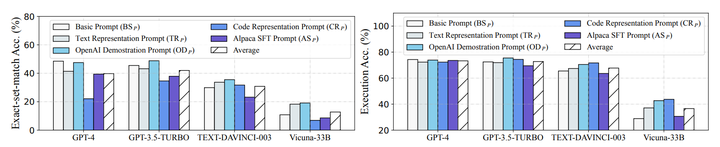

外键暗示不同关系表之间的关系,在 Text-to-SQL 任务中可能有帮助。只有 CR 包含外键信息,通过在其他表示中添加外键信息并在 Spider-dev 上进行评估(图 2),发现外键能显著提高多数 LLMs 的执行准确率,但对某些组合有负面影响。例如,外键使 BS 的执行准确率提高了 5.0%,但对 OD 和 AS 的性能有不利影响。

添加图片注释,不超过 140 字(可选)

-

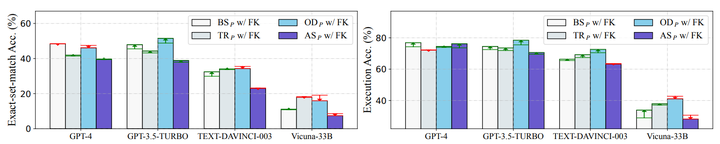

受 OD 性能的启发,研究规则暗示的影响。通过在不同表示中加入 “没有解释” 规则暗示并进行消融研究(图 3),发现添加该规则能一致提高所有 LLMs 在精确集匹配和执行准确率方面的性能,其中最显著的改进分别超过 6% 和 3%。而对于 OD ,移除该规则会导致精确集匹配准确率下降 2.4% - 6.2%,执行准确率下降 1.3% - 2.4%,表明该规则暗示的重要性。同时,对另一种规则暗示 “Let’s think step by step” 进行测试,发现其在 Text-to-SQ 任务中的性能高度不稳定。

添加图片注释,不超过 140 字(可选)

3.2 上下文学习的关键要素

上述问题表示方法使 LLM 能够直接通过 zero-shot 零样本学习输出所需的 SQL。但是 LLM 还可以通过上下文学习,在文本中输入少量的示例,使其在文本到 SQL 方面表现的更好。因此,在本小节中,我们将讨论上下文的关键学习,即示例选择和示例组织。我们首先给出上下文学习的方案,以进一步进行讨论。

添加图片注释,不超过 140 字(可选)

3.2.1 示例选择

随机选择:随机从可用候选示例中选取 k 个示例,是示例选择的一种基线方法。

问题相似性选择(QTS ):选择 k 个与目标问题最相似的示例,通过将示例问题和目标问题嵌入预训练语言模型,应用距离度量方法选择示例。

掩码问题相似性选择(MQS ):针对跨域 Text-to-SQ,通过用掩码标记替换表名、列名和值来消除特定领域信息的负面影响,然后计算嵌入相似度选择示例。

查询相似性选择(QRS ):不使用目标问题,而是旨在选择 k 个与目标 SQL 查询相似的示例。通过初步模型生成近似的 SQL 查询,然后根据关键词将示例查询编码为二进制离散语法向量,综合考虑相似度和多样性选择示例。

指出在示例选择时应综合考虑问题和 SQL 查询,因为根据上下文学习的本质是从类比中学习,在 Text-to-SQ 任务中需要生成与给定问题匹配的查询,所以 LLMs 应该学习从问题到 SQL 查询的映射。

3.2.2 示例组织

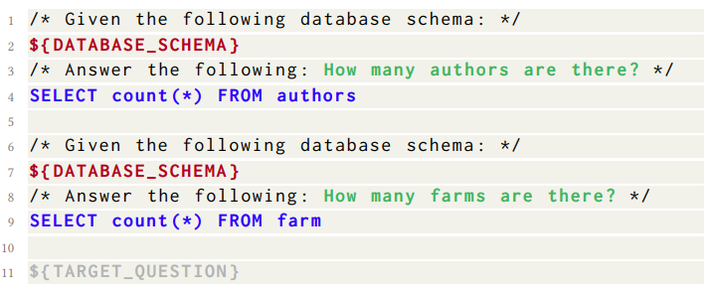

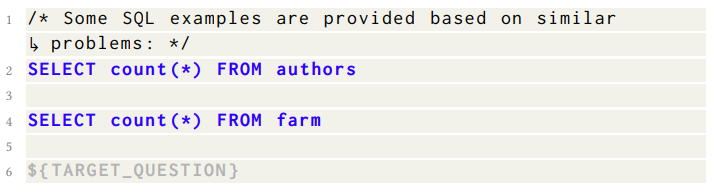

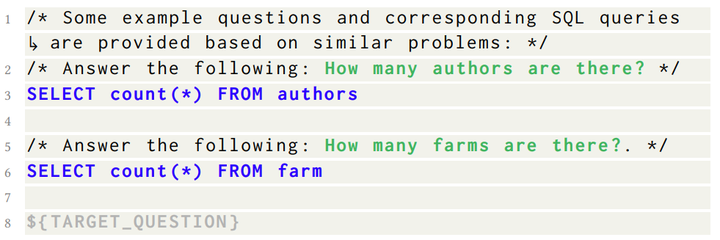

全信息组织(FI ):如清单 6 所示,组织示例的方式与目标问题相同,包含完整信息,包括指令、模式、问题和对应的 SQL 查询,仅在结尾的 “SELECT” 处与目标问题有所不同,此处为对应的 SQL 查询。这种方式保证了质量,但可能在数量上受限。

添加图片注释,不超过 140 字(可选)

仅 SQL 组织(SO ):如清单 7 所示,只包含所选示例的 SQL 查询,并在提示中有前缀指令。这种方式旨在最大化示例数量,但丢失了问题与 SQL 查询的映射信息,而该信息可能是有用的。

添加图片注释,不超过 140 字(可选)

提出一种新的示例组织策略 DAIL - SQL 的示例组织(DAIL ),它呈现问题和相应的 SQL 查询,作为 FI 和 SO 的折衷,保留问题-SQL 映射,同时减少示例的标记长度,通过去除标记成本较高的数据库模式来实现。

3.3 DAIL-SQL 的创新方法

添加图片注释,不超过 140 字(可选)

示例选择(DAIL ):综合考虑问题和查询来选择候选示例。首先在目标问题 和候选集 Q 中的示例问题 中掩码特定领域的单词,然后根据掩码后的问题嵌入的欧几里得距离对候选示例进行排序,同时计算预预测的 SQL 查询 ′与 Q 中的 的查询相似性,最后根据问题相似性和查询相似性大于预定义阈值 的标准选择示例,使得所选的 k 个示例在问题和查询方面都有良好的相似性。

示例组织(DAIL ):呈现问题和相应的 SQL 查询,保留问题 - SQL 映射,同时减少示例的标记长度。通过去除标记成本较高的数据库模式来实现,既保证了质量又考虑了数量。

3.4 监督微调的应用与探索

为了提高大型语言模型在零样本场景下的性能,现有的文本到 SQL 方法中流行的选择是上下文学习,这在上述小节中进行了讨论。作为一种替代但有前途的选择,有监督微调目前探索较少。与针对各种语言任务的有监督微调类似,我们可以将其应用于文本到 SQL 领域,并提高大型语言模型在这个下游任务上的性能。为了进一步了解有监督微调在文本到 SQL 中的作用,我们首先提供如下简要公式。

添加图片注释,不超过 140 字(可选)

3.4.1 公式及原理

对于 Text-to-SQ 任务,给定一个大型语言模型 M 和一组 Text-to-SQ 训练数据

![]()

添加图片注释,不超过 140 字(可选)

,监督微调的目标是最小化经验损失。其中, 和 分别是自然语言问题和其在数据库 上的对应查询,通过最小化损失函数 L 来衡量生成查询与真实查询之间的差异。监督微调包括两个子任务:对给定 LLM 进行微调以及寻找最优问题表示,这与问题表示部分相关联。

3.4.2 数据准备和微调过程

从给定的 Text-to-SQ 数据集中生成提示 - 响应对进行微调。具体而言,给定数据集

![]()

添加图片注释,不超过 140 字(可选)

,将目标问题和给定数据库作为提示,将期望的查询作为 LLM 的响应,即生成 T ={( = ( , ), = )}。根据计算资源情况,可以选择全微调或参数高效微调。例如,在有足够计算资源时可选择全微调,否则可选择参数高效微调。

3.4.3 开源 LLMs 的监督微调研究

(1)选择 LLaMA 及其对齐变体作为研究对象,包括 LLaMA - 7B、LLaMA - 13B、LLaMA - 33B、Falcon - 40B、Alpaca - 7B、GPT4ALL - 7B、Vicuna - 7B、Vicuna - 13B、Vicuna - 33B、LLaMA - 2 - CHAT - 7B、LLaMA - 2 - CHAT - 13B、LLaMA - 2 - CHAT - 70B 和 CodeLLaMA - 34B 等。

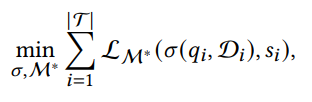

(2)在零样本场景下,通过对不同开源 LLMs 在 Spider - dev 上的实验(表 3),研究问题表示、模型规模和对齐对性能的影响。结果表明,CR 在不同开源 LLMs 上表现最佳,可能是因为其包含的全数据库知识补偿了开源 LLMs 的能力不足,或者刺激了 LLMs 的编码能力。从模型规模来看,LLaMA 和 Vicuna 的模型规模与性能呈正相关,例如 LLaMA - 2 - CHAT - 70B 随着参数增多性能提高。从对齐角度看,对齐后的 LLMs 在 Text-to-SQ 任务中表现更好,例如 Vicuna 在相同模型规模下比 LLaMA 执行准确率高约 5%。Falcon - 40B 由于训练数据集中缺乏专用代码数据,表现较差。CodeLLaMA - 34B 通过精心收集的代码数据在对齐阶段表现出显著的性能提升,尽管其参数只有 LLaMA - 2 - CHAT - 70B 的一半,但性能却超过了后者,这凸显了训练语料在 LLMs 中的重要性。

添加图片注释,不超过 140 字(可选)

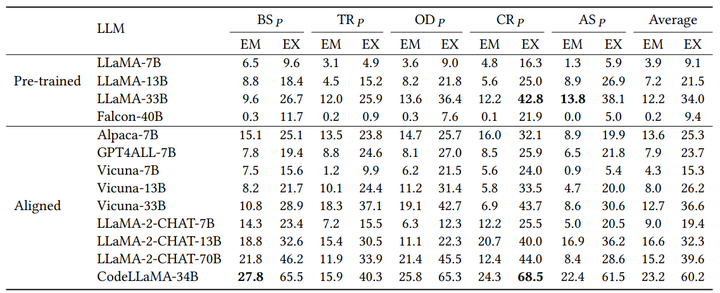

(3)在少样本场景下,以 LLaMA - 33B 和 Vicuna - 33B 为例,使用 CR 和 DAIL Selection 进行实验(图 5)。结果表明,LLaMA - 33B 受益更多,在 5 - shot Full - Information Organization 示例下达到 36.4% 的精确集匹配准确率。不同组织策略在不同 k - shot 场景下表现不同,Full - Information Organization 在多数情况下表现较好。

添加图片注释,不超过 140 字(可选)

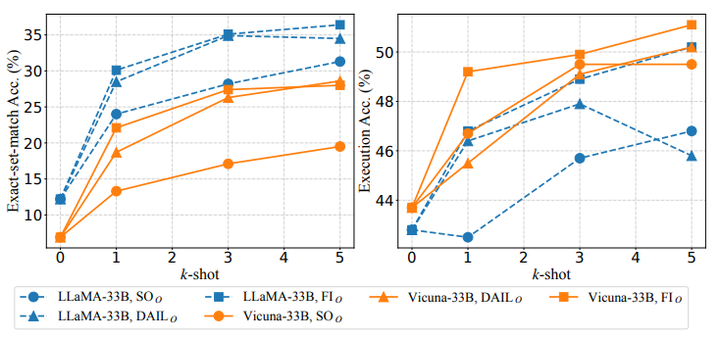

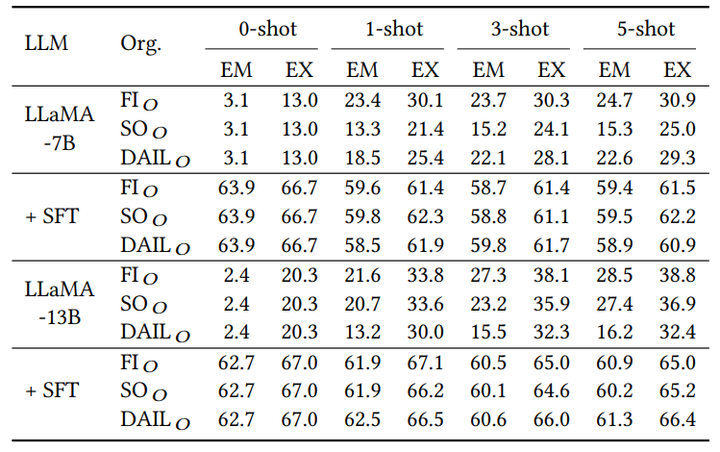

(4)监督微调后,在零样本场景下,开源 LLMs 的性能得到显著提升(图 6)。不同表示方法和模型规模之间的差距在微调后变窄,可能是因为微调后 LLMs 学会了在没有任务指令和外键的情况下回答新的 Text-to-SQ 问题。在少样本场景下,对微调后的 LLaMA - 7B 和 13B 进行实验(表 4)。结果表明,微调后的 LLMs 无法从示例中学习,添加上下文示例反而导致精确集匹配和执行匹配准确率下降,这可能是因为 LLM 过度拟合零样本提示,使得示例变得无用。

添加图片注释,不超过 140 字(可选)

添加图片注释,不超过 140 字(可选)

四、实验

4.1 实验设置

4.1.1 数据集选择

使用了两个被广泛认可的数据集:Spider 和 Spider - Realistic。Spider 是一个大规模的跨域 Text-to-SQ 数据集,包含 200 个数据库的 8659 个训练实例和 1034 个开发实例,每个实例由一个特定数据库上的自然语言问题及其对应的 SQL 查询组成。在本文中,使用开发集 Spider - dev 进行评估。Spider - Realistic 是 Spider 的一个更具挑战性的变体,它从 Spider - deV 中选择了 508 个示例,并手动修改了问题,同时保持 SQL 查询不变。在少样本场景中,使用 Spider 的训练集作为示例候选集,用于在 Spider - dev 和 Spider - Realistic 上进行测试。

4.1.2 评估指标确定

采用精确集匹配准确率(EM)和执行准确率(EX)作为评估指标。精确集匹配准确率衡量预测的 SQL 查询与对应的真实 SQL 查询之间匹配的 SQL 关键词数量,执行准确率则比较预测的 SQL 查询在某些数据库实例上的执行输出与真实 SQL 查询的执行输出。这两个指标能够更准确地评估模型的性能,因为对于一个给定的问题可能存在多个有效的 SQL 查询。

4.1.3 LLM 参数设置

为了确保公平比较,对所有方法使用相同的最大上下文长度,OpenAI LLM 为 4096,开源 LLM 为 2048。在评估过程中,预留 200 个标记用于响应生成。默认情况下,将温度参数设置为 0,以消除随机性的影响。在处理响应时,遵循现有工作,提取响应中的第一个 SQL 查询并去除额外的输出。

4.2 问题表示实验结果

4.2.1 零样本场景评估

通过在零样本场景下对 Spider - dev 数据集的实验(图 1),比较了不同问题表示方法在不同 LLMs 上的性能。结果表明,不同 LLMs 对问题表示方法的偏好不同,OD 在大多数 LLMs 上表现较好,而 AS 在部分 LLMs 上表现较差。通过消融研究(图 2、图 3),进一步探讨了外键(FK)和规则暗示(RI)对性能的影响。外键在多数情况下能提高 LLMs 的执行准确率,但对某些组合有负面影响;规则暗示 “没有给出任何解释” 能显著提高所有 LLMs 的性能,而另一种规则暗示 “让我们一步一步地思考。” 性能不稳定。综合来看,OD 与外键和 GPT - 3.5 - TURBO 的组合在零样本场景下是最有效和经济的。

4.2.2 消融实验总结

对外键和规则暗示的消融实验结果表明,它们对 Text-to-SQ 任务的性能有重要影响。外键信息对不同的问题表示方法和 LLMs 组合有不同的影响,而规则暗示 “没有给出任何解释” 在提高性能方面表现出一致性。这些结果为进一步优化问题表示方法提供了依据。

4.3 上下文学习实验详情

在少样本场景下,我们使用 GPT-4、GPT-3.5-Turbo、TEXT-DAVINCI-003 和 Vicuna-33B 来检验不同的示例选择和组织策略。

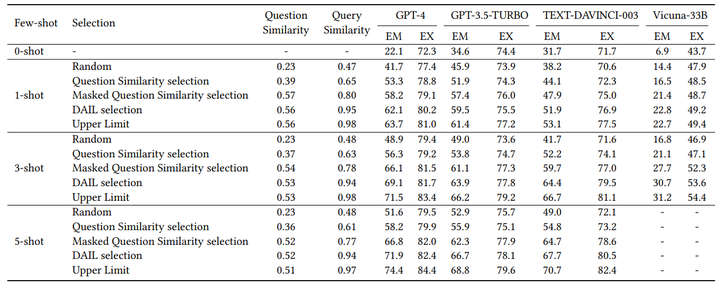

4.3.1 示例选择实验分析

添加图片注释,不超过 140 字(可选)

在少样本场景下,对不同示例选择策略进行了实验(表 2)。通过计算问题和查询的 Jaccard 相似度,并与目标实例进行比较,结果表明 DAIL 策略在大多数情况下优于其他策略。同时,问题和查询相似度越高,执行准确率越高,这进一步强调了在示例选择中同时考虑问题和查询的重要性。

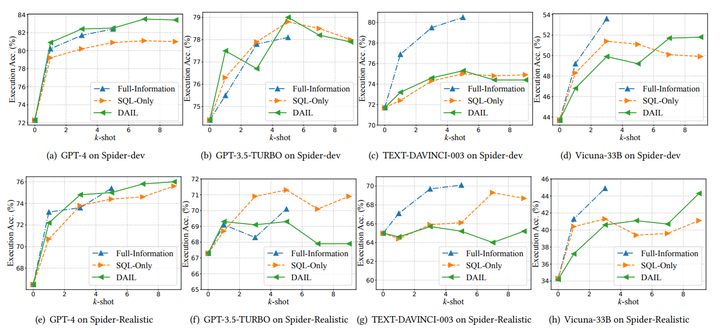

4.3.2 示例组织实验解读

添加图片注释,不超过 140 字(可选)

在少样本场景下,对不同示例组织策略进行了实验(图 4)。结果表明,不同 LLMs 对不同示例组织策略有不同的偏好。例如,GPT-4 在 DAIL 组织下受益最大,其执行准确率在 Spider-dev 上从 72.3% 提高到 83.5%,在 Spider-Realistic 上从 66.5% 使得该组织方式对其效果较好。对于 GPT-3.5-Turbo 和 TEXT-DAVINCI-003,添加示例可能会导致执行准确率下降,这可能是由于它们的上下文学习能力有限。对于 Vicuna-33B 随着示例数量的增加,其性能在 DAIL 组织下持续提高。综合来看,DAIL 组织在某些情况下能够取得较好的性能,并且对于具有较强上下文学习能力的 LLM,如 GPT-4 效果更为明显。

4.4 监督微调实验成果

在这一部分中,我们研究文本到 SQL 的有监督微调。由于对 OpenAI 大语言模型进行微调的成本高得难以承受,我们专注于开源大语言模型。鉴于很少有现有工作采用开源大语言模型且它们的性能尚不清楚这一事实,我们首先对开源大语言模型进行全面评估,采用各种问题表示、示例选择和组织策略。之后,我们在文本到 SQL 中对开源大语言模型进行微调,并观察它们在零样本和少样本场景下的性能提升。

4.4.1 开源 LLMs 实验总结

在零样本场景下,对不同开源 LLMs 进行了实验(表 3),分析了问题表示、模型规模和对齐对性能的影响。结果表明,CR 在不同开源 LLMs 上表现最佳,模型规模和对齐对性能有积极影响。在少样本场景下,以 LLaMA - 33B 和 Vicuna - 33B 为例进行实验(图 5),结果表明 LLaMA - 33B 受益更多,Full - Information Organization 在不同 k - shot 场景下表现较好。在监督微调方面,零样本场景下监督微调能显著提升性能,不同表示方法和模型规模之间的差距在微调后变窄(图 6)。少样本场景下,微调后的 LLMs 无法从示例中学习(表 4)。

从实验结果可以看出,开源 LLMs 在 Text-to-SQ 任务中具有一定的潜力,尤其是在监督微调后,其性能在零样本场景下有明显提升,能够与一些非开源的 LLMs 相媲美。然而,少样本场景下的问题也不容忽视,这可能需要进一步研究如何更好地利用示例信息,或者探索更合适的微调方法来解决。

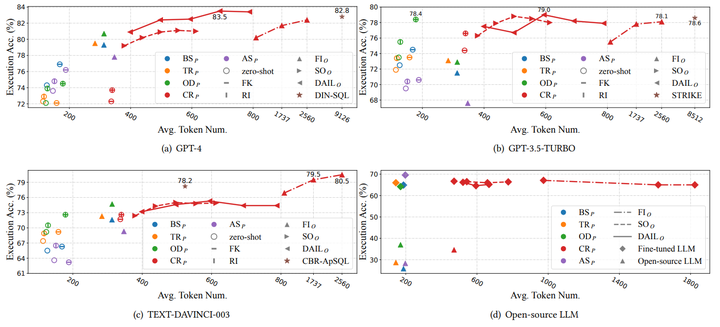

4.4.2 标记效率实验探讨

添加图片注释,不超过 140 字(可选)

强调了标记效率在 Text-to-SQ 任务中的重要性,并对不同表示方法和组织策略进行了标记效率的实验(图 7)。在零样本场景下,外键相关的提示在提高执行准确率的同时可能会消耗更多的标记。在少样本场景下,FI 组织方式效率较低,DAIL 在准确性和效率方面优于 SO 和 FI 。与其他先进的 Text-to-SQ 方法相比,DAIL - SQL 在准确性和效率上表现更优。对于开源 LLMs,微调后的 LLMs 标记效率有所提高,但添加示例可能会降低效率。

标记效率的研究为实际应用提供了重要的参考。在实际使用 LLMs 进行 Text-to-SQ 任务时,需要考虑如何在保证性能的前提下,尽可能地减少标记的使用,以提高效率和降低成本。DAIL - SQL 在这方面表现出了优势,为未来的研究和应用提供了一个良好的方向。

五、讨论

5.1 问题表示建议

推荐使用代码表示提示(CR )和 OpenAI 演示提示(OD ),因为它们在实验中表现出较好的性能。同时,外键和规则暗示等信息对于问题表示也非常有帮助,可以进一步提高性能。在实际应用中,可以根据具体的 LLM 和任务需求,灵活选择和组合这些方法,以达到最佳的效果。

5.2 示例选择要点

强调在示例选择中应同时考虑自然语言问题和 SQL 查询的相似性,这是设计有效示例选择策略的关键因素。通过实验证明,同时考虑这两个因素的 DAIL 策略在大多数情况下优于其他策略。未来的研究可以进一步探索如何更准确地衡量和利用这种相似性,以提高示例选择的质量。

5.3 示例组织策略

根据所采用的 LLM 的能力来选择示例组织策略。如果 LLM 足够强大,如 GPT - 4,呈现问题和 SQL 查询对是一种有效且高效的选择;否则,呈现全信息示例可能更为合适。这一结论为不同能力的 LLMs 在处理 Text-to-SQ 任务时提供了一种实用的指导原则,有助于提高任务的处理效率和效果。

5.4 开源 LLM 的思考

指出拥有更多参数的 LLMs 对 Text-to-SQ 任务有益,但训练语料在其中起着更为关键的作用。监督微调对于开源 LLMs 在 Text-to-SQ 任务中具有必要性且有很大的潜力。未来的研究可以进一步探索如何更好地利用监督微调技术,提高开源 LLMs 的性能,同时也需要关注训练语料的质量和多样性,以充分发挥 LLMs 的潜力。

5.5 研究局限性分析

由于资源有限,只测试了两种规则暗示,未来可以进一步探索更多规则暗示以提高性能。只使用了 Spider 训练集对开源 LLMs 进行微调,额外的 Text-to-SQ 数据可能会进一步增强 LLMs。Spider 和 Spider - Realistic 中的数据库可能不够大,在面对大量表的 Text-to-SQ 任务时可能会出现新的挑战。当前的评估指标优先考虑正确性而非效率,未来可以进一步研究如何促使 LLM 生成高效的 SQL 查询。

这些局限性为未来的研究指明了方向。研究人员可以在规则暗示、数据使用、数据库规模和评估指标等方面进行进一步的探索和改进,以推动 Text-to-SQ 技术的不断发展。

六、结论

6.1 研究总结

本文对基于 LLM 的 Text-to-SQ 任务进行了系统的研究。通过对现有提示工程方法的系统比较,提出了一种新的集成解决方案 DAIL - SQL,该方案在 Spider 排行榜上取得了 86.6% 的执行准确率,刷新了纪录。在问题表示方面,深入研究了不同的表示方法及其组成部分对性能的影响;在上下文学习方面,提出了 DAIL - SQL 的示例选择和组织方法,强调了同时考虑问题和查询的重要性;在监督微调方面,展示了开源 LLMs 在 Text-to-SQ 任务中的潜力,同时也指出了微调后可能出现的问题,如在少样本场景下无法从示例中学习。此外,还强调了标记效率在提示工程中的重要性,并通过实验证明了 DAIL - SQL 在准确性和效率方面的优势。

6.2 未来研究方向

然而,本文也存在一些局限性,未来的研究可以进一步探索更多规则暗示、使用更多的 Text-to-SQ 数据、应对更大规模的数据库以及优化评估指标以提高 Text-to-SQ 任务的性能。这些方向将有助于进一步完善 Text-to-SQ 技术,使其在实际应用中发挥更大的作用。

总之,本文为 Text-to-SQ 任务的进一步研究提供了全面的理论基础和实践指导,希望能够激发更多的研究人员关注和参与到这一领域的研究中来,共同推动 Text-to-SQ 技术的不断发展。

论文地址:https://arxiv.org/pdf/2308.15363

Text-to-SQL Empowered by Large Language Models: A Benchmark Evaluation

希望这篇文章能让您对论文的核心内容有更深入的了解,欢迎关注公众号,记着点赞、评论转发哦

3826

3826

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?