paper:《Matching the Blanks: Distributional Similarity for Relation Learning》

code: BERT-Relation-Extraction

论文贡献:

1. 测试了Bert的不同的输入方式和输出方式对关系抽取结果的影响

2. 无监督的训练任务:MTB,在少样本关系抽取任务上效果提升明显。

预训练阶段

论文使用数据集:一段连续的文本,通过spacy从文本中滑动窗口去取抽取实体,构成样本(参考上述code)

模型数据构建:

1. dataset中获取一条样本A (batch=16)

2. 获取正样本:与样本A包含相同实体e1,e2的作为候选正样本,从候选正样本中随机抽取batch/2 的样本作为正样本(0.7的概率把实体 用 [blank]替换 )

3.获取负样本:包含的实体与A不同的(要么全不同,要么部分不同)样本作为候选负样本,从候选负样本中抽取出batch/2的样本作为负样本

模型细节:

预训练任务:MLM 和MTB (论文4.3节详细说明了)

模型输入:文本序列, real mask token(被mask掉的真实token), e1e2 start(实体的起始位置)

模型输出:

1.mask位置的预测(MLM任务输出)

2.e1e2起始位置拼接起来的向量,维度是 【batch*1536】 (1536=2x768)

损失函数:

1.mlm loss:预测被mask的词,用交叉熵损失

2.MTB loss: 二分类问题,样本两两组合,预测是正立还是负例(BCE,二元交叉熵损失)

微调阶段

有监督任务(分类任务)

论文使用数据集:SemEval 2010 Task 8

预测一段包含两个实体的文本是属于哪种关系

模型输入:

x: 一句话,包含两个实体

y:这句话属于哪个标签

损失函数:

交叉熵损失

论文在不同数据集上的实验效果如下,有过MTB预训练的模型效果更好,但是提升不是很显著

不同的数据量下训练的结果如下,可以得出结论:有过MTB预训练的模型,在较少的样本下,表现的效果优于没有MTB预训练的

few shot task(少样本学习)

fewRel数据集 介绍:FewRel[11]数据集由Han等人在EMNLP 2018提出,是一个小样本关系分类数据集,包含64种关系用于训练,16种关系用于验证和20种关系用于测试,每种关系下包含700个样本。

每个样本格式如下:

{

"tokens": [

"In",

"June",

"1987",

",",

"the",

.....

],

"h": [

"cape girardeau bridge",

"Q5034838",

[

[

26, # 实体位置

27,

28

]

]

],

"t": [

"mississippi river",

"Q1497",

[

[

19, # 实体位置

20

]

]

]

}论文在fewRel数据集上做了评估,效果如下图,图中的指标是精确率。

(图片待补)

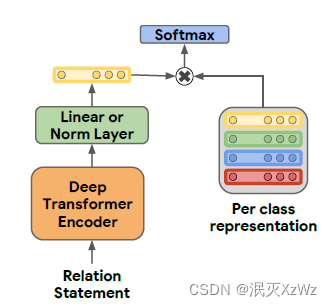

5 way 1 shot 意思是(数据集构建):假设类别一共有A~Z个类别,假设当前样本是A类,从剩下其它类中抽取4(4=5-1)个类,加上A类,一共5 (5 way)个类,从这5个类的样本中,每个类抽取1(1 shot)条样本,一共有5条样本,这5条样本称为候选样本,加上当前样本,则有6条,这6条数据送入模型,获得6个embeding, 将当前样本和其它5个做内积。

损失函数:交叉熵

论文原话:For the few-shot task, we use the dot product between relation representation of the query statement and each of the candidate statements as a similarity score. In this case, we also apply a cross entropy loss of the softmax of similarity scores with respect to the true class.

参考博客:

1719

1719

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?