前言

如本博客公告所述,目前和各个合伙人共管4个办公室:

- 长沙具身团队:侧重大模型赋能具身的定制开发,例如机械臂上的精密插拔、智能装配,及人形展厅讲解、人形灵巧操作、人形舞蹈定制等

- 武汉具身团队:侧重指导客户对世界级前沿模型的科研与复现,比如ACT/openpi/GR00T

- 上海具身团队(原南京团队,后迁至上海):侧重人形机器人大小脑的统一协调开发,偏loco-manipulation,如人形搬运,以落地工厂

- 北京教育团队

相当于对于人形这个方向,我司目前侧重:展厅讲解、灵巧操作、舞蹈定制、箱子搬运,故对人形搬运一直保持着高度关注,而本文一开始是在别的文章里的(本部分内容的首发时间则是2025年5.20),但鉴于把多个内容放在一篇文章里,篇幅过长,且不够专注

故把FALCON部分独立成此文,且做了大幅修订,以让解读更精准

PS,如果你也在研究人形搬运相关的方向,欢迎私我一两句简介,邀你入相关交流群

背景 Sim-to-Real Learning for Humanoid Box Loco-Manipulation(搬箱子)

// 待更

第一部分 FALCON:上下双智能体贡献全身感知从而联合训练的力自适应RL框架

3.1 引言与相关工作

3.1.1 引言

人形机器人在运动和操作方面已经取得了显著进展

- Humanoid locomotion and manipulation: Current progress and challenges in control,

planning, and learning - Teleoperation of humanoid robots: A survey

- B. Dynamics. Atlas® and beyond: the world’s most dynamic robots, 2024. URL https:

//bostondynamics.com/atlas/ - Unitree. Humanoid agent ai avatar, 2024. URL https://www.unitree.com/g1

- F. AI. Figure 02 humanoid robot, 2024. URL https://www.figure.ai/

- B. Robotics. Booster t1 humanoid robot, 2025. URL https://www.boosterobotics

.com/

然而,将这些能力扩展到高强度的行走-操作任务仍然具有根本性的挑战

- 例如,2015年DARPA挑战赛[7- The DARPA robotics challenge finals: Results and perspectives. J. Field Robotics, 34(2):229–240, 2017. doi:10.1002/ROB.21683. URL https://doi.org/10.1002/rob.21683]中强调的开门任务,不仅要求在动态、多方向力作用下实现精确操作,还要求在整个交互过程中保持下肢的稳定性

- 为满足这些需求,人形机器人系统必须能够灵活适应不同的负载和接触力,同时在行走-操作过程中保持整体的精度与鲁棒性

强化学习(RL)在类人全身控制方面取得了令人瞩目的成果

- 8- Mobiletelevision、9-HOMIE、10-Exbody2、11-Exbody

- 12-Hierarchical adaptive loco-manipulation control for quadruped robots

- 13-Adaptive force-based control of dynamic legged locomotion over uneven terrain

- 14- Bridging the sim-to-real gap for athletic loco-manipulation

- 15-Hover、16-H2O、17-Omnih2o、18-ASAP

- 19-Embrace Collisions: Humanoid Shadowing for Deployable Contact-Agnostics Motions

- 20-Whole body model predictive control with a memory of motion: Experiments on a torquecontrolled talos

- 21-Dynamic loco-manipulation on hector: Humanoid for enhanced control and open-source research

- 22-Humanoid loco-manipulations pattern generation and stabilization control

- 23-Quadratic programming for multirobot and task-space force control

- 24-Dynamic locomotion in the mit cheetah 3 through convex model-predictive control

- 25-Biped walking pattern generation by using preview control of zero-moment point

- 26-Humanplus、27-Wococo

但现有的RL方法大多仅在轻量级任务中取得成功,并未考虑在行走-操作任务中存在的显著交互力。目前,主要有两种范式

- Lower-RL-Upper-IK,即将RL应用于下肢运动,同时利用运动学求解器实现上肢控制[8-Mobiletelevision, 9-HOMIE]

该类方法缺乏针对强交互力的全身动力学建模,且全身协调性有限; - Monolithic-Whole-body-RL,直接学习控制所有自由度[10,11]

但此类方法探索效率低,因为单一策略需要同时学习相关性较弱的运动和操作技能。尽管在四足机器人力适应方面取得了一些进展 [12–14,28,29],但人形机器人面临着更多挑战,如不稳定性、更高的复杂性,以及在特定关节配置下更严格的力矩限制

为了使人形机器人能够执行多样化的力自适应行走-操作任务,来自CMU的研究者提出了FALCON「其对应的论文为:FALCON: Learning Force-Adaptive Humanoid Loco-Manipulation,Submitted on 10 May 2025」,这是一种采用精心设计的三维力课程、并遵循关节扭矩限制进行训练的双智能体RL架构

这是一种双智能体RL架构,通过精心设计的三维力课程训练,并严格遵循关节扭矩限制

他们主要创新包括:

- 一种双智能体学习分解方法,将下肢和上肢的策略训练分离,分别采用定制奖励,同时共享全身本体感知与指令

- 具有关节扭矩可行性的三维力课程,通过逆动力学在逐步增加两个末端执行器的三维施加力的同时,强制执行关节扭矩约束。FALCON实现了在有力行走-操作任务中对稳定行走与末端执行器精确跟踪的高效联合训练

结合关节扭矩可行性的三维力课程,逐步在两个末端执行器上施加可扩展的三维力,并通过逆动力学强制执行关节扭矩约束。FALCON实现了稳定行走与高精度末端执行器跟踪,且在高强度行走-操作任务中的高效联合训练

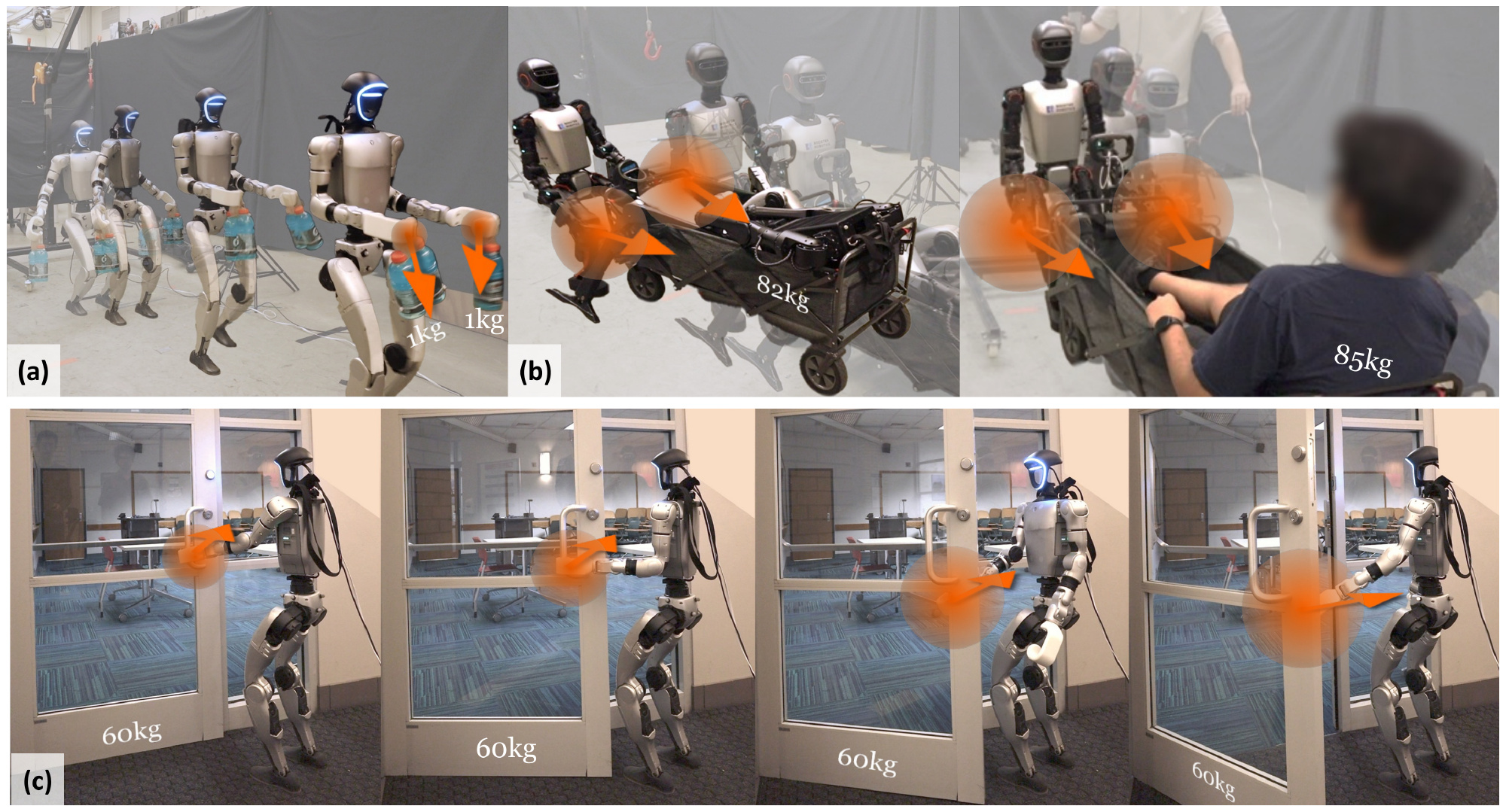

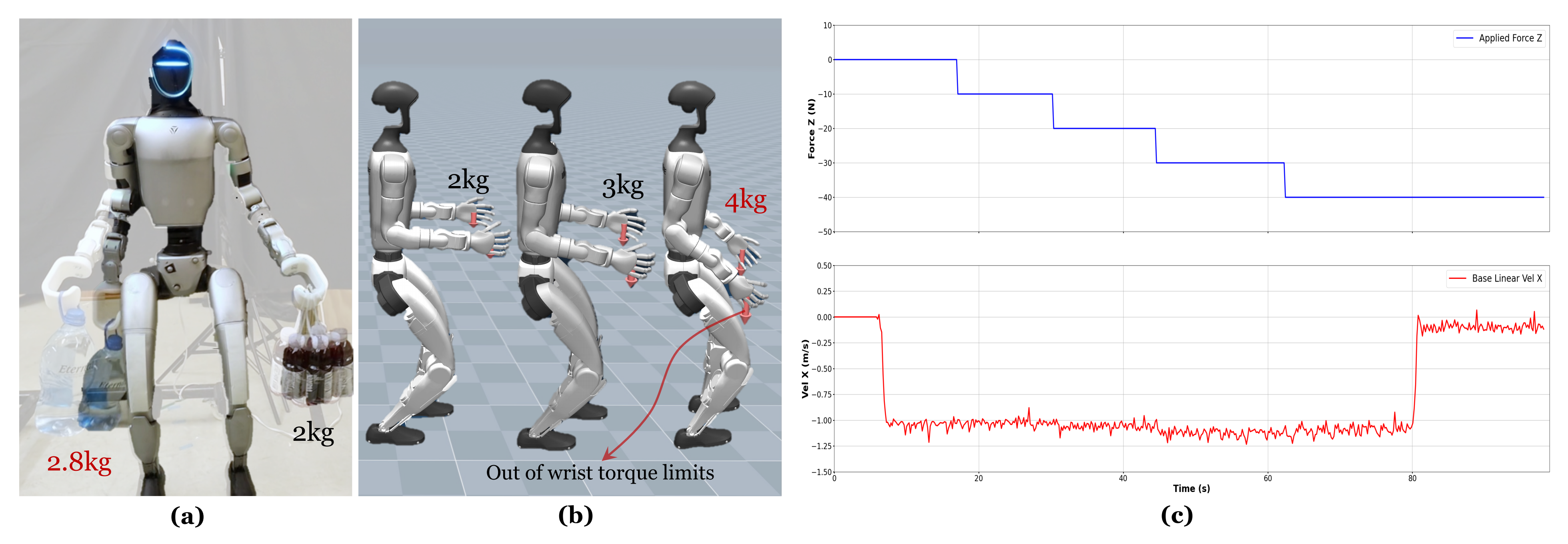

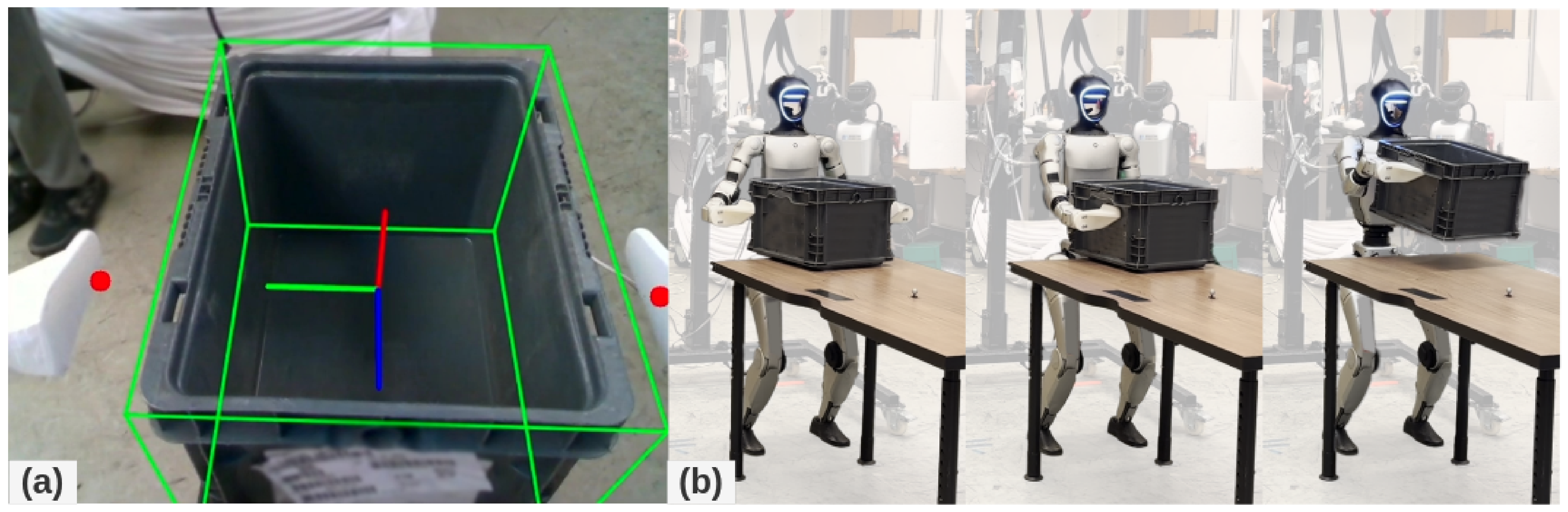

比如在Unitree G1和Booster T1人形机器人上验证了FALCON,展示了其在不同平台上的泛化能力,包括:

搬运负载

拉动小车

开门

详见见图1,这些任务均需要对显著未知的三维交互力进行实时适应

3.1.2 相关工作

第一,仿人形机器人行走与操作

- 类人机器人的行走-操作控制仍然是机器人领域中的一个具有挑战性的控制问题

虽然传统的基于模型的方法『例如,简化动力学模型和模型预测控制(MPC)』

20-Whole body model predictive control with a memory of motion: Experiments on a torquecontrolled talos

13-Adaptive force-based control of dynamic legged locomotion over uneven terrain

21- Dynamic loco-manipulation on hector: Humanoid for enhanced control and open-source research

22-Humanoid loco-manipulations pattern generation and stabilization control

23-Quadratic programming for multirobot and task-space force control

24-Dynamic locomotion in the mit cheetah 3 through convex model-predictive control

25- Biped walking pattern generation by using preview control of zero-moment point

30-Full-order sampling-based mpc for torque-level locomotion control via diffusion-style annealing

能够实现实时规划,但由于依赖人工设计,灵活性和泛化能力受限 - 相比之下,基于学习的方法——尤其是从仿真到现实的强化学习(sim-to-real RL)——在多样化的行走-操作任务中表现出了有前景的结果

31- Catch it! learning to catch in flight with mobile dexterous hands,接住飞行物

17-Omnih2o

11-Exbody

8-Mobiletelevision

9-HOMIE: humanoid loco-manipulation with isomorphic exoskeleton cockpit

32-Sim-to-real learning for humanoid box loco-manipulation

33-Opt2skill: Imitating dynamically-feasible whole-body trajectories for versatile humanoid locomanipulation - 对于人形机器人,目前主要有两种范式:Lower-RL-Upper-IK和Monolithic-Whole-body-RL

对于Lower-RL-Upper-IK

Lu等人[8-Mobiletelevision]提出了PMP,该方法利用逆向运动学(IK)和比例-微分(PD)控制实现上半身控制,而运动控制通过条件变分自编码器(CVAE)对上半身动作进行训练和调节

随后,Ben 等人 [9] 提出了 HOMIE,采用相同的解耦框架,但引入了基于外骨骼的驾驶舱,以实现更直观的人类遥操作

对于整体全身强化学习(Monolithic-Whole-body-RL)

Dao 等人 [32] 采用统一的强化学习方法处理箱体搬运任务,通过训练不同技能(如抬举、行走、站立),并利用有限状态机进行协调

He 等人[16-H2O,17-Omnih2o] 和 Ji 等人 [10-Exbody2] 则采用师生训练框架,模仿人类动作以完成行走与操作任务 - 尽管取得了这些进展,但很少有强化学习(RL)方法能够应对仿人机器人在执行行走-操作任务时末端执行器(EE)上出现的重大未知力扰动,且这两种范式各自存在关键缺陷

Lower-RL-Upper-IK方法在上半身控制中,力补偿存在延迟

Monolithic-Whole-body-RL方法由于上半身操作与下半身行走任务目标关联较弱,导致样本效率低下,常常出现过拟合,并使上半身或下半身的行为主导整体表现 - 在本研究中,受

34-Multi-agent deep reinforcement learning: a survey

35-Multi-agent reinforcement learning: A selective overview of theories and algorithms

36- Learning advanced locomotion for quadrupedal robots: A distributed multi-agent reinforcement learning framework with riemannian motion policies

的启发,作者提出了 FALCON,一种采用上下半身任务特定奖励函数分解的双智能体强化学习框架

与单独训练的架构不同,FALCON中的两个智能体通过共享本体感觉和命令进行联合训练,从而能够相互感知彼此的行为

这种联合训练防止了智能体各自独立适应,有效实现了对影响全身动力学的外部力的协调响应

第二,足式机器人中的强力交互

针对装有机械臂的四足机器人,强力交互已通过基于模型的方法进行了广泛研究——尤其是将模型预测控制(MPC)与力规划和控制相结合,以实现稳健且自适应的行走与操作[12,13,37]

- 近年来,强化学习(RL)的进步进一步提升了适应性,使四足机器人能够学习包括阻抗控制[38]和激进力适应[14]在内的自适应、灵活的力交互

- 对于人形机器人而言,强力交互面临更为严峻的挑战,这主要源于其更为复杂的动力学和更严格的关节限制。与质量分布集中的四足机器人不同,人形机器人在上下半身之间存在耦合动力学,这使得力适应尤其困难

- 近期基于模型的方法已在重载任务中实现了力控制[39,22],但这些方法需要事先了解被操作物体的质量、质心(CoM)或预定义的力轨迹,从而限制了其在未知扰动下的适用性

尽管已有部分研究尝试对人形机器人进行显式力估计[40],但这些方法仅限于准静态场景,无法应对动态行走操作中的力适应问题 - 在本文中,FALCON通过一种新颖的三维末端执行器(EE)受力课程,能够在不同末端执行器上隐式适应未知外部力,该课程同时考虑了仿人机器人关节力矩限制

通过这种方式,能够在保证关节力矩限制的前提下,最大化所学行走-操作策略对外力的适应能力,从而实现强健且安全的真实环境部署

3.2 FALCON:力自适应仿人行走-操作

在外部末端执行器力作用下的人形机器人行走-操作需要对上下半身进行协调控制

- 作者首先将该问题表述为一个统一的双目标条件策略学习问题

设人形机器人的自由度(DoFs)被划分为下半身关节和上半身关节,表示下半身自由度的数量,

表示上半身自由度的数量,

表示所有驱动关节的总数

- 机器人本体感知

,被定义为

其中包含关节位置

关节速度

根部角速度

投影重力

以及先前动作的五步历史信息

目标空间由运动目标

组成,指定所需的根部线速度与角速度、支撑指示器、根部高度和腰部偏航角

以及操作目标

指定上半身的目标关节配置,其中

在这一统一的形式下,传统方法的主要区别在于它们生成指挥机器人关节的动作的方式

- Lower-RL-Upper-IK:下半身动作

由一个策略

生成,该策略以全身本体感觉和目标为条件

而上半身动作则通过基于

的逆运动学(IK)求解器计算得到

虽然Lower-RL-Upper-IK方法具有较高的采样效率,但它们忽略了上半身的力补偿以及在末端执行器受力扰动下的全身耦合效应 - Monolithic-Whole-body-RL:单一策略

直接预测全身动作

,试图同时满足行走和操作两个目标

相比之下,Monolithic-Whole-body-RL方法提升了表达能力,但由于其涵盖了粗粒度相关的行走和操作目标,导致动作空间过大,从而探索效率低下

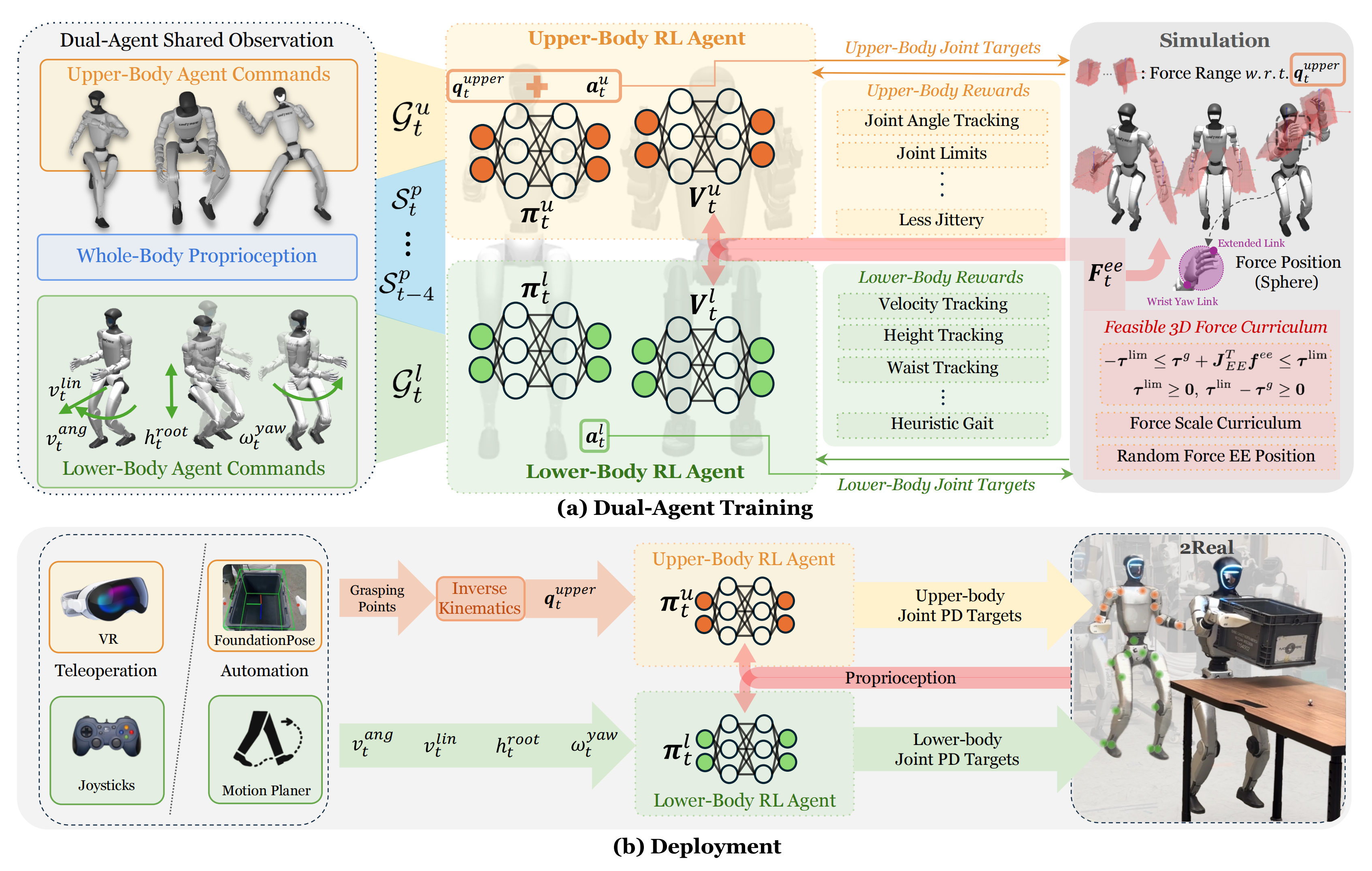

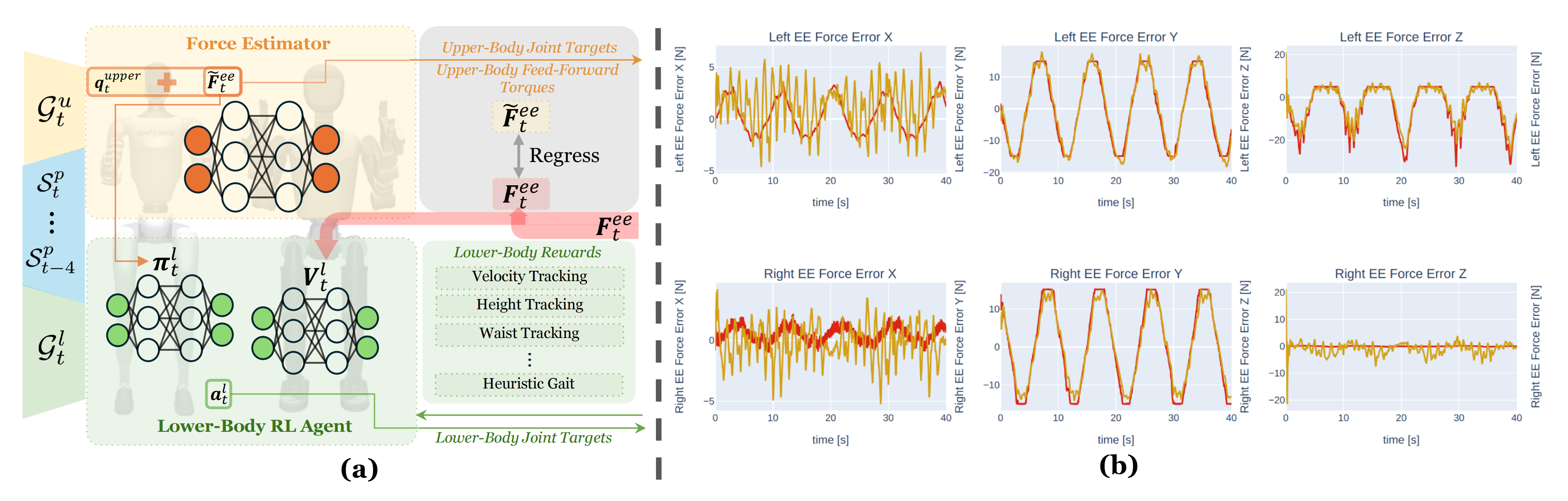

故,为克服这些挑战,作者提出了FALCON,这是一种双智能体强化学习框架,通过具有共享全身观测的分解学习,实现了训练效率和协调性

4.2.1 双智能体学习框架

如下图图2 所示,FALCON 联合训练两个智能体,每个智能体专注于不同的子任务

- 下肢行走智能体学习一个策略

,其价值函数为

- 而上肢操作智能体学习一个策略

,其价值函数为

两个智能体都接收相同的本体感觉输入,但分别优化独立的基于目标的目标函数

这两个策略参数和

通过近端策略优化PPO [42] 进行更新

其中为折扣因子。上半身目标关节角度

(肩、肘、腕的目标关节)在训练过程中从AMASS 数据集[43] 中随机采样,而在部署阶段则通过逆运动学(IK)计算得到

两个智能体的组合动作被发送到关节级PD 控制器。由于现实世界中的人形控制本质上是部分可观测的,故他们采用了非对称的actor-critic训练方法,其中critic 在训练过程中其中critic还可以访问包括根部线速度和末端执行器受力在内的特权信息,但在部署时无法访问

关于非对称 Actor-Critic 训练

在ASAP中 也用到了,详见此文《ASAP——让宇树G1后仰跳投且跳舞:仿真中重现现实轨迹,然后通过增量动作模型预测仿真与现实的差距,最终缩小差距以对齐》的『1.2.2 基于相位的运动追踪策略训练(Phase-based Motion Tracking Policy Training)』

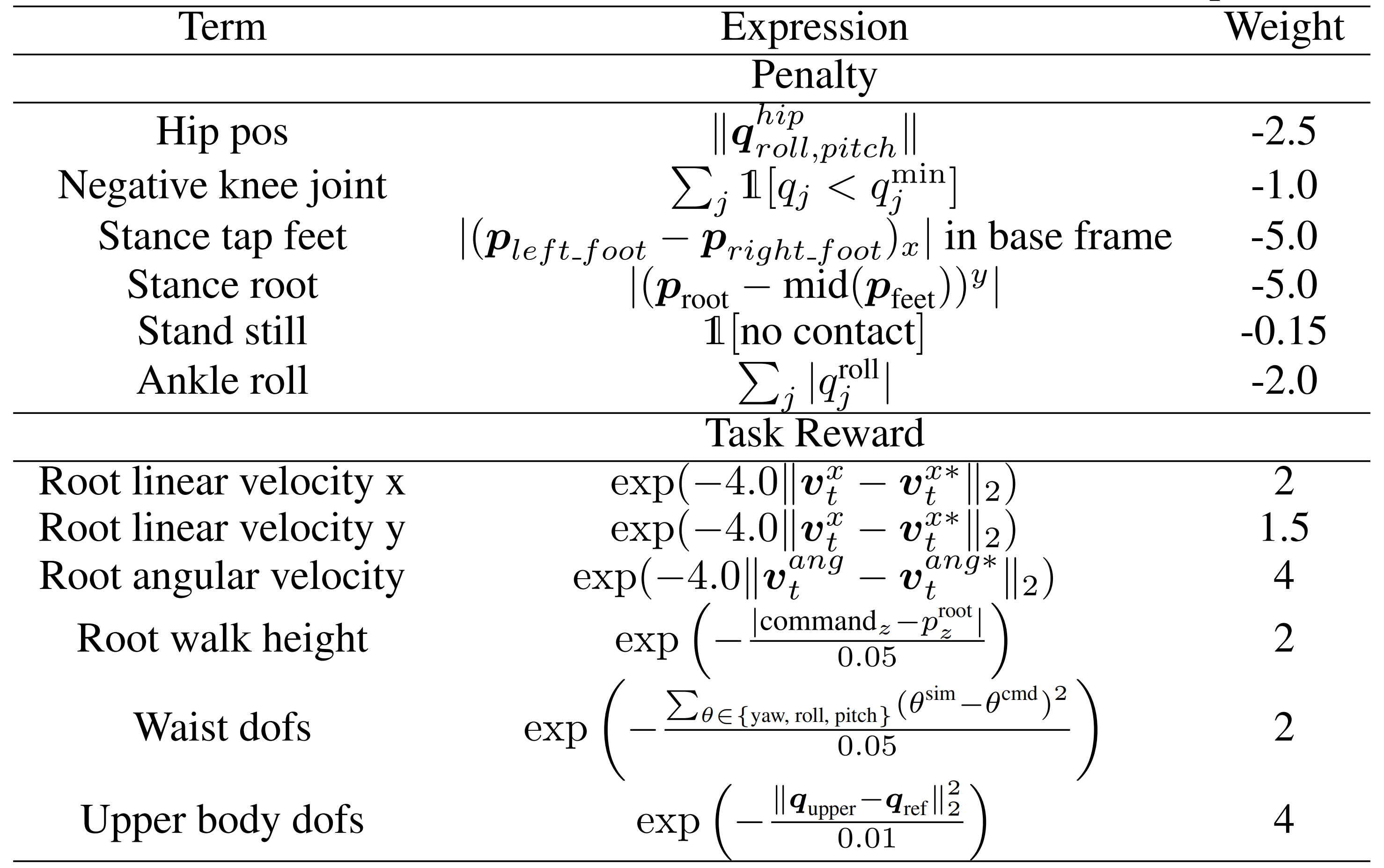

奖励设计细节和训练过程中的域随机化在原论文的附录A.1 和附录A.2中有说明,为方便大家一目了然,我摘取如下

- 对于奖励项

采用了与[17-Omnih2o,11-Exbody]类似的奖励项,但引入了一些重要的惩罚项,以确保在显著外力作用下的运动稳定性,并针对深蹲和腰部扭转增加了其他跟踪奖励

附加的奖励项总结于表5中『额外奖励组件及权重:用于防止不期望行为的惩罚奖励以实现从仿真到现实的迁移,以及用于实现期望的运动-操作能力的任务奖励』

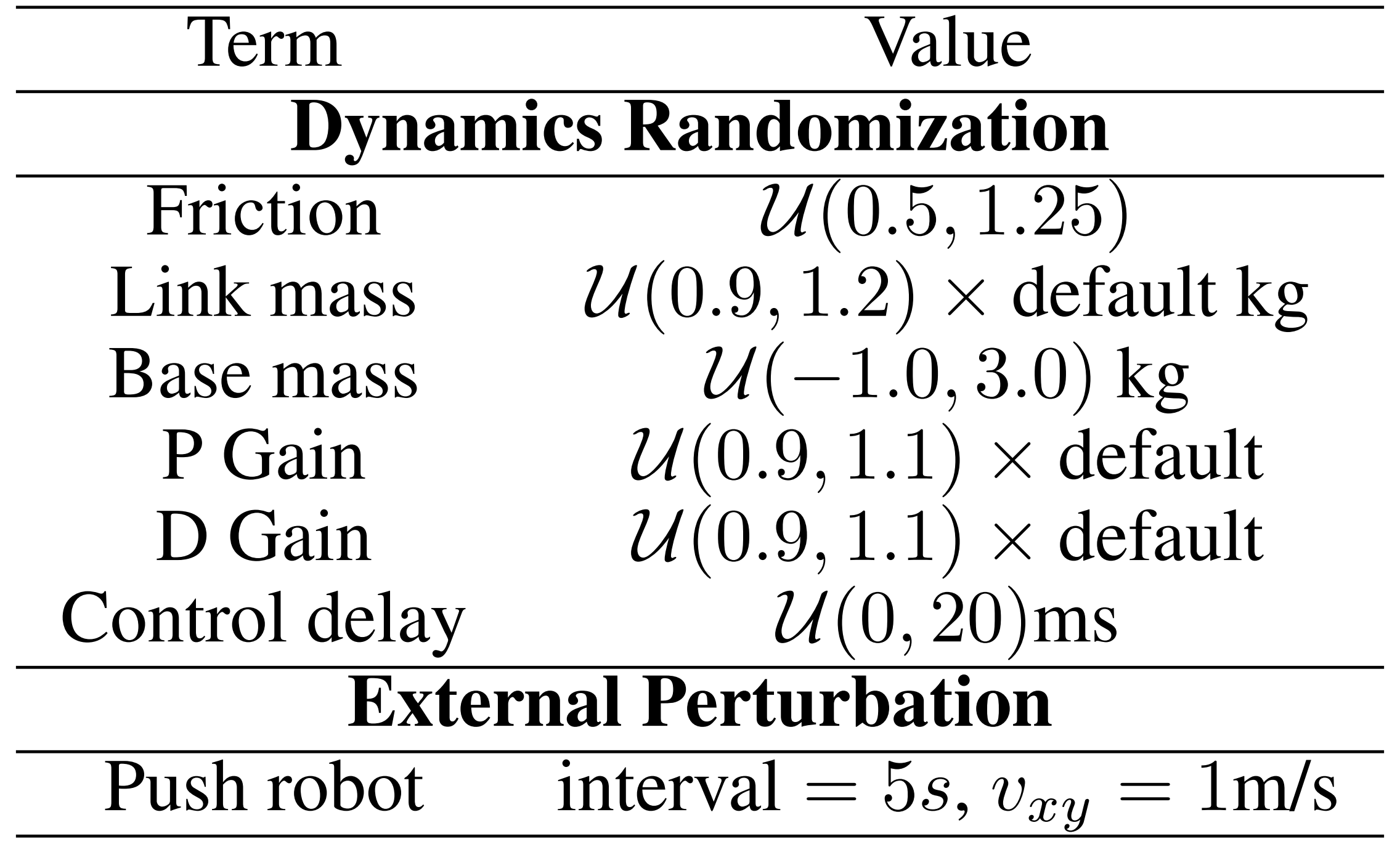

- 对于域随机化

作者在训练过程中应用以下域随机化项,这对于成功实现从仿真到现实的迁移非常重要,如下表表6所示,包括动力学随机化和外部扰动在内的领域随机化术语

// 待更

4.2.2 考虑扭矩限制的三维力课程

对于人形机器人——尤其是那些关节扭矩限制较弱的机器人,例如Unitree Humanoid G1的腕关节——在末端执行器(EE)受到较大外部扰动时,明确考虑这些扭矩约束至关重要

在上半身策略训练过程中忽视这些限制,可能导致实际机器人部署时出现意外或不安全的行为,例如扭矩饱和或关节极限违规

此外,在训练过程中逐步增加外部作用力也很重要,这样可以使策略逐步学习有效的力适应策略。为实现上述目标,他们的施力框架遵循以下三项原则

- 考虑转矩的力计算

在施加力之前

首先,需要估计可以施加在左端或右端执行器上的最大力

给定左端或右端执行器在其质心(CoM)处的Jacobian 矩阵

其关节转矩极限(其中

)

以及重力补偿转矩,该转矩满足

以确保可行性

作者通过分析在每个方向上施加单位力所引起的最坏情况关节转矩,来估计每个笛卡尔轴上的最大和最小允许力

,

逐元素的力界可以并行计算如下

其中表示末端执行器雅可比矩阵的

元,

是一个用于防止除以零的小正数

之后,作者通过Dirichlet 分布[44] 在x, y 和z 轴之间采样相对比例,其满足

可行的施加力将在估计范围内均匀采样,并表示为

该方法在遵守扭矩限制的同时最大化了力的自适应性,从而实现比随机采样更有效的训练,如第4.3节所述。请注意,由于上半身结构的不对称性(见图2),左右末端执行器施加的力可能会有所不同 - 渐进力课程Progressive Force Curriculum

为了促进渐进力适应,估算的EE 力通过一个全局因子进行缩放,该因子在训练过程中逐渐增加,因此施加的力变为

在行走过程中,平面力被投影到与速度相反的方向。应用低通滤波器以减少力的抖动 - 施加力的位置随机化(Position Randomization of the Applied Force)

基于学习的力适应利用本体感觉历史来隐式补偿外部力,从而无需显式力估计[40]或传感[45]

为了提高对末端执行器(EE)接触点变化的鲁棒性——这些变化会通过EE雅可比矩阵改变力矩映射——作者在EE连杆上对施力位置进行随机化,从腕部偏航到远端段,如上图图2所示

3.3 仿真与真实世界实验

在本节中,作者对FALCON与基线方法进行了广泛的定量比较,并展示了在真实世界部署中的定性结果,且作者选择了Unitree Humanoid G1和Booster T1作为他们的人形机器人平台

具体来说,他们关注以下关键问题:

- Q1:FALCON在上半身操作和下半身行走性能方面能否优于其他基线方法?

- Q2:为什么FALCON在力自适应行走操作方面的训练效率优于整体全身强化学习(M-WB-RL)?

- Q3:FALCON是否适用于不同的人形机器人,以展示其跨平台的泛化能力?

3.3.1 评估标准

为了评估所学习的下肢行走与上肢操作能力,作者在动态未知和三维末端执行器力的条件下,考虑以下指标,给定一系列目标上肢关节

、目标根部速度(target root velocities)

,以及支撑信号

,其中

,

为序列长度

- 上半身关节点跟踪误差:

- 根部速度跟踪误差:

3.3.2 基线方法

作者考虑了两类用于力自适应的基线方法,这两类方法均在相同的目标空间(例如,指令)下进行训练『见原论文第3.1节,即上文的3.2.1 双智能体学习框架』,并采用原论文第3.2节『即上文的3.2.2 考虑扭矩限制的三维力课程』描述的力课程,每一类方法还包括相关的消融变体

下肢强化学习与上肢逆运动学控制器解耦。对于所有变体,下肢运动采用强化学习,上肢则由逆运动学根据末端执行器位姿提供目标关节角度

主要区别在于力课程的使用方式以及上肢关节跟踪策略:

- a)Upper-PD-w/o-Force-Curr.:一个基线方法,参考文献[8,9],使用PD控制进行上半身关节跟踪,但不进行力随机化

- b)Upper-PD:在(a)的基础上引入力课程,使下半身能够适应外部力;上半身仍采用PD控制

- c)Upper-PID:在(b)的基础上,为上半身控制器增加了积分项,以减少稳态跟踪误差

- d)Upper-PD-ID:在(a)的基础上,加入了一个可学习的力估计器[38],并在准静态假设下采用基于逆动力学的力矩补偿(详见附录A.3)

对于具有力估算器的Lower-RL-Upper-IK

- 作者联合训练了一个3D 力估计器,采用与[38] 类似的方法,以机器人的本体感知作为输入

如图7(a) 所示估计器预测末端执行器的力

,然后将其与全身本体感知信息拼接后输入下半身的RL 策略

同时,上半身关节力矩的力补偿计算为- 且作者在图7(b)中比较了估算力和施加力,显示二者高度一致。然而,即便力的估计非常准确,末端执行器接触点的变化也会改变有效雅可比矩阵

,从而使补偿项

不准确

因此,在部署过程中仍然需要一个力传感器来定位施力位置并计算正确的。此外,该补偿假设了准静态条件,当上半身关节运动时会引入额外的误差

以下两项属于整体全身的强化学习

- (e) Monolithic-WB-RL-w/o-Force-Curr.:在先前设计 [11,15] 的基础上,使用与 FALCON 相同的目标指令训练单一智能体,但在训练过程中不施加任何力

- (f) Monolithic-WB-RL-with-Force-Curr.:基于 (e),他们在训练课程中引入了力的随机化以实现对力的适应,同时保持其他训练设置不变

3.3.3 仿真结果

为了解答Q1(FALCON在上肢操作和下肢行走性能方面能否优于其他基线方法?)和Q2(为何FALCON在力自适应行走操作任务中相比整体单体全身强化学习(M-WB-RL)具有更高的训练效率?),作者在IsaacGym平台的UnitreeHumanoid G1上,对作者的方法与另外两种基线方法进行了定量对比

// 待更

3.3.4 真实世界定量跟踪结果

3.3.5 现实世界中的远程操作部署

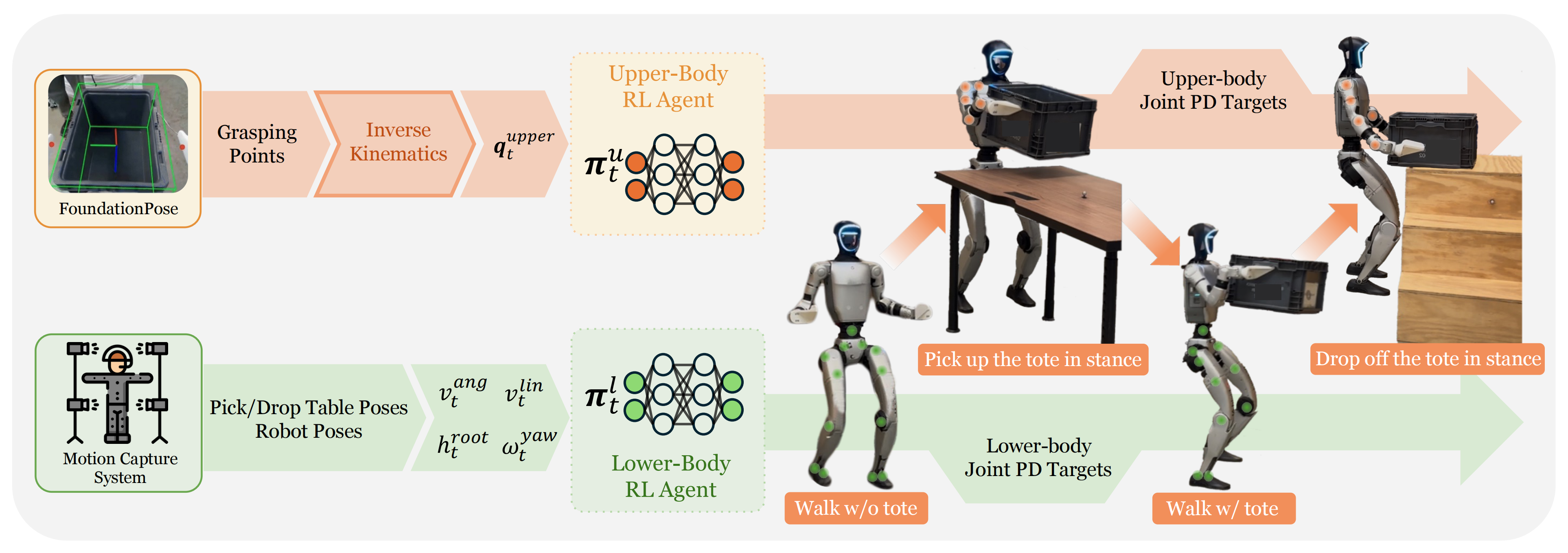

3.3.6 具备自主性的实际部署:搬箱子

作者还在 Unitree G1 上部署了 FALCON,用于自主托盘物流,这是一项具有代表性的仓库任务。如图 6 所示「相当于自主托盘物流:仿人机器人在无托盘时行走,拾取托盘,携带托盘行走,并放下托盘」

机器人需要从初始位置行走到取货站,举起一个未知重量的托盘,并将其运送到指定区域进行精确放置

进一步而言,自主流程的详细实现如原论文附录 A.5所述

作者开发了一个分层自主的周转箱物流流程,利用动作捕捉(MoCap)系统对机器人和桌子的位置信息进行定位。机器人由具有四个状态的状态机框架控制:

- 无箱行走

- 站立拾取周转箱

- 携带周转箱行走

- 站立放置周转箱

如图9 所示

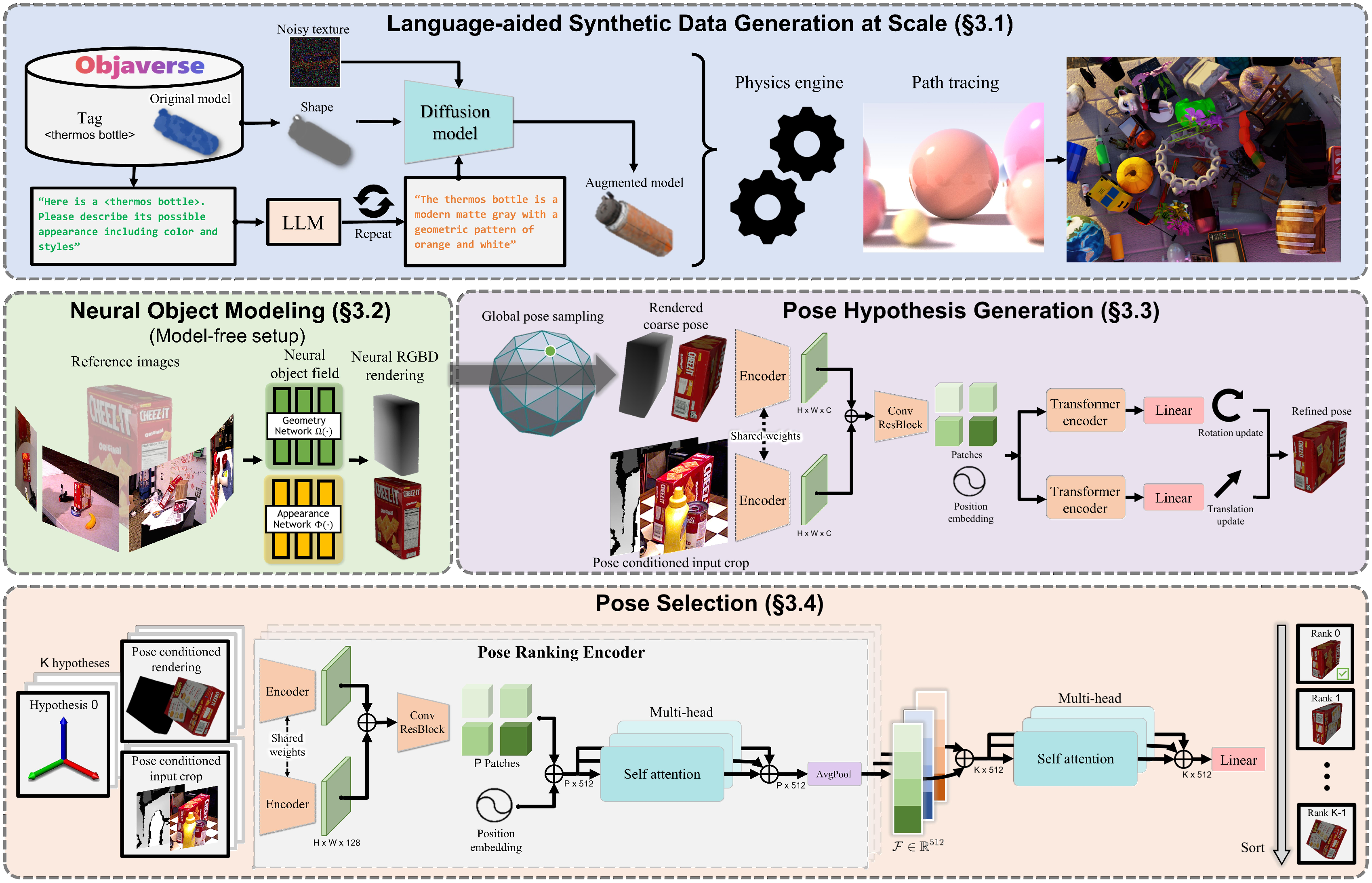

为了估计或获取托盘相对于摄像头的位姿,作者采用了FoundationPose

其对应的论文为:41-Foundationpose: Unified 6d pose estimation and tracking of novel objects

能够在基于模型和无模型的设置下,对新颖物体进行姿态估计和跟踪,输入为RGBD图像

这是一种先进的、用于精确且可靠的6自由度位姿估计算法

- 感知-位姿估计

为了搭建 FoundationPose 流水线 [41],作者首先通过原始 3D 扫描获取工业周转箱的高保真三维模型,随后在三维建模工具中进行手动后处理

生成的纹理和 .obj文件作为 FoundationPose 的输入,使其能够根据 G1 机器人图像流实现周转箱的6 自由度位姿估计「The resulting texture and .obj files serve as inputs to FoundationPose, enabling 6-DoF pose estimationof the tote from the G1 robot’s image stream」

此外,作者在周转箱表面沿纵向预定义抓取点「见下图图 10,G1托盘物流 (a) 托盘姿态估计的第一人称视角(抓取点以红色显示)。(b) 从左到右的动作序列——接近、抓取、提起」并利用相机与机器人之间已标定的外参,将这些抓取点转换到机器人基坐标系中

- 动作捕捉系统

动作捕捉系统为机器人底座、拾取台和放置台在全局参考坐标系中提供精确的六自由度(6-DoF)位姿估计——包括位置(x, y, z)和姿态(偏航、俯仰、滚转)——从而实现系统内一致的空间定位

当状态机切换到“(2) 站立姿态下拾取托盘”(见上图图9),由动捕反馈触发时,FoundationPose 会实时执行以估计托盘姿态。预定义的抓取点随后被传递给逆运动学(IK)求解器,该求解器将其表述为上半身操作的到达姿态问题『The predefined grasppoints are then passed to an inverse kinematics (IK) solver, formulated as a go-to-pose problem forthe upper-body manipulation』

最后,在使用FALCON训练的策略进行仿真到现实部署时

- 作者观察到人形机器人难以在长时间内维持高关节扭矩,通常会导致电机迅速过热——尤其是在手腕部位,如下图图11(a)所示

- 这显著限制了他们在默认关节位置下每只手臂搬运超过2千克负载的能力。相比之下,如图11(b)和(c)所示,在MuJoCo [47]中评估相同策略时,通过对关节扭矩进行裁剪以遵守关节限制,但未模拟热约束,能够成功搬运每个末端执行器超过3千克的负载,并且能准确跟踪沿x轴指令速度为−1m/s的线速度

这突显了仿真与现实中执行器耐久性之间的关键差距

总之,本文提出了FALCON,一种面向力自适应人形体运动操控的双智能体强化学习框架

- 该方法通过将上下半身的学习过程解耦,并通过共享本体感知反馈实现协调,FALCON在复杂任务中应对三维末端执行器力时展现出卓越的适应性

- 作者认为,他们的大量评估表明,FALCON在训练收敛速度、跟踪误差降低以及多种力场环境下的稳定性方面,均优于Lower-RL-Upper-IK和Monolithic-Whole-body-RL两种基线方法

- 此外,FALCON展现出很强的平台泛化能力,实现了从仿真到实体人形机器人策略的成功迁移,包括搬运负载、拉车和开门等任务。这些结果凸显了FALCON在实际力交互场景中部署的潜力

而尽管FALCON表现优异,但仍存在两个主要局限性

- 首先,它仅关注施加在末端执行器上的力干扰,未考虑作用于其他身体部位的接触力,也未支持多接触交互。这限制了其在涉及全身支撑的场景中的应用,例如倚靠、支撑或协作搬运

- 其次,当前的力课程仅考虑外部力,忽略了外部力矩。因此,FALCON在涉及旋转干扰的任务中可能表现不佳,如操作把手或带有偏心负载的工具。通过引入多接触推理和力矩自适应策略来解决这些局限性,仍然是未来研究的重要方向

// 待更

1461

1461

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?