目录

![]()

2024年5月28日 开源的 ChatTTS 截至 6月5日 20.2k 星

ChatTTS:开源领域最强的文本到语音转换(TTS)模型!它允许用户将文本转换为语音。该模型主要面向学术研究和教育目的,不适用于商业或法律用途。它使用深度学习技术,能够生成自然流畅的语音输出,适合研究和开发语音合成技术的人员使用。

带有情绪控制语音堪比真人,可以方便制作有声小说,如果应用在线对话中很难分辨是否是真人。

在线体验地址:https://huggingface.co/2Noise/ChatTTS

1. 本地部署准备

国内镜像库地址:https://gitee.com/vscene/ChatTTS

1.1 下载 ChatTTS 代码

将代码库拷贝到本地,注意要在英文目录下

> git clone https://gitee.com/vscene/ChatTTS

> cd ChatTTS

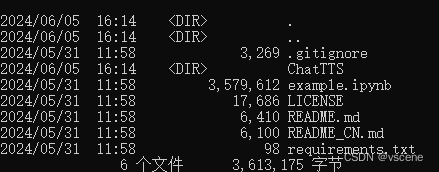

> dir

1.2 通过 modelscope 下载ChatTTS模型

运行 python 并输入如下代码, 或者创建 download.py 并输入如下代码( python download.py进行下载)

from modelscope import snapshot_download

model_dir = snapshot_download('pzc163/chatTTS')

如果报错:ModuleNotFoundError: No module named 'modelscope'

说明没有安装 modelscope .

通过conda 创建 ChatTTS 环境 ,如果没有安装conda 请参考

手撸私有AI大模型——开发环境搭建miniconda_开发ai私有模型-CSDN博客

# 创建 ChatTTS python 运行环境,python 默认安装 3.11.5

> conda create -n ChatTTS

#

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

747

747

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?