粗糙翻译,如有兴趣请看原文,链接:https://arxiv.org/abs/2310.07637

摘要

信息技术(IT)运营(Ops),特别是用于IT运营的人工智能(AlOps),是保持现有信息系统有序和稳定运行的保证。根据Gartner的预测,将人工智能技术用于自动化IT运营已成为一种新趋势。大型语言模型(LLM)在NLP相关任务中表现出非凡的能力,在AlOps领域显示出巨大的潜力,例如在故障的根本原因分析、操作和维护脚本的生成以及警报信息的总结等方面。尽管如此,当前LLM在运营任务中的表现尚未确定。需要一个全面的基准来优化为Ops(OpsLLM)量身定制的LLM。在本文中,我们介绍了OpsEval,这是一个为LLM设计的全面任务导向的运营基准。OpsEval首次评估了LLM在不同能力水平的各种关键场景中的熟练程度。该基准包括7184个多选择题和1736个英语和中文问答(QA)格式。通过对当前领先的大型语言模型进行全面的绩效评估,我们展示了各种LLM技术如何影响Ops的性能,包括自一致性、思想链和少数镜头的上下文学习,并讨论了与各种主题相关的发现,包括模型量化、QA评估和幻觉问题。为了确保我们评估的可信度,我们邀请了数十名领域专家手动审查我们的问题。与此同时,我们开源了20%的测试QA,以协助当前研究人员对其OpsLLM模型进行初步评估。其余80%的数据未披露,用于消除测试集泄漏问题。此外,我们还构建了一个在线排行榜,该排行榜实时更新,并将继续更新,确保任何新兴的LLM都将得到及时评估。我们的数据集和排行榜都已公开。

Data page is available at https://github.com/NetManAIOps/OpsEval-Datasets.

Leaderboard is available at https://opseval.cstcloud.cn/content/leaderboard.

1. 介绍

IT运营(Ops)在维护云计算、5G网络和金融信息系统等信息系统的高效稳定运行方面发挥着至关重要的作用。随着互联网的持续快速扩张,系统的规模和复杂性正在升级,导致人工智能辅助运维作为一种新趋势出现。这项技术被Gartner[12]称为“AlOps”,利用人工智能来解决(但不限于)异常检测、故障分析、生成警报摘要、性能优化和容量规划等任务。

近年来,大型语言模型(LLM)取得了重大进展。最新型号,如GP T-4V |20]、GPT-4 [19]、LLaMA-2 [8]和ChatGLM3 [3],已经展示了卓越的概括和任务规划能力。因此,这些模型为增强下游特定领域的应用程序提供了许多机会。凭借其先进的总结、报告分析和进行API调用的能力,LLM非常适合在答案生成、信息总结和报告分析等任务上进行操作。此后,我们将用于Ops的LLM称为OpsLLM,无论它们是否专门为Ops进行了优化。

虽然有评估通用NLP相关能力的基准,如C-EVAL[11]和AGIEval[34],但也有特定领域的基准,如金融部门的FinEval[33]和医疗领域的CMB[27]。然而,没有可以评估LLM或OpsLLM在Ops任务中的有效性的基准。迫切需要一个运维基准,以告知我们当前运维任务的LLM绩效。另一方面,一个好的基准可以大大有助于为Ops域量身定制的OpsLLM的优化过程。

然而,由于运维任务的特殊性,构建运营基准提出了以下挑战:

- Ops数据对公司来说主要是敏感和专有的,公开数据很少,因此任何公司都难独立提供足够的评估数据,以确保对测试结果的信心。

- Ops字段中有许多不同的子域(如5G通信、云计算、日志分析和网络管理)和子任务(如网络脚本生成和术语解释)。不同的领域和任务对模型有不同的准确性要求。例如,网络脚本生成需要高精度,而运维术语解释可能不如网络脚本生成任务准确。自动注释具有不同精度要求的评估问题构成了重大挑战。

- 由于现有的LLM没有针对Ops域进行明确训练,因此评估结果对即时工程更敏感。为稳健和准确的评估设计适当的提示具有挑战性。

- 像BLEU这样的现有指标只考虑模型输出与自然语言中地面真理答案的相似性,这并不总是表明Ops任务中的良好响应。Ops场景中的一些术语和表达方式具有无法提前总结的特定含义。设计一种自动评估方法,从准确的语义水平评估问答的准确性,具有挑战性。

为了解决这些问题,我们建议OpsEval,这是LLM的综合IT运营基准。首先,为了应对基准数据大多是私人的,不可公开共享的挑战,分布在各种公司,我们围绕AlOps建立了一个社区,目前有10家公司参与,允许社区中的每个实体持续贡献少量数据。然后,我们将数据汇总在同一域下,以确保评估的稳健性。此外,根据公开可用的网络管理书籍,我们生成了多项选择和QA问题作为补充。为了应对多个Ops场景和任务中不同准确性要求的挑战,我们采用了基于模型的预集群和手动审查来注释八项任务和三种独立评估能力。为了应对基准结果对提示的敏感性,我们在自我一致性、思想链和少数语境学习下系统地测试模型性能。我们评估中使用的提示也在论文中披露。最后,为了解决BLEU等现有指标在评估问题回答性能时的不准确性,我们设计了一个三维评估指标,从流畅性、准确性和证据的角度自动评估问题。实验结果表明,我们设计的指标与运营专家的注释非常一致。

我们论文的贡献如下:

- 我们提出OpsEval,包括8920个问题,并设计半自动注释方法,在八个领域进行独立和稳健的评估,为Ops领域的模型选择提供指导。

- 基于OpsEval,我们系统地测试了17个主流LLM,结果表明,当前模型在某些Ops任务上表现不理想,这表明现实世界应用程序存在重大差距。

- 我们设计了一个基于GPT-4[19]的多维评估指标,该指标与专家注释的一致性达到92%,取代了BLUE进行自动特定领域的QA评估。

- 我们发布了一个在线排行榜,更新了新兴模型在Ops任务上的性能。目前,该平台上的评估数据集规模继续增长。

- 为了帮助研究人员初步评估他们的OpsLLM,我们从我们的基准中仔细选择并发布了20%的QAs,其余80%的未披露数据可以防止因数据泄露而进行不公平的评估[30]。我们还在我们的网站上提供了一个界面,研究人员可以上传他们的模型,以便对照完整数据集进行评估。

2. 相关工作

随着 LLM 的快速发展,其复杂多样的能力越来越得到认可,而传统的NLP指标则未能准确评估这些能力。因此,提出专门为 LLM 量身定制的评估基准的趋势越来越大。这些可以分为两类:一般能力基准和特定领域的基准。

一般能力基准评估LLM在各种任务中的一般能力。这些任务评估 LLM 的逻辑推理能力、一般知识、常识和其他类似能力,而不是局限于特定领域。HELM[14]在42个独特的场景中采用了七个不同的指标,对LLM在多个维度的能力进行了全面评估。BIG-bench 24]包括204项任务,涵盖广泛的主题,特别关注当前LLM无法完成的任务。C-Eval[11]是第一个全面的中文评估套件,旨在严格评估中国LLM的高级知识和推理能力。AGIEval [34]从中国高考(CCEE)和SAT等考试中策划真实问题,构建了一个从根本上以人为中心的评估数据集。与此同时,MMCU[31]利用CCEE和各种专业考试的问题来建立强大的理解基准。CG-Eval [32]专注于评估LLM的生成能力,采用包括术语定义、短答案和计算问题的测试框架。

特定领域的基准评估LLM处理特定领域任务的能力。这些基准要求LLM拥有特定领域的专业知识,并以与该领域的认知模式一致的方式做出回应。尽管LLM在专业领域进展迅速,但这些特定领域的评估指标受到的关注较少。FinEval [33]是一个基准,明确用于衡量中国LLM的先进金融知识。MultiMedA [23]是一个广泛的医学问答数据集,其问题来自专业医学考试、研究和咨询记录。Huatuo-26M [13]包括实际的医疗咨询记录和医疗知识问答内容。CMB [27]包括多选择问题(CMB-Exam)和基于真实案例研究(CMB-Clin)的复杂临床问题,通过专家共识确定正确答案。NetOps[17]专注于网络领域的评估,这与Ops领域相关。NetOps包括英语和中文的多项选择问题,以及一些填入和问答问题。然而,他们只专注于有线网络运营。相比之下,我们的研究涵盖了各种Ops子域。此外,我们划定了任务和能力的分类,从而提供了一个更细致入微、更全面的评估框架。由于现实世界中的Ops问题通常涉及全栈IT技术,我们认为OpsEval更广泛的范围将提供比NetOps更多的好处。

3. OPSEVAL基准

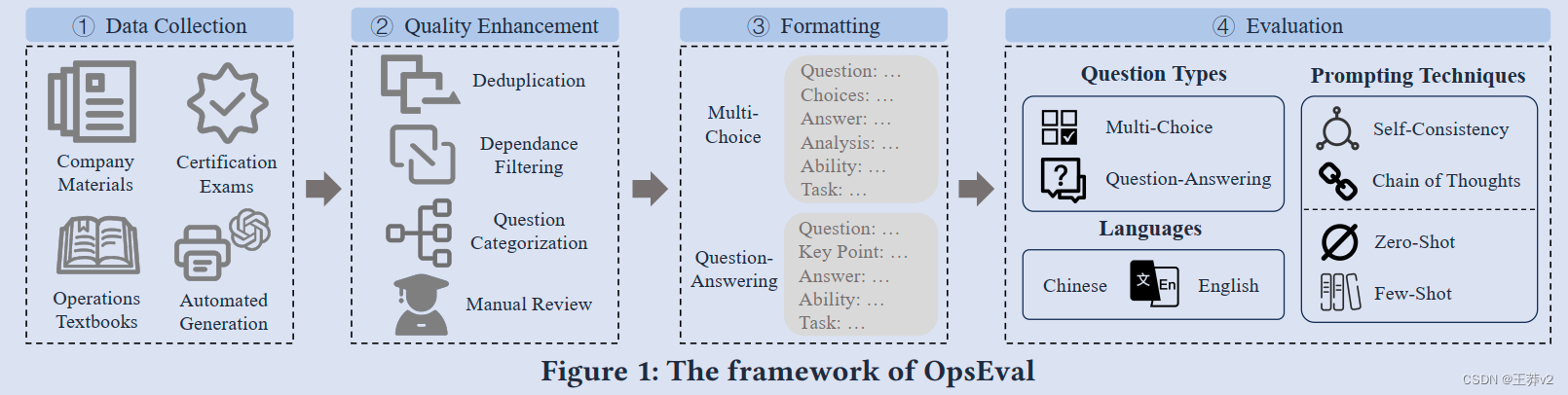

图1显示了OpsEval从施工到评估的总体框架。我们首先从多个来源收集数据,然后通过问题策划过程增强和保证所收集问题的质量。在第三步中,我们标准化了经过人工审查的问题的格式。最后,我们使用各种提示工程技术评估了数据集上领先的大型语言模型。以下小节提供了每个步骤的详细说明。

3.1 Data Collection

我们的基准问题是从各种来源收集的;我们将它们总结为四类:公司材料、认证考试、运营教科书和自动生成。每个来源都受到全球高度重视,并由我们的合作者审查。

公司材料包括Ops门票和错误日志等生产环境材料,以及Ops员工培训的内部文档和测试。我们与10家公司建立了合作关系,并从他们那里收到了材料。与我们合作的公司和企业涵盖各个部门,包括互联网、电信、金融和运营服务/工具提供商。每家公司都有指定专家与我们合作选择问题。有关公司和专家的信息可以在附录中找到。

认证考试包括成为运营工作人员所需的知识评估,自然以选择题和简短回答问题的形式出现。我们从公共图书网站获得了这些认证考试的相关学习指南,并从中提取了样本问题,作为Ops问题的来源之一。

运维教科书。我们首先为Ops字段构建了一个种子关键字列表,并搜索了相关书籍。教科书包含相对完整的知识内容,可以提供拥有问题创建材料的专家,以及一些书籍本身在章节末尾也包含一定数量的练习。

除了上述来源外,为了增强我们测试集的多样性和深度,我们还通过提取教科书内容并将其提供给GPT4,从涵盖一系列Ops领域的权威书籍中获取问答问题。在第6节中,我们讨论了自动化生成的方法和挑战,希望在Ops基准创建方面提供一些经验。

到数据收集过程结束时,我们总共收集了21250个问题,这些问题将进一步选择和策划。

3.2 Quality Enhancement

我们在以下阶段系统地处理了原始测试集:

重复数据删除:识别并删除任何重复或高度相似的问题,以避免测试集中出现冗余。我们计算问题词干的余弦相似性,以检测重复问题,并识别相似性高于特定阈值(th=0.7)的问题对。这些对稍后会手动审查,以确认它们是否是重复的。

依赖性过滤:由于OpsEval主要关注大型语言模型理解Ops知识的能力,因此我们过滤掉了依赖外部图像或文档内容的问题,以确保问题内容本身的完整性。

问题分类:在Ops的复杂景观中,认识到任务的多维性至关重要。我们设计了一个分类,涵盖了专业人士在实际应用中面临的许多任务。分类过程包括两个步骤:自动筛选和人工审查。

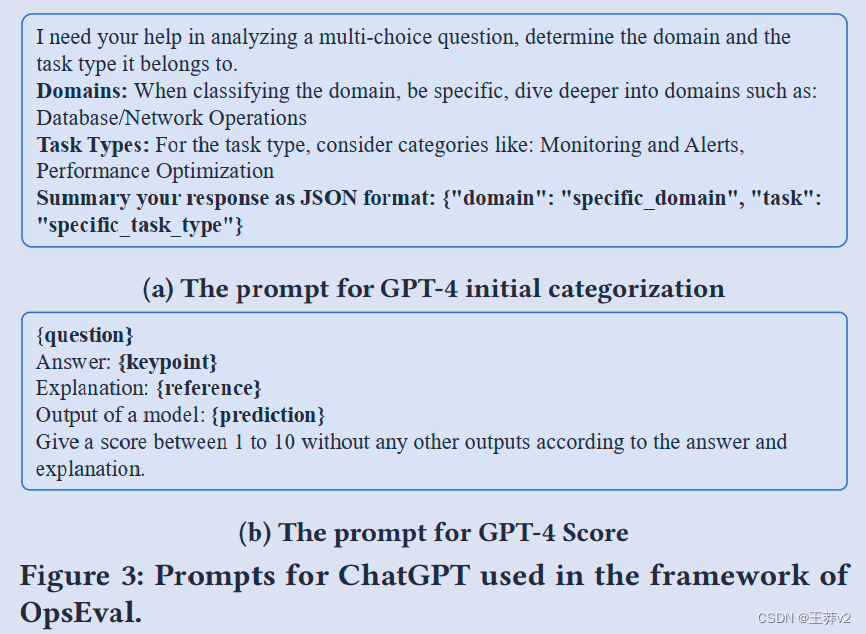

我们首先使用GPT-4进行主题建模,以获得关于数据集的粗略见解,利用其能力来确定每个问题与Ops的相关性。主题建模产生了20多个任务,但分布不平衡。我们用来让GPT-4进行分类的提示如图3a所示。

其次,在人工审查过程中(我们将在本节后面介绍这一步骤),我们让数十名专家参与了人工筛选。通过合并类似的任务并标记不同的能力水平,我们分别将问题分为八项任务和三个能力水平。

- 任务分类:我们八个不同的运营任务是根据行业相关性、任务频率和运营中每个领域的重要性制定的。八项任务的详细信息可以在附录A.2中找到。

- 能力分类:根据回答它们所需的能力,问题分为三类:知识回忆、分析思维和实际应用,反映了专业人士在现实世界中可能遇到的挑战。附录A.3描述了这三种能力。

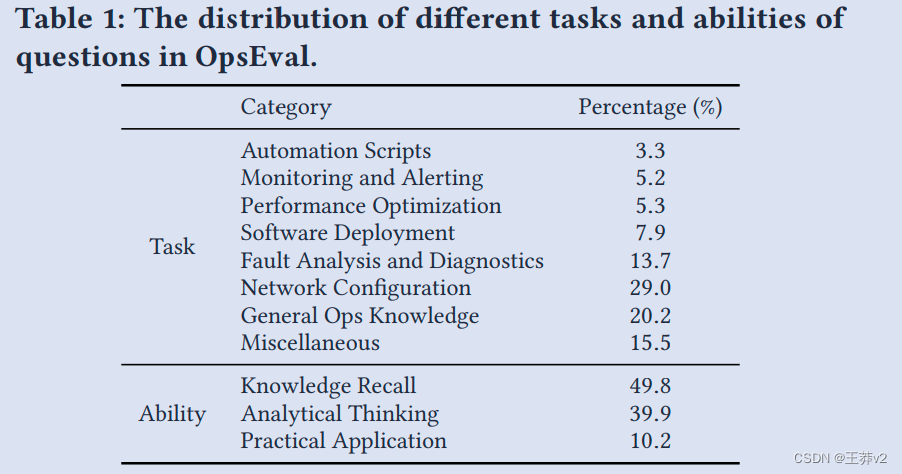

表1描述了问题在这八项任务和三个能力水平上的分布情况。

手动审查:在手动审查步骤中,我们要求行业运营专家检查前三个自动步骤的结果,包括确认重复和无效问题以及检查GPT-4的分类结果。专家们还被要求放弃与运营领域无关的问题。我们按n倍拆分数据集,并确保每个倍至少有两名专家需要审查。通过让专家达成共识,我们确保了自动处理后数据集的可靠性和权威性。

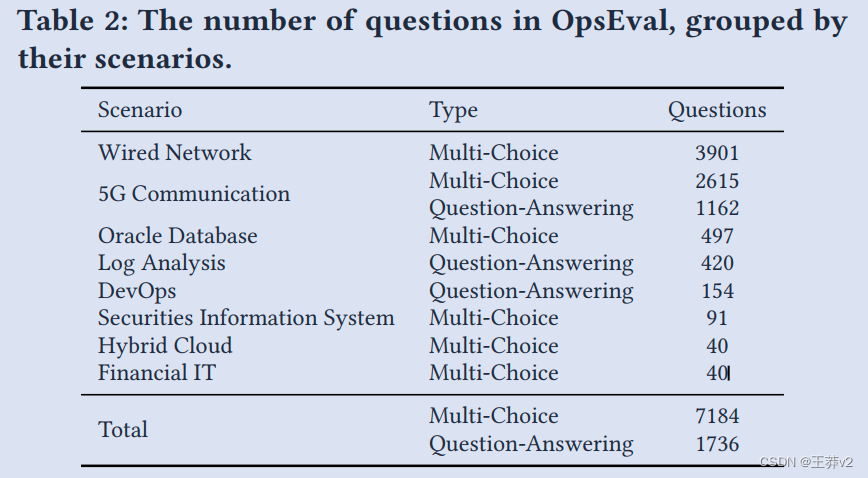

如表2所示,这个质量提升过程产生了一套由大约7000个多选择题和2000个问答问题组成的精炼测试。

3.3 Question Formatting

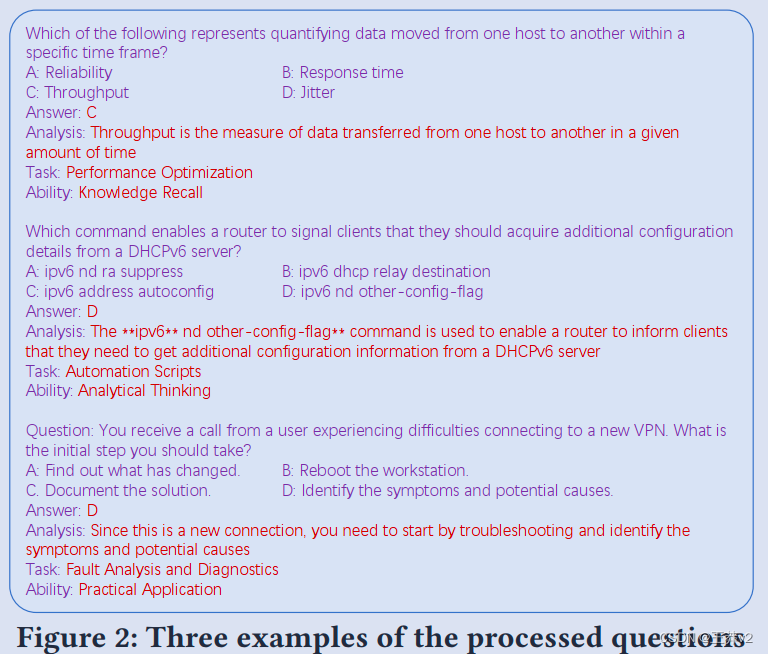

在收集的问题提高质量后,我们为即将到来的评估执行问题格式。每个问题的结构都包括上下文、答案、任务和能力。图2显示了格式化问题的三个示例。这种结构化方法有助于轻松评估和分析。

3.4 Evaluation Settings

在评估Ops域内的LLM时,我们将评估问题归类为多项选择和问答。

多项选择问题提供了一种结构化的方法,并给出了明确的答案。这些问题直截了当,为评估提供了明确的指标。然而,鉴于高级模型的复杂性,它们可能会受到所提供的选项的影响,导致它们的响应更多地由模式识别驱动,而不是对内容的正确理解。

我们使用准确性作为指标。除了所选选项外,LLM的输出可能包含其他字符串,即使我们发出明确请求并在提示符中使用几张照片。因此,我们使用基于正则表达式的选择提取函数来提取LLM的预测答案。然后,我们根据提取的答案和地真相标签计算准确性。

回答问题没有预定义的选项。它要求该模型更多地依赖其理解和知识库,为其认知能力提供更清晰的洞察力。这些问题可以更好地评估LLM产生连贯和上下文相关回复的能力。

我们使用两个指标来回答问题:一个基于单词重叠,另一个基于语义相似性。对于第一种类型,我们使用ROUGE [15]和BLEU [21],广泛用于NLP任务,特别是在翻译任务中。对于第二种类型,我们使用GPT-4和专家来获得LLM的输出分数,称为GPT4-Score和专家评估,在OpsEval中明确设计。我们在附录A.5中提供了对这些指标的更详细的描述。

我们根据与Ops需求高度相关的三个标准,设计专家评估,对LLM的输出进行手动评分。考虑的三个标准如下:

- 流畅。评估模型输出的语言流利度以及是否符合回答问题的回答要求。

- 准确性。评估模型输出的精度和正确性,包括它是否充分涵盖了地面真相答案的关键点。

- 证据。检查模型的输出是否包含足够的论证和证据支持,以确保答案的可信度和可靠性

对于LLM问题的每个输出,我们要求专家对每个标准进行0到3的评分。在评分过程中,每次迭代都会给出原始问题、详细答案及其要点以及匿名模型的输出。由于避免对特定模型的偏见很重要,因此没有提供有关模型的信息。

公平性考虑 我们目前正在向公众提供20%的数据,用于Ops社区的贡献和研究目的,但为了评估的公平性,OpsEval数据集的完整版本是保密的,不会披露。要评估新模型,用户可以在启动基于该模型的容器时提交带有初始化脚本的Docker映像。我们将自动运行评估,并在OpsEval网站上获取结果。用户可以选择在OpsEval的排行榜上披露他们的结果,也可以不根据自己的喜好披露他们的结果。

4 实验设计

在本节中,我们将展示OpsEval的实验设计。我们在OpsEval上评估各种LLM,旨在了解不同LLM在解决不同问题类型(多选择和问答问题)和任务方面的多重能力。我们还评估具有不同量化参数的LLM。

4.1 Models

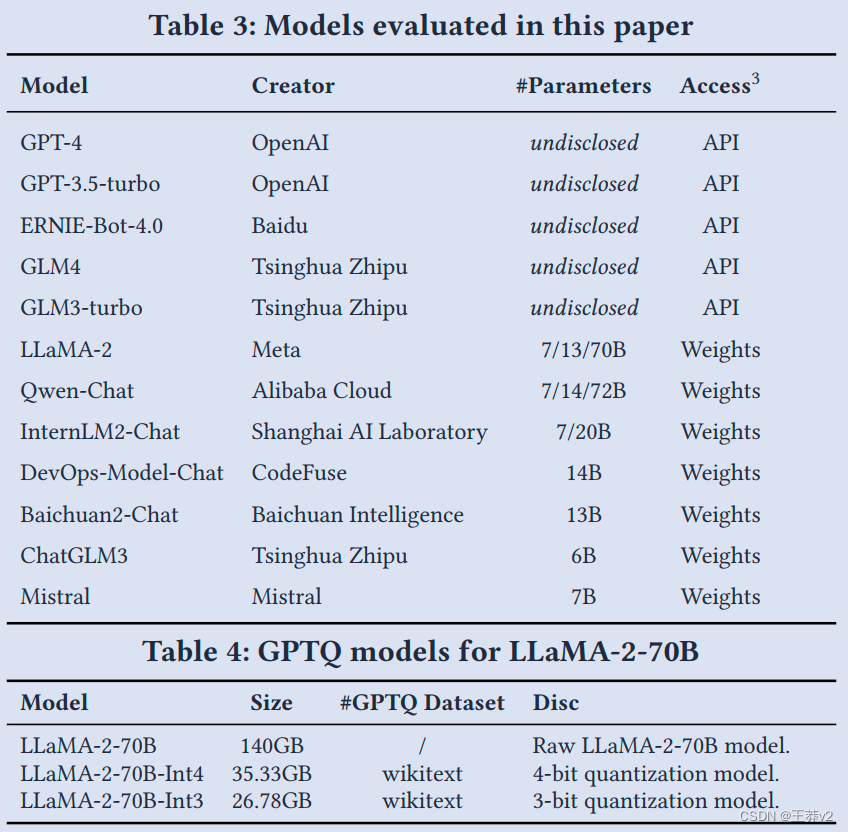

如表3所示,我们评估了涵盖不同组织不同权重的流行LLM。表3中所有LLM的详细信息见附录B.1。

此外,我们评估具有多个量化参数的LLaMA-2-70B,以概述不同量化参数的影响。具体来说,我们使用具有3位和4位量化参数的GPTQ(9)模型。*LLaMA-2-70B的大小是根据70B参数计算的。我们实验中评估的两个GPT模型在维基文本[16]上进行了校准,这是一种语言建模从维基百科上已验证的优质和特色文章集中提取的数据集。GPTQ是一种训练后量化(PTQ)方法,通过校准数据集使模型更小。这是一种基于近似、高度准确和高效的二阶信息的一次性权重量化方法。GPT模型的详细信息见表4。

4.2 Prompting Techniques

为了全面了解OpsEval上流行LLM的性能,我们使用各种设置来执行评估。我们在零镜头和几镜头设置中评估LLM(在我们的实现中3镜头)。对于每个设置,我们在提示工程的四个子设置中评估LLM,即天真的答案(天真)、自我一致性(SC[28])、思想链(CoT[29])、自我一致性与思想链(CoT+SC)。我们为英语和中文设计提示。

天真。天真的设置是期望LLM在没有任何其他解释的情况下生成答案。由于我们有每个问题的任务类型,我们将任务集成到提示中。

SC。自我一致性是在LLM的几个查询中选择最一致的答案。尽管它旨在“取代思想链提示中使用的天真贪婪的解码”,但它可以生成天真的答案,因为它可能会用相同的提示生成不同的答案。我们将SC中的查询数量设置为5。

CoT。CoT设置旨在使LLM能够通过中间推理步骤获得复杂的推理能力。我们在零和少数评估中为CoT设置构建了特定的提示。提示施工的详细信息见附录B.2。

CoT+SC。我们结合CoT和SC来提高CoT提示的性能。通过SC,我们选择一致的推理路径,并回答几个相同的查询。与SC设置一样,我们将Col+SC中的查询数量设置为5。

至于问答问题,我们结合了每个问题的任务类型和能力,以及作为提示的问题LLMs。附录A.4中的图9显示了构建提示符的示例。

5 EVALUATION

5.1 Benchmark Leakage Test

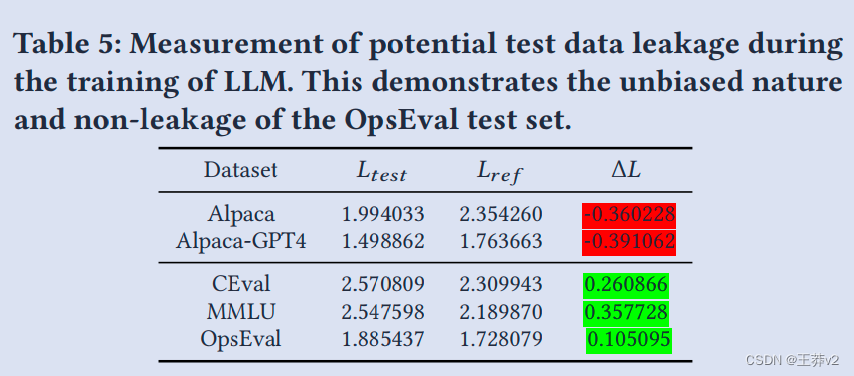

作为适合LLM的基准,有必要确保测试集没有包含在模型的预训练过程中。否则,潜在的偏见可能会损害基准的公平性。我们调整了Skywork 30]的方法,对OpsEval的数据集进行泄漏测试。我们从几个基础模型的不同数据集评估样本(样本是问答的串联)的LLM损失,并计算平均损失。对于每个数据集,我们比较测试拆分(Ltest)上的LM损失和GPT-4生成的特别策划的参考集(Lref),该参考集旨在模仿测试数据集。我们定义了一个关键指标:AL = Ltest - Lref,作为LLM训练期间潜在测试数据泄漏的指标,即较低的值表明可能存在泄漏。请注意,虽然Skywork[30]只要求GPT-4生成与GSM8K类似的问题,但我们要求GPT-4重写问题,同时保留其原始含义和准确性。通过保留原始含义,如果测试集的AL是较低的值,则表明LLM的较低Ltest源于测试集中对令牌的过度分布,而不是将问题背后的知识内化,从而表明测试集存在泄漏。

表5显示了泄漏测量的结果。除了两个标准评估基准(CEval[11]和MMLU[10])外,我们还对羊驼数据集[25]和羊驼-GPT4数据集[22]进行了相同的实验,该数据集可能用于大型模型的预训练,以其AL为参考。可能参与培训的语料库显示AL要小得多,而OpsEval数据集的损失仍然处于相对较小的正值。这表明了OpsEval测试集的无偏见性和无泄漏性。我们在泄漏测试中使用的模型列在附录B.1中。

5.2 Overall Performance

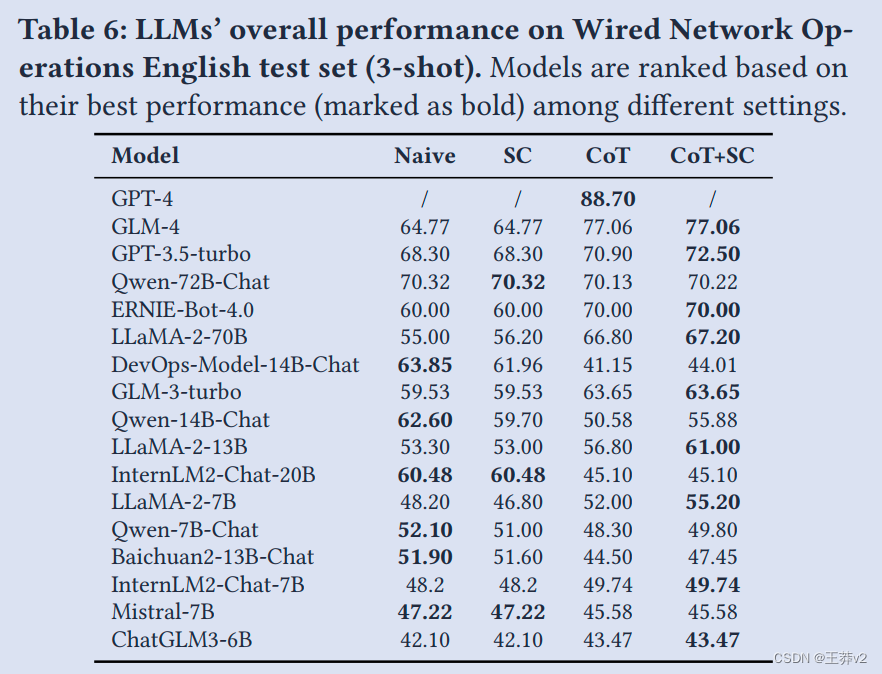

有线网络操作测试集上具有四个设置的几针评估结果如表6所示。附录B.3中显示的其他场景和设置的结果。5 从整体绩效结果中,我们可以得出一些发现。

在英语和中文问题上,GPT-4的表现一直优于所有其他型号,超过了所有其他LLM最佳表现。具有较大参数大小的LLM,如Qwen-72B-Chat、ERNIE-Bot-4.0和LLaMA-2-70B,在使用自一致性和思想链(CoT)提示方法时,接近ChatGPT的性能。较小的模型,如DevOps-Model-14B-Chat和Qwen-14B-Chat,在多项选择问题中表现出竞争性能,接近具有70B参数的模型的能力,这要归功于其微调过程和培训数据的质量。

此外,四个提示设置的有效性因不同的LLM而异。我们在前面第4节中提到的四个设置下,针对英语和中文测试集检查LLM的零镜头和几镜头性能。从评估结果中,我们可以总结以下观察结果:

(1)对于大多数模型,性能从Naive到SC、CoT和SC+CoT的设置有所提高。值得注意的是,几发性能优于零发性能。

(2)在这些设置中,Col提示对LLM的回答能力有了最显著的提高。SC提示导致相对较小的改进。LLM的回答在重复的问题上是一致的,与可靠性和一致性至关重要的运营任务的预期结果保持一致。

(3)与没有中文微调的LLM相比,专门为中文微调的LLM在英语和中文测试集中表现出更好的性能。我们在附录中讨论了对这些观察结果的进一步见解。B.5.

(4)在少数情况下,更先进的评估方法出人意料地导致更差的结果。对此的详细分析见附录B.6.1。

5.3 Performance on Different Tasks and Abilities

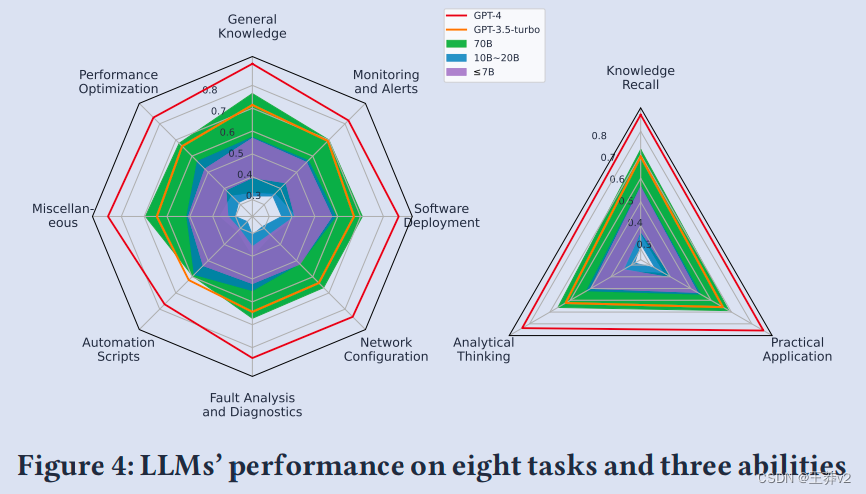

为了调查LLM在每个Ops任务中的表现,以及它们在多大程度上拥有知识回忆、分析思维和实际应用的能力,我们总结了不同参数大小的结果,我们根据Sec3.2中提到的任务和能力分类对LLM的表现进行分组,并将它们绘制在图4的两张雷达图上。

就我们测试的八项任务而言,LLM通常在一般知识任务中具有更高的准确性,而其性能自动化脚本和网络配置等高度专业化任务的下降和变化很大,反映了专业语料库和领域知识对LLM性能的影响。

在这三种能力中,LLM 在实际应用方面表现最好,其次是知识回忆。据预见,LLM在分析思维问题方面表现不佳,因为从LLM的现有事实中准确推断结论仍然是一个具有挑战性的研究课题。LLM在实际应用方面表现最好,因为我们测试的LLM是在涉及最佳操作实践的语料库上进行的,使LLM熟悉许多现实世界任务的解决方案。

通过按参数大小对LLM进行分组,我们发现,尽管与参数不超过7B的LLM相比,具有10B-20B参数的LLM在最佳情况下具有更高的准确性,但不同的10B-20B LLM的性能差异很大,有时甚至低于7B。另一方面,参数不超过7B的LLM在组内具有更稳定的性能范围。

5.4 Performance on Question-Answering

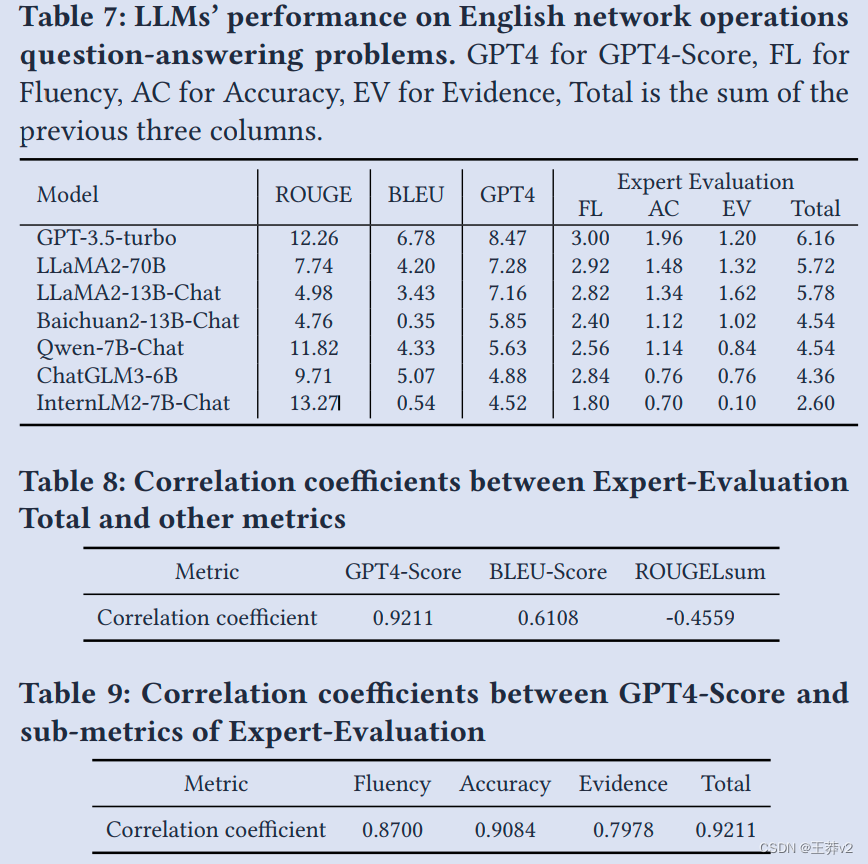

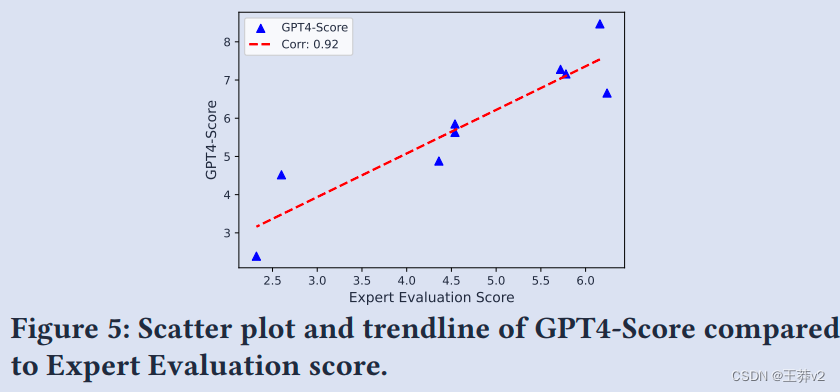

表7显示了跨越四个指标的200个问题回答英语问题的评估结果:ROUGE、BLEU、GPT4-Score和专家评估,按GPTA-Score结果排序。我们已经对GPT-4进行了问答测试,以便在使用它进行评分之前验证其能力。由于GPT-4目前是大型型号中能力最强的,其在问答问题方面的性能超过了其他型号。然而,为了避免偏见和误解,我们没有把它包括在表格中。

基于ROUGE和BLEU分数的排名与GPT4-Score和专家评估不一致,如表8所示。表现不佳的LLM可能会生成关键字,从而导致更高的ROUGE和BLEU分数。相比之下,与标准答案相比,由于措辞差异,性能良好的LLM可能会获得较低的ROUGE/BLEU分数。

关于GPT4-Score,排名与基于专家评估的排名非常相似。在表9中,我们计算了GPT4-Score和专家评估的不同子指标之间的相关系数,以获得更多见解。在这三个指标中,GPT4-Score的排名与准确性指标最接近,这表明GPT凭借其庞大的知识库在事实性方面最可靠。正如GPT4-Score和Fluency之间的高正相关性所表明的那样,生成内容的格式和长度也严重影响GPT-Score。另一方面,关于证据指标的排名存在更多差异,这表明在答案模棱两可的情况下,GPT-Score需要考虑论点和证据的作用。

在专家评估中,证据是一个重要的标准,具有更复杂论点的法学硕士在总分数上可以优于GPT-3.5-turbo,即使其准确性分数远低于后者。

5.5 Performance on Different Quantization parameters

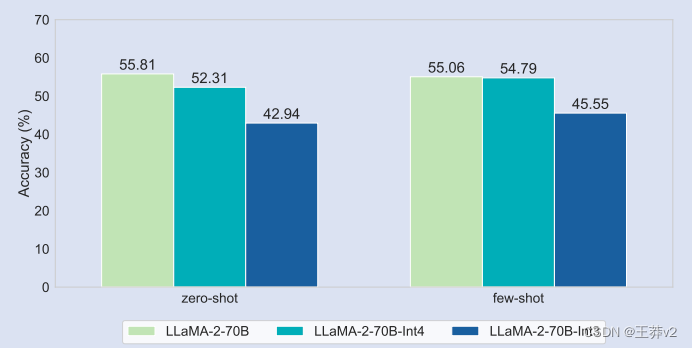

图6显示了LLaMA-2-70B在英语多项选择问题上不同量化参数的准确性。我们用朴素的设置进行几针和零针评估。在推理过程中使用量化会导致性能下降。

LLaMA2-70B-Int4可以在没有量化的情况下实现接近LLaMA-2- 70B的精度。具体来说,在英语多项选择问题上,与LLaMA-2-70B相比,具有4位量化参数的GPTQ模型的准确性在零射击评估中低3.50%,在少数射击评估中低0.27%。至于中国问题,与LLaMA-2-70B相比,LLaMA2-70B-Int4的准确性在零镜头评估中低3.67%,在几镜头评估中低5.18%。

然而,如图6所示,LLaMA2-70B-Int3的性能下降不容忽视。平均而言,与LLaMA-2-70B-Int3相比,LLaMA2-70B-Int3的准确性下降了12.46%,与LLaMA2-70B-Int4相比下降了9.30%。原因可能是全尺寸模型的信息在3位量化中丢失得太多。

6 DISCUSSION

6.1 Implications of the evaluation results

我们在这里总结了我们从评估中的关键观察结果:

-

如果对模型进行调整以适应这些技术, Few-shot和CoT可以显著提高性能,而SC可能对高度一致的LLM几乎没有影响。

-

LLM在一般知识方面表现最好,而推断专业结论仍然具有挑战性。

-

GPT4-Score适合作为大规模定性评估中的自动指标。

-

超过3位的量化可以是一种有效的方法降低计算和内存成本,同时保持性能。

总体而言,LLM在OpsEval基准上的评估结果通常低于MMLU[10]和CEval[11]等一般领域的评估结果。这种比较凸显了为Ops字段明确微调OpsLLM的必要性。

我们使用各种提示工程技术对模型的测试表明,提示工程会显著影响从模型中获取操作知识的有效性。这表明,需要进一步研究即时工程,以提高大型模型在这个特定垂直领域的性能。

6.2 Automated QA generation for question-answering questions

在数据收集过程中,我们考虑了自动生成问答。首先,我们对问题答案对进行了采样,并手动评估了它们的准确性和领域相关性。后来,我们使用典型的手动评估示例进行几次学习,使GPT能够根据我们的评估标准自动评估问答对。

直接生成的问题答案往往是简单的判断或概念问题,而不是更好地展示模型能力和知识密度的推理问题。我们的目标是确保问题的主题仍然与种子问题相关,但其具体内容与原始问题不同。通过维护Ops领域的总体框架,我们可以扩大问题的数量和类型,从而能够更全面地评估模型能力。此外,我们可以在数据生成过程中吸收外部知识,不断提高我们评估新内容的能力。

6.3 Examination Methodology of Hallucination Issues in LLM within OpsEval

认识到LLM缓解幻觉问题的必要性,我们探索了相应的评估方法。

我们的方法包括多项选择和问答评估。多项选择问题根据其知识和多样化的运营能力来评估LLM。然而,为了有效地发现幻觉,我们依靠问答评估。这涉及专家审查,根据三个主要标准对产出进行审查:流利度、准确性和证据。特别是证据标准,在强调幻觉问题方面至关重要。它强调了法学硕士提供证据或推理过程以支持其产出的重要性。

幻觉问题和循证评估的交集是我们研究的焦点。通过强调证据,我们旨在缓解幻觉问题,确保LLM的产出不仅合理,而且可验证。我们计划完善我们的多选择问题设计。这将使我们能够更有效地自动评估模型对幻觉的鲁棒性。预计这一调整将进一步提高我们对LLM在处理幻觉方面的能力和局限性的理解,从而有助于在运营领域开发更可靠和值得信赖的LLM。

7 CONCLUSION

在本文中,我们介绍了OpsEval,这是一个为LLM设计的综合Ops基准套件。OpsEval方法史无前例,它评估了LLM在各种Ops场景中的熟练程度,同时考虑了包括知识回忆、分析思维和实际应用的不同能力水平。这个全面的基准包括7200个多选择和问答格式的问题,包括英语和中文。经过行业专家的仔细审查,我们在Github上向公众提供了OpsEval中的数据集,并在OpsEval官方网站上发布了评估排行榜。

在定量和定性结果的支持下,我们阐明了各种LLM技术(如连锁思想和少数背景学习)对Ops绩效的细致入微影响。值得注意的是,与广泛使用的BLEU和ROUGE相比,GPT评分是一个更可靠的指标,这表明它有可能取代大规模定量评估中的手动标签。

OpsEval框架内确定的灵活性为未来的探索提供了机会。该基准的适应性促进了额外细粒度任务的无缝集成,为持续研究和优化为运营量身定制的法学硕士奠定了基础。

REFERENCES

论文链接:https://arxiv.org/abs/2310.07637

9万+

9万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?