线性回归

| 目的 | 试图学得一个线性模型以尽可能地预测实值输出标记(即学w,b) | |

| 形式/ 向量形式 |

| |

| 均方差MSE的推导 | 梯度下降法:

理解: 需要选择学习率, 是迭代求解, 特征数m很大时不影响 | 最小二乘法:

理解: 不需要选择学习率, 不是迭代求解: 特征数m很大时计算速度慢 |

感知机

| 抽象理解 |

| 权重 | 突触 | |||||

| 偏置 | 阈值 | |||||||

| 激活函数 | 细胞体

| |||||||

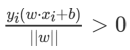

| 分类模型 | 二分类线性模型 | 输入:特征向量 输出: 类别(+1, -1) | 目标: 求超平面(能将训练数据集正负实例完全正确分开) |

| ||||

| 距离 | 点到线: | 样本到超平面:

| ||||||

| 损失函数 | 正确分类: 错误分类: | 目标: 使错误分类的样本到超平面的距离最小 | ||||||

| 感知机学习算法 | 输入:

| 输出:

| 过程:

(2)从训练集获取一个样本(x,y) (3)如果y(wx+b)<=0, 按照梯度更新参数 (4)继续(2)直到没有样本被错误分类 | |||||

| 感知机学习算法 | 假设: 算法执行了n(很多次)次才收敛, 参数的主部是增量. 即w变成ayx, | Gram本质: x*x可以事先由gram矩阵,计算好, 只更新a即可. | 过程:

| Gram减少运算量: n是维数, N是样本个数

n过高时, 应选择对偶形式算法加速(原始算法主要是w和x的内积) N很大时, 采用原始算法(对偶形式主要是输入实例之间的内积) | ||||

逻辑回归

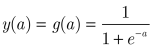

| 逻辑回归的引入 | 将激活函数从感知机的”符号函数”替换成了, “sigmoid”函数, 即给出了隶属于各类别的概率 | |

| Logistic函数 |

| |

| 二分类标签的后验概率 | y=1

| Y=0

|

| 交叉熵+梯度+参数更新 | 交叉熵:

| |

| 梯度:

| ||

| 参数更新:

| ||

Softmax分类

| argmax | 如果使用某一类的参数(w, b)使得wx+b最大, 则结果分为该类 | |

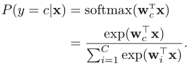

| 目标类别的条件概率 |

| 对比逻辑回归:

|

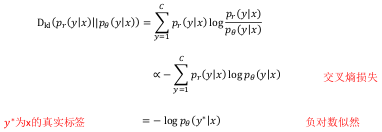

| KL散度, 负对数似然 |

| |

| 交叉熵+梯度下降 | 交叉熵:

| 梯度下降:

|

| 为什么逻辑回归用交叉熵损失而不用MSE? | 答: 参数的更新公式中有激活函数, 如果接近0或1就会梯度消失陷入局部极小

| |

929

929

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?