AI生成音乐正在迅速成为音乐创作领域的一大热点。从作曲到编曲,AI技术正以前所未有的方式改变着音乐的创作流程。本篇文章将详细探讨AI如何参与音乐的创作和编曲过程,并提供相关的代码实例,展示如何使用现有的AI工具和技术生成音乐。

AI生成音乐的基本原理

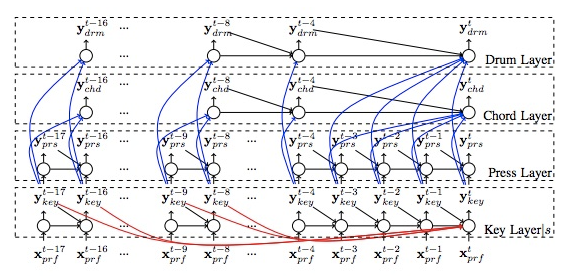

AI生成音乐通常涉及深度学习技术,特别是循环神经网络(RNN)和生成对抗网络(GAN)。这些模型能够学习和模仿音乐风格,从而生成新的音乐片段。

循环神经网络(RNN)

RNN擅长处理序列数据,特别适合音乐这种时间序列数据。LSTM(长短期记忆网络)是RNN的一种改进,能够有效地捕捉长期依赖关系。

生成对抗网络(GAN)

GAN由生成器和判别器组成,生成器尝试生成逼真的音乐片段,而判别器则尝试区分真实音乐和生成音乐。两者相互对抗,共同提升生成音乐的质量。

AI作曲

AI作曲指的是使用AI算法生成旋律、和弦进程等音乐元素。通常,AI会基于已有的音乐数据集进行学习,然后生成新的音乐片段。

使用Magenta进行作曲

Magenta是一个基于TensorFlow的开源项目,旨在探索AI在音乐和艺术创作中的应用。下面是一个简单的使用Magenta生成音乐的示例。

AI编曲

AI编曲涉及为旋律添加伴奏、和声等,使其成为一首完整的乐曲。DeepBach是一个流行的AI编曲工具,能够模仿巴赫的风格为旋律生成和声。

使用DeepBach进行编曲

DeepBach使用了LSTM和马尔科夫链模型,能够为给定的旋律生成和声。

AI生成音乐的实战应用

在理解了AI生成音乐的基本原理和相关技术之后,我们可以深入探讨如何在实际应用中使用这些技术工具进行音乐创作。

1. 准备音乐数据集

要生成高质量的音乐,我们首先需要一个丰富的音乐数据集。常用的数据集包括MIDI格式的音乐文件。以下是如何准备和处理音乐数据集的示例。

2. 构建音乐生成模型

使用提取的音符数据构建并训练音乐生成模型。这里我们将以LSTM模型为例,展示如何进行模型训练和生成音乐。

3. 生成音乐

训练完成后,我们可以使用模型生成新的音乐片段。以下是如何生成音乐并保存为MIDI文件的示例。

4. 编曲与混音

生成音乐后,我们可以使用AI工具进行编曲和混音。编曲通常涉及为旋律添加伴奏、和声、鼓点等,而混音则是调整各音轨的音量和平衡,使整个作品听起来更加和谐。以下是一个简单的使用库(如pydub)进行混音的示例。

AI生成音乐的挑战与解决方案

尽管AI生成音乐具有巨大的潜力,但在实际应用中仍然面临许多挑战。以下是一些常见的挑战及其解决方案。

1. 数据质量和多样性

AI模型的性能很大程度上依赖于训练数据的质量和多样性。如果数据集过于单一,生成的音乐可能会缺乏创新性和多样性。

解决方案:

- 多样化数据来源: 使用不同风格、流派和时期的音乐数据进行训练,增加模型的创作多样性。

- 数据增强: 通过数据增强技术,例如改变音高、速度和音量等方式,增加数据集的多样性。

2. 长期依赖问题

音乐序列通常较长,RNN在处理长期依赖问题时可能会遇到困难,导致生成的音乐缺乏连贯性。

解决方案:

- 使用LSTM或GRU: 这些改进的RNN结构能够更好地捕捉长期依赖关系。

- 注意力机制: 引入注意力机制,使模型能够关注音乐序列中的重要部分,提升生成音乐的连贯性。

3. 模型过拟合

在小数据集上训练的模型容易出现过拟合现象,即在训练数据上表现良好,但在生成新音乐时表现不佳。

解决方案:

- 正则化: 使用Dropout和L2正则化等技术减少模型过拟合。

- 交叉验证: 使用交叉验证方法评估模型性能,确保模型具有良好的泛化能力。

4. 评估标准

音乐的创作具有很强的主观性,评估AI生成的音乐质量并不容易。

解决方案:

- 主观评估: 通过人类听众的反馈进行主观评估,了解音乐的情感表达和听觉效果。

- 客观评估: 使用统计指标,如音高分布、节奏模式和和声结构等,进行客观评估。

实际案例:生成流行音乐

为了更好地展示AI生成音乐的实际应用,我们将通过一个完整的案例,展示如何生成流行音乐。

步骤1:数据准备

我们将使用一个流行音乐数据集,包括多个流行音乐的MIDI文件。首先,提取音符并进行数据预处理。

步骤2:构建和训练模型

使用LSTM模型训练数据。

步骤3:生成音乐

使用训练好的模型生成新的流行音乐片段。

步骤4:编曲和混音

为生成的旋律添加伴奏和混音,创建完整的音乐作品。

未来发展方向

随着AI技术的不断进步,我们可以预见AI生成音乐将在以下几个方面取得进一步的发展:

- 个性化音乐创作: AI能够根据用户的喜好和需求,生成个性化的音乐作品,满足不同场景和情感表达的需求。

- 实时音乐生成: AI可以实时生成音乐,应用于现场表演和互动娱乐,为观众带来全新的体验。

- 跨领域融合: AI生成音乐可以与其他艺术形式(如视觉艺术、舞蹈)相结合,创造出多元化的艺术作品。

总结

本文详细探讨了AI生成音乐的全流程体验,从数据准备、模型训练、音乐生成到编曲和混音。通过实例代码,我们展示了如何利用AI技术生成高质量的音乐作品。尽管AI生成音乐面临诸多挑战,但其发展潜力巨大,未来有望为音乐创作带来更多创新和可能性。希望本文能为您提供有价值的参考和启发,鼓励您在音乐创作中大胆探索AI技术的应用。

2139

2139

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?