摘要

得益于大规模的训练数据,基于Siamese的目标跟踪的最新进展已经在普通序列上取得了引人注目的结果。 而基于Siamese的跟踪器假定训练和测试数据遵循相同的分布。 假设有一组有雾或有雨的测试序列,不能保证在正常图像上训练的跟踪器在其他领域的数据上表现良好。 训练数据和测试数据之间的域转移问题已经在目标检测和语义分割领域进行了讨论,但在视觉跟踪方面尚未进行研究。 为此,在Siamese++的基础上,我们引入了域适配Siamese++,即DASiamRPN++,以提高跟踪器的跨域可移植性和鲁棒性。 在理论的启发下,提出了两个域适配模块:像素域适配(Pixel domain Adaptation, PDA)和语义域适配(Semantic domain Adaptation, SDA)。 PDA模块对模板的特征图和搜索区域图像进行对齐,消除了由于天气、光照等原因造成的像素级域漂移。 SDA模块将跟踪目标的出现特征表示对齐,以消除语义级的域漂移。 PDA和SDA模块通过对抗性训练学习领域分类器来减小领域差异。 域分类器强制网络学习域不变的特征表示。 在合成雾和红外序列两个不同域的标准数据集上进行了大量实验,验证了所提跟踪器的可移植性和域适应性。

1、简介

视觉目标跟踪是计算机视觉的基本问题之一,它的目的是在目标只有一个初始状态的情况下估计任意视觉目标的运动轨迹。 通用视觉跟踪是一个有趣而具有挑战性的研究课题,具有广泛的应用前景,如视频监控、自动驾驶等。

在大规模标记良好的数据集和深度卷积神经网络的驱动下,最近的目标跟踪方法取得了优异的性能,特别是基于Siamese的跟踪器。 基于Siamese的跟踪器通常通过从模板中学习到的特征表示与搜索区域之间的互相关联来学习一般的相似性映射,这些特征表示通过端到端大规模数据进行训练。

Problem.

在现实场景中,由于应用环境的多样性,如天气(雾/雨/云)、方式(RGB/TIR)和照明(白天/夜晚)等,跟踪算法面临着巨大的挑战。 如图1所示,从不同的领域收集了Persons、Cars和Dogs的跟踪目标序列。 一般情况下,跟踪器仅使用理想条件下采集的序列进行训练,由于训练数据和测试数据之间的域漂移,无法保证跟踪器对开放场景的适应性和可移植性。 为了证明这一问题的存在,我们利用SiamRPN++[23]对正常序列、热红外(TIR)序列和生成的fog序列进行了验证性实验。 注意,SiamRPN++只接受了LaSOT数据集的训练。 (1)、我们首先在合成雾VOT2018和普通雾VOT2018上评估训练模型。 (2)、VOT2019-RGBT基准可以分为RGB序列和TIR序列,并对RGB序列和TIR序列进行训练模型评估。 结果如图2所示,表明训练数据和测试数据之间的域分布差异确实会导致性能的显著退化。

该问题的解决方案之一是尽可能多地收集训练数据,以减轻域漂移的影响。 但是,边界框注释是费时费力的。 因此,类似于域自适应检测,开发域自适应跟踪器来处理跨域差异造成的性能下降是合理和自然的。 为了克服跨域跟踪的限制,提高泛化能力,我们引入了一种基于典型SiamRPN算法的域适配跟踪器。 针对无监督域自适应场景,即源域标记良好而目标域未标记的情况,我们打算使域自适应跟踪器在源域和目标域上都表现良好,而不需要额外的标注成本。 据我们所知,我们首先注意到视觉跟踪区域的域分布差异问题,并提出了一种域自适应跟踪器。

无监督域自适应的一般思想是通过显式学习不同域之间的域不变表示来弥合域间隙,并在目标域上实现小误差。 我们的目标是最小化,它通常用来测量源域和目标域之间的分布散度。 基于贝叶斯公式和协变量位移假设,4.2节给出了跟踪的概率分析。 受

理论和概率视角的启发,我们提出了两种层次的域适配跟踪器,即像素域适配(Pixel domain Adaptation, PDA)和语义域适配(Semantic domain Adaptation, SDA)。 PDA模块主要关注每个特征像素的域移,例如图像样式、光照等。 而SDA模块则以域移引起的外观和类别变化来关注整体目标。 通过对抗性的方式训练领域分类器和暹罗网络,PDA和SDA加强了卷积神经网络学习领域不变的特征映射和特征表示。 本文的贡献可归纳如下:

- 我们首先将域分布差异问题引入视觉跟踪社区。 验证性实验表明,域移导致了明显的性能下降。

- 我们提出像素域自适应(PDA)模块和语义域自适应(SDA)模块来学习域不变特征。 PDA实现了图像级源域与目标域的域分布对齐。 SDA主要关注领域分布对齐,而不是语义级的跟踪目标。

- 我们提出了一种生成雾图像和构建雾基准的新方案。 采用单视图深度估计方法MegaDepth对深度图进行预测。 受HazeRD的启发,我们利用RGB图像及其对应的深度预测图生成Foggy VOT2018、Foggy OTB100、Foggy UAV123和Foggy GOT-10k。

2、相关工作

Siamese Network for Tracking.

Siamese网络在视觉跟踪领域得到了广泛的关注。 包括SINT和SiamFC在内的先驱工作都是用大规模的图像对进行训练,以端到端方式学习相似函数。 Li等人受Faster RCNN的启发,[24]将Siamese网络与Region Proposal network (RPN)相结合,将目标跟踪作为局部的一次性目标检测问题。 为了开发更深入和更广泛的跟踪网络,SiamRPN++用ResNet-50取代了改良的AlexNet,以丰富提取的特征图。 SPM-tracker[39]设计了两级网络,即粗匹配阶段和精匹配阶段,可以实现较高的定位精度。 Cascade-RPN采用多级跟踪框架,三个RPN级联,利用不同级别的特征图。 无锚跟踪器采用逐像素预测方式获得精确的边界框,提高计算效率。 但是,大多数跟踪方法只在第一帧中生成目标的外观模型,在接下来的帧中没有更新外观模型。 这些跟踪器的鲁棒性受到严重限制。 Bhat等人[3]提出了一种目标模型预测器对外观模型进行在线优化,能够同时利用目标和背景信息生成判别目标模型。 然而,这些SOTA跟踪器没有考虑跨数据集的域转移,这无疑削弱了它们的适配性和可移植性。

Domain Adaptation

域适配被广泛用于跨域图像分类和检测,其目的是通过减少分布差异将知识从一个域转移到另一个域。 一种常用的域适配方法是通过使从不同域提取的特征不可区分来弥合域间隙。 近年来,一些方法在无监督域自适应方面取得了巨大的成功。 早期的模型通过最大平均偏差(Maximum Mean deviation, MMD)、矩匹配等度量度量域的发散度来减小不同域之间的差异。 近年来提出的基于对抗学习的方法,要么采用生成式对抗网络(GAN),要么采用梯度倒转层(GRL)进行对抗训练。 由GAN驱动的一些方法实现了图像-图像转换技术的像素级适配。 Ganin等提出了梯度反向层,该层在反向传播阶段反转梯度,实现特征表示与域分类器之间的极大极小优化,这是一个直观的域自适应问题。

3、回顾SiamRPN++

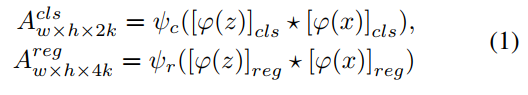

SiamRPN++主要由两部分组成,包括用于特征提取的Siamese网络和用于定位的区域建议网络。模板z及其对应的搜索区域x被表述为SiamRPN++的输入图像对。基于暹罗的跟踪器通常利用双流网络分别提取模板和搜索区域的特征图。SiamRPN++采用深度互相关和全卷积层相结合的方式组装头部模块,用于计算分类分数和包围框回归坐标(offset),可表示为:

其中![]() 为SiamRPN网络。

为SiamRPN网络。![]() 是调整层,使功能更好地适合不同的任务。

是调整层,使功能更好地适合不同的任务。![]() 表示互相关操作,k是锚的数量。交叉熵损失和平滑L1损失用于监督二值分类和回归分支。

表示互相关操作,k是锚的数量。交叉熵损失和平滑L1损失用于监督二值分类和回归分支。

4、理论基础

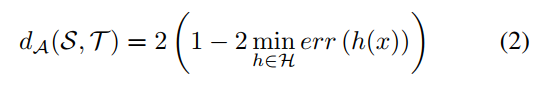

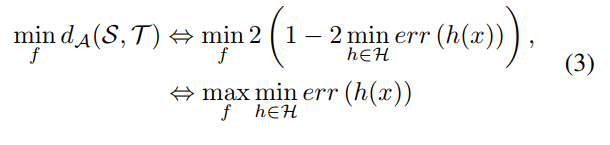

4.1、A距离

给定源域S和目标域T,对于两组具有域分布的样本,我们通常使用来测量两组样本之间的分布差。假设

![]() 是域分类器的假设集,

是域分类器的假设集,![]() ,领域分类器之一,其目的是预测源样本

,领域分类器之一,其目的是预测源样本![]() 为0(即

为0(即![]() ),目标样本

),目标样本![]() 为1(即

为1(即![]() )。度量域散度的A-distance可以表示为:

)。度量域散度的A-distance可以表示为:

其中![]() 由一组域分类器组成,

由一组域分类器组成,![]() 为理想域分类器的预测误差。显然,一个小的域分类错误意味着大的领域分歧。大多数域适配方法通常会使域差异最小化

为理想域分类器的预测误差。显然,一个小的域分类错误意味着大的领域分歧。大多数域适配方法通常会使域差异最小化![]() 来实现特征对齐。因此,等效于最大化理想域分类器的误差,有:

来实现特征对齐。因此,等效于最大化理想域分类器的误差,有:

其中是Siamese网络样本

的特征表示。显然,问题(3)是特征提取器f和域分类器h之间的一个标准极大极小优化问题。因此,我们以对抗训练的方式对上述极大极小问题进行优化。梯度反转层(GRL)是解决这一问题的常用方法。

4.2、目标跟踪器的概率分析

对于视觉跟踪,给定目标的初始状态,跟踪器的目的是预测目标在接下来的帧中的位置,可以将其视为后验概率![]() ,其中

,其中和

表示分类得分和预测边界框,

和

表示模板和搜索区域,等。我们利用

![]() 及

及![]() 表示源域和目标域的联合分布。由于域移的存在,源域的联合分布与目标域的联合分布一般不一致。

表示源域和目标域的联合分布。由于域移的存在,源域的联合分布与目标域的联合分布一般不一致。

像素域适配

当两个域之间有定义域变换时,我们有:

![]()

根据贝叶斯公式,可以将联合分布分解为:

![]()

式中![]() 表示不同的域。对目标跟踪进行了协变量位移假设。

表示不同的域。对目标跟踪进行了协变量位移假设。![]() 表示条件分布,源域和目标域相同,即

表示条件分布,源域和目标域相同,即![]() 。因此,域位移主要是由边际分布引起的,即

。因此,域位移主要是由边际分布引起的,即

![]()

在理想的情况下,无论序列属于哪个域,SiamRPN++的预测结果应该是相同的。根据网络框架,![]() 表示RPN,用于分类和回归。

表示RPN,用于分类和回归。![]() 表示Siamese网络输出的模板和搜索区域的特征映射。最终目的是加强Siamese网络来提取领域不变的特征映射,这样,

表示Siamese网络输出的模板和搜索区域的特征映射。最终目的是加强Siamese网络来提取领域不变的特征映射,这样,

![]()

语义域适配

像素域自适应解决了由天气或光照引起的域漂移,即全局区域。但不同领域数据的跟踪目标存在外观变化和类别变化。跟踪目标的语义信息也应得到重视。类似于像素域自适应,我们可以用贝叶斯公式将联合分布分解为另一种格式,即:

![]()

我们还提出了语义域适配的协变量转移假设。假设条件分布![]() 对于不同的域是相同的,即

对于不同的域是相同的,即

![]()

根据Eq.(8),我们认为边际分布![]() 是导致域差异和性能下降的主要原因。因此,我们应该约束这两个域的边际分布相同,理想情况下,

是导致域差异和性能下降的主要原因。因此,我们应该约束这两个域的边际分布相同,理想情况下,![]() 。注意,跟踪目标注释对于目标域是不可用的。因此,无论是源域还是目标域,我们都使用RPN预测的边界框。

。注意,跟踪目标注释对于目标域是不可用的。因此,无论是源域还是目标域,我们都使用RPN预测的边界框。

5、提出的方法

5.1、Siamese网络

整个框架如图3所示。受第4节的理论和概率视角的启发,我们引入了两个域自适应模块来解决域漂移问题,包括像素域自适应(Pixel domain Adaptation, PDA)和语义域自适应(Semantic domain Adaptation, SDA)。我们使用改进的ResNet-50作为我们的骨干网络进行特征提取。原始ResNet-50的步幅是32像素。为了使它更适合于跟踪,我们通过遵循与SiamRPN++相同的协议,将block 3和block 4的有效步幅从16像素和32像素调整为8像素。由于不同级别的Siamese网络包含不同特征表示的低层和高层特征映射,我们打算利用多级特征来充分利用语义信息和外观信息。

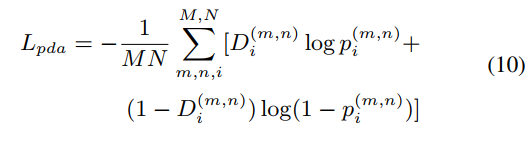

5.2、像素级适配

如第4.2节所述,特征图是由Siamese网络提取的,包含了模板和搜索区域的前景和背景信息。训练图像在图像风格、光照等方面具有多样性。因此,为了获得域不变特征映射,像素域自适应模块包括模板对齐和搜索区域对齐,其目的是通过域分类器和Siamese网络之间的极大极小优化来混淆跨域的特征映射。给定一个图像对,即模板![]() 和从源域或目标域搜索区域

和从源域或目标域搜索区域![]() ,我们首先从块2、块3、块4提取多级特征映射,记为

,我们首先从块2、块3、块4提取多级特征映射,记为![]() 和

和![]() ,

,![]() 。因此,我们打算用域分类器来约束每个级别的特征映射。该像素域分类器由卷积层、最大池化层和全连通层组成。FC层用于对每个特征像素进行二值分类。像素域自适应损失:

。因此,我们打算用域分类器来约束每个级别的特征映射。该像素域分类器由卷积层、最大池化层和全连通层组成。FC层用于对每个特征像素进行二值分类。像素域自适应损失:

其中![]() 为域分类器像素(m,n)。

为域分类器像素(m,n)。 ![]() 表示源域或目标域的域标签。我们的目的是使域分类器不能区分像素是否属于源域。根据Eq.(3)的思想,我们首先将域分类器学习的域分类损失最小化,然后对Siamese网络学习的域分类损失最大化。域分类器的可训练参数记为

表示源域或目标域的域标签。我们的目的是使域分类器不能区分像素是否属于源域。根据Eq.(3)的思想,我们首先将域分类器学习的域分类损失最小化,然后对Siamese网络学习的域分类损失最大化。域分类器的可训练参数记为![]() ,

, ![]() 表示Siamese网络的参数。对抗性学习可以写成:

表示Siamese网络的参数。对抗性学习可以写成:

![]()

5.3、语义域适配

由于不同域的类别、视角和姿态的变化,跟踪目标的出现会发生明显的变化。为此,我们提出了语义域自适应(Semantic Domain Adaptation, SDA)模块,以强制跟踪目标的特征表示在语义层面上是域不变的。

随着RPN的输出,我们可以得到预测的边界框。ROI Align取预测的边界框和多层特征映射的![]() ,

,![]()

![]() 作为输入。ROI Align的输出为固定大小为

作为输入。ROI Align的输出为固定大小为![]() 的目标特征。为了对两个域之间的局部区域的特征表示进行对齐,我们采用类似于像素域自适应的对抗性训练策略。在领域分类器和ROI Align之间实现GRL。为了从整体目标的角度协调语义特征,我们利用两个完全连接的层构成语义域分类器。采用交叉熵损失,即。

的目标特征。为了对两个域之间的局部区域的特征表示进行对齐,我们采用类似于像素域自适应的对抗性训练策略。在领域分类器和ROI Align之间实现GRL。为了从整体目标的角度协调语义特征,我们利用两个完全连接的层构成语义域分类器。采用交叉熵损失,即。

![]()

其中![]() 表示语义域分类器的输出。我们还以对抗性的方式训练了SDA模块的损失函数,

表示语义域分类器的输出。我们还以对抗性的方式训练了SDA模块的损失函数,

![]()

其中![]() 是Siamese网络的参数,

是Siamese网络的参数,![]() 表示语义域分类器的参数。无论跟踪目标来自源域还是目标域,目标的域不变特征都能在得分图中获得较高的响应。

表示语义域分类器的参数。无论跟踪目标来自源域还是目标域,目标的域不变特征都能在得分图中获得较高的响应。

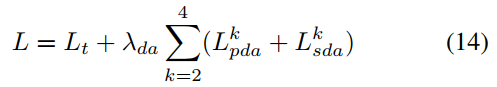

5.4、训练损失

在训练阶段,整个框架由基线跟踪器和领域自适应模块组成。因此,所提框架的最终损耗包括跟踪损失和域适配损失,

其中![]() 由基于交叉熵的前景-背景预测二值分类损失和基于平滑

由基于交叉熵的前景-背景预测二值分类损失和基于平滑![]() 的目标定位回归损失组成。

的目标定位回归损失组成。![]() 是一个权衡参数。K为多层次特征映射的指标。

是一个权衡参数。K为多层次特征映射的指标。

6、有雾图像生成

为了验证域移问题,我们打算将普通序列作为源域,而雾序列作为目标域。然而,目前还没有公开的模糊跟踪数据集,边界框注释也非常昂贵和耗时。使用合成数据来训练CNN变得越来越流行。例如,合成雾图像被广泛应用于数据驱动的去雾方法和领域自适应检测。受[5]的启发,我们提出利用现有的跟踪数据集来合成雾序列。现有的跟踪数据集中的图像有三个通道(RGB)。为了使合成的雾数据集更加真实。在前人研究工作的基础上,本文提出了一种基于单视角深度预测的雾天图像合成方法,该方法可分为两步:(1)、采用单视角深度预测算法生成雾天深度图;(2)、根据大雾天气的光学模型,利用RGB图像及其对应的深度图合成大雾图像。合成雾天图像如图4所示。

对于单视图深度预测模型,我们选择常用的MegaDepth。得益于大量的互联网SfM+MVS数据,MegaDepth具有较高的精度和良好的泛化性能。预测的深度图显示在图4的第二行。然后,使用RGB-Depth图像生成雾霭图像。根据Mie散射理论和HazeRD,空气光线和衰减是雾霾下图像信息建模的两个主要因素。由于空气中存在尘埃、薄雾或烟雾,当物体的反射光在空气中传播到达相机时,反射光的强度会随着距离的增加呈指数衰减。大气散射模型是对雾天图像生成的经典描述,可以表示为:

![]()

![]() 为波长,

为波长,![]() 为光谱辐照度,

为光谱辐照度,![]() 为空气光,

为空气光,![]() 为透射率,透射率可表示为:

为透射率,透射率可表示为:

![]()

其中![]() 为雾霾粒子的散射系数,d为物体到相机的距离。Foggy VOT2018、Foggy OTB100、Foggy UAV123和Foggy GOT-10k基准通过这种方式生成。值得一提的是,为了防止过拟合问题,我们对训练和评价数据集采用了不同的

为雾霾粒子的散射系数,d为物体到相机的距离。Foggy VOT2018、Foggy OTB100、Foggy UAV123和Foggy GOT-10k基准通过这种方式生成。值得一提的是,为了防止过拟合问题,我们对训练和评价数据集采用了不同的![]() 。

。

7、实验

7.1、实现细节

Data Preprocessing.

我们执行与Siamrpn++相同的数据准备。 对于源训练数据集,即LaSOT,可以使用标注来获取裁剪后的图像。 但是对于目标训练数据集,如Foggy GOT-10k和LSOTB-TIR,则没有注释。 在实践中,我们应该首先在目标域数据集上运行现有的SiamRPN++,以获得可以用于裁剪图像的伪标签。

Training.

我们使用在ImageNet上预训练的改进的ResNet-50作为我们的骨干。 在训练阶段,我们对模型进行了19个epoch的16个小批量训练。 在前10个epoch中,我们冻结了backbone的参数,只微调了三个RPN头[36]的参数。 在最近的9个epoch中,区块2、3和4的参数被解冻。 基础学习率为,前5个epoch的预备学习率为

。 在过去的14个epoch中,学习速率在每个epoch从

下降到

。 我们使用随机梯度下降(SGD)训练网络,权值衰减为

,动量为0.9。 对于域自适应模块,它们的初始学习速率设置为

,并随着RPN的学习速率减小。 实验在使用Intel i9-7900X和4个NVIDIA TITAN Xp图形处理器的PC机上进行。

7.2. Cross-domain Tracking from Normal to Foggy

Foggy VOT2018:

VOT数据集由60个具有挑战性的序列组成,每年更新部分序列。 通过精度(A)、鲁棒性(R)和EAO来评估性能,EAO分别表示成功跟踪帧的平均重叠、失败率和期望平均重叠。

为了更好地反映我们方法的性能改进,我们选择了从Epoch 11到19的SiamRPN++和DASiamRPN++训练模型,在Foggy VOT2018上进行评估,没有微调任何超参数。 我们首先比较DASiamRPN++和DASiamRPN++的最佳结果。 如表1所示,我们的DASiamRPN++可以获得0.231的最佳EAO分数,优于SiamRPN++ 0.211的最佳EAO分数,相对增益为9.5%。 对于表1中每个epoch的定量结果,我们的方法可以超过SiamRPN++。

Foggy OTB100:

Foggy OTB100包含了从常用跟踪序列中收集的100个序列。 评估基于两个指标:精度(P)和成功(S)得分。 每个epoch结果见表2。 SiamRPN++的最佳成功分数是0.533。 与SiamRPN++相比,我们的DASiamRPN++使用PDA和SDA模块实现了+2.1%的性能增益。 在每个阶段,我们的大多数模型都超过了SiamRPN++,这证明了我们的方法的有效性。

Foggy UAV123:

UAV123由123个航拍视频序列组成,以精度(P)和成功(S)得分作为性能比较指标。 所有结果如表3所示。 我们方法的最佳成功分数是0.498。 与SiamRPN++的最佳成功分数相比,我们可以获得2.3%的相对增益。 对于各epoch模型的比较,我们的方法可以显著提高精度和成功分数。

7.3. Cross-domain Tracking from RGB to TIR

LSOTB-TIR:

LSOTB-TIR由1400个TIR序列组成,分为训练子集和测试子集。 测试子集包含120个视频。 我们选择LaSOT作为源域数据集,而选择LSOTBTIR训练子集作为目标域数据集。 性能指标与OTB100相同。 我们在LSOTB-TIR测试子集上评估了SiamRPN++和DASiamRPN++。 各epoch结果见表4。 与基准相比,我们的方法有了改进。

7.4. Ablation Study and Discussion

Effectiveness of PDA.

在表5中,我们评估了结合SiamRPN++和PDA模块的模型。 显然,SiamRPN++加上PDA模块可以获得更好的性能。 PDA模块对模板和搜索区域的特征映射进行域对齐。 Siamese网络能够提取域不变的特征,使我们的跟踪器更适合复杂的应用环境。 对于大多数epoch模型,只有PDA模块的DASiamRPN++也可以超过原始的SiamRPN++。

Effectiveness of SDA.

与前面提到的PDA类似,我们的DASiamRPN++仅使用SDA在Foggy VOT2018上进行了评估,以显示语义域自适应模块的效率。 在表5中,SiamRPN++和SDA组合在不同时代的效果都优于SiamRPN++。 所提出的SDA模块有助于最终的域自适应。

Visualization.

t-SNE是一种常用的特征降维方法。 它非常适合将高维数据降维为2维或3维,便于可视化。 提取的block 3特征图如图6所示。 利用领域自适应模块的约束,混淆了DASiamRPN++提取的特征映射。 跟踪结果可视化如图5所示。

Evaluation on Normal Sequences.

我们预计DASiamRPN++在原始VOT2018上不会导致任何性能下降。 如图7所示,橙色的线表示DASiamRPN++的评价结果,说明我们的方法在普通序列和雾序列上都很好。

8、结论

在本文中,我们将跨不同数据集的域移问题引入视觉跟踪领域。 为了证明区域分布的差异会导致性能下降,我们设计了验证性实验,包括合成雾序列和红外序列。 然后,为了解决域漂移问题,将原始标注完整的正常序列设置为源域,而将完全未标注的模糊序列设置为目标域。 基于理论和概率视角,引入了像素域自适应和语义域自适应两个域自适应模块。

设计了两个域自适应模块,通过基于极大极小的对抗训练最小化数据集之间的域差异。 大量实验表明,与SiamRPN++相比,该方法具有明显的性能改进,对跨域跟踪具有较好的适应性和可移植性。

3580

3580

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?