SiamRPN++: Evolution of Siamese Visual Tracking with Very Deep Networks

https://blog.csdn.net/zjc910997316/article/details/90749967?ops_request_misc=&request_id=&biz_id=102&utm_term=SiamRPN++&utm_medium=distribute.pc_search_result.none-task-blog-2allsobaiduweb~default-0-90749967.142v77control_1,201v4add_ask,239v2insert_chatgpt&spm=1018.2226.3001.4187

Abstract

基于Siamese网络的跟踪器将跟踪表述为目标模板和搜索区域之间的卷积特征互相关。然而,与最先进的算法相比,Siamese追踪器仍有精度上的差距,它们不能利用深度网络的特征,如ResNet-50或更深的网络。在这项工作中,证明核心原因来自于缺乏严格的平移不变性。通过全面的理论分析和实验验证,我们通过一个简单而有效的空间感知采样策略打破了这一限制,成功地训练了基于ResNet网络的孪生跟踪器,并取得了显著的性能提升。此外,我们提出了一种新的模型结构,以进行分层和深度聚合,这不仅进一步提高了准确性,而且还减少了模型的大小。

1、Introdution

孪生跟踪器通过对目标模板和搜索区域学习的特征表示之间的互相关,将视觉目标跟踪问题描述为学习一个通用的相似性映射。为了保证跟踪效率,离线学习的孪生相似度函数在运行时经常是固定的。DaSiamRPN跟踪器[52]进一步引入了一个干扰感知模块,并提高了模型的识别能力。

我们观察到,所有这些跟踪都在类似于Alexnet的架构上构建了自己的网络,并多次尝试训练具有更复杂架构(如Resnet)的孪生网络,但没有性能提升。在这种观察的启发下,我们对现有的孪生追踪器进行了分析,发现其核心原因是绝对平移不变性(strict translation invariance)的破坏。(严格的不变性指的就是严格地将目标放在图片正中央去进行训练。)

由于目标可能出现在搜索区域的任何位置,因此学习到的目标模板的特征表示应该保持空间不变性,并且我们进一步从理论上发现,在现代深度架构中,只有AlexNet的zero-padding满足这种空间不变性限制。

为了克服这一限制,用更深的网络结构去克服孪生网络跟踪算法平移不变性的限制,通过大量的实验验证,我们引入了一种简单而有效的采样策略来打破Siamese跟踪器的空间不变量限制。我们成功地训练了一个基于SiamRPN的跟踪器,使用ResNet作为主干网络,并获得了显著的性能改进。

利用ResNet结构,提出了一种基于层的互相关运算特征聚合结构(a layer-wise feature aggravation structure),该结构有助于跟踪器从多个层次的特征中预判出相似度图。通过对孪生网络结构的交叉相关分析,发现其两个网络分支在参数个数上存在高度不平衡,因此进一步提出了一种深度可分离的相关结构,它不仅大大减少了目标模板分支中的参数个数,而且使模型的训练过程更加稳定。还观察到一个有趣的现象,即相同类别的对象在相同通道上具有较高的响应,而其余通道的响应则被抑制。正交特性也可以提高跟踪性能。

综上所述,本文的主要贡献如下:

-

我们对孪生跟踪器进行了深入的分析,并证明在使用深网络时,精度的降低是由于绝对平移不变性的破坏。

-

我们提出了一种简单而有效的采样策略,以打破空间不变性限制,成功地训练了基于ResNet架构的孪生跟踪器。

-

提出了一种基于层次的互相关操作特征聚集结构,该结构有助于跟踪器根据多层次学习的特征预测相似度图。

-

我们提出了一个深度可分离的相关结构来增强互相关,从而产生与不同语义相关的多重相似度图。

2、Related Works

在深度视觉跟踪器中,网络架构通常包含不超过5个由AlexNet或VGGNet定制的构成层。这一现象可以解释为,浅特征主要有助于物体的准确率定位。在这项工作中,如果模型在整个孪生网络中得到适当的训练,那么使用更深层次的模型,孪生追踪器的性能可以显著提高。

3、Siamese Tracking with Very Deep Networks

如果使用更深层次的网络,基于孪生网络的跟踪算法的性能可以显著提高。然而,仅仅通过直接使用更深层的网络(如resnet)来训练孪生跟踪器并不能获得预期的性能改进。我们发现其根本原因主要是由于孪生追踪器的内在限制,因此,在引入所提出的SiamRPN++模型之前,我们首先对孪生追踪网络进行了深入的分析。

3.1、Analysis on Siamese Networks for Tracking

基于孪生网络的跟踪算法将视觉跟踪作为一个互相关问题,并从具有孪生网络结构的深层模型中学习跟踪相似性图,一个分支用于学习目标的特征表示,另一个分支用于搜索区域。目标区域通常在序列的第一帧中给出,可以看作是一个模版z。目标是在语义嵌入空间Φ(·)中从后续帧x中找到最相似的区域(实例),其中b是偏移量。:

这个简单的匹配函数自然意味着孪生网络跟踪器有两个内在的限制。

- 孪生跟踪器中使用的收缩部分和特征抽取器对绝对平移不变性有内在的限制,

其中

其中 ,是平移移位子窗口操作器,确保了有效的训练和推理。

,是平移移位子窗口操作器,确保了有效的训练和推理。 - 收缩部分对结构对称性有着内在的限制,

,适用于相似性学习。

,适用于相似性学习。

通过详细的分析,我们发现防止使用深网络的孪生跟踪器的核心原因与这两个方面有关。一个原因是深层网络中的填充会破坏绝对平移不变性。另一个是RPN需要不对称的特征来进行分类和回归。我们将引入空间感知抽样策略来克服第一个问题,并在3.4中讨论第二个问题。

图1.使用不同随机平移时正样本的先验概率的可视化。 在±32像素内随机平移后,分布变得更加均匀。

图2.随机平移对VOT数据集的影响。

绝对平移不变性只存在于no padding的网络中,如修改后的Alexnet。以前基于孪生的网络设计为浅层网络,以满足这一限制。然而,如果使用的网络被新型网络如ResNet或MobileNet所取代,填充(padding)将不可避免地使网络更深入,从而破坏了绝对平移不变性限制。我们的假设是,违反这一限制将导致空间偏移。

我们通过在带有填充(padding)的网络上进行模拟实验来验证我们的假设。移位定义为数据扩充中均匀分布产生的最大平移范围。

首先,在三个单独的训练实验中,目标被放置在具有不同移位范围(0、16和32)的中心。在收敛后,我们将测试数据集上生成的热图集合起来,然后将结果显示在图1中。

图一 在第一次零偏移模拟中,边界区域的概率降为零。结果表明,尽管有测试目标的出现,但仍然存在很强的中心偏差。

另外两个模拟表明,增加位移范围将逐渐防止模型崩溃到这个微不足道的解决方案中。定量分析结果表明,32-shift的总热量更接近于测试对象的位置分布。结果表明,空间感知抽样策略有效地缓解了填充网络对严格平移不变性的破坏。

为了避免对物体产生强烈的中心偏差,我们采用空间感知采样策略,用Resnet-50主干训练SiamRPN。如图2所示,在VOT2018上,零移位(zero shift)的性能降低到0.14,适当的移位(±64像素)对于训练深孪生跟踪器至关重要。

3.2、ResNet-driven Siamese Tracking

图3.我们提出的框架的插图。给定目标模板和搜索区域,网络通过融合多个Siamese Region Proposa(SiamRPN)块的输出来输出密集预测。每个SiamRPN块都显示在右侧。

基于上一节的分析,可以消除中心偏差的影响。一旦我们消除了对中心位置的学习偏差,任何现成的网络(例如,MobileNet,ResNet)都可以用于迁移学习后执行视觉跟踪。此外,还可以自适应地构造网络拓扑结构,揭示深度网络的视觉跟踪性能。

在本小节中,我们将讨论如何将深度网络转移到我们的跟踪算法中。特别是,我们的实验主要集中在ResNet-50。

原来的ResNet有32 像素 的大 stride,不适合于密集的孪生网络预测。如图3所示,我们通过修改conv4和conv5块以获得单位空间步幅,将最后两个块的有效步幅从16像素和32像素减少到8像素,并通过扩大卷积增加其感受野。在每个块输出端附加一个额外的1×1卷积层,将通道减少到256。

由于所有层的填充都保持不变,模板特征的空间大小增加到15,这给相关模块带来了沉重的计算负担。因此,我们裁剪中心7×7区域作为模板特征,其中每个特征单元仍然可以捕获整个目标区域。

在SiamRPN的基础上,我们将互相关层和全卷积层组合成头模块(head module)用于计算分类分数(用S表示)和边界框回归器(用B表示)的头模块。SiameseRPN块用P表示。

此外,我们发现经过的微调ResNet将提高性能。通过将ResNet提取器的学习速率设置为比RPN小10倍,该特征表示更适合于跟踪任务。与传统的孪生方法不同,深层网络的参数以端到端的方式进行联合训练。据我们所知,我们是第一个在深度孪生网络(>20层)上实现端到端学习的视觉跟踪算法。

3.3、Layer-wise Aggregation

在利用像ResNet-50这样的深度网络后,聚合不同的深层成为可能。

直观地说,视觉跟踪需要丰富的表示,从低到高,从小到大,从细到粗的分辨率。即使卷积网络中的特征有深度,孤立的一层也是不够的:组合和聚集这些表示可以提高识别和定位的推理。

在以前的文献中,仅使用像Alexnet这样的浅层网络,多层特性不能提供多元的特征表示。考虑到感受野的变化很大,ResNet中的不同层更有意义。浅层特征主要集中在颜色、形状等低级信息上,对于定位是必不可少的,而缺乏语义信息;深层特征具有丰富的语义信息,在运动模糊、大变形等挑战场景中有利于定位。假设使用这种丰富的层次信息来帮助跟踪。

在我们的网络中,多分支特征被提取出来共同推断目标定位。对于Resnet-50,我们探索从最后三个residual blocks中提取的多级特性,以进行分层聚合。我们将这些输出特征分别称为F3(z)、F4(z)和F5(z)。如图3所示,conv3、conv4、conv5的输出分别输入三个SiamRPN模块。

由于三个RPN模块的输出尺寸具有相同的空间分辨率,因此直接在RPN输出上采用加权和。加权融合层结合了所有的输出:

S——分类,B——回归

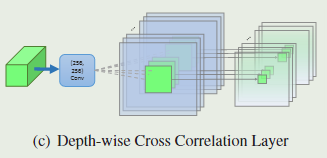

图4、不同互相关层的图示。

- (a)交叉相关(XCorr)层预测目标模板和搜索区域之间的单通道相似度图。

- (b)向上通道互相关(UP-XCorr)层通过在SiamRPN中将一个具有多个独立XCorr层的重卷积层级联而输出多通道相关特征。

- (c)深度相关(DW-XCorr)层预测模板和搜索块之间的多通道相关特征。

组合权重被分开用于分类和回归,因为它们的域是不同的。权重与网络一起进行端到端优化离线。

与以前的论文相比,我们的方法没有明确地结合卷积特征,而是分别学习分类器和回归。请注意,随着骨干网络的深度显着增加,我们可以从视觉语义层次结构的充分多样性中获得实质性效果。

3.4、Depthwise Cross Correlation

互相关模块是嵌入两个分支信息的核心操作。SiamFC 利用交叉相关层获得目标定位的单通道响应图。 在SiamRPN 中,通过添加巨大的卷积层来扩展通道(UP-Xcorr),交叉相关被扩展为嵌入更高级别的信息,例如anchors。 巨大的up-channel模块严重影响参数分布的不平衡(即RPN模块包含20M参数,而特征提取器在中仅包含4M参数),这使得SiamRPN中的训练优化变得困难。

在本小节中,我们提出了一个轻量级互相关层,名为Depthwise Cross Correlation(DW-XCorr),以实现有效的信息关联。 DW-XCorr层包含的参数比SiamRPN中使用的UP-XCorr少10倍,而性能却很高。

图5. conv4中深度相关输出的通道。conv4中共有256个通道,但是在跟踪过程中只有少数通道具有高响应。 因此我们选择第148,222,226通道作为演示,图中为第2,第3,第4行。第一行包含来自OTB数据集的六个对应搜索区域。不同的通道代表不同的语义,第148通道对汽车有很高的响应,而对人和人脸的反应很低。第222和第226通道分别对人和面部有很高的反应。

为实现此目的,采用conv-bn块来调整每个residual blocks的特征以适应跟踪任务。至关重要的是,边界框预测和基于anchors的分类都是不对称的,这与SiamFC不同(见第3.1节)。为了对差异进行编码,模板分支和搜索分支传递两个非共享卷积层。然后,具有相同数量的通道的两个特征图 按通道进行相关操作。附加另一个conv-bn relu块以融合不同的通道输出。最后,附加用于分类或回归输出的最后一个卷积层。

通过将互相关替换为深度相关,我们可以大大降低计算成本和内存使用。通过这种方式,模板和搜索分支上的参数数量得到平衡,从而使训练过程更加稳定。

此外,有趣的现象如图5所示。 同一类别中的对象在相同的通道上具有高响应(第148通道中的车,第222通道中的人,以及第226通道中的人),而其余通道的响应被抑制。由于深度互相关产生的通道方式特征几乎正交并且每个通道代表一些语义信息,因此可以理解该属性。我们还使用up-channel cross correlation 分析热图,并且响应图的解释性较差。

绿色的F(Z)和紫色的F(X)分别代表该颜色主干网络某一层的输出,上图倒数第二行的adj_n指的是一次卷积操作,他的目的是将绿色的F(Z)和紫色的F(X)的通道数压缩到256,然后就是关键也是本文的一大精髓了,DW-Corr(Depth-wise Cross correlation),具体操作见下图:

拿adj_1和adj_2举例,adj_1和adj_2他们两个不是已经把F(Z)和F(X)的通道都压缩到256了吗(假设输出分别为F’(Z)和F’(X)),这时,以F’(Z)的第i个通道为卷积核,对F’(X)的第i个通道进行卷积运算(i=1,2,3,…,256),得到的输出仍然为256个通道。以上我讲的就是对应DW-Corr_n的操作步骤。

最后DW-Corr_n的输出经过Box Head(或者Cls Head)运算(本质上也是卷积操作),得到了 B i B_i Bi 和 S i S_i Si ,关于他们两个是什么先放一边,一会儿解释。以上的操作总共进行了三次,每次的输入(绿色的F(Z)和紫色的F(X))都是来自主干网络的不同的层。 B i B_i Bi 和 S i S_i Si 一共有三组( B 1 , B 2 , B 3 和 S 1 , S 2 , S 3 B_1,B_2,B_3和S_1,S_2,S_3 B1,B2,B3和S1,S2,S3),最终的 B B B 由 B 1 , B 2 , B 3 B_1,B_2,B_3 B1,B2,B3 加权求和得到,同理, S S S 由 S 1 , S 2 , S 3 S_1,S_2,S_3 S1,S2,S3 加权求和得到,而且,他们加权求和的系数也是网络可以学习的。

B B B 对应结构图中的 BBox Regression, S S S 对应结构图中的CLS。

Experimental Results

4.1、Training Dataset and Evaluation

Training

我们的架构的骨干网络在ImageNet 上进行了预训练,用于图像标记,已经证明这是对其他任务的非常好的初始化。我们在COCO ,ImageNet DET ,ImageNet VID和YouTube-BoundingBoxes数据集的训练集上训练网络,并学习如何测量视觉跟踪的一般对象之间相似性的一般概念。在训练和测试中,我们使用单比例图像,其中127个像素用于模板区域,255个像素用于搜索区域。

Evaluation

我们专注于OTB2015 ,VOT2018 和UAV123 上的短时单目标跟踪。我们使用VOT2018-LT 来评估长时跟踪任务。

在长时跟踪中,物体可能长时间离开视野或完全遮挡,这比短期跟踪更具挑战性。我们还分析了我们的方法在 LaSOT 和TrackingNet 上的实验,这两个是最近才出现的单一目标跟踪的benchmarks。

4.2、Implementation Details

4.3、 Ablation Experiments

4.4、Comparison with the state-of-the-art

5、Conclusions

在本文中,我们提出了一个统一的框架,称为SiamRPN ++,用于端到端训练深度连体网络进行视觉跟踪。 我们展示了如何在孪生跟踪器上训练深度网络的理论和实证证据。 我们的网络由多层聚合模块组成,该模块组合连接层次以聚合不同级别的表示和深度相关层,这允许我们的网络降低计算成本和冗余参数,同时还导致更好的收敛。 使用SiamRPN ++,我们实时获得了VOT2018上最先进的结果,显示了SiamRPN ++的有效性。 SiamRPN ++还在La-SOT和TrackingNet等大型数据集上实现了最先进的结果,显示了它的泛化性。

172

172

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?