激活函数

激活函数在神经网络中起着非常重要的作用,它的主要功能是引入非线性性质,使得神经网络可以学习和表示更加复杂的模式和关系。下面是激活函数的几个主要作用:

- 引入非线性:激活函数通过引入非线性变换,打破了神经网络中仅由线性变换组成的限制。这是因为仅有线性变换的叠加还是等于一个线性变换,而非线性激活函数可以将多个线性变换叠加后转化为非线性。

- 增强网络的表达能力:激活函数使得神经网络能够学习和表示更加复杂的模式和关系。非线性激活函数可以引入非线性特征提取能力,帮助网络捕获数据中的非线性模式。

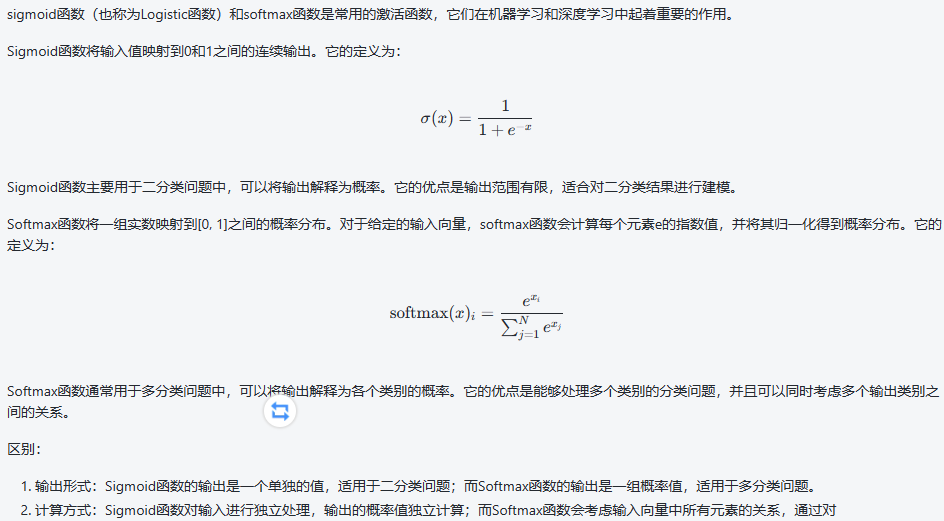

- 解决二分类问题:对于二分类问题,通常使用sigmoid激活函数。Sigmoid函数将输出值映射到[0,1]之间,可以解释为概率值,便于进行二分类。

- 解决多分类问题:对于多分类问题,通常使用softmax激活函数。Softmax函数将每个类别的原始分数转化为概率分布,方便进行多分类任务。

控制神经元的激活程度:激活函数可以控制神经元在不同输入值下的激活程度。例如,ReLU(Rectified Linear Unit)函数在输入大于零时被激活,而在输入小于等于零时被抑制。

需要注意的是,选择合适的激活函数对于神经网络的训练和性能非常重要。不同类型的激活函数适用于不同的问题,应根据具体情况进行选择。此外,还需要注意梯度消失和爆炸的问题,避免梯度无法传播或引起数值不稳定性。

sigmoid 和 softmax

5万+

5万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?