理论知识:

集成是合并多个机器学习模型来构建更强大模型法方法。

随机森林本质上是许多决策树的集合,其中每棵树都和其他数略有不同,随机森林背后的思想是:每棵树的预测可能都比较好,但是可能对部分数据过拟合,如果构造很多树,并且每棵预测的都很好,但都以不同的方式过拟合,那么可以对这些树的结果取平均来降低过拟合。

为了实现这一策略,需要构造很多决策树。每棵树都应该对目标值做出可以接受的预测,还应该与其他树不同。

随机森林中树的随机化方法有两周:一种是通过选择用于构造树的数据点,另一种是通过选择每次划分测试的特征。

想要构造一个随机森林模型,需要确定用于构造的树的个数。比如构造10棵树,这些树在构造时彼此完全独立,算法对这些树进行不同的随机选择,确保树和树之间是有区别的。想要构造一棵树,首先对数据进行自助采样。也就是说,从数据点中有放回的重复抽取样本,样本数与数据点数相同,这样会创建一个与原数据集相同大小的数据集,但是有些数据点会缺失或重复。

基于新数据集构造决策树,但是要对算法稍作修改。在每个叶结点处,算法随机选择特征的一个子集,并对其中一个特征寻找最佳测试,而不是对每个结点都寻找最佳测试。选择的特征个数由max_features参数来控制。每个结点中特征子集的选择是相互独立的,这样树的每个结点可以使用特征的不同子集来做出决策。

由于使用了自助采样,随机森林中构造每棵决策树的数据集都是略有不同的,由于每个结点的特征选择,每棵树的每次划分都是基于特征的不同子集。这两种方法共同确保了随机森林中每棵树都不相同。

构造过程中的一个关键参数是max_features,如果设置max_features=n_features,那么每次划分都要考虑数据集的所有特征,等于在特征选择过程中没有添加随机性,如果max_features=1,那么在划分时就无法选择对哪个特征进行测试,只能对随机选择的某个特征搜索不同的阈值。为了很好的拟合数据,每棵树的深度都要比较大。

想要利用随机森林进行预测,算法首先对森林中的每棵树进行预测,对于回归问题,可以对这些预测结果取均值作为最终结果,对于分类问题,可以采取“软投票”的方式取概率最大的结果作为最终的预测值。

分析随机森林:

import mglearn.plots

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import make_moons

from sklearn.model_selection import train_test_split

import matplotlib.pyplot as plt

plt.rcParams['font.sans-serif'] = ['SimHei']

X,y=make_moons(n_samples=100,noise=0.25,random_state=3)

X_train,X_test,y_train,y_test=train_test_split(X,y,stratify=y,random_state=42)

forest=RandomForestClassifier(n_estimators=5,random_state=2)

forest.fit(X_train,y_train)

fig,axes=plt.subplots(2,3,figsize=(20,10))

for i,(ax,tree) in enumerate(zip(axes.ravel(),forest.estimators_)):

ax.set_title('Tree {}'.format(i))

mglearn.plots.plot_tree_partition(X_train,y_train,tree,ax=ax)

mglearn.plots.plot_2d_separator(forest,X_train,fill=True,ax=axes[-1,-1],alpha=.4)

axes[-1,-1].set_title('随机森林')

mglearn.discrete_scatter(X_train[:,0],X_train[:,1],y_train)

plt.show()

可以看到,5棵树的决策边界大不相同,并且每棵树都犯了一些错误,因为有些训练点实际上没有包含在这些树的训练集里,这是自助采样的结果。

再构造一个包含100棵树的随机森林:

import mglearn.plots

from sklearn.ensemble import RandomForestClassifier

from sklearn.datasets import make_moons

from sklearn.model_selection import train_test_split

import matplotlib.pyplot as plt

from sklearn.datasets import load_breast_cancer

import numpy as np

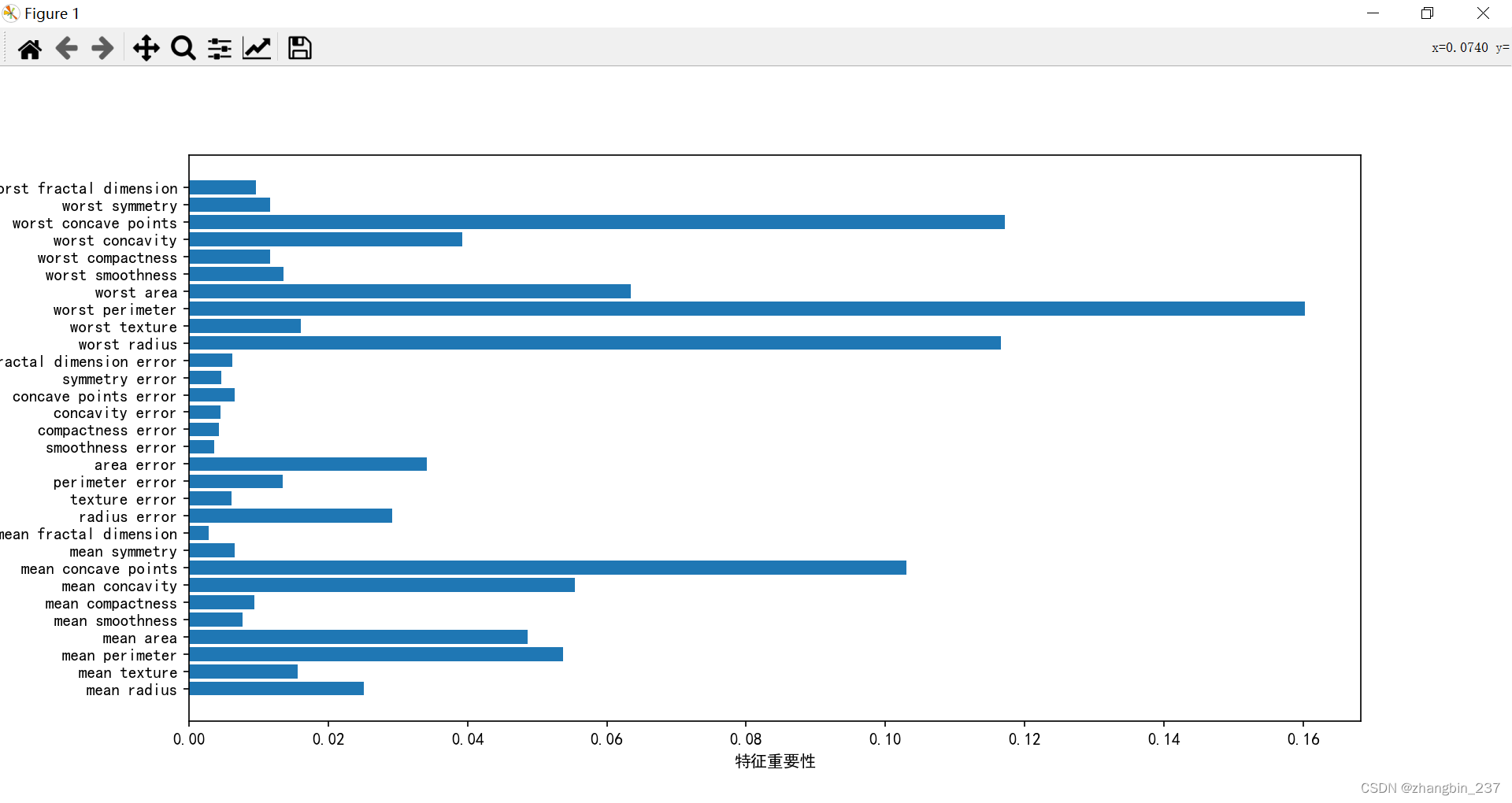

def plot_importances(model):

n_feature=cancer.data.shape[1]

plt.barh(range(n_feature),model.feature_importances_,align='center')

plt.yticks(np.arange(n_feature),cancer.feature_names)

plt.xlabel('特征重要性')

plt.ylabel('特征')

plt.rcParams['font.sans-serif'] = ['SimHei']

cancer=load_breast_cancer()

X_train,X_test,y_train,y_test=train_test_split(cancer.data,cancer.target,random_state=0)

forest=RandomForestClassifier(n_estimators=100,random_state=0)

forest.fit(X_train,y_train)

print('训练集特征:{:.3f}'.format(forest.score(X_train,y_train)))

print('测试集特征:{:.3f}'.format(forest.score(X_test,y_test)))

plot_importances(forest)

plt.show()

可以看到在没有任何参数的情况下,随机森林的精度为97.2%,比线性模型或单棵树都要好。可以通过调节max_feature参数进行调整,但是一般情况下,默认参数就已经可以给出很好的结果了。

特征重要性:

与单棵树相比,随机森林中有更多特征不为0,而且因为算法需要考虑多种可能的解释,随机森林比单棵树更能从总体上把握数据的特征。

随机森林的优缺点:

随机森林拥有决策树所有的优点,同时弥补了决策树的一些缺点随机森林的本质上是随机的,设置不同的随机状态可以彻底改变构建的模型,森林中的树越多,对随机状态选择的鲁棒性就越好,如果希望可以复现,固定random_state是很重要的。

对于维度非常高的稀疏数据,随机森林的表现往往不是很好,对于这种数据,用线性模型会更合适。随机森林需要更大内存,训练和预测的速度比线性模型要慢一些,所以如果时间和内存很重要,也可以选择线性模型。

随机森林需要调节的参数有n_estimators和max_features,可能还包括预剪枝选项(max_dept), n_estimators越大越好,但是越大需要的内存和时间也更多。

max_features决定每棵树的随机性大小,较小的max_features可以降低过拟合,一般来说,max_features使用默认值就很好,对于分类问题,默认值max_features=sqrt(n_features),对于回归来说,默认值max_features= n_features。

572

572

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?