orb的原理已经有很多博主已经解释过了,但是感觉大家都讲的很理论,有些具体的实现还是没有讲清楚,因此自己翻出了opencv的源码出来看。

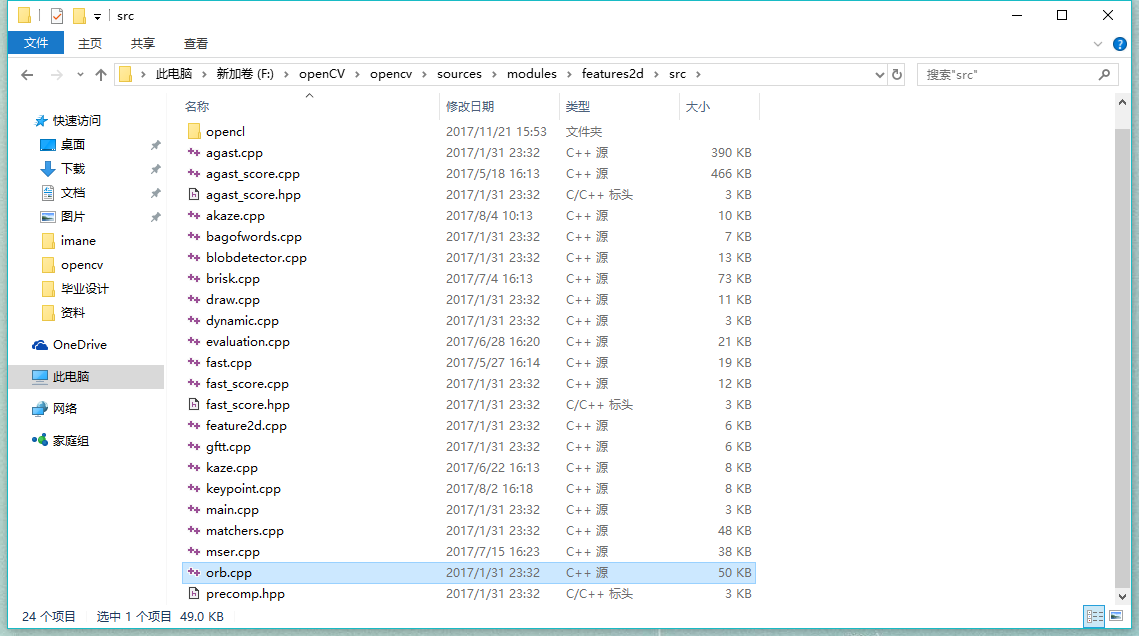

源码的位置如图:

看了好几天之后,才大概弄清楚了orb算法的具体实现是怎样的,画个流程图给你们看。

至于orb描述子的生成呢,它是有2点对比较,3点对和4点对比较三种生成方式,就是说每次可以在特征点的邻域内随机选取两个,三个或者四个点作为一组进行比较。对于最常用的两点对,比较的结果就是0或1,即1个比特,而描述子作为矩阵,存储的数据类型为8位无符号整数,因此是在一次循环中取16个点,按顺序为8组点对,得到八个比特即一个字节的比较结果,源码如下:

if( wta_k == 2 )

{

for (i = 0; i < dsize; ++i, pattern += 16)

{

int t0, t1, val;

t0 = GET_VALUE(0); t1 = GET_VALUE(1);

val = t0 < t1;

t0 = GET_VALUE(2); t1 = GET_VALUE(3);

val |= (t0 < t1) << 1;

t0 = GET_VALUE(4); t1 = GET_VALUE(5);

val |= (t0 < t1) << 2;

t0 = GET_VALUE(6); t1 = GET_VALUE(7);

val |= (t0 < t1) << 3;

t0 = GET_VALUE(8); t1 = GET_VALUE(9);

val |= (t0 < t1) << 4;

t0 = GET_VALUE(10); t1 = GET_VALUE(11);

val |= (t0 < t1) << 5;

t0 = GET_VALUE(12); t1 = GET_VALUE(13);

val |= (t0 < t1) << 6;

t0 = GET_VALUE(14); t1 = GET_VALUE(15);

val |= (t0 < t1) << 7;

desc[i] = (uchar)val;

}

}

而对于三点对和四点对,则是找出点对中最大的点的编号(1,2或3)/(1,2,3或4),因此结果为2个比特,故一次循环中取12或者16个点比较,从而得到8比特即一字节的描述子,源码中表述如下(3点对的就不贴了,反正是一个意思):

else if( wta_k == 4 )

{

for (i = 0; i < dsize; ++i, pattern += 16)

{

int t0, t1, t2, t3, u, v, k, val;

t0 = GET_VALUE(0); t1 = GET_VALUE(1);

t2 = GET_VALUE(2); t3 = GET_VALUE(3);

u = 0, v = 2;

if( t1 > t0 ) t0 = t1, u = 1;

if( t3 > t2 ) t2 = t3, v = 3;

k = t0 > t2 ? u : v;

val = k;

t0 = GET_VALUE(4); t1 = GET_VALUE(5);

t2 = GET_VALUE(6); t3 = GET_VALUE(7);

u = 0, v = 2;

if( t1 > t0 ) t0 = t1, u = 1;

if( t3 > t2 ) t2 = t3, v = 3;

k = t0 > t2 ? u : v;

val |= k << 2;

t0 = GET_VALUE(8); t1 = GET_VALUE(9);

t2 = GET_VALUE(10); t3 = GET_VALUE(11);

u = 0, v = 2;

if( t1 > t0 ) t0 = t1, u = 1;

if( t3 > t2 ) t2 = t3, v = 3;

k = t0 > t2 ? u : v;

val |= k << 4;

t0 = GET_VALUE(12); t1 = GET_VALUE(13);

t2 = GET_VALUE(14); t3 = GET_VALUE(15);

u = 0, v = 2;

if( t1 > t0 ) t0 = t1, u = 1;

if( t3 > t2 ) t2 = t3, v = 3;

k = t0 > t2 ? u : v;

val |= k << 6;

desc[i] = (uchar)val;

}

}static int bit_pattern_31_[256*4]copyMakeBorder(currImg, extImg, border, border, border, border,

BORDER_REFLECT_101+BORDER_ISOLATED);

2764

2764

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?