实时语音交互中文基准12月测评结果出炉,4大维度15项能力8款应用,讯飞星火领跑,国内产品延时、打断和场景应用表现出色

原创 SuperCLUE CLUE中文语言理解测评基准 2024年12月24日 14:03 浙江

SuperCLUE团队

2024/12

背景

中文原生实时语音交互测评基准(SuperCLUE-Voice)旨在深入评估新一代实时语音交互产品在中文语音交互中的整体表现。该基准不仅全面考察产品在打断、说话风格等语音交互核心能力上的表现,还重点评估其在记忆能力、联网能力等通用能力上的综合水平。同时,测评还特别关注产品在实时翻译、教育辅导等五大实际应用场景中的表现,旨在为语音交互技术的多场景落地提供全面的评判标准。

本次我们针对国内外8款代表性实时交互产品进行了全面评测,以下为详细测评报告。

![]()

测评核心内容摘要

摘要1:国内头部产品在实时中文语音综合能力表现上有一定领先性。

测评结果显示,实时语音产品总体表现差异较大,分层现象明显。国内头部产品在实时中文语音能力上表现领先,讯飞星火综合表现最强,位居第一,海外产品ChatGPT-4o紧随其后,国内的豆包与海螺AI也表现不俗,展现了各自的优势。

摘要2:语音交互能力上,ChatGPT-4o在说话风格方面有较大的领先性,打断能力和语音自然度方面国内产品表现较好。

在语音交互方面,ChatGPT-4o在说话风格上保持领先,国内产品在打断能力和语音自然度上占优势,尤其是讯飞星火的语音自然度达到90分以上。

摘要3:通用能力方面,国内实时语音产品占有一定的领先优势。

国内实时语音产品在通用能力上具有领先优势,文小言在安全和记忆能力方面表现突出,Kimi在推理任务中表现较好,但国内产品在联网能力上普遍较弱,亟待改善。

摘要4:在中文场景应用方面,国内实时语音产品依然保持较好的表现。

国内语音产品在中文场景应用中仍具优势,通义在场景应用上领先,得分突破70分,其他国内产品得分均超过60分,整体表现较9月有所提升。

#榜单概览

目录

一、SuperCLUE-Voice基准介绍

1. 基准测评体系

2. 测评方法、评价标准及示例说明

二、测评结果

1. 测评产品列表

2. 中文实时语音基准总榜

3. SuperCLUE-AI产品象限(实时语音)

4. 二级细粒度任务测评结果总表

5. SuperCLUE-Voice能力分布图

6. 一级维度测评结果

1)语音交互榜单

2)通用能力榜单

3)场景应用榜单

4)响应速度榜单

7. 评测与人类一致性验证

三、测评对比示例

四、分析与结论

五、测评邀请

正文

一、SuperCLUE-Voice基准介绍

中文语言理解测评基准CLUE(The Chinese Language Understanding Evaluation)发起于2019年,已陆续推出CLUE、FewCLUE、ZeroCLUE、KgCLUE、DataCLUE、SuperCLUE等广为引用的AI测评基准。

SuperCLUE是大模型时代CLUE基准的发展和延续。聚焦于通用大模型的综合性测评,致力于精准量化通用人工智能AGI进展。

1. SuperCLUE-Voice基准体系

SuperCLUE-Voice是专为中文设计的多模态实时语音交互产品测评基准,旨在为中文领域提供全面的实时语音产品多维能力评估参考。

2. 测评方法及评价标准说明

1)测评方法

参考SuperCLUE细粒度评估方式,构建专用测评集,每个维度进行细粒度的评估并可以提供详细的反馈信息。

![]()

a)测评集构建

中英文实时对话材料构建流程:1.参考现有相关任务的提示词(Prompt)—>2.根据任务特点,撰写专项提示词(Prompt) —>3.调用语音合成(TTS)模型生成对话材料—>4.测试验证—>5.修改并确定最终中英文测评提示词(Prompt)—>6.针对每个维度构建专用的测评集—>7.调用语音合成(TTS)模型生成完整的音频对话测评集。

![]()

b)测评过程

在相同设备和网络环境下,使用同一语音合成(TTS)模型生成的音频对话测评集,对每个产品进行对话测试,统一执行测评并生成对话录音文件。

![]()

c)评分过程

1.获得录制好的对话材料-->2.依据评估标准-->3.使用评分规则-->4.进行细粒度打分;

结合超级模型,在定义的指标体系里明确每一个维度的评估标准。结合评估流程、评估标准、评分规则,将文本和文件传给超级模型进行评估,并获得每一个维度的评估结果。

![]()

d)人类一致性分析

对自动化测评结果进行评估,与人类评价的一致性对比,并报告一致性表现。

2)评价方法与标准

a. 自动评价计算方法及示例

在每个二级维度下,都有相应的评分标准。将对话材料传递给Gemini-1.5-Pro,为该维度的每一项评价指标进行评分,并计算每项指标得分的平均值,最终得出此任务的总体评分。

【示例】场景应用-实时翻译

语音Prompt:

第一轮:请你待会儿将我说的话,翻译成英语说出。

第二轮:改革开放以来,中国人民生活水平不断提升,这在人们的饮食变化上得到充分体现。

,时长00:39

超级模型(Gemini-1.5-Pro)裁判:

----------评分开始----------

我的思考与答案:用户要求 AI 助手将中文翻译成英文。AI 助手准确识别了用户的请求,并将用户所说的中文「改革开放以来,中国人民生活水平不断提升,这在人们的饮食变化上得到充分体现。」翻译成了英文「Since the reform and opening up, the living standards of the Chinese people have been continuously improving, which is fully reflected in the changes in people's diets.」。

问题及改进的反馈意见:AI 助手的翻译速度较慢,可以考虑优化翻译速度。

1.多语言能力:AI 助手能够准确识别用户指定的翻译语言,并用英文进行翻译,符合用户要求。得分:5分

2.翻译准确性:AI 助手将中文准确翻译成英文,语义一致,没有出现翻译错误。得分:5分

3.翻译流畅度:AI 助手翻译的英文语句流畅自然,符合英语表达习惯。得分:5分

综合以上,AI助手的综合得分(平均分)为(5 + 5 + 5) / 3 = [[5.00]]

----------评分结束----------

b. 响应延时测算方法及示例

用户会话的结束时间(记为user_end_time)为开始时间,和AI助手响应会话的开始时间(记为AI_start_time)为结束时间,取这一段的时间间隔作为响应延迟。(我们没有扣除基础网络延迟,因为测评在相同的设备和网络环境中进行,以更真实地反映用户的体验。)具体计算方式如下:

响应延迟 = AI_start_time - user_end_time

下面是计算延迟的示例:

,时长00:24

响应延迟计算示例:参考上文对响应延迟的定义,在本视频中,我们截取了一段可测量的时间戳间隔,分别位于[10760],[12350](单位为毫秒),分别计算其间隔,求得响应延迟为1590毫秒。

响应延时总分计算:

我们从每个产品中同批次挑选对话次数较多的任务类型,并抽取其中15%的实时对话样本,来获取所有交互的响应延迟,最终计算出平均响应时间。

通过设定延迟阈值,将延迟小于或等于300毫秒(这一阈值通常被认为是用户几乎察觉不到延迟的界限,能够保证流畅的交互体验)的产品评分为100分,而延迟大于或等于5000毫秒的产品评分为0分。对于介于这两个值之间的延迟,根据其在阈值范围内的位置计算出一个比例得分,从而实现评分的线性分布。

计算代码示例:

# 定义产品名称和对应的延迟(毫秒)product_data = {"ChatGPT-4o(高级语音)": 1939.44,"海螺AI(实时语音)": 2143.78,"讯飞星火(实时语音)": 1621.44,"豆包(实时语音)": 2044.78,"智谱清言(实时语音)": 3433.11,"通义(实时语音)": 4332.00,"文小言(实时语音)": 6623.67,"Kimi(实时语音)": 3614.78}# 定义延迟阈值min_latency = 300 # 满分阈值,延迟小于或等于此值得100分max_latency = 5000 # 零分阈值,延迟大于或等于此值得0分# 计算每个产品的得分scores = {}for product, latency in product_data.items():if latency <= min_latency:score = 100elif latency >= max_latency:score = 0else:score = (max_latency - latency) / (max_latency - min_latency) * 100scores[product] = score# 输出结果for product, score in scores.items():print(f"{product}: {score:.2f} 分")

c. 打断延时测算方法及示例

用户尝试中断当前会话的时间点(记为user_start_time)为用户开始打断时间,和AI助手停止当前响应的时间点(记为AI_end_time)为AI助手响应停止时间,取这一段的时间间隔作为打断延迟。具体计算方式如下:

打断延迟 = AI_end_time - user_start_time;

下面是打断延迟的示例:

,时长00:24

参考上文对打断延迟的定义,在本视频中,我们截取用户开始打断时间为8464ms(user_start_time),AI助手响应停止时间为9286ms(AI_end_time)。根据公式计算,求得打断延迟为822ms。

最终打断延时总分计算:

针对打断任务,获取每个产品所有交互的打断延迟,最终分别计算出每个产品的平均打断延迟。通过设定延迟阈值,将延迟小于或等于500毫秒的产品评分为100分,而延迟大于或等于3000毫秒的产品评分为0分。对于介于这两个值之间的延迟,根据其在阈值范围内的位置计算出一个比例得分,从而实现评分的线性分布。

二、SuperCLUE-Voice测评结果

1. 测评产品列表

本次测评实时语音交互产品,选取了国内外有代表性的8个实时语音交互产品在12月份的版本。

本次测评海外产品GPT-4o(高级语音)是ChatGPT产品中的GPT-4o高级语音模式,为了更有区分性,测评报告中均统称为GPT-4o高级语音。

2.中文实时语音测评基准总榜

3.SuperCLUE-AI产品象限

基于大模型在基础能力和应用能力的表现,本次共有8个国内实时语音交互产品入选SuperCLUE-AI产品象限。

4.细粒度任务测评结果总表

5.SuperCLUE-Voice能力分布图

6.一级维度榜单

1)语音交互榜单

2)通用能力榜单

3)场景应用榜单

4)响应速度榜单

7.评测与人类一致性分析

为确保大模型自动化测评的科学性,我们对Gemini-1.5-Pro在实时交互语音评价任务中进行了人类一致性评估,以此来确保评估的合理性与准确性。

具体操作方法:抽取4个产品,按每个维度进行分层抽样,对各产品对应的共100个任务输出答案的质量进行人工评价,并与超级大模型的评分进行比较,考察Gemini-1.5-Pro评价与真实情况的吻合度,进行相关性计算,得到皮尔逊相关系数:0.98,P值:2.07e-02;斯皮尔曼相关系数:1.00;说明SuperCLUE-Voice基准测评的成绩,与人类对模型的评估,具有高度一致性。

最终得到的人类一致性评估结果(合格率)如下:

四、测评对比示例

示例1:语音交互-打断

Prompt:

第一轮:请问吃坚果对身体有害吗?

第二轮:不是,我问的是有什么好处吗?

讯飞星火示例

,时长00:23

打断延时:9601 ms(AI_end_time)- 9283ms(user_start_time)= 318 ms

Kimi示例

,时长00:27

打断延时:13564 ms(AI_end_time)- 11559 ms(user_start_time)= 2005 ms

示例2:语音交互-说话风格

Prompt:

第一轮:请你用“五花八门”这个词简单的造一个句子,语速要快一点。

第二轮:语速再快一点。

第三轮:再快一点。

ChatGPT-4o示例:较好的按照指令风格完成任务。

得分:5分

,时长00:24

文小言的示例:未遵循指令,有一定优化空间

得分:1分

,时长00:35

示例3:语音交互-说话风格

Prompt:你有1000公斤蘑菇,含水量是99%。现在晒几天,晒到含水量为98%,那需要晒掉多少水?

参考答案:500公斤

Kimi示例:推理过程正确,推理出的答案也正确。

得分:4.67分

,时长00:46

示例4:通用能力-记忆能力

Prompt:

第一轮:明天早上我需要到学校进行展示,展示前我应该如何确保展示时不会出错?

第二轮:上午展示完以后,我想先复习上周课上学到的知识,中午自己煮午餐,你觉得我应该煮什么才能确保营养均衡。

第三轮:吃完午饭后继续上午的复习,大约4点左右就去做运动,请问饭前做运动对身体有什么影响吗?

第四轮:根据刚刚的对话,请简单地叙述我明天一整天的行程安排。

得分:4.5分

海螺AI示例

,时长01:40

示例5:场景应用-实时翻译

Prompt:

第一轮:请你待会儿将我说的话,翻译成汉语说出。

第二轮:I’m flexible with the timing, so let me know what works for you.

得分:5分

ChatGPT-4o示例

,时长00:19

四、分析与结论

1.国内头部产品在实时中文语音综合能力表现上有一定领先性。

测评结果显示,实时语音产品总体表现差异较大,分层现象明显。其中讯飞星火(76.18分)综合能力表现出色,领跑SuperCLUE-Voice基准。海外产品ChatGPT-4o高级语音位列第二,稍落后于讯飞星火。国内产品中,紧随其后的豆包与海螺AI表现同样不俗,在具体任务上都有着各自的特点和优势。

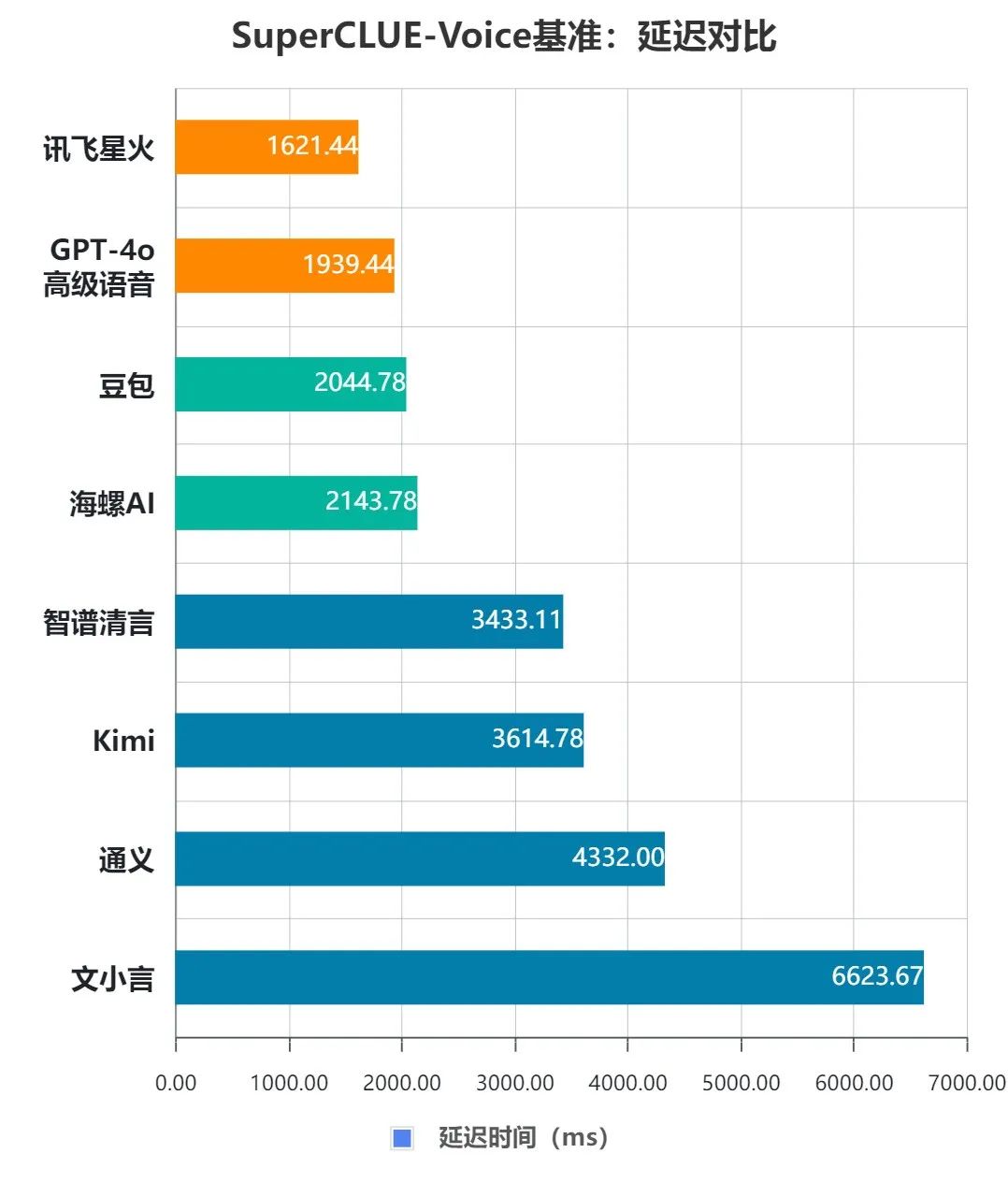

2.语音响应速度方面国内头部产品仍然保持一定优势。

数据来源:SuperCLUE,12月24日;当前延迟时间包括网络延迟,所有测评交互均在相同网络环境、相同时间周期内进行。

与九月份的测评相比,由于更换了测评设备,所有产品的平均延时整体有所增加。

根据本次测评结果的延迟时间数据,不同实时语音产品的响应速度差异较为明显。表现最为优异的是讯飞星火,平均延时为1621.44ms,处于领先地位;豆包和海螺的表现也较为出色,平均响应时间均控制在2200ms以内。

在被测产品中,文小言的延迟较为显著,其平均延时超过6秒。响应时间是实时语音交互产品体验中的关键因素,SuperCLUE将继续跟踪国内实时语音产品在响应速度方面的表现。

3.语音交互能力上,ChatGPT-4o在说话风格方面有较大的领先性,打断能力和语音自然度方面国内产品表现较好。

在中文实时语音交互环境下,ChatGPT-4o在说话风格方面依然保持一定的领先性,虽然国内产品要比9月份的测评有较显著的进步,但与ChatGPT-4o相比还是有一定的优化空间;相对的在语音自然度方面,国内模型占有较大的优势,其中讯飞星火的得分是唯一超过90分的产品,语音自然度高度拟人;豆包和海螺AI的表现也不俗,得分均在80分以上。

与9月份测评相比,国内实时语音产品在打断任务上也有所突破;讯飞星火的表现惊艳,成为唯一进入500ms的实时语音产品。

4.通用能力方面,国内实时语音产品占有一定的领先优势,其中文小言在特定任务上的表现较为亮眼,通义和Kimi的表现较为稳定。

在通用能力维度上,文小言表现出色,尤其在传统安全方面,凭借其出色的敏感话题识别能力,成为唯一突破90分的产品。指令遵循方面,Kimi和文小言的表现均较为优异。记忆能力方面,文小言的表现最佳,通义和Kimi也表现不俗。Kimi在推理能力的测评任务中表现较为突出。然而,在联网能力方面,国内产品的得分普遍低于70分,表明联网搜索能力和范围仍然有限,亟需进一步优化。

5.在中文应用场景方面,国内产品依然保持较好的表现,其中通义领跑实时语音场景应用。

在场景应用方面,国内实时语音产品展现出了较强的落地能力。其中,通义表现出一定的领先优势,以72.76分成为唯一突破70分的产品,其他国内产品的得分均超过60分,相比9月份的测评也有所进步。文小言的表现则较为平淡,其回答质量还有优化空间。

在场景应用的各个二级维度排名中,通义在实时翻译、情感咨询、健康咨询和购物客服等方面均获得了第一名,展现出一定的领先优势;文小言则在教育辅导任务中表现更为突出;在健康咨询方面,Kimi和豆包的表现也不容忽视。

五、测评邀请

参与流程

1. 邮件申请

2. 意向沟通

3. 参测确认与协议流程

4. 提供测评产品

5. 公开测评报告

5031

5031

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?