[论文笔记] ResNet:Deep Residual Learning for Image Recognition

说在前面

个人心得:

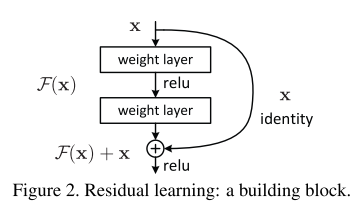

1. 学习残差比学习一个未知的函数要容易

2. 残差块的构造和改进为bottleneck的设计

3. ResNet-50、ResNet-101和ResNet-151的结构

4. 在复现过程中,发现ResNet的没有bias

CVPR 2016,原文链接:https://arxiv.org/abs/1512.03385

本文作于2020年3月25日。

1、摘要

Deeper neural networks are more difficult to train. We present a residual learning framework to ease the training of networks that are substantially deeper than those used previously. We explicitly reformulate the layers as learning residual functions with reference to the layer inputs, instead of learning unreferenced functions. We provide comprehensive empirical evidence showing that these residual networks are easier to optimize, and can gain accuracy from considerably increased depth.

深度神经网络很难训练。我们提出了一种学习残差的框架,以简化比以前使用的网络更深的网络的训练。我们明确定义了学习残差函数,而不是学习未知的函数。我们提供了全面的经验证据,表明这些残差网络更易于优化,并且可以通过大大增加的深度来获得准确性。

On the ImageNet dataset we evaluate residual nets with a depth of up to 152 layers—8× deeper than VGG nets but still having lower complexity. An ensemble ofthese residual nets achieves 3.57% error on the ImageNet test set. This result won the 1st place on the ILSVRC 2015 classification task. We also present analysis on CIFAR-10 with 100 and 1000 layers.

在ImageNet数据集上,我们测试152层的ResNet(残差网络),这比传统的VGG深尽8倍,但仍然保持较低的复杂度。这些ResNet的整体在ImageNet测试集上实现了3.57%的误差。该结果在ILSVRC 2015分类任务中获得第一名。我们分析了在CIFAR-10上100层和1000层的模型的不同。

The depth of representations is of central importance for many visual recognition tasks. Solely due to our extremely deep representations, we obtain a 28% relative improvement on the COCO object detection dataset. Deep residual nets are foundations ofour submissions to ILSVRC & COCO 2015 competitions1, where we also won the 1st places on the tasks ofImageNet detection, ImageNet localization, COCO detection, and COCO segmentation.

深度对于许多视觉识别任务至关重要。仅依靠我们的深度改变,就在COCO对象检测数据集上获得了28%的相对提升。Deep ResNet是我们向ILSVRC和COCO 2015提交的基础,在这些竞赛中,我们还获得了ImageNet detection,ImageNet localization,COCO detection和COCO segmentation等任务的第一名。

2、前言

深度卷积神经网络为图像分类带来了一系列突破。深度神经网络集成了低/中/高层次的特征,可以被端到端训练,特征的层次可以通过网络的深度来丰富。有研究证明深度对网络至关重要,在ImageNet的竞赛中也有一系列很深的模型被使用。

深度的重要性也带来一系列问题:是否层数也多网络模型就越容易被训练呢?梯度损失和梯度爆炸从源头上阻止了这一切。但是,此问题已通过归一化初始化层和中间归一化层得到了很大程度上地解决,这使具有数十个层的网络能够通过反向传播开始收敛用于随机梯度下降(SGD)。

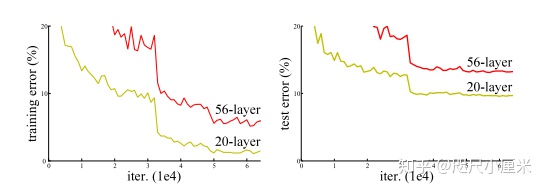

当更深的网络开始收敛,退化问题就出现了:随着网络深度的增加,准确度会达到饱和,急速退化。出乎意料的是,这种退化不是由过拟合造成的,将更多的层加到模型中会导致更高的训练误差。

训练准确率的下降表明,不是所有系统都同样容易优化。让我们考虑一个较浅的结构和一个较深的结

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5085

5085

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?