概述

- 从表格或图像数据中提取特征的方法已经众所周知了,但是图(数据结构的图)数据呢?

- 学习如何使用DeepWalk从图中提取特征

- 我们还将用Python实现DeepWalk来查找相似的Wikipedia页面

介绍

我被谷歌搜索的工作方式迷住了。 每次我搜索一个主题都会有很多小问题出现。 以“人们也在搜索?”为例。 当我搜索一个特定的人或一本书,从谷歌我总是得到与搜索内容类似的建议。 例如,当我搜索“Lewis Hamilton”时,我得到了其他著名f1车手的名单:

目录

数据的图示

不同类型的基于图的特征

节点属性

局部结构特征

节点嵌入

DeepWalk简介

在Python中实施DeepWalk以查找相似的Wikipedia页面

数据的图示

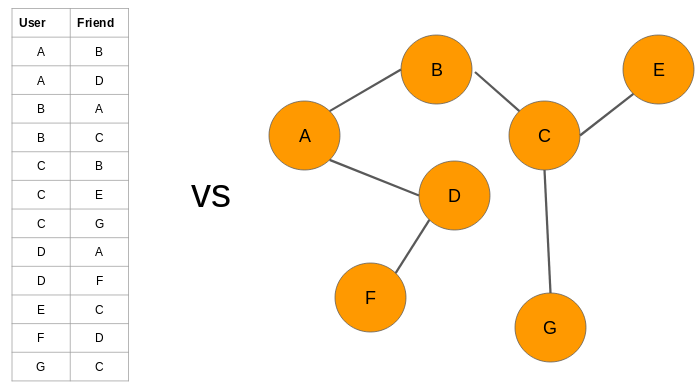

当你想到“网络”时,会想到什么? 通常是诸如社交网络,互联网,已连接的IoT设备,铁路网络或电信网络之类的事物。 在图论中,这些网络称为图。网络是互连节点的集合。节点表示实体,它们之间的连接是某种关系。

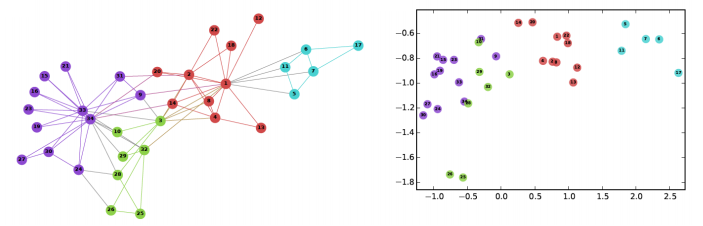

例如,我们可以用图的形式表示一组社交媒体帐户:

为什么我们将数据表示为图?

为什么不仅仅使用典型的数据可视化技术来可视化数据? 为什么要更复杂并学习新概念? 下面我们会给出答案。 图数据集和数据库可帮助我们应对在处理结构化数据时面临的若干挑战。 这就是为什么当今的主要科技公司,例如Google,Uber,Amazon和Facebook使用某种形式的图的原因。 让我们以一个例子来理解为什么图是数据的重要表示形式。 看下图:

基于图的特征的不同类型

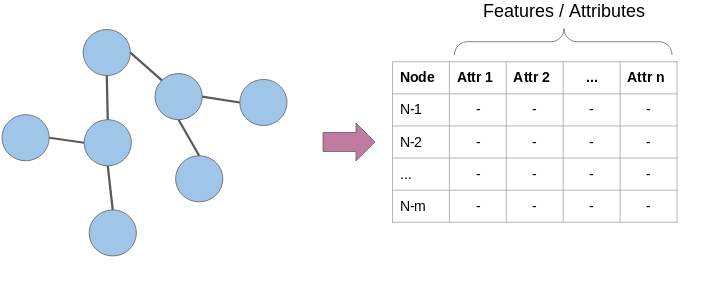

为了解决上述问题,我们无法将图直接提供给机器学习模型。 我们必须首先从中创建特征,然后模型将使用这些特征。 此过程类似于我们在自然语言处理(NLP)或计算机视觉中所做的过程。 我们首先从文本或图像中提取数字特征,然后将这些特征作为输入提供给机器学习模型:

- 节点属性:我们知道图中的节点代表实体,并且这些实体具有自己的特征属性。我们可以将这些属性用作每个节点的特征。例如,在航空公司航线网络中,节点将代表机场。这些节点将具有飞机容量,航站楼数量,着陆区等特征。2.局部结构特点:节点的度(相邻节点的数量),相邻节点的平均度,一个节点与其他节点形成的三角形数,等等。

- 节点嵌入:上面讨论的特征仅包含与节点有关的信息。它们不捕获有关节点上下文的信息。在上下文中,我指的是周围的节点。节点嵌入通过用固定长度向量表示每个节点,在一定程度上解决了这个问题。这些向量能够捕获有关周围节点的信息(上下文信息)

DeepWalk简介

要了解DeepWalk,重要的是要正确理解词嵌入及其在NLP中的使用方式。 我建议在下面的文章中仔细阅读Word2Vec的解释: https://www.analyticsvidhya.com/blog/2019/07/how-to-build-recommendation-system-word2vec-python/?utm_source=blog&utm_medium=graph-feature-extraction-deepwalk 为了将事物置于上下文中,词嵌入是文本的向量表示形式,它们捕获上下文信息。 让我们看看下面的句子:- 我乘巴士孟买

- 我乘火车去孟买

什么是随机游走?

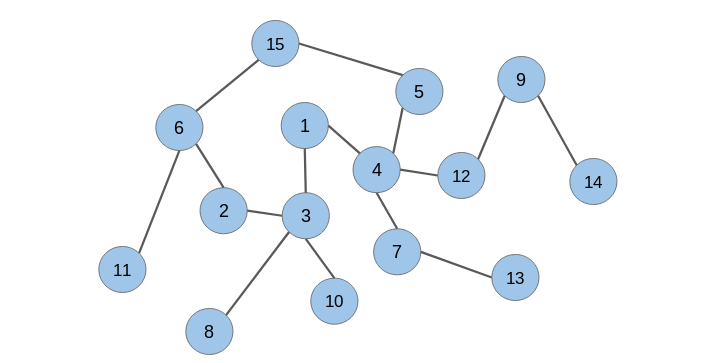

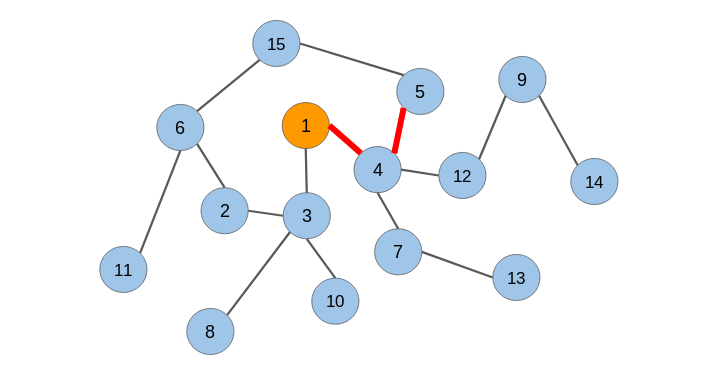

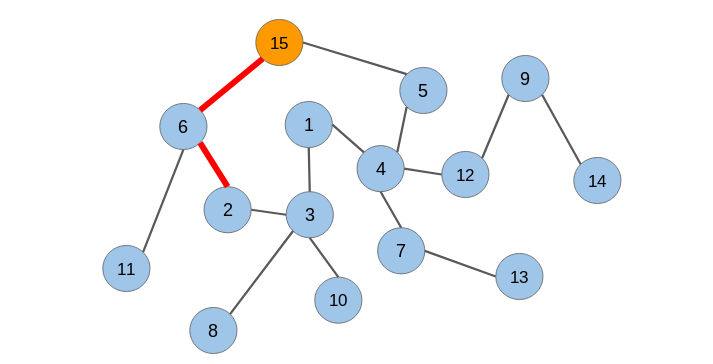

让我说明一下随机游走的工作原理。 让我们考虑下面的无向图:随机游走是一种从图中提取序列的技术。我们可以使用这些序列来训练一个skip-gram模型来学习节点嵌入。

在下一节中,我们将在Wikipedia文章网络上从头开始实施DeepWalk。在生成节点序列之后,我们必须将它们提供给一个skip-gram模型以获得节点嵌入。整个过程被称为Deepwalk。

在Python中实施DeepWalk以查找相似的Wikipedia页面

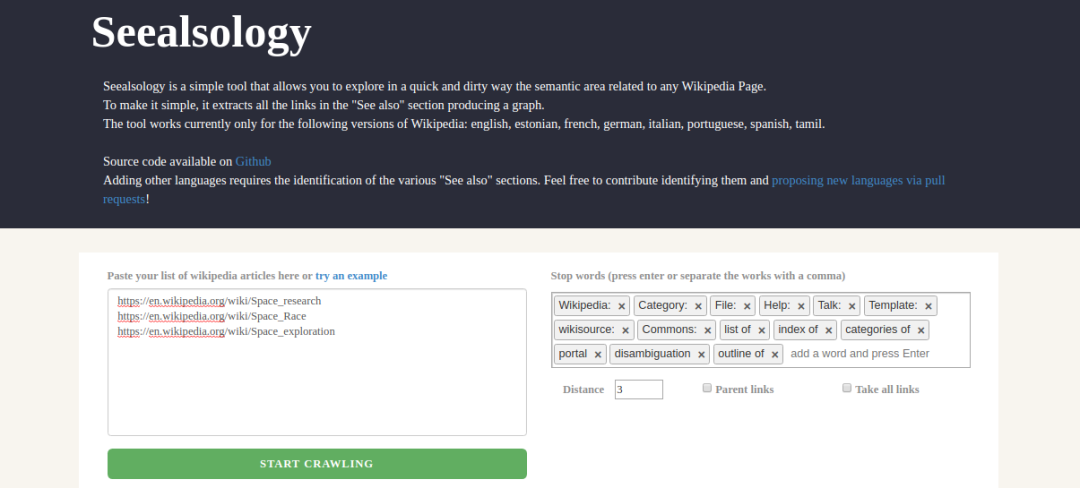

这将是本文中最令人兴奋的部分,尤其是如果你喜欢代码。 因此,请启动这些Jupyter notebook! 我们将使用Wikipedia文章图,并使用DeepWalk从中提取节点嵌入。 然后,我们将使用这些嵌入来查找相似的Wikipedia页面。 我们不会触及这些文章中的任何文本。 我们的目标是纯粹基于图的结构来计算页面之间的相似度。 但是,等等。 我们如何以及在何处获得Wikipedia图数据集? Seealsology这个出色的工具将为我们提供帮助。 这有助于我们从任何Wikipedia页面创建图。 你甚至可以提供多个Wikipedia页面作为输入。 这是该工具的屏幕截图:

- 如果有数百万个节点,那么我们需要大量的计算能力来解析文本并从所有这些节点或页面中学习词嵌入

- 这种方法不会捕获这些页面之间连接的信息。例如,一对直接连接的页面可能比一对间接连接的页面具有更强的关系

导入所需的Python库

import networkx as nximport pandas as pdimport numpy as npimport randomfrom tqdm import tqdmfrom sklearn.decomposition import PCAimport matplotlib.pyplot as plt%matplotlib inline加载数据集

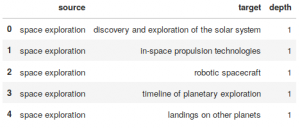

你可以从这里下载.tsv文件: https://s3-ap-south-1.amazonaws.com/av-blog-media/wp-content/uploads/2019/11/space_data.zipdf = pd.read_csv("space_data.tsv", sep = "\t")df.head()Output:

构造图

G = nx.from_pandas_edgelist(df, "source", "target", edge_attr=True, create_using=nx.Graph())让我们检查图中的节点数:

len(G)Output: 2088

我们将处理2,088个Wikipedia页面。

随机游走

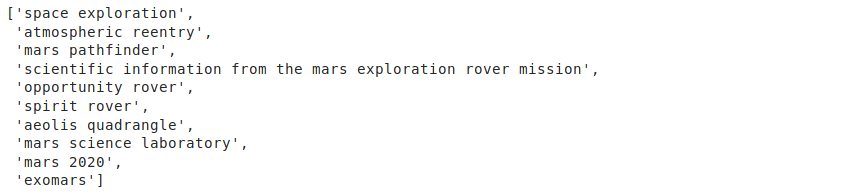

在这里,我定义了一个函数,将节点和被遍历的路径的长度作为输入。 它将从指定的输入节点以随机的方式穿过连接节点。 最后,它将返回遍历节点的顺序:def get_randomwalk(node, path_length): random_walk = [node] for i in range(path_length-1): temp = list(G.neighbors(node)) temp = list(set(temp) - set(random_walk)) if len(temp) == 0: break random_node = random.choice(temp) random_walk.append(random_node) node = random_node return random_walk让我们来试试节点“space exploration”这个函数:

get_randomwalk('space exploration', 10)输出:

# 从图获取所有节点的列表all_nodes = list(G.nodes())random_walks = []for n in tqdm(all_nodes): for i in range(5): random_walks.append(get_randomwalk(n,10))# 序列个数len(random_walks)# importing required librariesimport pandas as pdimport networkx as nximport numpy as npimport randomfrom tqdm import tqdmfrom sklearn.decomposition import PCAimport pprintfrom gensim.models import Word2Vecimport warningswarnings.filterwarnings('ignore')# read the datasetdf = pd.read_csv("space_data.tsv", sep = "\t")print(df.head())G = nx.from_pandas_edgelist(df, "source", "target", edge_attr=True, create_using=nx.Graph())G = nx.from_pandas_edgelist(df, "source", "target", edge_attr=True, create_using=nx.Graph())print('The number of nodes in pur graph: ',len(G))def get_randomwalk(node, path_length): random_walk = [node] for i in range(path_length-1): temp = list(G.neighbors(node)) temp = list(set(temp) - set(random_walk)) if len(temp) == 0: break random_node = random.choice(temp) random_walk.append(random_node) node = random_node return random_walkprint('\n\nRandom sequence of nodes generated from Random Walk\n\n')while True: first_node = input("Enter name of first node (for example 'space exploration') : ") if len(first_node) > 0: breakpprint.pprint(get_randomwalk(first_node, 10))# 从图中获取所有节点的列表all_nodes = list(G.nodes())random_walks = []for n in tqdm(all_nodes): for i in range(5): random_walks.append(get_randomwalk(n,10)) # 序列长度len(random_walks)# 训练skip-gram (word2vec)模型model = Word2Vec(window = 4, sg = 1, hs = 0, negative = 10, # 负采样 alpha=0.03, min_alpha=0.0007, seed = 14)model.build_vocab(random_walks, progress_per=2)model.train(random_walks, total_examples = model.corpus_count, epochs=20, report_delay=1)print('\n\n Get similar nodes\n\n')while True: any_node = input("Enter name of any node (for example 'space toursim') : ") if len(any_node) > 0: breakpprint.pprint(model.similar_by_word(any_node))结尾

我真的很喜欢在本文中探索DeepWalk中的图形数据,我迫不及待地想尝试其他图形算法。 在接下来的几周里,继续关注这个系列吧! 我鼓励你实施此代码,试用它,并建立自己的图模型。这是学习任何概念的最佳方法。完整的代码在这里: https://github.com/prateekjoshi565/DeepWalk 。关于深度传送门

深度传送门是一个专注于深度推荐系统与CTR预估的交流社区,传送推荐、广告以及NLP等相关领域工业界第一手的论文、资源等相关技术分享,欢迎关注!加技术交流群请添加小助手deepdeliver,备注姓名+学校/公司+方向。

5283

5283

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?