引言

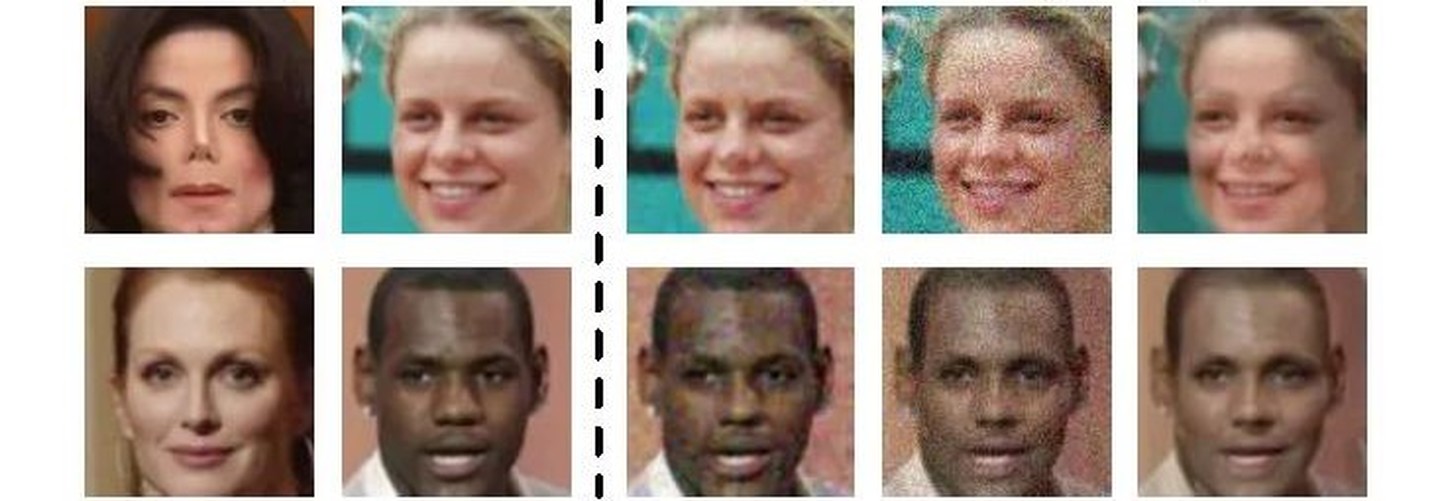

针对当前的深度神经网络在人脸识别方面的应用,存在很多不安全的隐患,作者提出了一种针对深度神经网络的黑盒攻击攻击方法,提出了一种新的基于遗传算法的攻击方法,数据集:Wild (LFW) and MegaFace实验结果表明:

这种攻击方法即使在限制对模型的查询次数也很有效,并且将其用于真实的人脸识别环境中,也攻击成功了。

1、介绍

本文的主要贡献

(1)提出了一个在基于决策的黑盒场景下的进化攻击方法,可以对搜索方向的局部几何进行建模,同时降低搜索空间的维度。

(2)利用基于决策的黑盒攻击方法,对几种最先进的人脸识别模型(SphereFace, CosFace, ArcFace)做了鲁棒性测评,并展示了这些人脸模型的脆弱性。

(3)通过对真实世界中的人脸识别系统进行攻击,展示了提出的方法的实际适用性

2、Background and related work

2.1 人脸识别

人脸识别中有两个子任务:

(1) face verification:人脸配对

(2)face identification:人脸匹配当前常见的人脸识别网络

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

6915

6915

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?