大家好,我是木易,一个持续关注AI领域的互联网技术产品经理,国内Top2本科,美国Top10 CS研究生,MBA。我坚信AI是普通人变强的“外挂”,专注于分享AI全维度知识,包括但不限于AI科普,AI工具测评,AI效率提升,AI行业洞察。关注我,AI之路不迷路,2024我们一起变强。

推理型AI搜索是近期AI应用领域比较火的方向之一。国内的AI厂商,如月之暗面的Kimi推出了Kimi探索版,智谱AI推出了AI搜索智能体,360AI则是在原有的360AI搜索的基础上增加了慢思考模式。国外的AI玩家,如AI搜索的领头羊Perplexity,也在这两天在Pro Search中增加了能够自动运行的推理模式(Reasoning Mode)。

推理型AI搜索源自于OpenAI发布的推理模型o1。在o1中,OpenAI内置了一个被称为“内部思维链(Internal Chain of Thought)”的推理逻辑,对于复杂的任务,该模型会先生成推理链条进行自我推理,然后再用逐个击破的思想一步步得出回答。

推理型AI搜索也是基于这个思路。搜索作为AI模型应用的一大热门领域,属于比较高频的使用场景。而在推理型AI搜索诞生前,传统的AI搜索对于稍微复杂一些的问题往往无法胜任。推理让AI搜索看到了进化的方向。面对复杂问题,比如仅凭搜索信息得不到直接的答案的问题,推理型AI搜索可以先让模型“思考”,分析问题,拆解为数个子问题,然后逐个解决子问题,最后还可以加上一个在AI Agent中常用的“反馈(Reflection)”机制,以让模型检查并优化回答的质量。

从这一点来看,推理型AI搜索本质上可以看作是一个大号的AI Agent(智能体)。

测评问题

本次测试对象由于都是国内的AI搜索工具,我们先测试中文互联网内的问题。

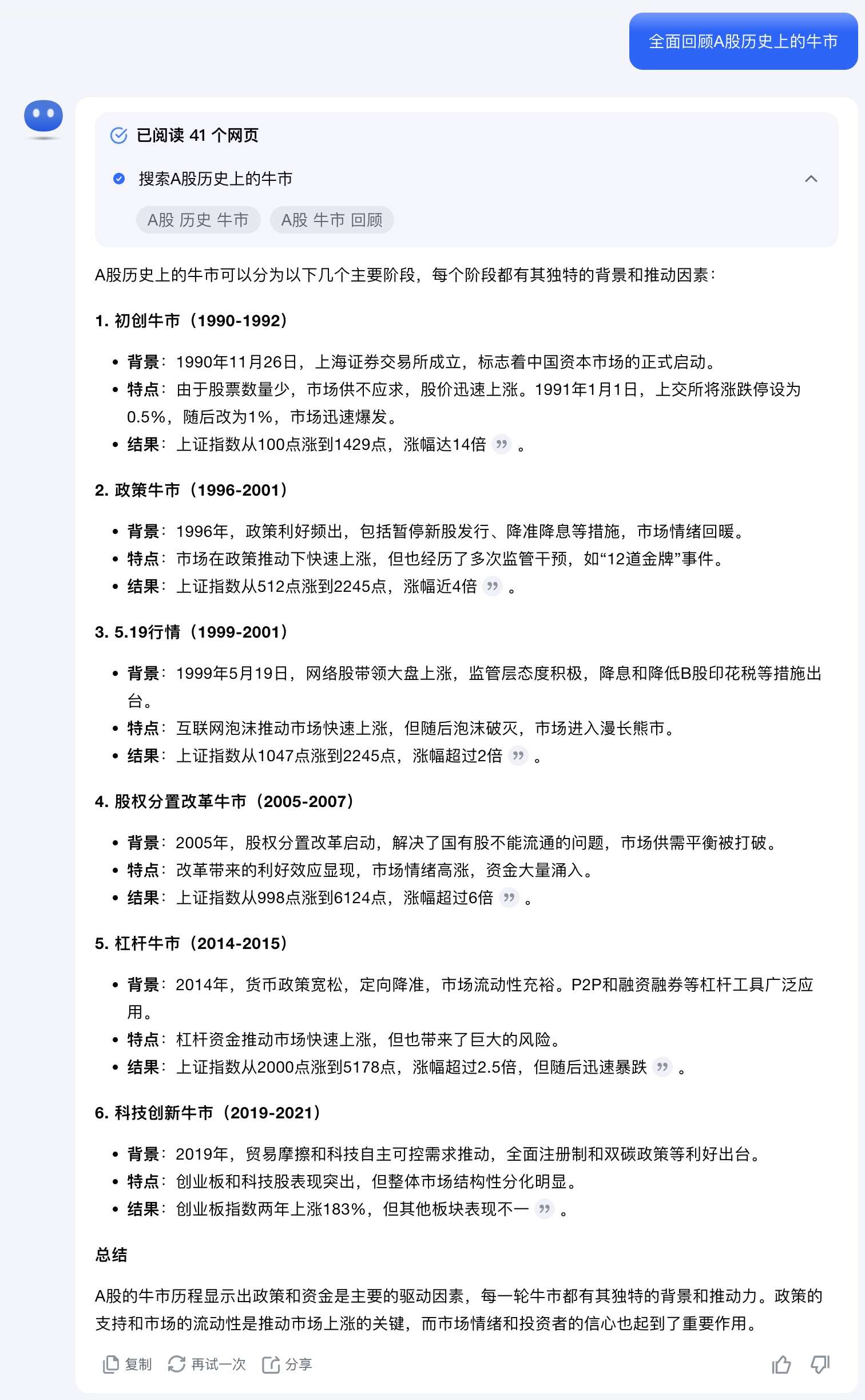

提示词:全面回顾A股历史上的牛市。

结论

先上结论。

-

内容全面性:360AI搜索的回答最为全面,涵盖了牛市的各个方面;智谱AI的回答次之,提供了主要数据;Kimi探索版的回答相对简洁。

-

结构和逻辑性:三者中,360AI搜索的结构最为严谨,层次分明;Kimi探索版的回答简洁明了;智谱AI的回答则偏向于数据罗列。

-

分析深度:360AI搜索对牛市的分析最为深入,涵盖了市场环境和规律等;Kimi探索版和智谱AI的分析相对简单。

-

数据和事实准确性:智谱AI和360AI搜索提供了较多具体数据,但需注意数据的一致性和准确性;Kimi探索版的数据相对较少。

-

可读性:Kimi探索版的回答简洁,适合快速阅读;智谱AI的回答数据密集,适合对数字敏感的读者;360AI搜索的回答信息量大,适合深入研究。

Kimi探索版

Kimi探索版是基于Kimi原有的联网搜索工具的一个升级版本。关于其详细信息可以看我这篇文章:《『深度分析』Kimi版o1来了!Kimi探索版全面解读!》。

Kimi探索版针对“全面回顾A股历史上的牛市”这个问题的回答如下。完整版回答文字过长,所以这里放上回答的截图。

Kimi点评

优点:

-

结构清晰,层次分明:Kimi的回答将A股历史上的牛市分为六个主要阶段,每个阶段都有明确的标题和时间段,条理清晰,最易读,便于理解和记忆。

-

内容精炼,重点突出:每个阶段都包含背景、特点和结果三个部分,信息简洁明了,抓住了每次牛市的核心要点。

-

总结概括到位:在结尾处对A股牛市的整体特征进行了总结,强调了政策和资金作为主要驱动因素的重要性。

不足:

-

时间段划分存在交叉:将1996-2001年定义为“政策牛市”,而同时又将1999-2001年定义为“5.19行情”,这可能会引起混淆,时间段划分需更严谨。

-

细节描述略显不足:对于每次牛市的具体细节和影响,描述过于简略,缺乏深入的分析和数据支持。(这一点和我在上一篇文章里的测评结果一致,都有着分析不够深入的缺点)

智谱AI搜索智能体

智谱推出的推理型AI搜索位于智谱智能体——AI搜索。

智谱AI搜索智能体回答如下。

智谱点评

优点:

-

全面性强:回答罗列了A股自1990年以来的九次主要牛市,覆盖了历史上的重要阶段。

-

数据详实:每次牛市都提供了具体的涨幅、持续时间(时间甚至精确到日)和指数点位,数据丰富。

-

原因分析简明:对每次牛市的主要推动原因进行了简要说明,帮助读者了解背后的驱动因素。

不足:

-

缺乏深入分析:和前面的Kimi一样,虽然提供了数据和原因,但对每次牛市的特点、影响等缺乏更深入的探讨。从回答来看,仅是对事实的罗列,而深入分析的回答内容太少。

-

缺少整体总结:在列举完各次牛市后,没有对A股牛市的整体规律或特征进行总结和概括。

-

数据源不够多:相比Kimi的41个网页,360AI搜索的27篇资料,智谱引用的数据源是最少的,仅有14个搜索来源,阅读了5个网页。丰富的数据源是回答质量的基础,在这一点,智谱还需要加强。比如智谱的回答中提到最后一个牛市是2019年初至今,这一点回答明显是错误的(A股向来是牛短熊长,和美股相反,何来5年多的牛市?)。

360AI搜索慢思考模式

360AI搜索,背靠原本的360搜索引擎,曾一度成为国内AI工具的月活第一名。推理型AI搜索则作为一个新模式——慢思考模式出现,可以在360AI搜索输入框下方看到入口。

360AI搜索慢思考模式回答如下。考虑到360AI搜索回答篇幅过长,隐去了慢思考模式的思维链。

360AI搜索点评

优点:

-

内容详尽全面:回答不仅列举了各次牛市,还包括了牛市的持续时间、涨幅、推动因素、政策影响、市场环境分析、规律特点等,多角度、多层次地进行了阐述。这一点,360AI搜索做的最好,不仅指出了牛市的各项信息,还进行了多方面总结。

-

深入分析:对牛市的推动因素、政策影响、市场环境等进行了深入的分析,体现了较高的专业水平。

-

总结归纳:对牛市的特点和影响进行了综合分析,有助于读者全面理解A股市场的历史规律。

不足:

-

信息量较大,可能造成阅读负担:内容详尽虽然是优点,但过多的信息可能会让读者感觉冗长,影响阅读体验。

-

部分数据需核实:例如,提到“六次牛市的平均持续时间约为17.8个月”,但前文列举了八次牛市,数据前后需一致。其次,360AI搜索关于牛市的总结仅截止到了2015年,应该是受到了信息源的影响,2015年后的事情只字未提。

结语

那么,你觉得在这个测试中,Kimi探索版、智谱AI搜索智能体和360AI搜索慢思考模式,谁胜出?

精选推荐

都读到这里了,点个赞鼓励一下吧,小手一赞,年薪百万!😊👍👍👍。关注我,AI之路不迷路,原创技术文章第一时间推送🤖。

9万+

9万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?