点一下关注吧!!!非常感谢!!持续更新!!!

目前已经更新到了:

- Hadoop(已更完)

- HDFS(已更完)

- MapReduce(已更完)

- Hive(已更完)

- Flume(已更完)

- Sqoop(已更完)

- Zookeeper(已更完)

- HBase(已更完)

- Redis (已更完)

- Kafka(已更完)

- Spark(正在更新!)

章节内容

上节我们完成了如下的内容:

- Spark Streaming DStream 转换函数

- DStream 无状态转换

- DStream 无状态转换 案例

转换方式

有两个类型:

- 无状态转换(已经完成)

- 有状态转换

接下来开始有状态转换。

有状态转换

有状态转换主要有两种:

- 窗口操作

- 状态跟踪操作

窗口操作

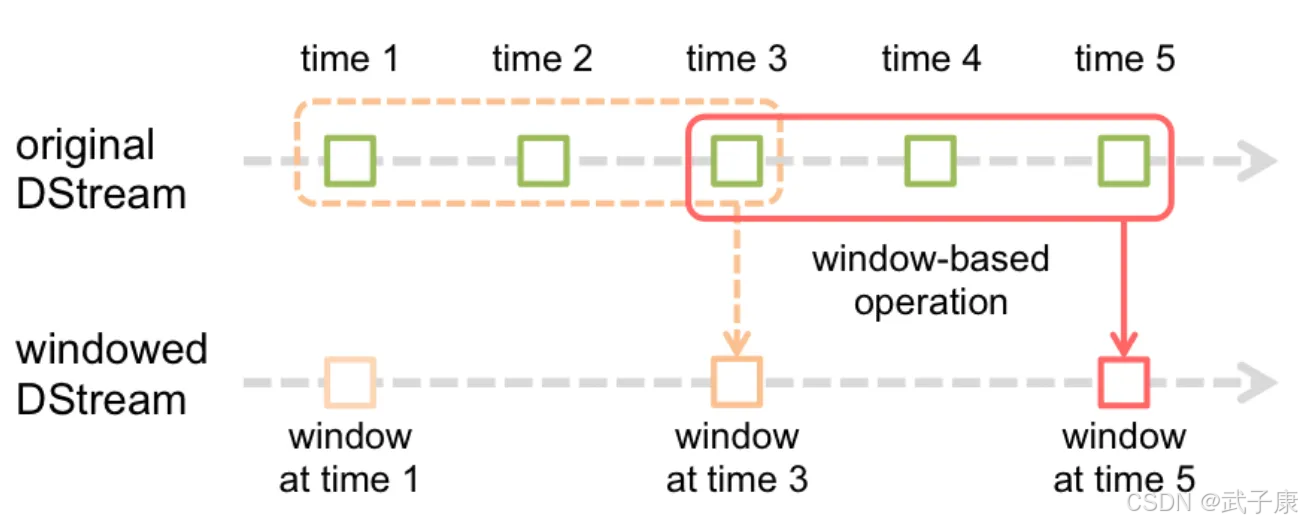

Window Operations 可以设置窗口大小和滑动窗口间隔来动态获取当前Streaming的状态

基于窗口的操作会在一个比 StreamingContext 的 batchDuration(批次间隔)更长的时间范围内,通过整合多个批次的结果,计算出整个窗口的结果。

基于窗口的操作需要两个参数:

- 窗口长度(Window Duration):控制每次计算最近的多少个批次的数据

- 滑动间隔(Slide Duration):用来控制对新的 DStream 进行计算的间隔

两者都必须是StreamingContext中批次间隔(batchDuration)的整数倍

准备编码

我们先编写一个每秒发送一个数字:

[窗口操作] 案例2观察窗口数据

- 观察窗口的数据

- 观察 batchDuration、windowDuration、slideDuration 三者之间的关系

- 使用窗口相关的操作

编写代码

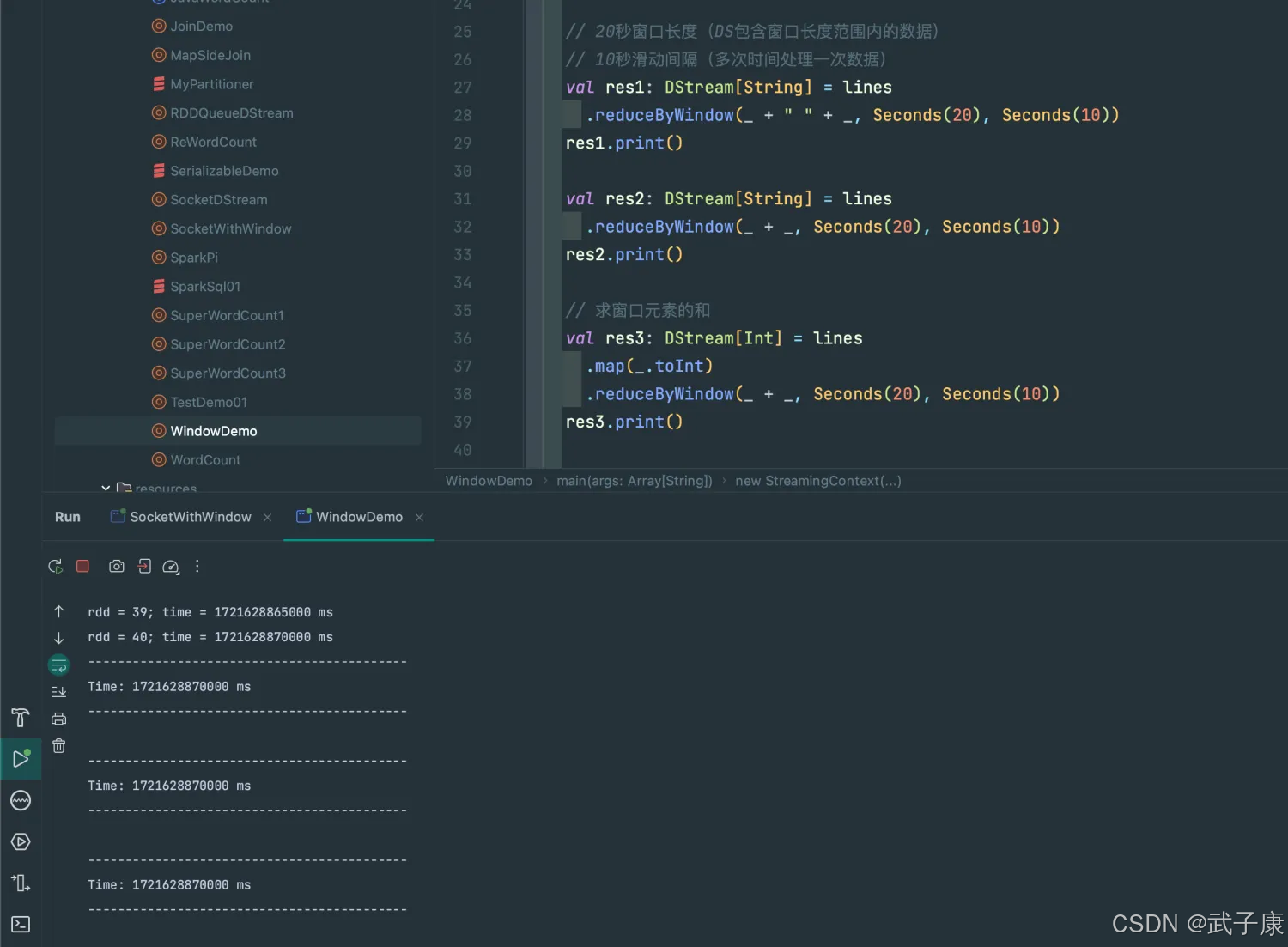

运行结果

运行之后控制截图如下:

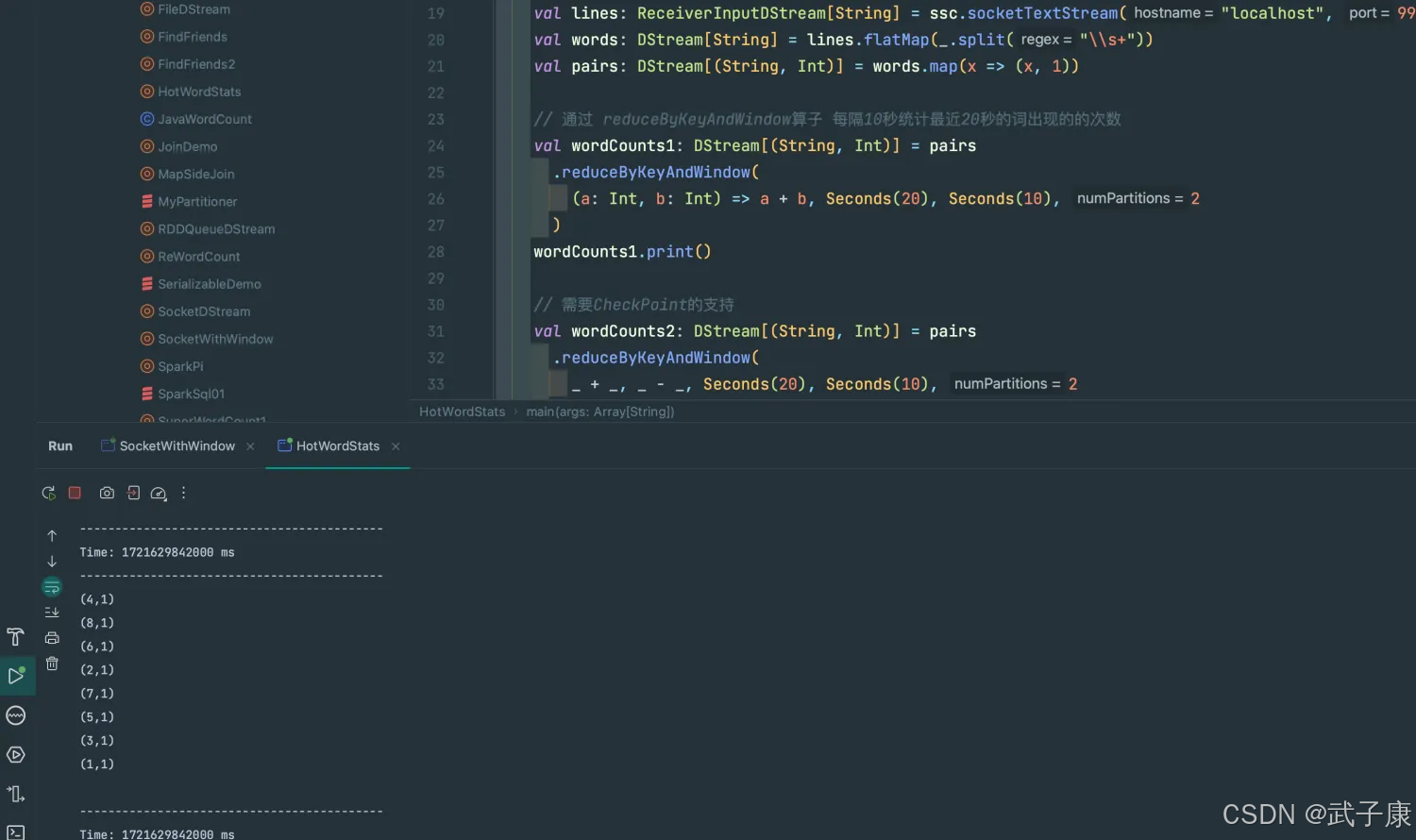

[窗口操作] 案例3 热点搜索词实时统计

编写代码

运行结果

运行结果如下图:

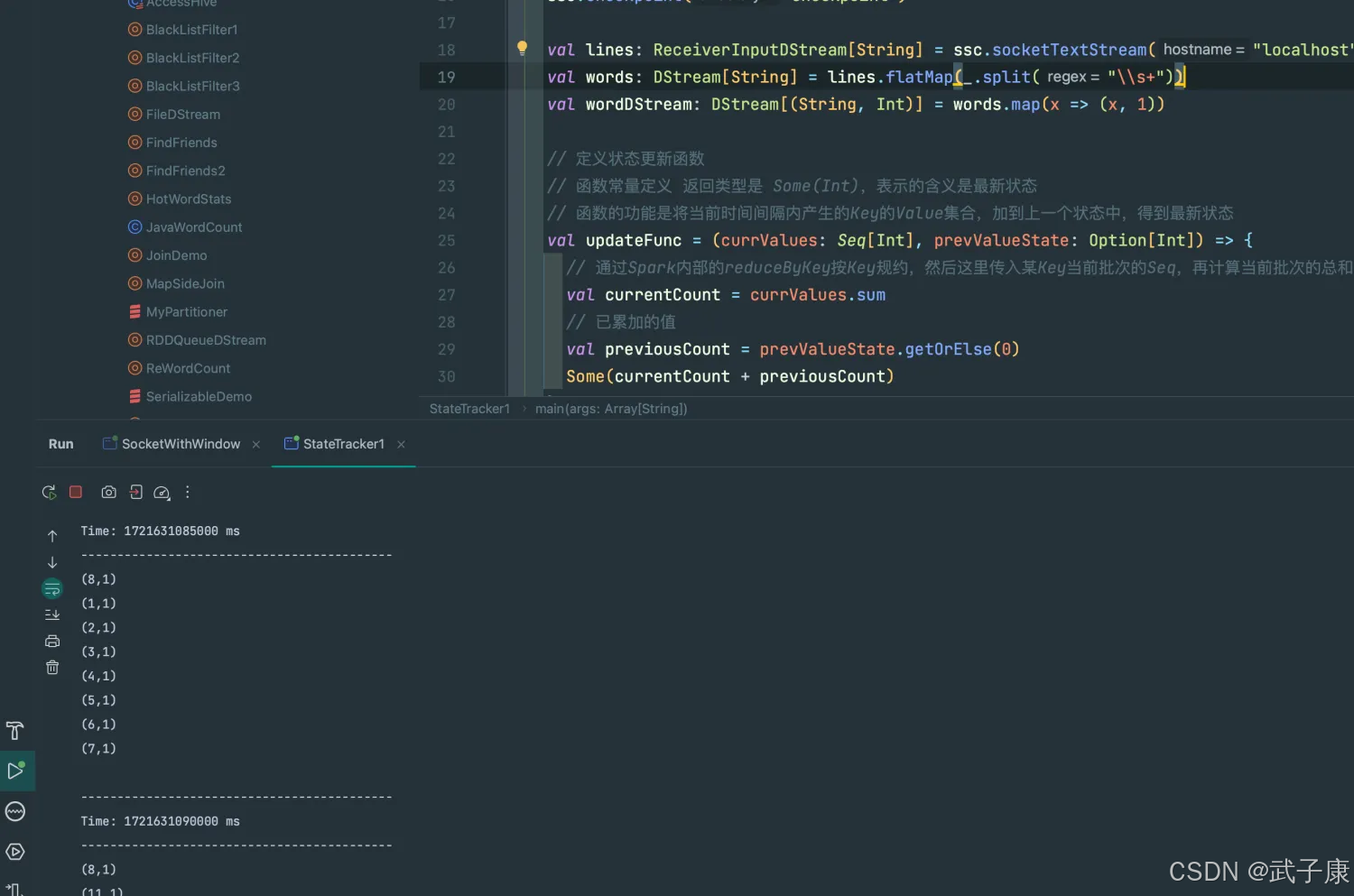

[状态追踪操作] updateStateByKey

UpdateStateByKey的主要功能:

- 为Streaming中每一个Key维护一份State状态,state类型可以是任意类型的,可以是自定义对象,更新函数也可以是自定义的

- 通过更新函数对该Key的状态不断更新,对于每个新的batch而言,Spark Streaming会在使用updateStateByKey的时候已经存在的key进行state状态更新

- 使用updateStateByKey时要开启 CheckPoint 功能

编写代码1

流式程序启动后计算wordcount的累计值,将每个批次的结果保存到文件

运行结果1

运行结果是:

统计全局的Key的状态,但是就算没有数据输入,也会在每一个批次的时候返回之前的Key的状态。

这样的缺点:

- 如果数据量很大的话,CheckPoint数据会占用较大存储,而且效率也不高

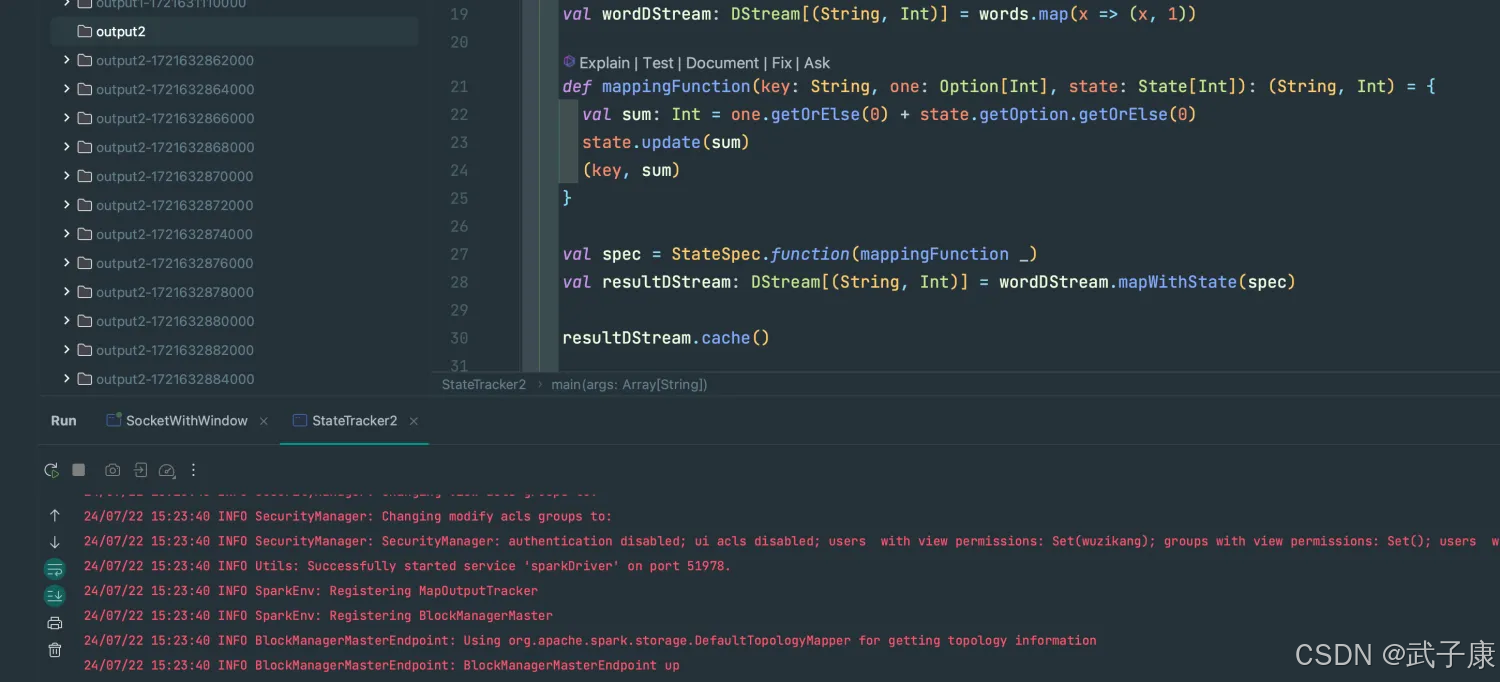

编写代码2

mapWithState:也是用于全局统计Key的状态,如果没有数据输入,便不会返回之前的Key的状态,有一点增量的感觉。

这样做的好处是,只关心那些已经发生的变化的Key,对于没有数据输入,则不会返回那些没有变化的Key的数据,即使数据量很大,checkpoint也不会像updateStateByKey那样,占用太多的存储。

运行代码

792

792

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?