RTX4060安装pytorch-gpu (Cuda12.2)技术分享

问题描述:

在cmd中运行以下命令返回的是false

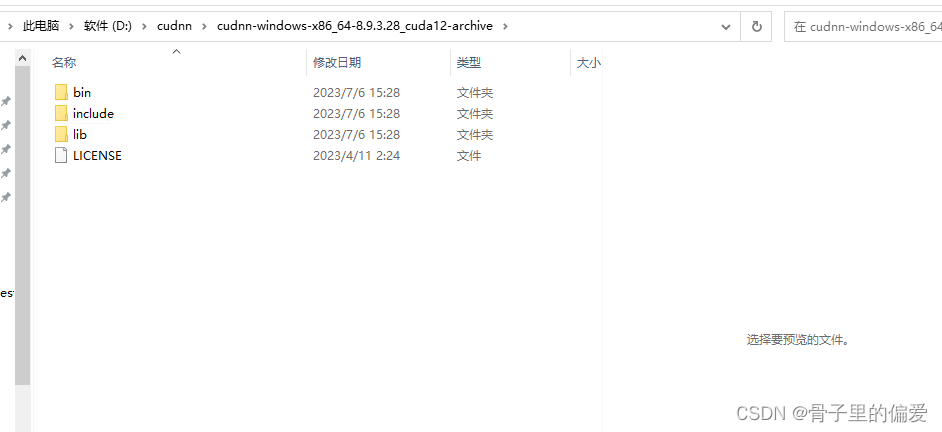

第一步:我的电脑显卡是4060Ti,我安装的cuda是12.2,那么我需要下载的cudnn的版本是8.9.3

下载的具体网址

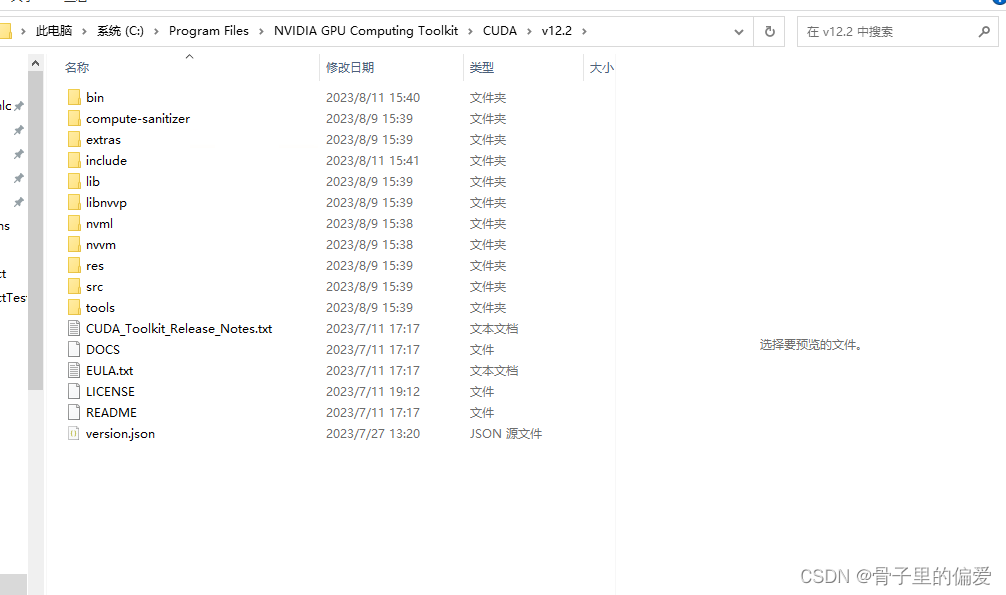

然后下载的cudnn,将三个文件夹中的文件分别复制粘贴到cuda安装的对应的目录下

cmd中查看是否安装成功

cmd中查看是否安装成功

nvidia-smi

nvcc -V

确认一下是否安装成功

进入如下目录:

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v12.2\extras\demo_suite

执行 bandwidthTest.exe,看见PASS

执行 deviceQuery.exe,看见PASS

操作就是先打开命令行cmd,然后将以上的两个.exe拖进cmd中,回车就能看到结果了

如果以上都没有问题,那就需要设置一下镜像

设置镜像

在C盘用户目录下,加入如下内容即可。

[global]

index-url = https://pypi.tuna.tsinghua.edu.cn/simple/

[install]

use-mirrors =true

mirrors =http://pypi.mirrors.ustc.edu.cn/simple/

trusted-host =pypi.mirrors.ustc.edu.cn

创建pytorch环境,我当前的是3.8.8,看第一幅图有版本。

在cmd中

conda create –n pytorch38 python=3.8

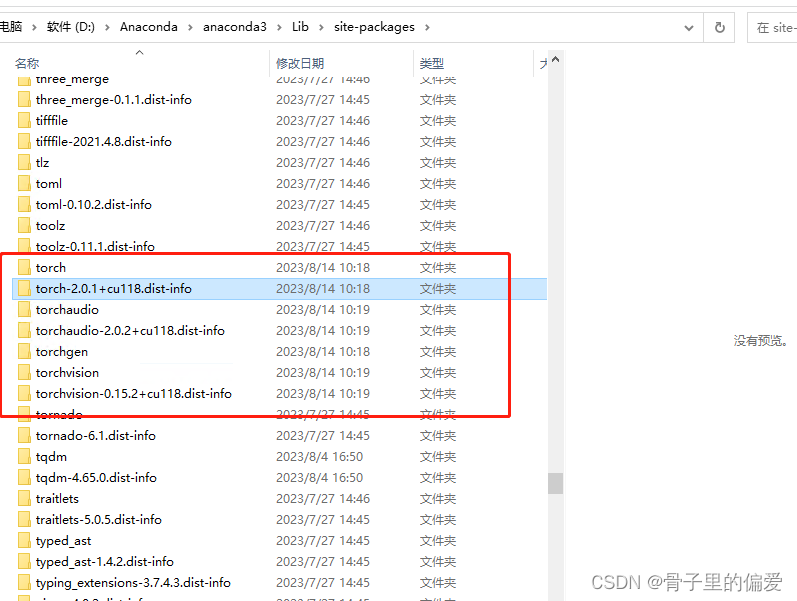

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

安装的过程有点慢,耐心等待即可。

完成安装时,在cmd中输入pip list时,查看安装的版本

安装的路径在下图:

以前安装的是torch的版本是cpu版本,我先剪切出去了,以防不成功

cmd中,进入python环境后,输入一下的测试命令,进行测试,结果:

conda 的基础命令

#查看现有环境

conda env list

#更新conda

conda upgrade --all

#使用py36环境

conda activate py36

#返回base环境

conda deactivate

#创建一个名字叫py36的环境,版本为3.6

conda create -n py36 python=3.6

#删除一个名字叫py36的环境

conda remove -n py36 --all

进行项目上的测试结果返回:

100Epochs只需要1分钟,我用cpu跑需要30分钟。差了30倍的速度

最新的执行的命名:

pip install torch==2.4.1+cu128 torchvision==0.19.1+cu128 torchaudio==2.1.1+cu128 --index-url https://download.pytorch.org/whl/cu128

安装命令:

pip install torch==2.4.1+cu124 torchvision==0.19.1+cu124 --index-url https://download.pytorch.org/whl/cu124

pip install torchaudio==2.4.0+cu124 --index-url https://download.pytorch.org/whl/cu124

2819

2819

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?