一、学习内容

目标检测: fast r-cnn、ssd、yolov3

二、所需知识

图像处理基础知识

python3基础语法

numpy 科学计算包

了解pytorch

数学基础(线性代数)

三、所需环境

anaconda3 python3.6 pycharm pytorch torchvision

沟通方式:github csdn

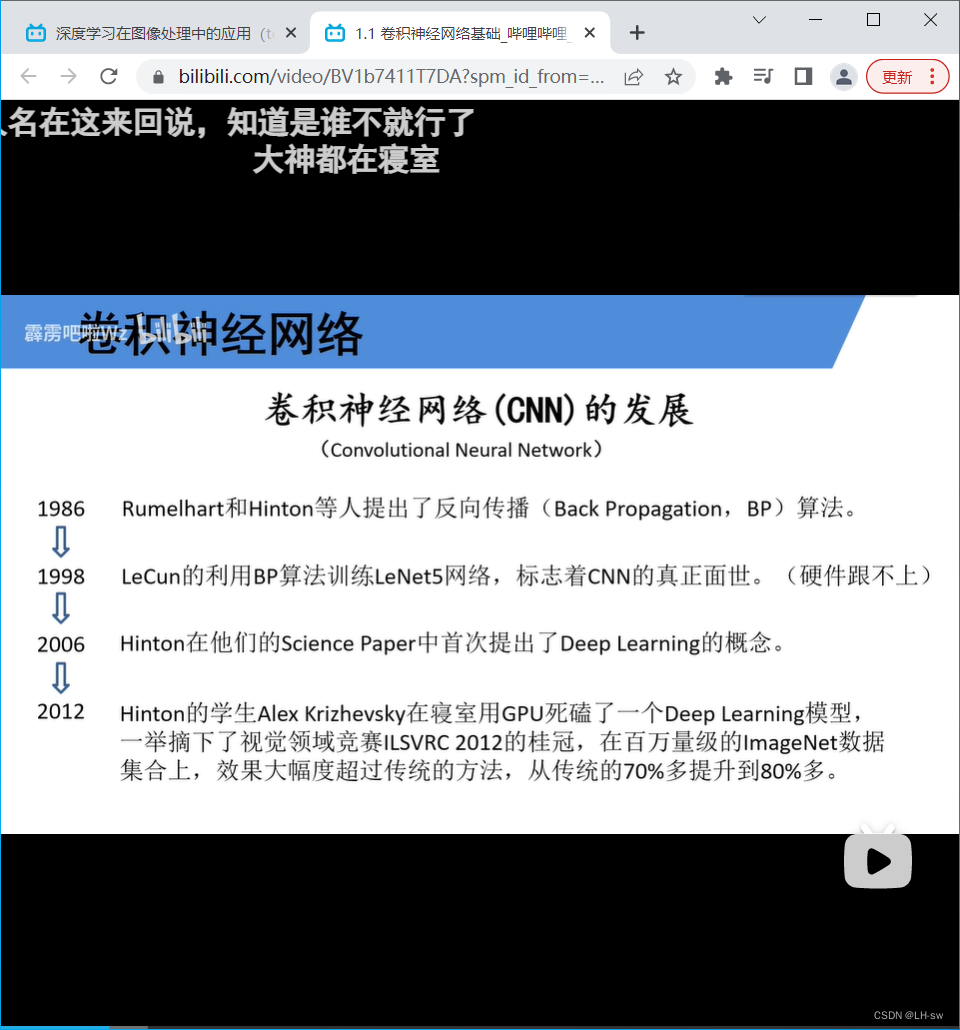

四、卷积神经网络(cnn)发展

五、全连接层

- 神经元

- bp算法:包括信号的前向传播和误差的反向传播两个过程。计算误差时按从输入到输出的方向进行,调整权值和阈值则从输出到输入的方向进行。

- 实例:利用bp算法实现车牌识别(可以再看视频回忆)

六、卷积层(cnn中独特的网络的结构)

- 用一个卷积核在图像上已滑动窗口的形式顺序滑动。

- 目的:进行图像特征提取 卷积特性:

1、拥有局部感知机制

2、权值共享 卷积过程: 卷积核的深度(个数)与输入特征层的深度(个数)相同。 输出的特征矩阵深度(个数),与卷积核个数相同

- 激活函数:

- 矩阵经卷积操作后的尺寸由什么因素决定:

七、池化层:

- 目的:对特征图进行稀疏处理,减少数据运算量

- maxpooling下采样层:取的最大值

- averagepooling下采样层:取的是平均值。 池化层特点:

没有训练参数 只改变矩阵的宽度和高度,不改变深度 一般池化大小和步距是一样的。

八、回顾

全连接层

卷积层

池化层

1201

1201

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?