今天梳理一下逻辑回归,这个算法由于简单、实用、高效,在业界应用十分广泛。注意咯,这里的“逻辑”是音译“逻辑斯蒂(logistic)”的缩写,并不是说这个算法具有怎样的逻辑性。

前面说过,机器学习算法中的监督式学习可以分为2大类:

分类模型:目标变量是分类变量(离散值);

回归模型:目标变量是连续性数值变量。

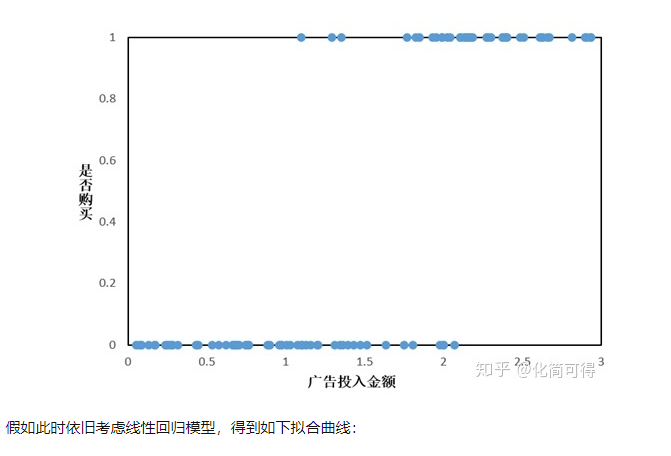

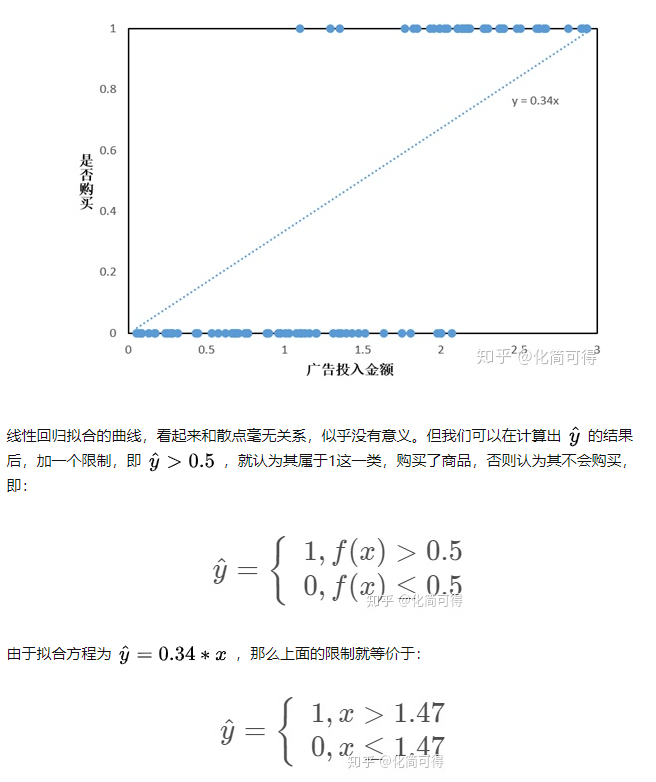

逻辑回归通常用于解决分类问题,例如,业界经常用它来预测:客户是否会购买某个商品,借款人是否会违约等等。实际上,“分类”是应用逻辑回归的目的和结果,但中间过程依旧是“回归”。

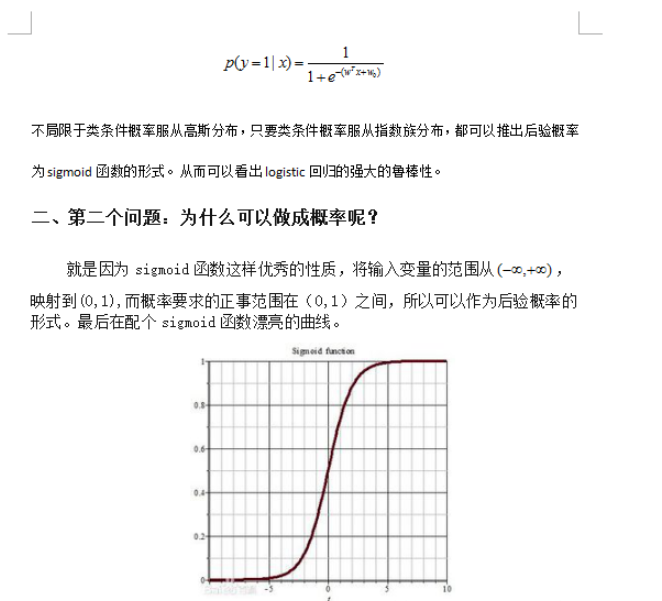

为什么这么说?因为通过逻辑回归模型,我们得到的计算结果是0-1之间的连续数字,可以把它称为“可能性”(概率)。

对于上述问题,就是:客户购买某个商品的可能性,借款人违约的可能性。然后,给这个可能性加一个阈值,就成了分类。例如,算出贷款违约的可能性>0.5,将借款人预判为坏客户。

1.从线性回归说起

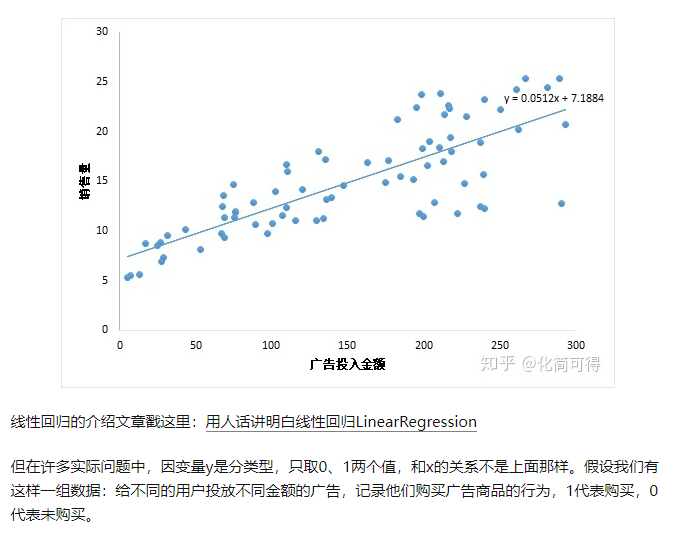

考虑最简单的情况,即只有一个自变量的情况。比方说广告投入金额x和销售量y的关系,散点图如下,这种情况适用一元线性回归。

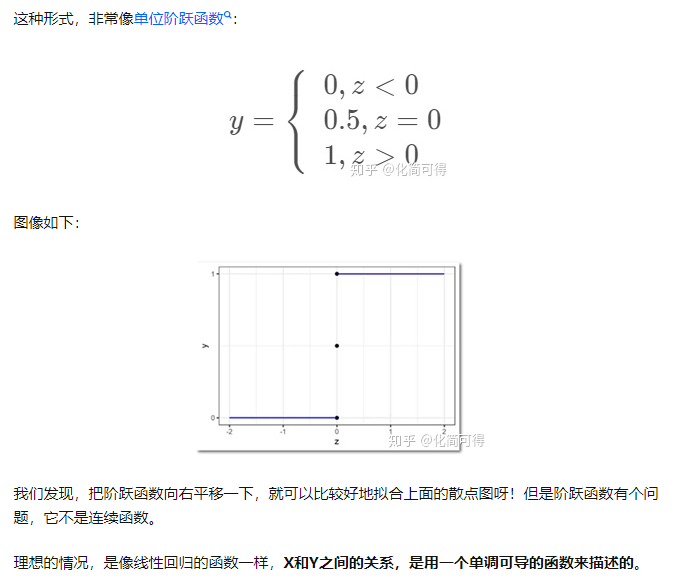

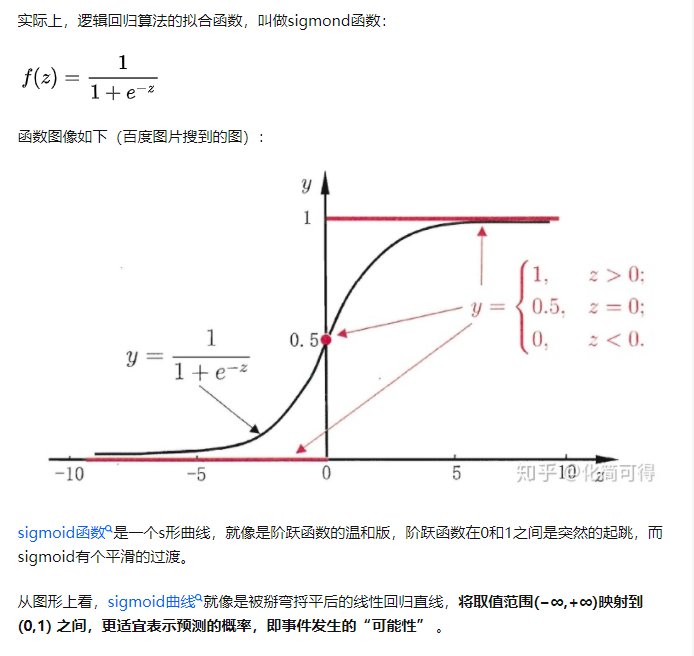

2.Sigmod函数

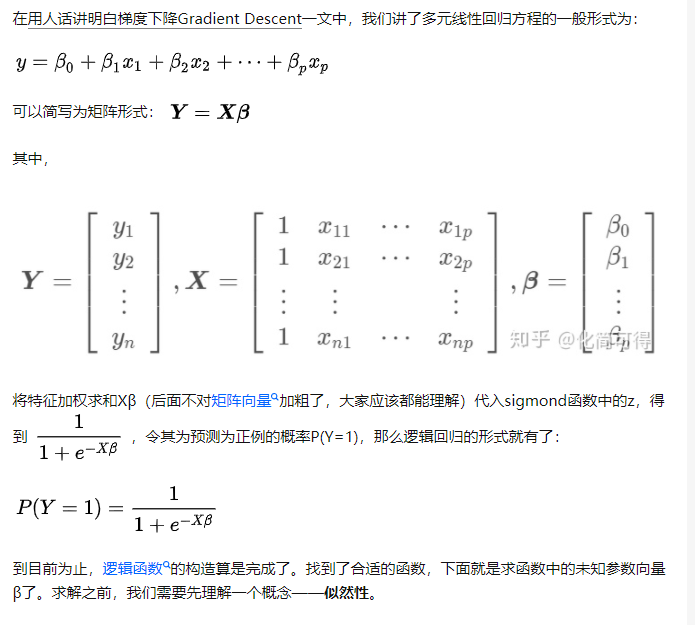

3.推广到多元

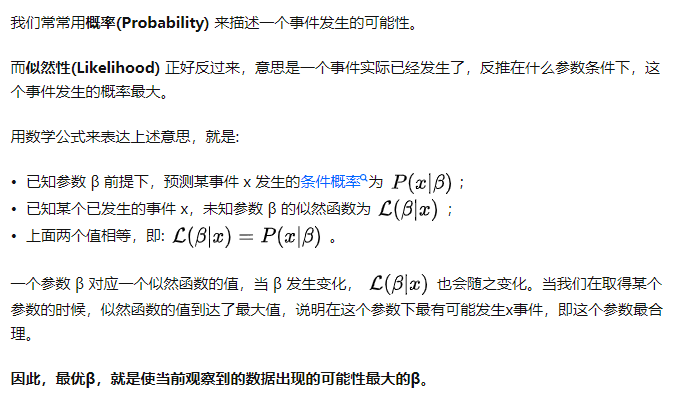

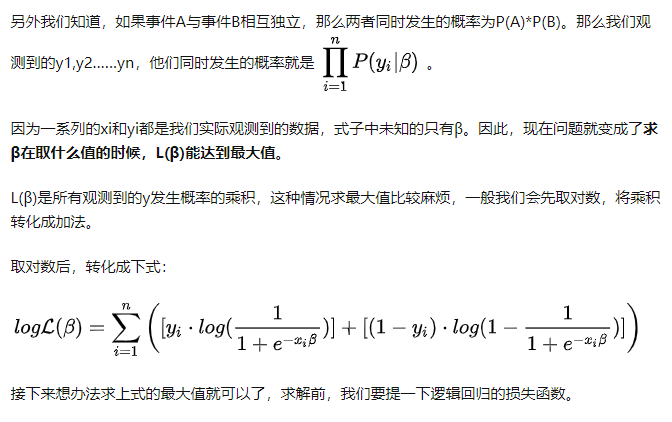

4.似然函数

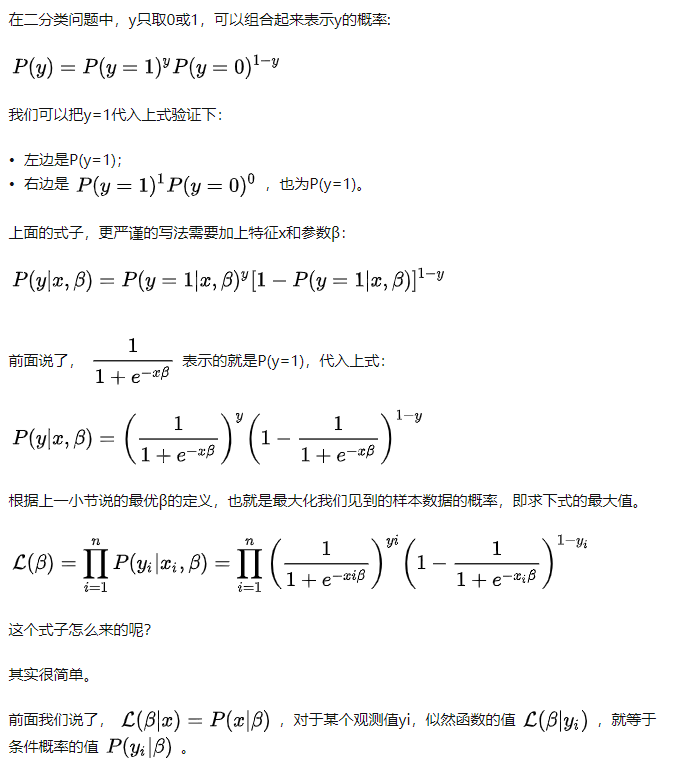

5.最大似然估计

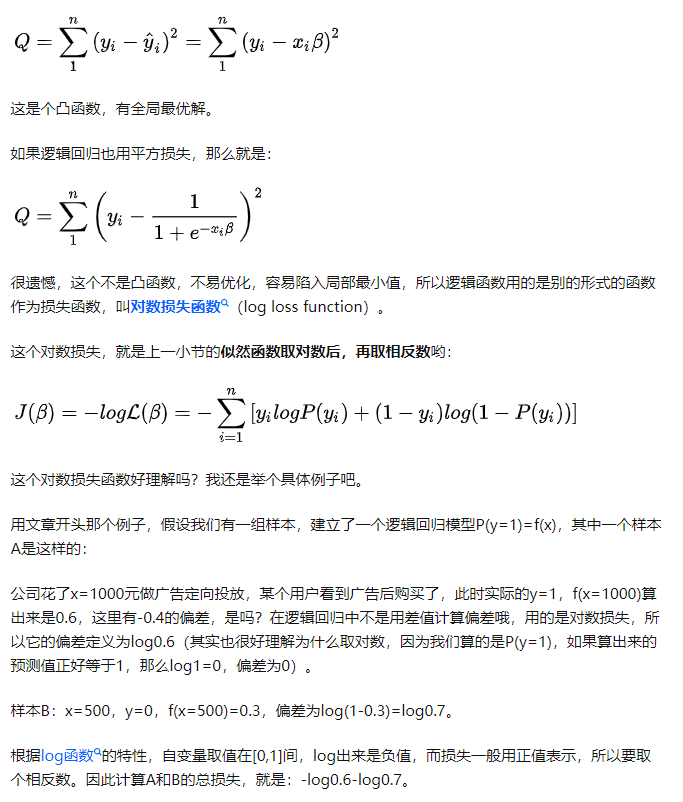

6.损失函数

在机器学习领域,总是避免不了谈论损失函数这一概念。损失函数是用于衡量预测值与实际值的偏离程度,即模型预测的错误程度。也就是说,这个值越小,认为模型效果越好,举个极端例子,如果预测完全精确,则损失函数值为0。在线性回归一文中,我们用到的损失函数是残差平方和SSE:

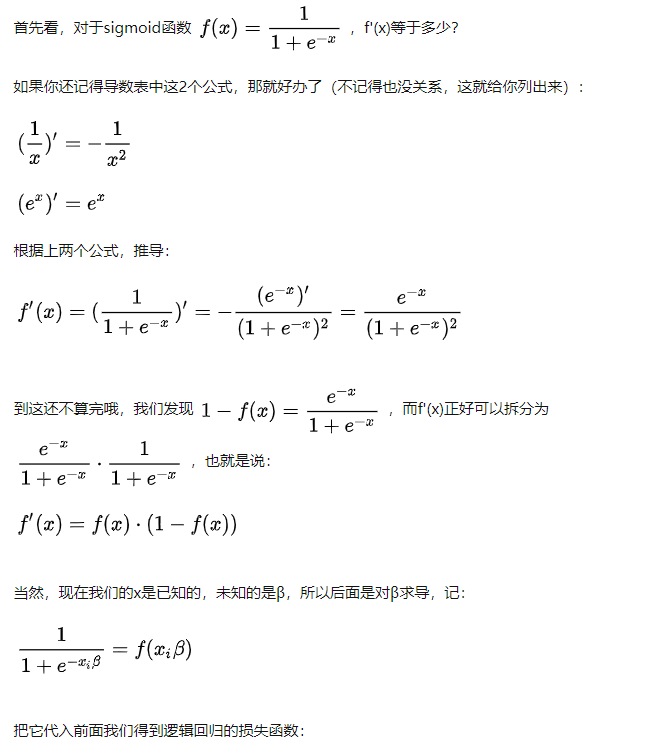

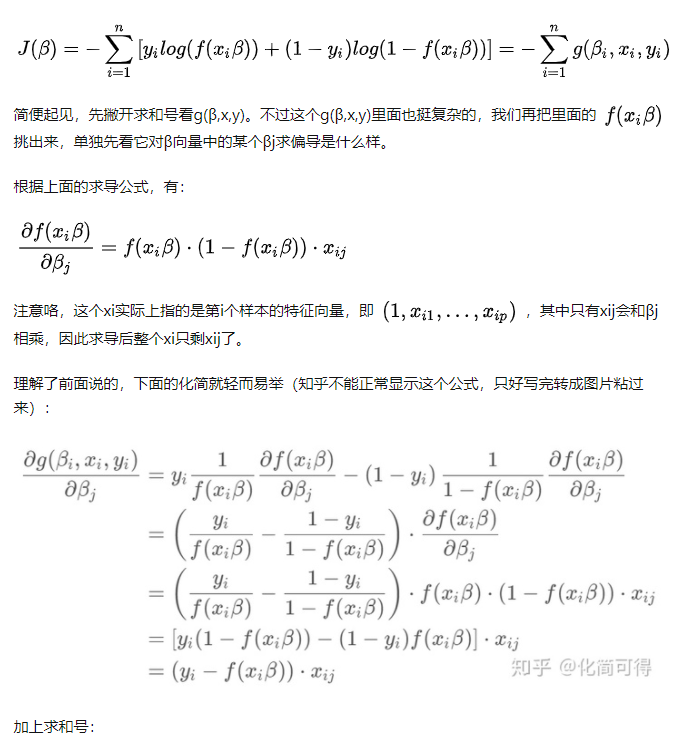

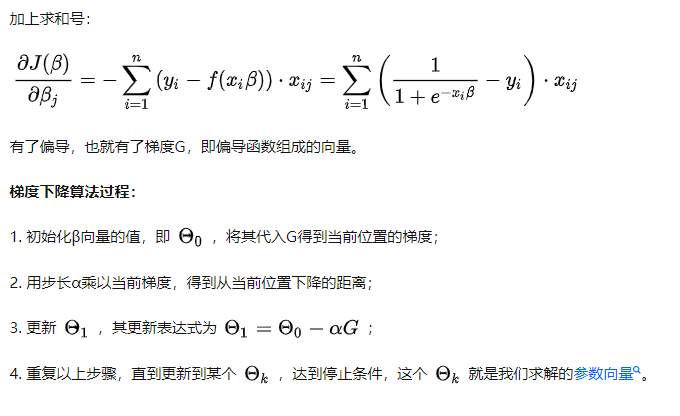

7.梯度下降法求解

要开始头疼的公式推导部分了,不要害怕哦,我们还是从最简单的地方开始,非常容易看懂

9 总结

(1) 获取lable=1 的概率p 则0的概率为1-p 为了可以用一个统一的式子表示 推出

py * (1-p)(1-y)

(2) 根据最大似然 写出连成的函数 为了方便计算(p在0,1之间,连乘结果很小),引入log

(3)可以利用梯度下降计算

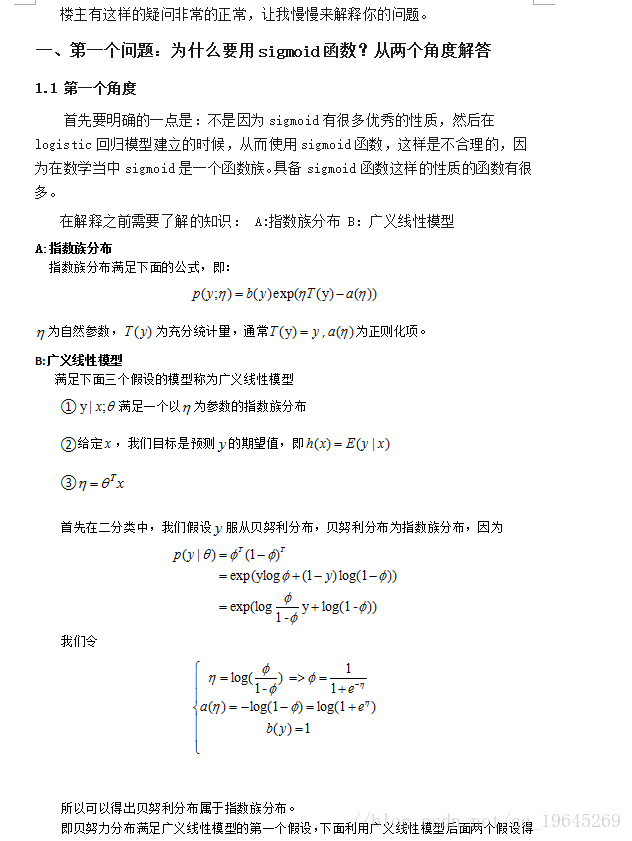

10 逻辑回归为什么使用sigmod函数

理解推导第一个角度即可

362

362

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?