- 试错学习(trial and error learning)主要包括以下几个关键部分:

- 尝试:采取一系列动作或行为来尝试解决问题或实现目标。

- 错误:在尝试的过程中可能会出现错误,这些错误可能是环境的不确定性导致的,也可能是自身的不当行为导致的。

- 结果:每次尝试的后果,无论是积极的还是消极的,都会对下一次尝试产生影响。

- 学习:通过不断地尝试并出现错误,自身会逐渐积累经验,了解哪些动作或行为会产生有利的结果,从而在下一次尝试中做出更加明智的选择。

试错学习虽然是强化学习中最鲜明的要素之一,但并不是强化学习的全部,强化学习还包含其它的学习形式例如观察学习(对应模仿学习、离线强化学习等技术)。

尝试—>后果(好的/坏的;即时的/延时的)

决策—>奖励/惩罚(正的/负的;即时的/延时的)

最终通过一次次的决策来实现目标,这个目标通常是以最大化累积的奖励来呈现的,这个过程就是序列决策(sequential decision making)过程,而强化学习就是解决序列决策问题的有效方法之一。

- 强化学习的应用场景

- 游戏

| AlphaGo | 围棋AI |

|---|---|

| AlphaStar | 《星际争霸》AI |

| Alpha Zero | 通用游戏AI |

| OpenAI Five | Dota 2 AI |

- 机器人领域

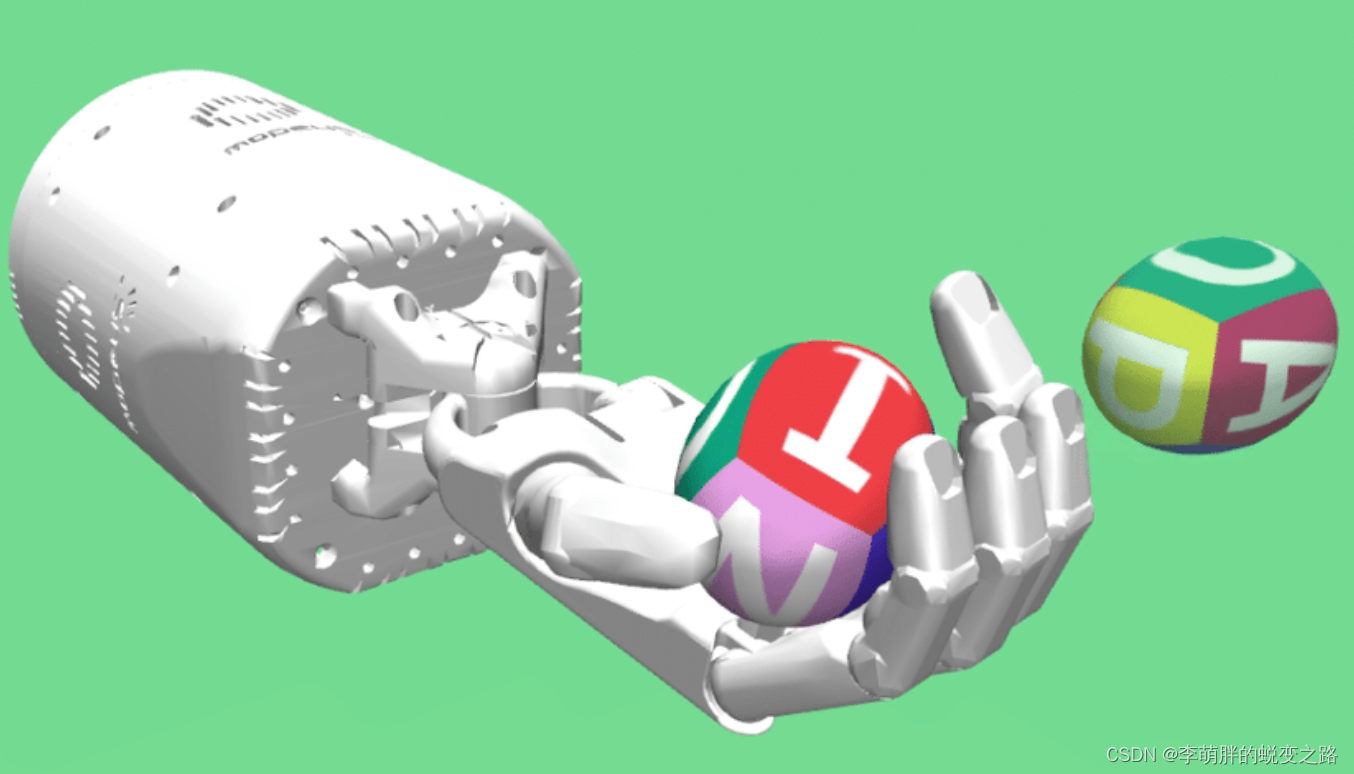

图片演示了NICO机器人学习抓取任务的过程。该任务的目标是将桌面上的物体抓取到指定的位置,机器人通过每次输出相应关节的参数来活动手臂,然后通过摄像头观测当前的状态,最后通过人为设置的奖励(例如接近目标就给一个奖励)来学习到正确的抓取策略。

强化学习应用在机器人领域仿真的必要性:

不同于游戏领域,在机器人中实现强化学习的成本往往较高,一方面观测环境的状态需要大量的传感器,另一方面则是试错学习带来的实验成本,在训练过程中如果机器人决策稍有失误就有可能导致设备损坏,因此在实际应用中往往需要结合其他的方法来辅助强化学习进行决策。其中最典型的方法之一就是建立一个仿真环境,通过仿真环境来模拟真实环境,这样就可以大大降低实验成本。如:

当然,仿真环境也并不是万能的,因为仿真环境和真实环境之间往往存在一定的差异,这就需要我们在设计仿真环境的时候尽可能全面地考虑到真实环境的各种因素,这也是一个非常重要的研究方向。除了简单的抓取任务之外,研究者们还在探索将强化学习应用于更加复杂的机器人任务,例如仓储搬运、机器人足球以及自动驾驶等等。

- 金融领域

如股票交易、期货交易、外汇交易等。在股票交易中,我们的目标是通过买卖股票来最大化我们的资产。在这个过程中,我们需要不断地观测当前的股票价格(state),然后根据当前的价格来决定买入或卖出股票的数量(action),最后通过股票价格的变化来更新我们的资产(policy)。在这个过程中,我们的资产会随着股票价格的变化而变化,这就是奖励或惩罚,每次的买卖就是决策。

- 自动驾驶

- 推荐系统

- 交通派单

- 广告投放

- ChatGPT

- ……

- 强化学习的一些典型技术方向

- 多智能体强化学习(MARL)

在多个智能体的环境下进行强化学习。

- 存在非静态问题,即环境的状态不仅由智能体的动作决定,还受到其他智能体的动作的影响。

- 存在信号问题,即智能体之间可能需要进行通信以合作或竞争,如何高效地通信并从信号中学习是一个难题。

- 存在信誉分配问题,在多智能体的合作任务中,确定每个智能体对于整体目标的贡献(或责任)是一个挑战。

- 存在复杂的博弈场景,对于此类研究往往引入博弈论来找到环境中的纳什均衡或其他均衡策略,但这是一个复杂的挑战。

- 从数据/演示中学习(learn from demonstration)

利用数据来辅助强化学习。

- 从专家数据中学习策略

- 以逆强化学习( inverse reinforcement learning,IRL)为代表的从人类数据中学习奖励函数。它指通过观察人类的行为来学习到一个奖励函数,然后通过强化学习来学习一个策略。由于需要专家数据,逆强化学习会受到噪声的影响,因此如何从噪声数据中学习到一个较好的奖励函数也是一个难题。

- 以人类反馈强化学习(reinforcement learning from human feedback,RLHF)为代表的从人类标注的数据中学习奖励模型来进行微调(fine–tune)。

- 离线强化学习(offline reinforcement learning)

- 世界模型(world model)

- 模仿学习,指在奖励函数难以明确定义或者策略本身就很难学出来的情况下,我们可以通过模仿人类的行为来学习到一个较好的策略。最典型的模仿策略之一就是行为克隆(behavioral cloning,BC),即将每一个状态-动作对视为一个训练样本,并使用监督学习的方法(如神经网络)来学习一个策略。但这种方法容易受到分布漂移( distribution shift )的影响。智能体可能会遇到从未见过的状态,导致策略出错。

- 探索策略

- 实时环境

- 多任务强化学习

- 强化学习与深度学习

- 深度学习在强化学习中扮演的角色主要是提供了一个强大的函数拟合能力,使得智能体能够处理复杂、高维度和非线性的环境。

- 深度学习与强化学习之间的关系相当于眼睛和大脑的关系,眼睛是帮助大脑决策更好地观测世界的工具,对于一些没有眼睛的动物例如蚯蚓也可以通过其他的感官来观测并解析状态。再比如,同样大脑水平下,即相同的强化学习算法条件下,正常人要比双目失明的人日常的决策要更方便。但是,即使深度学习部分是相同的,例如正常大人和小孩都能通过眼睛观测世界,然由于大脑决策水平的差异也会让两者表现有所差异。

总而言之,深度与强化在更复杂的环境下缺一不可。深度学习可以为强化学习提供强大的感知能力,使强化学习更好地发挥自身的决策能力。

强化学习基本上分为两类:基于价值的和基于策略梯度的算法,这两种算法各有优势,根据实际需要谨慎选择即可。

427

427

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?