学习链接:

https://github.com/isnowfy/snownlp

from snownlp import SnowNLP

s = SnowNLP(u'这个东西真心很赞')

s.words # [u'这个', u'东西', u'真心',

# u'很', u'赞']

s.tags # [(u'这个', u'r'), (u'东西', u'n'),

# (u'真心', u'd'), (u'很', u'd'),

# (u'赞', u'Vg')]

s.sentiments # 0.9769663402895832 positive的概率

s.pinyin # [u'zhe', u'ge', u'dong', u'xi',

# u'zhen', u'xin', u'hen', u'zan']

s = SnowNLP(u'「繁體字」「繁體中文」的叫法在臺灣亦很常見。')

s.han # u'「繁体字」「繁体中文」的叫法

# 在台湾亦很常见。'

text = u'''

自然语言处理是计算机科学领域与人工智能领域中的一个重要方向。

它研究能实现人与计算机之间用自然语言进行有效通信的各种理论和方法。

自然语言处理是一门融语言学、计算机科学、数学于一体的科学。

因此,这一领域的研究将涉及自然语言,即人们日常使用的语言,

所以它与语言学的研究有着密切的联系,但又有重要的区别。

自然语言处理并不是一般地研究自然语言,

而在于研制能有效地实现自然语言通信的计算机系统,

特别是其中的软件系统。因而它是计算机科学的一部分。

'''

s = SnowNLP(text)

s.keywords(3) # [u'语言', u'自然', u'计算机']

s.summary(3) # [u'因而它是计算机科学的一部分',

# u'自然语言处理是一门融语言学、计算机科学、

# 数学于一体的科学',

# u'自然语言处理是计算机科学领域与人工智能

# 领域中的一个重要方向']

s.sentences

s = SnowNLP([[u'这篇', u'文章'],

[u'那篇', u'论文'],

[u'这个']])

s.tf

s.idf

s.sim([u'文章'])# [0.3756070762985226, 0, 0]

训练:

提供训练的包括分词,词性标注,情感分析,而且都提供了我用来训练的原始文件

这样训练好的文件就存储为sentiment.marshal了,之后修改snownlp/sentiment/init.py里的data_path指向刚训练好的文件即可

找到SnowNLP 安装目录,如下:

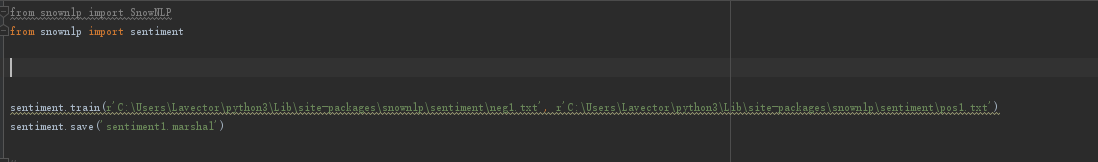

from snownlp import sentiment

sentiment.train('neg.txt', 'pos.txt')

sentiment.save('sentiment.marshal')

1.neg1.txt

用了两罐资生堂发膜后,再买发现要税。还是用蜂花吧

资生堂非常好,但我还是喜欢兰蔻

资生堂的买回来没用过两次

资生堂的睫毛夹太难用了啊啊啊啊啊啊!我又要重新买一个别的了

2.pos1.txt

轻薄好用,适合补妆

资生堂新透白美肌这一套用完后,早上起来脸滑滑的是没错了

我的天,爱上资生堂的六角眉笔,这也太好用了吧

目前为止最爱的一套,资生堂这个系列真给力

我爱资生堂的洗面奶!给我刷子洗的巨干净(又省了一笔清洁液的钱

无语,这个资生堂的什么鬼绿野芳香惠润柔净洗发露(名字太拗口了!要不是我无所谓反正买的时候随便谁会盲买一个这样的名字!)也太好闻了,真是香喷喷

吹爆资生堂智能 真的太适合我了哈哈哈

为资生堂疯狂打call

我是不是说过资生堂红腰子很鸡肋,我现在给它道歉。资生堂全系列都好用

资生堂这个遮瑕,好用不贵性价比超高!但是有点黑!

新水乳打一下卡,资生堂D系列,外观太好看啦

3.结论

a 用自带的模型预测这是正向,但与实际结果不符,实际是负情感对于资生堂

b 训练针对这个问题自己的模型,用上面统计的正向和负向情感库

c 最好记得改默认模型库的调用地址下重新再预测

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?