一、MCP本质

MCP(Model Context Protocol,模型上下文协议) 是Anthropic公司在2024年推出的开放协议。MCP协议可以像USB充电接口那样,标准化AI模型与外部工具的交互方式。

从前的LLM大语言模型像是一个大脑,根据自身训练的数据,帮助我们完成一些工作,它的作用在某种程度上更像一个聊天机器人,而通过使用MCP这种标准化协议,可以将越来越多的好用的工具,非常便捷的接入各种不同的LLM大语言模型,这些工具就像四肢一样,LLM大语言模型指挥着多种多样的工具组合在一起使用,在未来大模型的能力无疑会更加强大。

注意,MCP不是新API标准,而是专为大模型上下文工具调用设计的通信协议,MCP定义了AI大模型如何发现和调用工具的规范,让AI Agent能标准化调用各类工具。

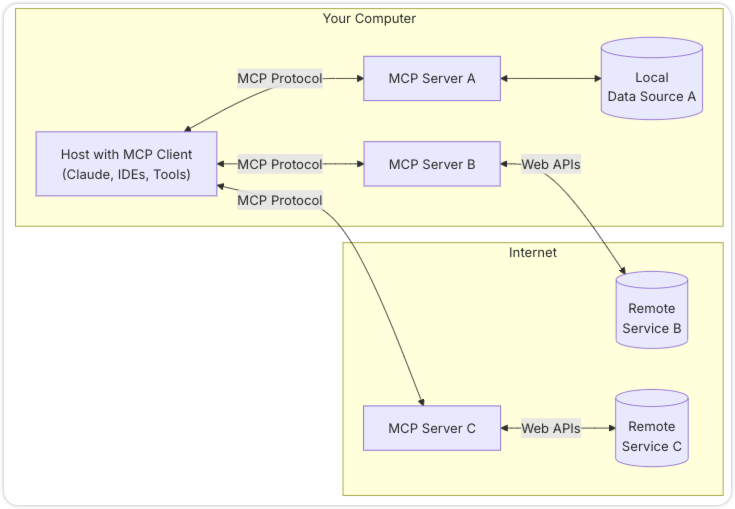

在MCP中,有以下几个角色:

-

MCP Host:程序入口(如智能客服系统、IDE、或者其他AI工具),它们需要通过MCP访问数据

-

MCP Client:与MCP Server保持1对1连接的客户端

-

MCP Server:轻量级工具Server端,每个程序都通过标准化协议来提供特定的功能

-

本地数据源:MCP Server可以操作本机上的文件、数据库、服务

-

远程服务:MCP Server可以通过互联网请求的方式(例如通过 Web API)连接到的外部系统

二、为什么需要MCP?

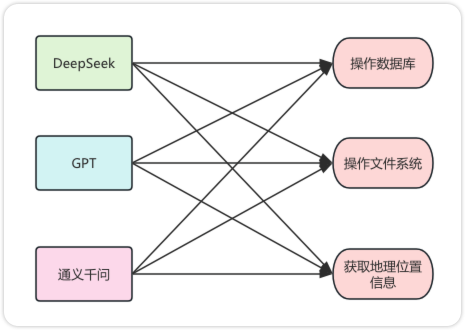

在以往的AI应用开发中,集成每个新工具都需要、研究API文档、处理API认证、数据处理、异常错误重试等等问题,根据调查开发一个AI应用38%时间消耗在接口适配上。

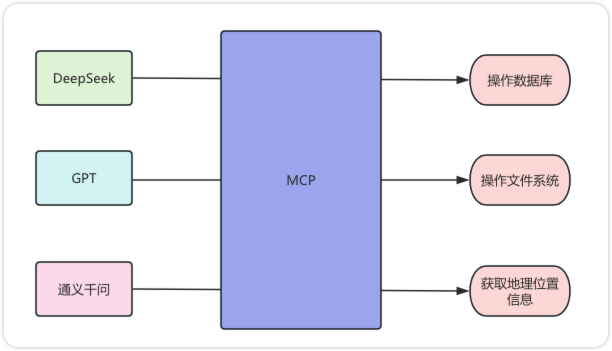

而MCP通过标准化协议,可以达到如下目的:一次开发,多模型通用:开发一个GitHub MCP服务,Claude、GPT等大模型都可以使用。在应用中,可以达到动态扩展工具的效果,即运行时发现新服务,无需重新开发,避免m×n问题。

三、MCP的通信方式

MCP通信方式主要分为两种:stdio方式、SSE方式

3.1 stdio方式

通过stdio(即Standard Input/Output)方式,适用于MCP客户端和MCP服务器在同一台机器上,主要的使用场景如操作本机数据库、执行本地命令等场景。

使用这种方式可靠性更高,因为操作都是在本地执行,并且通信方式简单,不需要依赖网络请求,server端响应速度更快。但使用前需要配置本地执行环境,并且如果大量服务都在本机,进程资源消耗更大。

3.2 流式 HTTP方式

通过流失Http(即Streamable HTTP),流式 HTTP 传输使用 HTTP POST 请求进行客户端到服务器通信,适用于实时数据更新、消息推送、轻量级监控和实时日志流等需求。配置过程简洁,主要通过提供目标服务URL建立连接。

四、MCP环境配置

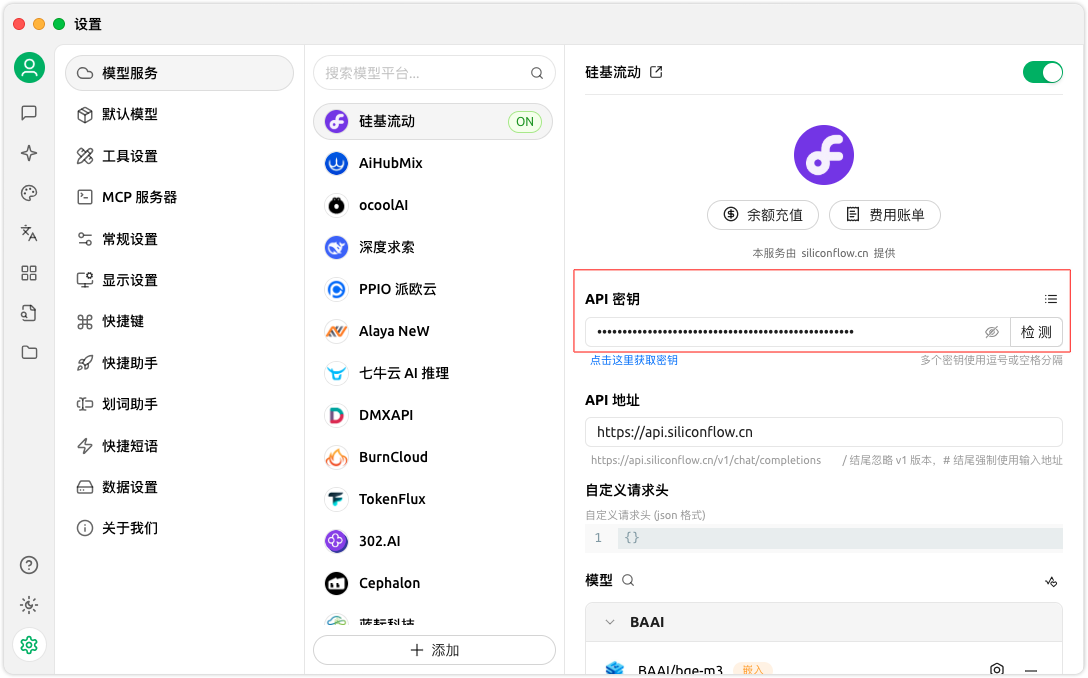

以Cherry Studio为例,在Cherry Studio中,首先配置使用大模型的API秘钥,这里配置的是硅基流动。

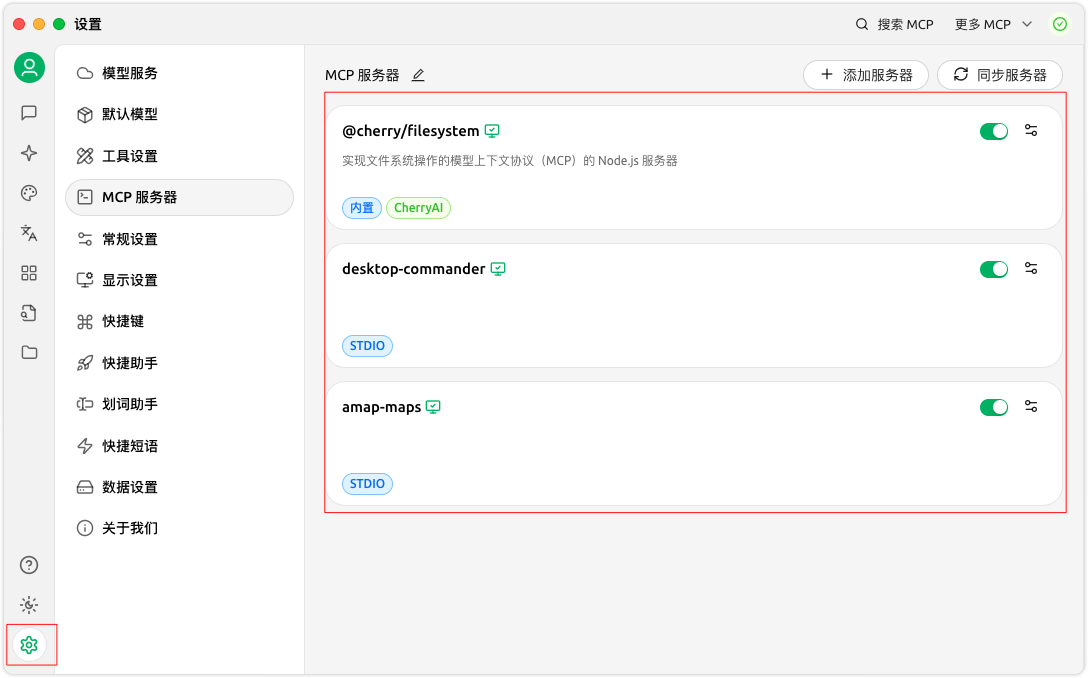

在设置中配置MCP服务器,如下配置了3个server,分别是本地操作文件、命令行执行、获取高德地图地理位置信息,并且通信方式都是stdio。

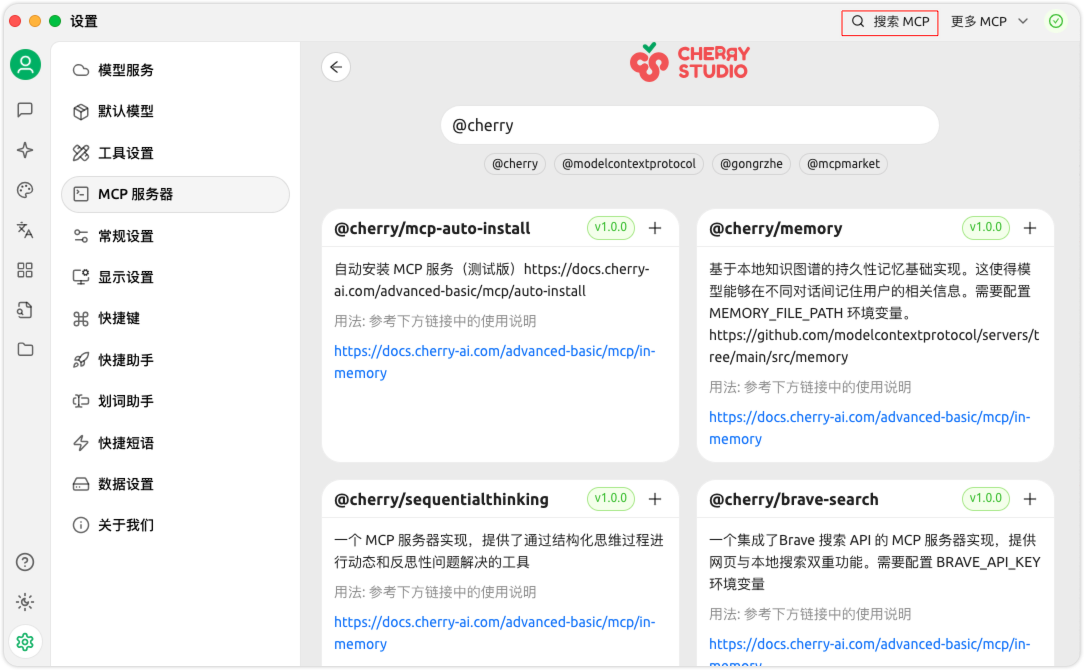

CherryStudio内置的server fileSystem可以直接从这里进行搜索。

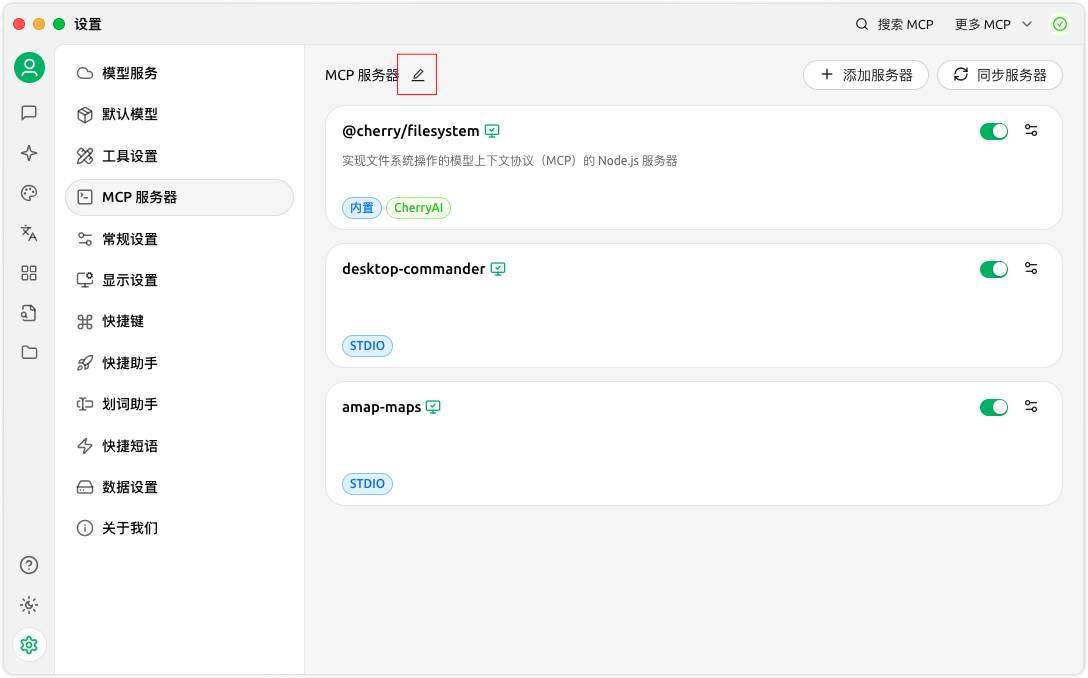

另外两个server可以通过mcp.json进行配置。

完整的mcp.json文件如下:

{

"mcpServers": {

"p6AShLq39VXrjmd_cJ7-a": {

"name": "@cherry/filesystem",

"type": "inMemory",

"description": "实现文件系统操作的模型上下文协议(MCP)的 Node.js 服务器",

"args": [

"/Users/username/Desktop",

"/path/to/other/allowed/dir"

],

"isActive": true,

"provider": "CherryAI"

},

"desktop-commander": {

"isActive": true,

"command": "npx",

"args": [

"-y",

"@wonderwhy-er/desktop-commander"

],

"name": "desktop-commander"

},

"amap-maps": {

"name": "amap-maps",

"type": "stdio",

"isActive": true,

"registryUrl": "",

"command": "npx",

"args": [

"-y",

"@amap/amap-maps-mcp-server"

],

"env": {

"AMAP_MAPS_API_KEY": "8cca998b0498cc43cc3b5fe0ea06a495"

}

}

}

}

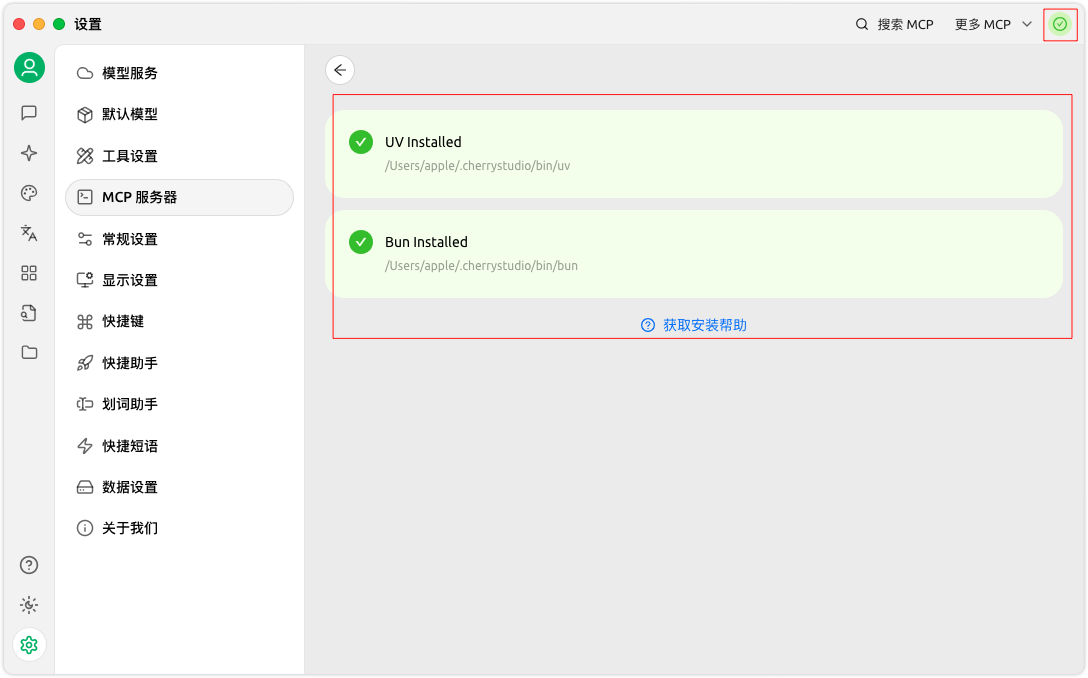

这里要注意的是,如果右上角是红色感叹号,点击感叹号把里面的两个服务安装好,并且本机要配置Python环境和Node环境。

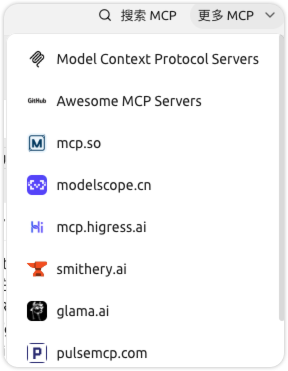

更多的mcp server可以通过,这些MCP Server网站进行查找,以下是Cherry Studio推荐的MCP Server网站。

五、MCP使用基础案例

下面在Cherry Studio中使用如下提示词,让大模型通过MCP工具去完成创建html网页的任务,这里使用的是DeepSeek-R1模型,提示词如下:

需要你完成以下任务

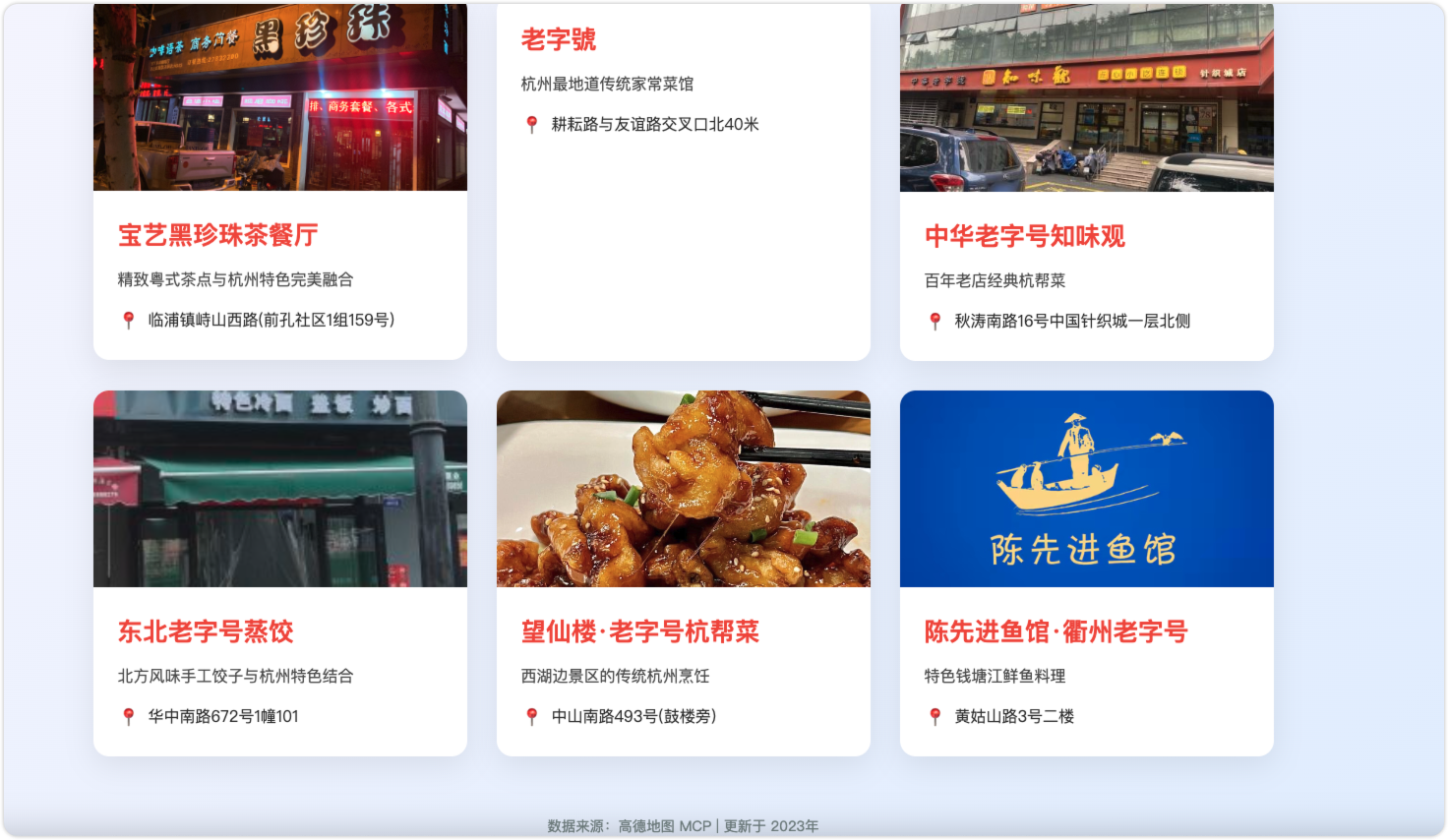

1、通过高德地图MCP推荐几家不错的杭州餐厅将相关餐厅信息保存到/Users/apple/Documents/ai,并命名为:餐厅.txt

2、根据txt文件的内容制作一个精美的html展示页面,命名为index.html放在/Users/apple/Documents/ai目录下,并确保这个html可以在macbook浏览器正常展示。

输入提示词

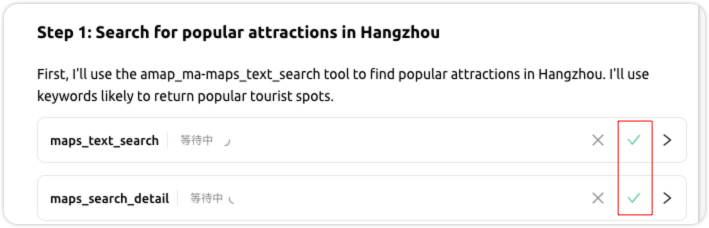

在大模型执行的过程中,需要调用mcp的地方需要我们确认之后才会执行,点击对号之后,就会正常执行,整个执行流程过程会比较长。

最终生成文件如下:

最终html页面效果

六、总结

本文介绍了什么是mcp以及mcp的基本使用方式,mcp协议作为AI模型与外部工具的交互的标准协议,将会结束各种大语言模型群雄争霸的局面,而一统江湖,随着各种强大的mcp server不断地涌现,有了这些强大工具的加持,相信在不远的将来大语言模型能力也会越来越强大。

864

864

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?