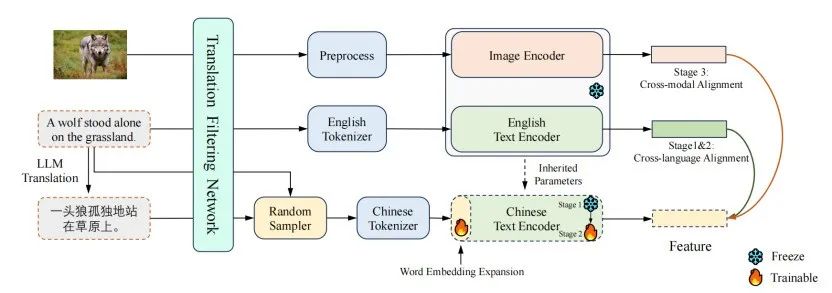

该文章还处于审稿状态,其介绍了一种名为YouCLIP的多语言跨模态学习模型,通过三阶段的高效微调方法将现有最强的英文CLIP模型转换为中文CLIP模型。YouCLIP以低成本实现了强大的性能,包括在COCO-CN等数据集上显著提升文本到图像的召回率(Recall@1)得分,同时保持在英文数据集(如ImageNet-1K)上的高性能。三阶段微调包括嵌入层对齐、标记融合和跨模态对齐。此外,作者提出了翻译过滤网络(TFN)以优化数据质量,从1.5亿对翻译对中筛选出高质量的1.2亿对。这种方法不仅在性能上超越了现有的中文CLIP模型,而且大幅减少了训练资源需求,并支持中英文双语使用。模型与代码将开源以促进社区发展。

1 YouCLIP多语言跨模态学习方法

1.三阶段微调框架

-

YouCLIP通过三阶段的微调流程,从现有的英文CLIP模型中派生出目标语言的模型(本文以中文为例)。以下是三个阶段的核心内容:

-

o第一阶段:嵌入层对齐

通过对齐中英文的嵌入层,将中文文本嵌入映射到与英文嵌入相同的空间,同时冻结Transformer的其他部分。这种对齐依赖于中文和英文的匹配文本特征相互接近,而非匹配特征被拉远。 -

o第二阶段:标记融合

处理不同语言间相同概念的标记数量差异问题,例如中文和英文的单词可能被分解为不同数量的标记。通过训练中文Transformer编码器的前半部分,实现多标记特征的融合。 -

o第三阶段:跨模态对齐

将经过前两阶段训练的中文文本编码器与图像编码器直接对齐,进一步消除中文和图像模态之间的差异,确保最终的跨模态一致性。

2.数据处理与优化

-

o翻译过滤网络(TFN)

利用英文和中文编码器对翻译的数据进行相似性评分,过滤掉低质量的翻译样本,以确保高质量的训练数据。 -

o三阶段中的数据采样

在训练中随机选择中英文数据进行混合训练,确保模型能够同时支持两种语言。

3.参数冻结与解冻策略

-

o在嵌入层对齐阶段,仅训练中文嵌入层,其余参数保持冻结。

-

o在标记融合阶段,训练中文Transformer的前半部分,其余部分冻结。

-

o在跨模态对齐阶段,解冻所有中文编码器的参数,同时使用图像编码器进行训练。

-

o通过模型继承机制,直接继承英文CLIP的图像编码器和Transformer层大部分参数,通过最小化训练部分参数,实现快速收敛和低成本的语言迁移。

2 结语

文章提出了一种名为YouCLIP的多语言跨模态学习方法,通过高效的三阶段微调将英文CLIP模型转化为性能领先的中文CLIP模型,显著提升了跨语言和跨模态任务的效率与效果,同时支持中英文双语。

论文题目: YouCLIP: Advancing Multilingual Cross-Modal Learning with Efficient Training

论文链接: https://openreview.net/forum?id=P7s4WYF1rf

PS: 欢迎大家扫码关注公众号^_^,我们一起在AI的世界中探索前行,期待共同进步!

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?