1.请简要介绍下SVM

svm是一个寻求最大间隔的分类器。它希望能在众多平面中找到一个可以很好划分数据的超平面,让离其最近的点到其的距离最大化。当数据线性可分的时候,用硬间隔svm,不允许有点出现在间隔之内(也就是划分错误的点);当数据近似线性可分的时候,用软间隔svm,允许少量点出现在间隔之内(也就是划分错误的点);当数据线性不可分的时候,通过使用核技巧及软间隔最大化,学习非线性支持向量机。

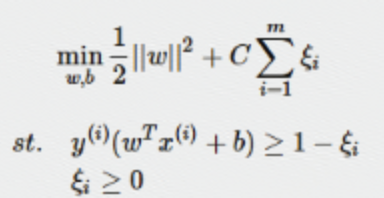

软间隔:

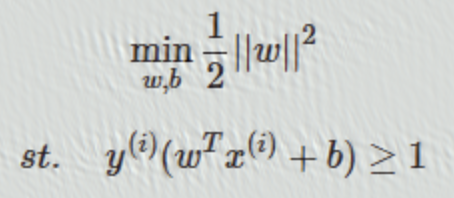

硬间隔:

损失函数:

2.请简要介绍下Tensorflow的计算图

Tensorflow 是通过计算图的形式来表示计算系统的。tensorflow中每一计算都是计算图中的一个节点,而节点与节点之间的连线则代表计算的依赖关系。一般分为两个步骤,构建图中的计算,然后通过会话执行计算。

3.逻辑回归LR

逻辑回归是一个有监督的学习,根据输入的x,y,学习它们之间的映射关系,预测的y值是一个单独值,是在线性回归的基础上套上了一个sigmoid函数,也就是说先把特征线性求和,然后通过sigmoid将值转换成[0,1]之间的概率,判断类别,实质上是一个二分类的判别器。LR的模型相对简单,在进行大规模线性分类时比较方便。

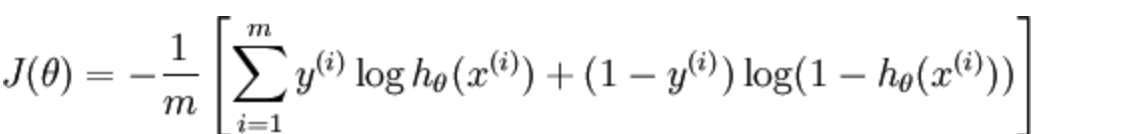

损失函数的推导:交叉熵函数

使用梯度下降法求解最优参数,使loss最小:

4.线性回归

线性回归是一个有监督的学习,通过输入的x,y,学习它们之间的映射,但是它的预测值y是一个连续值。

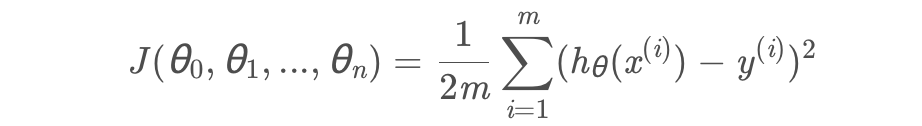

损失函数:线性回归的损失函数为平方损失函数

5.LR和SVM的联系与区别

联系:

LR和SVM都可以处理分类问题,且一般都用于处理线性二分类问题。都是有监督的分类算法,是判别模型。

区别:

LR是参数模型,SVM是非参数模型。LR使用的是交叉熵函数,svm是hinge loss(最大化间隔的距离), SVM的处理方法是只考虑Support Vectors,也就是和分类最相关的少数点,去学习分类器。

6.LR与线性回归的区别与联系

联系:

线性回归和逻辑回归都是线性模型,线性回归是狭义上的线性模型,逻辑回归是广义的线性模型,都是有监督的学习,学习x,y之间的映射关系。

区别:

线性回归的预测值y是一个连续值,使用的是最小化平方误差损失函数,是通过最小二乘法构建的,主要解决回归问题。

逻辑回归的预测值y是一个非连续值,它是在线性回归的基础上加了一个sigmoid函数,先把特征线性求和后转换成 [0,1]之间的概率,使用的是log损失函数,是通过似然函数构建的,解决的是分类问题。

总结:线性回归在整个实数域范围内进行预测,敏感度一致,而分类范围,需要在[0,1]。逻辑回归就是一种减小预测范围,将预测值限定为[0,1]间的一种回归模型,因而对于这类问题来说,逻辑回归的鲁棒性比线性回归的要好。

7.逻辑回归怎么实现多分类

方法一:为每个类别都建立一个分类器,每个分类器用来区分该类别和剩下的其他类别(1,0),预测的时候,根据每个分类器预测为某一类(1)的概率,最大值即为预测结果。

方法二:修改逻辑回归的损失函数,使用softmax函数构造模型解决多分类问题,softmax分类模型会有相同于类别数的输出,输出的值为对于样本属于各个类别的概率,最后对于样本进行预测的类型为概率值最高的那个类别。

8.生成模型和判别模型基本形式,有哪些

判别模型:由数据直接学习决策函数 Y = f(X),或者由条件分布概率 P(Y|X)作为预测模型,即判别模型。

生成模型:由数据学习联合概率密度分布函数 P(X,Y),然后求出条件概率分布P(Y|X)作为预测的模型,即生成模型。

由生成模型可以得到判别模型,但由判别模型得不到生成模型。

常见的判别模型有:K近邻、SVM、决策树、感知机、线性判别分析(LDA)、线性回归、传统的神经网络、逻辑回归、boosting、条件随机场

常见的生成模型有:朴素贝叶斯、隐马尔可夫模型、马尔科夫随机场

9.核函数

核函数的作用:

核函数就是把低维空间中线性不可分的点,转化成高维空间内线性可分的点。

核函数的种类及应用场景

线性核、多项式核、高斯核

线性核:当样本的特征很多且维数很高时可考虑用SVM的线性核函数,很多问题是线性可分的

高斯核:若特征数较少,样本数适中,对于时间不敏感,遇到的问题是线性不可分的时候可以使用高斯核来达到更好的效果。因为高斯核函数为一种局部性较强的核函数,无论对于大样本还是小样本均有较好的性能且相对于多项式核函数有较少的参数。

为什么高斯核能够拟合无穷维度

因为将泰勒展开式代入高斯核,将会得到一个无穷维度的映射。

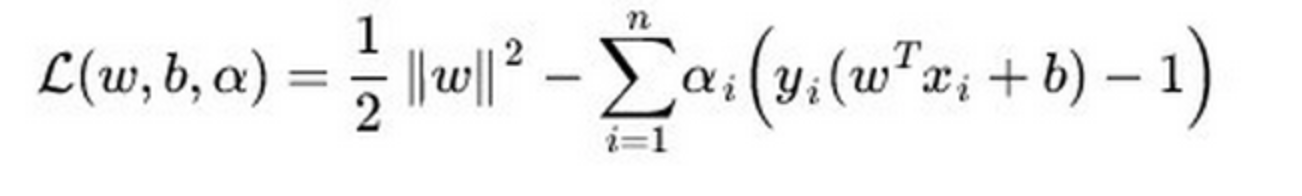

10.SVM使用对偶计算的目的是什么

目的有两个:一是方便核函数的引入;二是原问题的求解复杂度与特征的维数相关,而转成对偶问题后只与问题的变量个数有关。由于SVM的变量个数为支持向量的个数,相较于特征位数较少,因此转对偶问题。通过拉格朗日算子发使带约束的优化目标转为不带约束的优化函数,使得W和b的偏导数等于零,带入原来的式子,再通过转成对偶问题。

11.分类算法列一下有多少种?应用场景

单一的分类方法主要包括:LR逻辑回归,SVM支持向量机,DT决策树、NB朴素贝叶斯、NN人工神经网络、K-近邻;

集成学习算法:基于Bagging和Boosting算法思想,RF随机森林,GBDT,Adaboost,XGboost。

576

576

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?