1.1线性回归

在了解回归之前我们先看一张图:

1.1.1什么是回归?

建立方程模拟两个或者多个变量之间如何关联。被预测的变量叫做因变量(输出),被用来进行预测的变量叫自变量(输入).一元线性回归包含一个因变量和一个自变量.包含两个以上的变量叫多元线性回归.

1.1.2相关性

- 正相关:斜率大于0

- 负相关:斜率小于0

- 不相关:平行于x轴

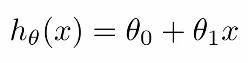

1.1.3代价函数(损失函数)

求解方法:最小二乘法

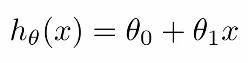

公式:

代价函数

使用正值进行评价,可以选择绝对值或者平方和.绝对值求导不方便.这里的系数1/2只是为了消除求导之后的系数,这里的m是为了求取所有样本数据的平均值.为了让拟合的效果更好,我们的代价函数越小越好.

不同的拟合曲线,代价函数的值不同.我们可以调节不同的权值来改变

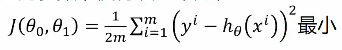

相关性系数:衡量线性相关性的强弱。用来描述两个变量相关性的强弱

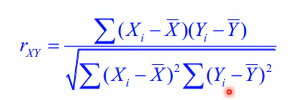

决定系数:描述两个变量之间的线性关系(用来描述拟合曲线和知识曲线之间的差距)

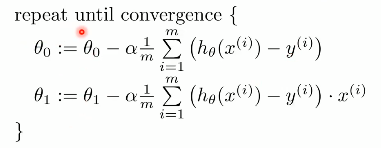

1.1.4梯度下降法

是一种优化算法,通过不断的迭代,改变和

的值,使得代价函数的值越来越小.目的是让代价函数的值不断的变小。步骤:

- 初始化权值

- 不断改变权值,直到代价函数达到全局最小值或者局部极小值。

- 如果想要将极小值变成最小值,我们可以使用分段函数先求取局部极小值,然后求取全局最小值.

缺点:可能得不到全局最小值,而得到局部极小值。

适用于:线性回归、神经网络等

注意点:学习率不能太小,太小可能会导致梯度小时;学习率不能太大,太大可能会导致梯度爆炸。

权值更新:必须同时更新和

- 如果是一个凸函数得到的可能是全局最小值,如果是非凸函数,得到的很可能是局部最小值。

- 在最小值的左边,斜率为负值,我们应该减去,在最小值右边,斜率为正值,我们应该加上。

代码实现:实现一元线性回归

import numpy as np

import matplotlib.pyplot as plt

data = np.genfromtxt("data.csv", delimiter=",")

x_data = data[:,0]

y_data = data[:,1]

print(x_data.shape,y_data.shape)

plt.scatter(x_data,y_data)

plt.show()

lr = 0.0001

b = (np.random.random())*2-1

k =(np.random.random())*2-1

epochs = 50

# 计算代价函数

def compute_error(b, k, x_data, y_data):

totalError = 0

for i in range(0, len(x_data)):

totalError += (y_data[i] - (k * x_data[i] + b)) ** 2

return totalError / float(len(x_data)) / 2.0

def gradient_descent_runner(x_data, y_data, b, k, lr, epochs):

m = float(len(x_data)) # 计算总数据量

for i in range(epochs): # 循环epochs次

b_grad = 0 # 初始化截距

k_grad = 0 # 初始化斜率

# 计算梯度的总和再求平均

for j in range(0, len(x_data)):

b_grad += (1/m) * (((k * x_data[j]) + b) - y_data[j])

k_grad += (1/m) * x_data[j] * (((k * x_data[j]) + b) - y_data[j])

# 更新b和k

b = b - (lr * b_grad)

k = k - (lr * k_grad)

# 每迭代5次,输出一次图像

if i % 5==0:

print("epochs:",i)

plt.plot(x_data, y_data, 'b.')

plt.plot(x_data, k*x_data + b, 'r')

plt.show()

return b, k

print("Starting b = {0}, k = {1}, error = {2}".format(b, k, compute_error(b, k, x_data, y_data)))

print("Running...")

b, k = gradient_descent_runner(x_data, y_data, b, k, lr, epochs)

print("After {0} iterations b = {1}, k = {2}, error = {3}".format(epochs, b, k, compute_error(b, k, x_data, y_data)))多元线性回归

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?