Backdoor Attack and Defense in Federated Generative Adversarial Network-based Medical Image Synthesis----《基于联邦生成对抗网络的医学图像合成中的后门攻击与防御》2023 Medical Image Analysis

背景:

- 由于联邦学习服务器无法访问原始数据,需要联合不可信的客户端来训练模型,容易受到后门攻击,因此,提出现有的后门攻击是否会影响GAN训练,如果会,在FL设置中如何防御攻击。

- 目前没有一种方法可以生成适合所有人群的合成数据,不同医疗机构之间的数据协作可以有效地构建一个可以从不同人群中学习的稳健模型。

- 大量医学图像自然呈现出后门触发器和噪声标签,这增强了后门研究在医学图像分析领域的重要性。但由于FL的去中心化特征,服务器不能直接检测到被攻击的图像。

引言

尽管深度学习对医疗保健研究产生了重大影响,但不可否认的是,与其他应用领域相比,深度学习在医疗保健领域的影响更为缓慢和有限。造成这种情况的一个重要原因是,广泛的机器学习研究难以获得患者数据,这很大程度上是由于患者隐私问题。尽管医疗保健提供商、政府和私营企业正越来越多地以电子方式收集大量和各种类型的患者数据,这些数据可能对科学家极其有价值,但由于病人的隐私问题,它们通常无法提供给更广泛的研究界。此外,即使研究人员能够获取这些数据,确保数据的正确使用和保护是一个受严格法律要求规范的漫长过程。这可能会显著减慢研究的进展速度,因此减少了研究对患者护理的益处。

高质量和真实性的合成数据集可用于加速医学方法论的进步(Dube 和 Gallagher,2013;Buczak 等,2010)。虽然有一些方法可以为电子健康记录生成医疗数据(Dube和Gallagher, 2013;Buczak等人,2010年),但医学图像的合成研究比较困难,因为医学图像是高维的。随着生成式对抗网络(GAN)的发展(Goodfellow et al., 2014),高维图像生成成为可能。特别是,有条件GAN (Mirza和Osindero, 2014)可以在给定的模式下生成有条件的图像,例如,根据标签构造图像来合成有标记的数据集。在医学图像合成领域,Teramoto等(2020)提出了一种渐进生长条件GAN生成肺癌图像,并得出合成图像可以辅助深度卷积神经网络训练的结论。Yu等人(2021)最近在宫颈细胞分类中使用了条件gan生成的异常细胞图片来解决类别失衡问题。此外,关于基于 GAN 的论证在医学图像中的作用的全面调查可以在 Shorten 和 Khoshgoftaar (2019) 中找到。

与大多数基于深度学习 (DL) 的任务一样,有限的数据资源始终是基于 GAN 的医学合成的挑战。此外,需要大量、多样化和具有代表性的数据集来发展和完善循证医学的最佳实践。然而,没有一种方法可以生成适用于所有人群的合成数据(Chen等人,2021年)。不同医疗机构之间的数据协作(由于个体或患者在性别、种族和地理位置上的表型异质性,以及在医疗系统、工作流程和使用的设备上的异质性)可以有效地构建一个可以从不同人群中学习的稳健模型。但数据收集的数据共享将导致数据隐私问题,可能会暴露患者信息(Malin et al., 2013;Scherer等人,2020)。联合学习(FL)(2016)是一种隐私保护工具,它将每个医疗机构(客户)的数据保存在本地,并与服务器交换模型权重,以协作学习一个全局模型。由于不需要数据共享,它是医疗保健领域的一种流行研究选择(Rieke等人,2020年;Usynin等人,2022)。Augenstein等人(2019)提出了联邦GAN (FedGAN)来分布地训练GAN用于数据合成;Rasouli等人(2020)。其抗攻击的整体鲁棒性还有待研究。

然而,作为一个开放系统,FL很容易受到恶意参与者的攻击,已经有研究深入研究了联邦场景中分类模型的各种攻击,如梯度反转攻击(Huang et al., 2021)、中毒和后门攻击(Bagdasaryan et al., 2020)。在带有分类模型的后门攻击中,攻击者(如恶意客户端)在其训练数据中添加一个“触发”信号,并将任何带有“触发”的图像识别为其他类(Saha等人,2020年)。一个“触发器”,比如一个带有随机噪声的小补丁,可能会导致样本被错分类到另一个类别。这种攻击利用了分类模型过度拟合触发器而不是实际图像的倾向(Bagdasaryan等人,2020)。值得注意的是,如图1所示,大量的医学图像自然呈现出后门触发器和噪声标签,这增强了后门研究在医学图像分析领域的重要性(Xue et al., 2022)。不幸的是,由于FL的去中心化特性,服务器不能直接检测到被攻击的图像,客户端在本地保存他们的私有数据。最近,一些研究发现后门附加客户端可能会导致 FL 分类性能大幅下降(Tolpegin 等人,2020;Sun 等人,2021)。这些事实启发我们思考后门攻击如何影响FL中的生成模型。

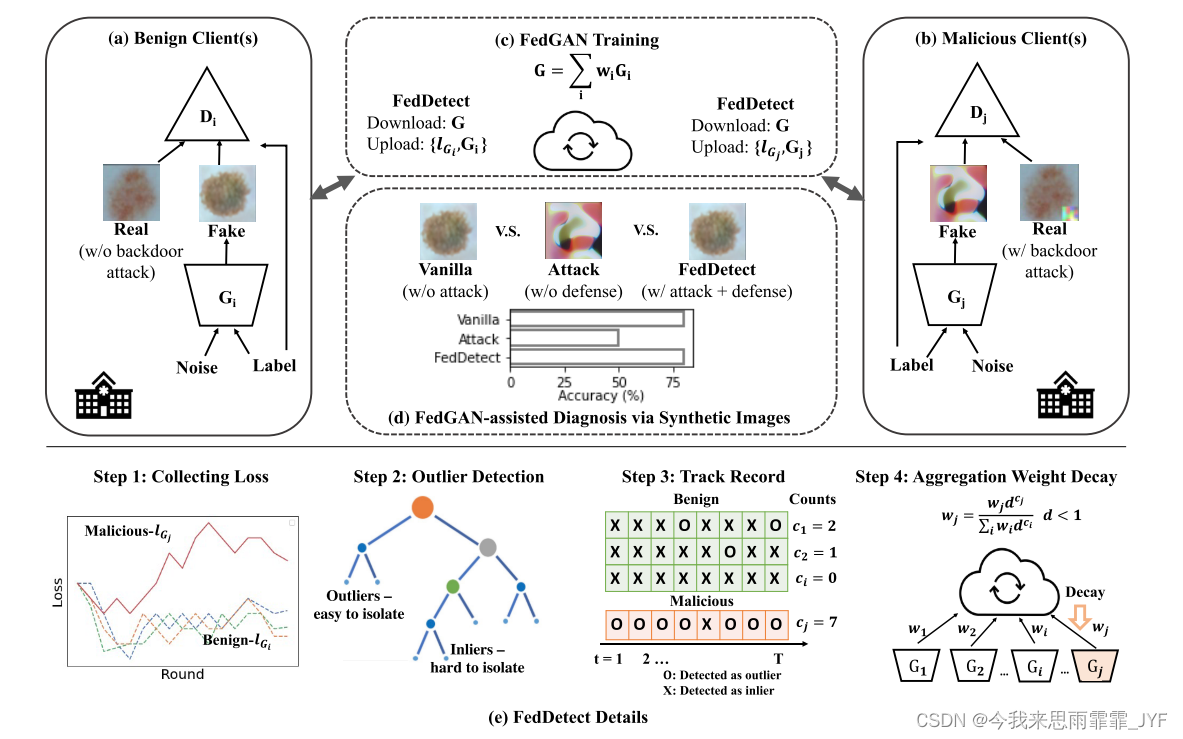

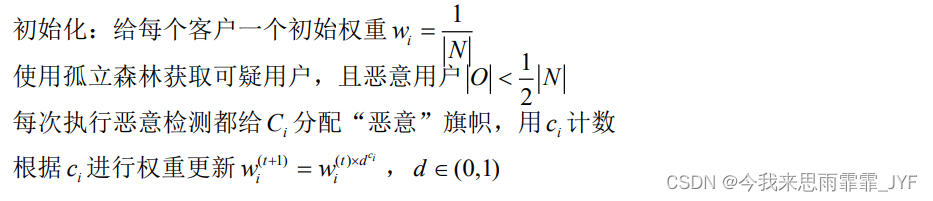

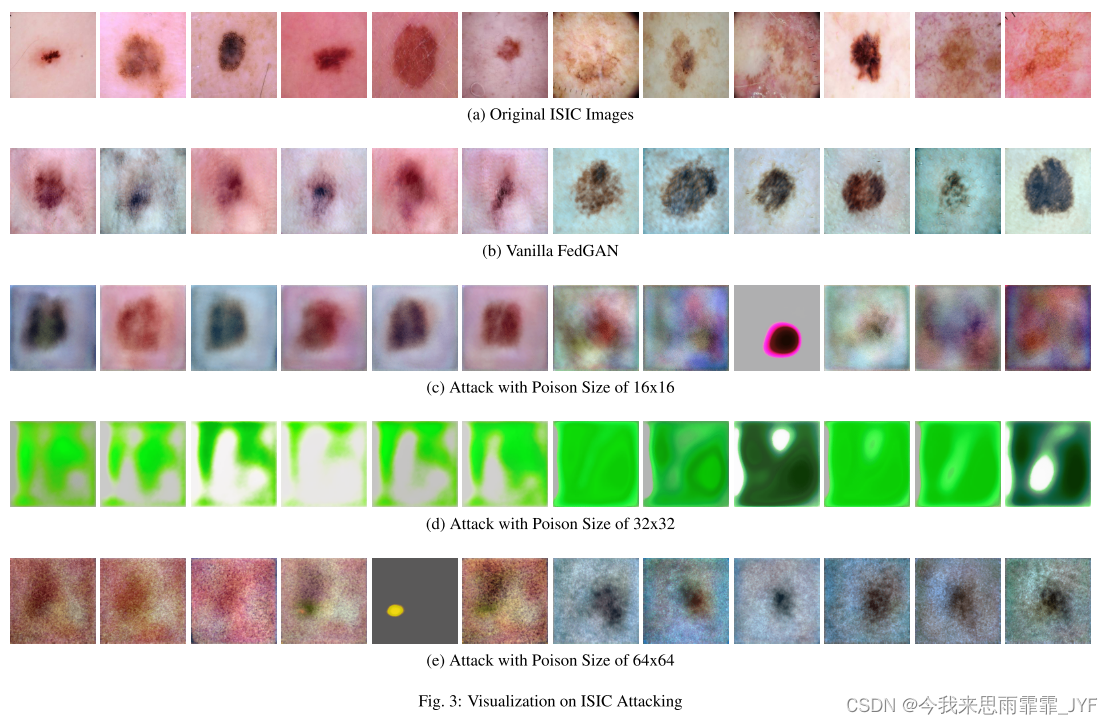

在本工作中,我们主要研究利用条件FedGAN合成标记医学图像中的后门攻击问题。在我们的实验中,我们使用了两个广泛使用的医学数据集。首先,我们演示了添加不同大小和类型的触发器(例如,添加不同样式和大小的patch,大小在原始图像大小的0.5%到6.25%之间)可以显著影响生成的图像的保真度。其次,我们提出了一种有效的防御机制FedDetect来检测恶意客户端。我们观察到,受攻击的判别器往往会过度拟合,从而产生不一致且不同的训练损失模式。因此,FedDetect在每次迭代中对客户端的共享训练损失进行异常检测,如果客户端在多次迭代中根据记录被检测为异常值,则将其标记为恶意。我们的结果首先定性地比较了FedDetect生成图像的可视化,以及在不同触发器大小的后门攻击下的备选防御策略。此外,以 FedGAN 辅助诊断作为 FedGAN 在医学领域作用的标志,我们定量评估了 FedGAN 辅助数据增强对深度学习训练、攻击和 FedDetect 的效果。结果表明,FedGAN 辅助的数据增强有效提高了深度学习训练的性能,而受攻击的 FedGAN 生成的合成医学图像却破坏了其效用,导致医疗效用价值较低。FedDetect 阻止了此类对抗性并构建了拜占庭稳健的 FedGAN(Fang 等人,2020)。

我们的贡献总结如下:

- 据我们所知,我们是第一个从实用的后门攻击角度来检验FedGAN健壮性的人,FedGAN 是一个很有前途的医疗数据合成流程。不失一般性,我们在两个公共医疗数据集上检查我们提出的流程、攻击和防御。

- 我们提出了一个通用的条件 FedGAN 流程,用于生成带标签的医疗数据集。我们将分类模型的后门攻击扩展到生成模型,并通过后门攻击揭示了条件FedGAN训练的脆弱性。我们研究了不同触发器大小和类型对攻击的影响。

- 我们提出了一种有效的防御策略 FedDetect 并将其与当前实践进行比较,以显示其在实现强大的 FedGAN 方面不可替代的作用。我们不仅通过检查合成数据的保真度来呈现定性结果,而且还定量评估它们作为数据增强以协助诊断模型训练的效用。我们展示了FedDetect在医学图像合成领域的实际应用和创新。

相关工作

条件生成对抗网络

GAN 最早由 Goodfellow 等人提出(2014),作为一种无监督生成算法,其中两个深度神经网络:鉴别器和生成器相互训练以优化最小最大目标函数方程。 GAN 已被用来生成医学图像数据集,以进行数据增强和用于开放研究的数据共享,因为医疗机构受到法规约束,不能发布其收集的私人数据(Chen 等人,2022年;Lin 等人,2022年)。

后来,Mirza 和 Osindero(2014)实现了条件 GAN,将 GAN 变成了监督学习算法,在这种情况下,鉴别器和生成器都采用额外的辅助标签,以便根据更新的目标函数生成与给定标签有关的图像。利用条件GAN生成合成医疗数据在医疗场景中具有更大的实用价值。因为医疗数据通常是有标签的,这个标签使其对诊断有意义,例如,用于对特定患者是否患有该疾病进行分类(Frangi等人,2018),以及用于数据扩充(Chen等人,2022)。

联邦学习

训练DL模型通常需要大量的训练数据。然而,在医疗保健领域收集数据是一项挑战,因为医疗保健提供者、政府以及相关医疗机构必须特别注意患者的隐私,并保证其收集的数据的正确使用(Price和Cohen, 2019)。在这种情况下,当地医疗机构的有限数据通常是有偏见和片面的(Wang et al., 2020b),这反过来又阻碍了医疗保健中的人工智能辅助诊断技术的应用(Van Panhuis et al., 2014)。

FL已被提出作为一项有前途的战略,以促进若干机构(例如,分布在不同地理位置的医疗中心)之间的合作,以培训全球DL模式(2016年)。鉴于FL在利用来自分布地点的医疗数据和基于DL的合成模型在医学中的实际应用方面发挥的重要作用,将它们结合在一起将有助于促进医学的进步。之前的研究试图建立FedGAN (Rasouli et al., 2020),并探索其在差异隐私方面的鲁棒性(Augenstein et al., 2019)。

此外,拜占庭-鲁棒FL是FL部署中的一个关键挑战,因为客户端几乎无法控制,通常被视为一个开放系统。文献表明,FL易受多种敌人的攻击(Bouacida和Mohapatra, 2021;刘等,2022)。例如漏洞包括模型中毒攻击(Bhagoji等人,2019年)、梯度反演攻击(Huang等人,2021年)、推理攻击(Ying等人,2020年)、后门攻击(Li等人,2022年)等。

后门攻击

后门攻击者的目标是在训练数据中嵌入一个后门,也称为触发器,以破坏深度神经网络的性能。由于涉及数据投毒,属于数据投毒攻击领域,在支持向量机、统计机器学习、DL等多个机器学习领域得到了广泛的探索(Biggio et al., 2012;Nelson等人,2008)。在DL中,目前的研究主要是在集中式分类模型中探索投毒攻击,其中隐藏的触发器粘贴在一些错误标签的训练数据上。攻击者在测试期间激活它,使得分类模型对带有触发器的图像产生较低的测试精度(Saha 等人, 2020)。这种攻击策略利用了深度神经网络更容易学习后门模式而不是实际图像的趋势(Li等,2022)。

由于FL的分布式特性,服务器对客户端几乎没有控制权。也就是说,FL 更容易受到后门和中毒攻击。现有研究从不同角度探讨了分类模型中的此类攻击。Bagdasaryan(2020)提议使用应用模型替换作为将后门功能引入 FL 内全局模型的方法。方等人(2020) 引入了针对 FL 拜占庭鲁棒性的局部模型中毒攻击的初始概念。王等人(2020a)引入了边缘情况后门的新概念,它操纵模型对看似简单的输入进行错误分类,而这些输入极不可能成为训练或测试数据的一部分。孙等人 (2019) 对 FL 分类模型中的后门攻击和防御策略进行了彻底的研究。

现有的后门攻击主要集中在分类模型上。尽管如此,针对 GAN 的后门攻击的适用性尚未得到充分探索,特别是在医学领域。这是因为针对 GAN 的后门攻击更加复杂,因为 GAN 的输入是噪声向量,而输出是生成的新图像。分类模型的 FL 后门最初由 Bagdasaryan 等人引入(2020),其中应用约束和规模技术来放大客户端的恶意梯度。在研究中,当地客户可以灵活地采用当地的培训程序。然而,这种情况不太可能发生在医疗环境中,因为FL的组织者可以在可靠的硬件上执行适当的培训程序,以防止恶意客户采取敌对行动(Pillutla等人,2019年)。与之前的后门联邦分类研究相比,我们假设存在一个可靠的FL管道,每个客户端都遵循提供的训练规则来计算和更新正确的参数,而不修改它们,从而按照可信服务器(即FL的组织者)给出的指令执行给定的培训过程。然后,我们研究后门攻击如何影响GAN的数据合成在这个FL设置。

防范后门攻击

后门攻击的防御策略有多种,从数据级别到模型级别,但重点是集中训练中的分类模型。数据层面的防御主要包括两个角度:1) 检测触发模式,然后将其从数据中消除,或者添加触发拦截器以减少后门在训练 DL 模型期间的贡献(Doan 等人,2020)。2)在将数据输入模型之前执行一系列数据论证(例如缩小、翻转)(Qiu et al., 2021;Villarreal-Vasquez and Bhargava, 2020)。这是因为过渡后门攻击对触发器的模式和后门补丁的位置很敏感(Li et al., 2021b)。

模型级防御策略还有更多: 1)重构被攻击模型策略。该策略旨在使用一些良性样本重新训练经过训练的攻击者模型,以减轻后门攻击。2) 综合触发防御策略。它试图通过重建特定的触发器对DL模型进行离群检测(Wang等人,2019;Harikumar等人,2020)或触发分布(Zhu等人,2020;郭等,2020)。3)通过元分类器诊断受攻击模型。该方法应用某些预先训练的分类器来识别潜在感染的模型并防止部署它们(Kolouri 等人,2020;Zheng 等人,2021)。4)不学习受感染模型。遗忘策略首先检测恶意行为,然后利用隐式超梯度(Zeng et al., 2021a)或修改损失函数(Li et al., 2021a)进行反向学习来防御后门攻击。5)鲁棒聚合。这个策略是专门为FL定制的。它涉及对服务器聚合学习率的细致调整,考虑到每个维度和每轮的客户端更新(Pillutla 等人,2019)。6)对抗性蒸馏。这种防御策略也是为 FL 中的分类任务而设计的。它在服务器端使用 GAN 来获取蒸馏数据集。随后,应用知识蒸馏,利用干净的模型作为老师来教育服务器模型并从恶意模型中删除后门神经元(Zhu et al., 2023)。7) 触发逆向工程。这是一种可证明的技术,专门针对 FL 分类模型下的后门攻击而提出(Zhang 等人,2022)。这需要良性客户端在训练时应用触发反转技术,以构建一个增强数据集,其中包括带有干净标签的受污染图像。这起到了模型强化的作用,并降低了后门样本的预测置信度。然后,推理步骤利用此预测置信度来执行分类任务。此外,全面的后门攻击调查可以在 Li 等人中找到。 (2022)和郭等人。 (2022)。

不幸的是,上述大多数防御策略都不适合 FedGAN 设置,要么是由于服务器无法访问本地私有数据,要么是基于 GAN 的生成模型的训练与分类模型的行为不同。

方法:

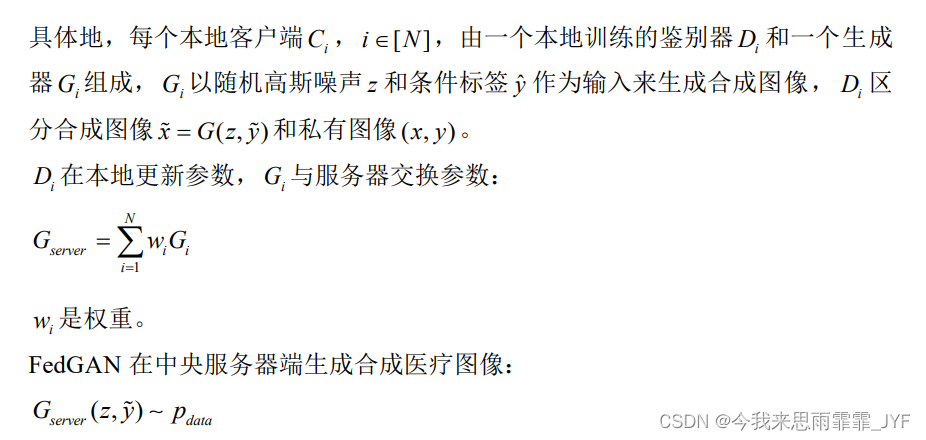

1、联邦生成对抗网络

FedGAN框架的训练策略是对共享模型参数进行平均,即FedAvg。在本地训练判别器和生成器对,与服务器共享生成器参数。

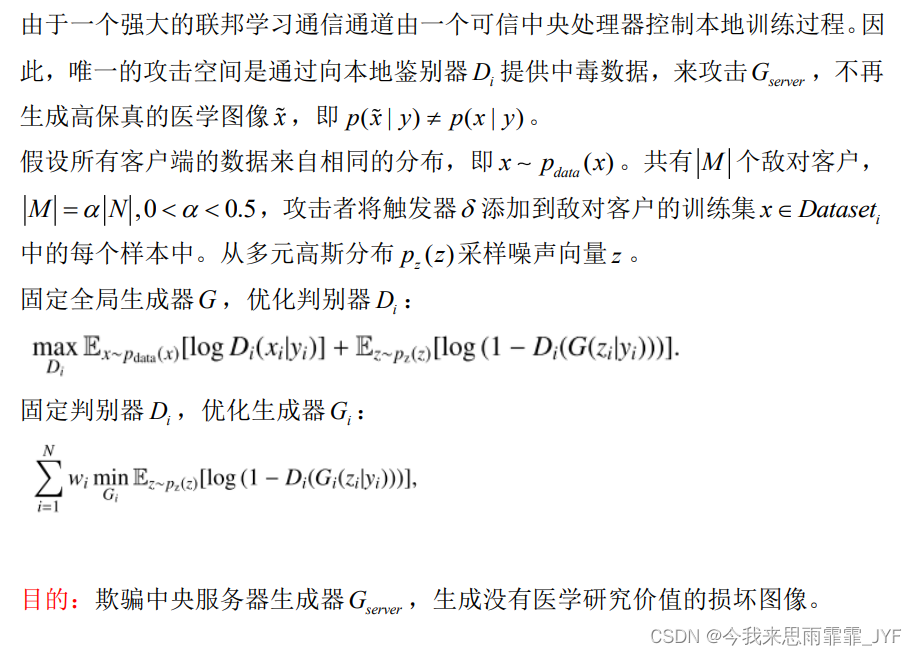

2、后门攻击策略(毒害训练数据)

攻击者执行后门攻击的目的是破坏拜占庭鲁棒的FedGAN,导致模型发散或收敛到次优。

3、后门防御策略(FedDetect)

可疑客户端检测:

鲁棒聚合的自适应权重:

实验

设置4个客户端,其中1个为恶意用户,另外3个为正常用户。

总结:

未来工作将扩大FL系统的客户端,将FedDetect推广到其他深层模型,如扩散模型,或考虑后门攻击的其他变体,如频域注入。

952

952

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?