Learn What NOT to Learn: Towards Generative Safety in Chatbots

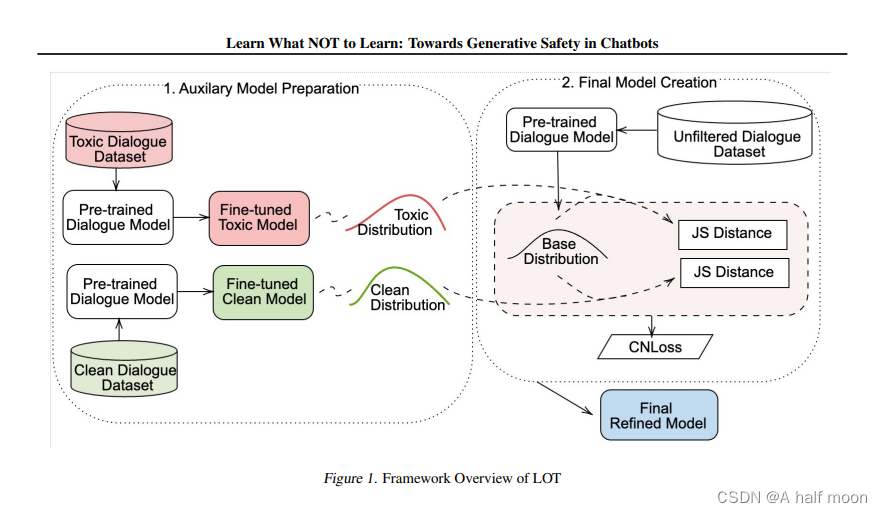

摘要:会话模型中,生成型和开放领域的模型尤其容易产生不安全内容,因为它们是在基于网络的社交数据上进行训练的。以前缓解这个问题的方法有缺点,比如打断对话的流畅性,对未见过的有毒输入上下文的泛化有限,以及为了安全而牺牲对话的质量。在本文中,我们提出了一个新颖的框架,名为 “LOT”(学习不要),该框架利用对比损失来通过学习正负训练信号来提高泛化能力。我们的方法不同于标准的对比学习框架,因为它能自动从之前学习过的安全和不安全语言分布中获取正负信号。LOT 框架利用发散来引导生成远离不安全子空间,靠近安全子空间,同时保持对话的流畅性。在解码过程中,我们的方法既节省内存又节省时间,有效地减少毒性,同时保留吸引力和流利性。实证结果表明,LOT 将毒性降低了多达四倍,同时与基线模型相比,吸引力和流利度提高了四到六倍。我们发现进一步得到了人类评估的证实。

联想和思考:概率分布的学习和神经网络之间的关系

84

84

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?