| 论文题目 | MobileNetV2: Inverted Residuals and Linear Bottlenecks |

| 作者 | Mark Sandler; Andrew Howard; Menglong Zhu; Andrey Zhmoginov; Liang-Chieh Chen |

| 论文链接 | MobileNetV2: Inverted Residuals and Linear Bottlenecks | IEEE Conference Publication | IEEE Xplore |

1、Depthwise Separable Convolutions

深度可分离卷积(deothwise separable convolutions)是许多高效神经网络的重要组成部件。一个标准的卷积,输入的张量维度是,对其使用一个卷积操作,卷积核

,输出的特征图维度为

。一个标准的卷积的计算成本为

。而一个深度可分离卷积的计算成本为

。相较于传统卷积,计算成本可以减少

倍。

2、 Linear Bottlenecks

文章3.2节读了并不是很懂,看代码应该就是在深度可分离卷积中,降维用的1x1卷积不使用非线性激活,如果有理解的大神可以评论区交流一下。

文章强调了两个属性,它们表明需要关注的流形(the manifold of interest,翻译软件直接翻译)应位于高维激活空间的低维子空间中:

- 如果感兴趣的流形在ReLU变换后仍保持非零量,则它对应于线性变换。

- ReLU能够保存关于输入流形的完整信息,但仅当输入流形位于输入空间的低维子空间时。

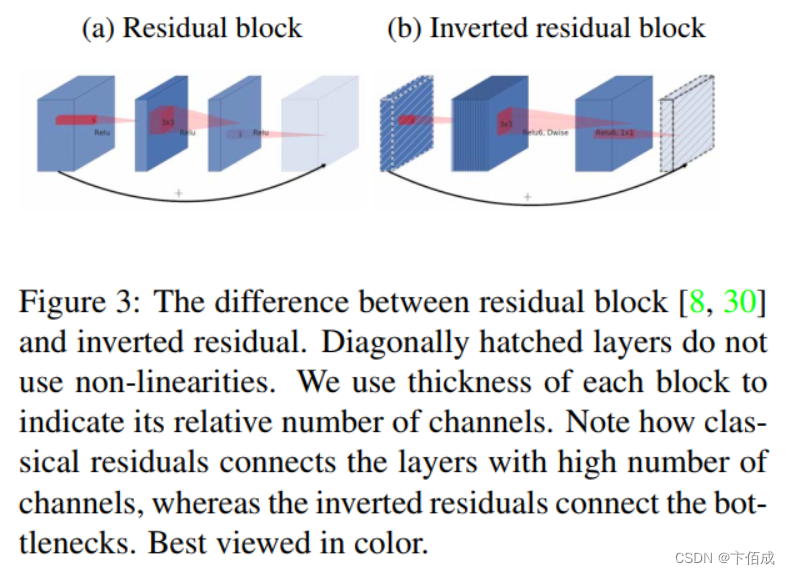

3、 Inverted residuals

倒残差结构类似于残差结构,不同于传统残差结构两头大中间小,倒残差结构先升维再降维,两头小中间大。作者想提高梯度传播的能力,在实验中表现优于传统残差结构,同时内存效率更高。

5649

5649

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?