Cityscapes

像素级分割一个很常用的数据集,原图存放在leftImg8bit文件夹中,精细标注的数据存放在gtFine (gt : ground truth) 文件夹中 ,训练集(train)2975张,验证集(val)500张,测试集(test)1525张,都是有相应的标签的,其中,训练集和验证集有label,测试集没有label,只能去官网提交得到指标

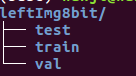

leftImg8bit/的文件结构:存放的是1024*2048的图片,图片名为munster(城市)_000000(第几张图)_000019_leftImg8bit.png

gtFine/的文件结构:gtFine中train,test的子目录为城市名

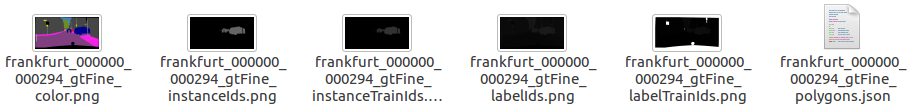

子目录中每一张图片的标注分为6种,

- gtFine_color.png 可视化的分割图

- gtFine_instaceIds.png 实例分割标注文件

- gtFine_instanceTrainIds.png 实例标注文件,只包含了在label.py中’hasInstances’=True的物体,总计标记了10类

- gtFine_labelIds.png 语义分割标注文件,分割一般使用此文件

- gtFine_labelTrainIds.png 语义分割标注文件,labelTrainIds.png只标记了18类(trainid列的值不为255的类别),其他类别都设置为255,所以labelTrainIds.png中会有很多白色色块,就是代表了所谓非18类之外的背景色块

- gtFine_polygons.json 存储的是各个类和相应的区域(用多边形顶点的位置表示区域的边界)

Kitti

包含市区、乡村和高速公路等场景采集的真实图像数据,每张图像中最多达 15 辆车和 30 个行人,还有各种程度的遮挡与截断。 3D 目标检测数据集由 7481个训练图像和 7518 个测试图像以及相应的点云数据组成,包括总共 80256个标记对象

数据集下载地址:彩色图像数据(12GB)、点云数据(29GB)、相机矫正数据(16MB)、标签数据(5MB)。其中彩色图像数据、点云数据、相机矫正数据均包含 training(7481)和 testing(7518)两个部分,标签数据只有 training 数据

training文件夹包括:image,velodyne,calib,label四个文件夹

-

image:图像以 8 位 PNG 格式存储

-

velodyne:激光雷达的测量数据(绕其垂直轴(逆时针)连续旋转),点云数据以浮点二进制文件格式存储,每行包含 8 个数据,每个数据由四位十六进制数表示(浮点数),每个数据通过空格隔开。一个点云数据由四个浮点数数据构成,分别表示点云的 x、y、z、r(强度 or 反射值),点云的存储方式如下表所示:

-

calib:是相机、雷达、惯导等传感器的矫正数据

-

label:KITTI 中 object 的标签和评估数据

物体类别:总共有 9 类,Car、Van、Truck、Pedestrian、Person_sitting、Cyclist、Tram、Misc、DontCare。其中 DontCare 标签表示该区域没有被标注,比如由于目标物体距离激光雷达太远。为了防止在评估过程中(主要是计算 precision),将本来是目标物体但是因为某些原因而没有标注的区域统计为假阳性 (false positives),评估脚本会自动忽略 DontCare 区域的预测结果

dimensions:该属性表示在相机坐标系下,当物体正对着相机的时候,该物体的高度值、宽度值和长度值(单位为米) ,也就是物体的实际长宽高值。

location:表示物体底部中心的(x, y, z)坐标值,而不是物体正中心的(x, y, z)坐标值,这里的xyz是在相机坐标系下3D物体的中心点位置。

物体的观察角度(alpha):取值范围为:-pi ~ pi(单位:rad),它表示在相机坐标系下,以相机原点为中心,相机原点到物体中心的连线为半径,将物体绕相机 y 轴旋转至相机 z 轴,此时物体方向与相机 x 轴的夹角(camera:z向上,y向内 ,x向右)

3D 物体的空间方向(rotation_y):取值范围为:-pi ~ pi(单位:rad),它表示,在照相机坐标系下,物体的全局方向角(物体前进方向与相机坐标系 x 轴的夹角),camera坐标系是y轴朝下的,rotation_y和alpha是(x,z)平面的角,那么我们用右手握住y轴,大拇指朝下,那么这个时候顺时针就是正角,逆时针就是负角,x轴起始,对于lidar坐标系,逆时针为正,顺时针为负,x轴起始

rotation_y 和 alpha的关系:alpha + arctan(x/z) = rotation_y

Kitti数据集可视化github

Market1501

Market-1501 数据集在清华大学校园中采集,夏天拍摄,在 2015 年构建并公开。它包括由6个摄像头(其中5个高清摄像头和1个低清摄像头)拍摄到的 1501 个行人、32668 个检测到的行人矩形框。每个行人至少由2个摄像头捕获到,并且在一个摄像头中可能具有多张图像。训练集有 751 人,包含 12,936 张图像,平均每个人有 17.2 张训练数据;测试集有 750 人,包含 19,732 张图像,平均每个人有 26.3 张测试数据。3368 张查询图像的行人检测矩形框是人工绘制的,而 gallery 中的行人检测矩形框则是使用DPM检测器检测得到的。

数据集下载地址:https://pan.baidu.com/s/1ntIi2Op

文件目录结构:

├── bounding_box_test(750 人,包含 19732 张图像)

│ ├── 0000_c1s1_000151_01.jpg

│ ├── 0000_c1s1_000376_03.jpg

│ ├── 0000_c1s1_001051_02.jpg

│

├── bounding_box_train(751 人,包含 12936 张图像)

│ ├── 0002_c1s1_000451_03.jpg

│ ├── 0002_c1s1_000551_01.jpg

│ ├── 0002_c1s1_000801_01.jpg

│

├── gt_bbox(手工标注的bounding box,用于判断DPM检测的bounding box是不是一个好的box)

│ ├── 0001_c1s1_001051_00.jpg

│ ├── 0001_c1s1_009376_00.jpg

│ ├── 0001_c2s1_001976_00.jpg

│

├── gt_query(判断一个query的哪些图片是好的匹配(同一个人不同摄像头的图像)和不好的匹配(同一个人同一个摄像头的图像或非同一个人的图像))

│ ├── 0001_c1s1_001051_00_good.mat

│ ├── 0001_c1s1_001051_00_junk.mat

│

├── query(750 人在每个摄像头中随机选择一张图像作为query,因此一个人的query最多有 6 个,共 3368 张图像,与test中的数据不重复)

│ ├── 0001_c1s1_001051_00.jpg

│ ├── 0001_c2s1_000301_00.jpg

│ ├── 0001_c3s1_000551_00.jpg

└── readme.txt

图片命名规则:

0001_c1s1_000151_01.jpg

- 0001 表示每个人的标签编号,从0001到1501

- c1 表示第一个摄像头(camera1),共有6个摄像头

- s1 表示第一个录像片段(sequece1),每个摄像机都有数个录像段

- 000151 表示 c1s1 的第000151帧图片,视频帧率25fps

- 01 表示 c1s1_001051 这一帧上的第1个检测框,由于采用DPM检测器,对于每一帧上的行人可能会框出好几个bbox。00 表示手工标注框

VeRi-776

Github:数据集

为了促进车辆重识别(Re-Id)的研究,我们在现实世界城市监控场景中建立了一个名为VeRi的车辆重识别的大规模基准数据集。 VeRi的特点:

-

20台摄像机在1KM^2的城市区域内24小时拍摄而来,包含776辆车的超过50,000张图像。

-

图像是在真实世界的无约束监视场景中捕获的,并标注不同的属性,例如: BBox,类型,颜色和品牌。

-

每辆车在不同的视点,照明,分辨率和遮挡下由2~18台摄像机拍摄。

-

还标注了足够的车牌和时空信息,例如板块的BBox,车牌号,拍摄的时间戳以及相邻相机之间的距离。

文件目录结构:

├── camera_Dist.txt(任意相机对之间的距离矩阵)

├── camera_ID.txt(20个相机的ID)

├── gt_index.txt(每一行列出了相应查询图像的真实匹配图像索引)

├── image_query(包含1678张查询图像)

├── image_test(包含11579张测试图像,200类车辆)

├── image_train(包含37778张训练图像,576类车辆)

├── jk_index.txt(每一行列出了相应查询图像的junk图像索引,junk图像指的是和查询图像具有相同相机ID的的图像)

├── list_color.txt(标签中数字对应的颜色类别)

├── list_type.txt(标签中数字对应的车型类别)

├── name_query.txt(查询图像的名称列表)

├── name_test.txt(测试图像的名称列表)

├── name_train.txt(训练图像的名称列表)

├── ReadMe.txt

├── test_label.xml(测试图像的标签:车辆ID,相机ID,颜色,类型)

├── test_track.txt(全部测试track,每个track大约包含6张同一相机拍摄的同一车辆图像,一共有2021类映射关系)

├── train_label.xml(训练图像的标签:车辆ID,相机ID,颜色,类型)

└── YongtaiPoint_Google.jpg(标注相机位置的地图)

参考博客:

Cityscapes踩坑记录

KITTI Dataset

5999

5999

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?