写在前面

从今天开始,我准备学习ML了,开此专栏记录自己学习周志华老师的《机器学习》一书的心得和相关笔记,能够帮助到你们的小伙伴可以关注一哈喔~

郑重声明:本人目前仅在CSDN这一个平台发布文章,其他小伙伴如果想转载 或者引用请注明引用来源,未经许可不得直接搬运,请尊重创作人的劳动成果,谢谢!

一、思维导图

绪论部分整体知识还是比较简单的,为了帮助理解,我绘制了一个思维导图,可以使知识一目了然。

思维导图

二、基本术语

引言部分没什么好说的,大家感兴趣的话可以看一下原书,这里我先介绍机器学习中的一些基本术语。

假设我们收集了⼀批西瓜的数据,例如:(色泽=青绿;根蒂=蜷缩;敲声=浊响), (色泽=乌黑;根蒂=稍蜷;敲声=沉闷), (色泽=浅白;根蒂=硬挺;敲声=清脆)……每对括号内就是⼀个西瓜的记录。

- 定义:所有西瓜记录的集合为:数据集。

- 每⼀条记录为:⼀个实例(instance)或样本(sample)。

- 单个的特点为特征(feature)或属性(attribute),例如:色泽或敲声。

- 对于⼀条记录,如果在坐标轴上表示,每个西瓜都可以用坐标轴中的⼀个点表示,⼀个点也是⼀个向量,例如(青绿,蜷缩,浊响),即每个西瓜为:⼀个三维的特征向量(feature vector)。

- ⼀个样本的特征数为:维数(dimensionality),该西瓜的例子维数为3。

当维数非常大时,也就是现在说的“维数灾难”。计算机程序学习经验数据生成算法模型的过程中,每⼀条记录称为⼀个“训练样本”,同时在训练好模型后,我们希望使用新的样本来测试模型的效果,则每⼀个新的样本称为⼀个“测试样本”。定义:

- 所有训练样本的集合为:训练集(trainning set),[特殊]。

- 所有测试样本的集合为:测试集(test set),[⼀般]。

- 机器学习出来的模型适用于新样本的能⼒为:泛化能力(generalization),即从特殊到⼀般。

西瓜的例子中,我们是想计算机通过学习西瓜的特征数据,训练出⼀个决策模型,来判断⼀个新的西瓜是否是好瓜。可以得知我们预测的是:西瓜是好是坏,即好瓜与差瓜两种,是离散值。同样地,也有通过历年的人口数据,来预测未来的人口数量,人口数量则是连续值。

定义:

- 预测值为离散值的问题为:分类(classification)。

- 预测值为连续值的问题为:回归(regression)。

我们预测西瓜是否是好瓜的过程中,很明显对于训练集中的西瓜,我们事先已经知道了该瓜是否是好瓜,学习器通过学习这些好⽠或差瓜的特征,从而总结出规律,即训练集中的西瓜我们都做了标记,称为标记信息。但也有没有标记信息的情形,例如:我们想将⼀堆西瓜根据特征分成两个小堆,使得某⼀堆的西瓜尽可能相似,即都是好瓜或差差,对于这种问题,我们事先并不知道西瓜的好坏,样本没有标记信息。

定义:

- 训练数据有标记信息的学习任务为:监督学习(supervised

learning),容易知道上面所描述的分类和回归都是监督学习的范畴。 - 训练数据没有标记信息的学习任务为:无监督学习(unsupervised learning),常见的有聚类和关联规则。

三、假设空间

归纳(induction) 与演绎(deduction)是科学推理的两大基本手段.前者是从特殊到一般的"泛化" (generalization) 过程,即从具体的事实归结出一般性规律;后者则是从一般到特殊的"特化" (specializatio叫过程,即从基础原理推演出具体状况;而"从样例中学习"显然是一个归纳的过程因此亦称"归纳学习" (inductive learning)。

归纳学习有狭义与广义之分,广义的归纳学习大体相当于从样例中学习,而狭义的归纳学习则要求从训练数据中学得概念(concept) ,因此亦称为"概念学习"或"概念形成"。概念学习中最基本的是布尔概念学习,即对"是" “不是"这样的可表示0/1 布尔值的目标概念的学习。

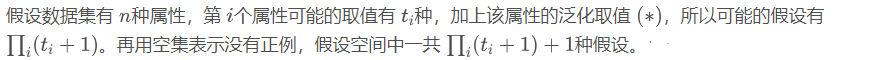

我们用 m 表示这 个假设,这样,若"色泽” “根蒂” "敲声"分别有3、 2、 2 种可能取值,则我们面临的假设空间规模大小为 4 x 3 x 3 + 1 = 37。具体算法如下:

四、归纳偏好

现在有三个与训练集一致的假设,但与他们对应的模型在面临新样本的时候,却会产生不同的输出。根据仅有的训练样本无法判断三个假设中哪个“更好”。对于一个具体的学习算法而言,它必须要产生一个模型,这时,学习算法本身的“偏好”起到关键左右。例如,若算法喜欢“尽可能特殊”的模型,则会有相应的模型产生。机器学习算法在学习过程中对某种类型假设的偏好,称为“归纳偏好”。

任何一个有效的机器学习算法必有其归纳偏好,否则产生的模型每次在进行预测时随机抽选训练集上的等效假设,学得模型结果不一,显然没有意义。

归纳偏好可看作学习算法自身在一个可能很庞大的假设空间中对假设进 行选择的启发式或"价值观"那么,有没有一般性的原则来引导算法确立 “正确的"偏好呢? “奥卡姆剃刀” (Occam’s razor)是一种常用的、自然科学研究中最基本的原则,即"若有多个假设与观察一致,则选最简单的那个"如果采用这个原则,并且假设我们认为"更平滑"意味着"更简单” (例如曲线 A 更易于描述,其方程式是 y = x 2 + 6 x + 1 y = x2+ 6x + 1y=x2+6x+1 ,而曲线 B 则要复杂得多),则在选择样本时我们会自然地偏好"平滑"的曲线 A。

引用源自

bilibili up主:致敬大神 视频链接:https://www.bilibili.com/video/BV17J411C7zZ

《机器学习》 --周志华

CSDN博主 九号店 博文连接:https://blog.csdn.net/weixin_44578032/article/details/103257305

CSDN博主 风度78 博文链接:https://blog.csdn.net/fengdu78/article/details/106536571?utm_medium=distribute.pc_relevant.none-task-blog-BlogCommendFromMachineLearnPai2-3.control&depth_1-utm_source=distribute.pc_relevant.none-task-blog-BlogCommendFromMachineLearnPai2-3.control

本篇完,如有错误欢迎指出~

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?