autograd 模块实现了反向传播求导数,自动提供微分。

可以调用variable的。backward实现反向传播,自动计算所有梯度。

variable的属性

有三个属性:

1.data :保存variable包含的tensor

2.grad :保存data对应的梯度(也是variable)

3.grad_fn:指向一个function对象用来反向传播计算输入的梯度

建立

注意:requires_grad是参不参与误差反向传播, 要不要计算梯度

import torch as t

from torch.autograd import Variable

#第一种

x=Variable(t.ones(2,2),requires_grad=True)

#第二种

tensorr=t.FloatTensor([1,2],[3,4])

y=Variable(tensorr,requires_grad=True)

计算,梯度

# 先生鸡蛋

tensor = t.FloatTensor([[1,2],[3,4]])

# 把鸡蛋放到篮子里, requires_grad是参不参与误差反向传播, 要不要计算梯度

variable = Variable(tensor, requires_grad=True)

t_out = t.mean(tensor*tensor) # x^2

v_out = t.mean(variable*variable) # x^2

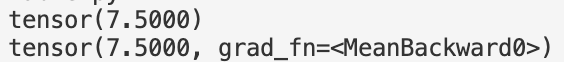

print(t_out)

print(v_out) # 7.5!

但是时刻记住, Variable 计算时, 它在背景幕布后面一步步默默地搭建着一个庞大的系统, 叫做计算图, computational graph. 这个图是用来干嘛的? 原来是将所有的计算步骤 (节点) 都连接起来, 最后进行误差反向传递的时候, 一次性将所有 variable 里面的修改幅度 (梯度) 都计算出来, 而 tensor 就没有这个能力啦.

#求和,y是一个variable

x=Variable(t.ones(2,2),requires_grad=True)

y=x.sum()

#梯度

##反向传播 【1/4 * sum(variable*variable)】,计算梯度【d(v_out)/d(variable) = 1/4*2*variable = variable/2】

y.backward()

print(x.grad)

特别注意:反向传播是累加的,所以要先清零

x.grad.data.zero_()

接口一致

t.cos(x)和t.cos(x.data)是一样的

PyTorch自动求导详解

PyTorch自动求导详解

本文详细介绍了PyTorch中autograd模块的功能与使用,包括如何创建Variable,利用requires_grad参数控制变量是否参与反向传播,以及如何通过调用.backward()方法实现自动计算梯度。同时,文章还解释了计算图的概念及其在反向传播中的作用。

本文详细介绍了PyTorch中autograd模块的功能与使用,包括如何创建Variable,利用requires_grad参数控制变量是否参与反向传播,以及如何通过调用.backward()方法实现自动计算梯度。同时,文章还解释了计算图的概念及其在反向传播中的作用。

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?