Ollama 是一个开源的大语言模型(LLM)服务平台,支持一键部署并运行 Llama、DeepSeek、Phi 等多种 AI 模型。通过 Ollama,你无需依赖云端服务,就能在自己的电脑上实现 AI 对话、推理甚至编写代码等复杂任务。本文将详细介绍如何安装 Ollama,加载模型,并实现本地 API 的调用,助你轻松打造自主的 AI 助手或应用。

一、Ollama 下载与安装

首先,前往 Ollama 的官方 GitHub。在页面下载与你的系统对应的安装包(支持 macOS、Windows 及 Linux)。

以 macOS 为例:

-

下载安装包,完成安装。

-

打开「终端」(macOS 可按 F4 搜索“终端”),输入命令测试是否安装成功:

ollama如能正常显示命令选项,即安装无误。

二、下载和加载 AI 模型

Ollama 提供丰富的模型选择。启动终端,通过如下命令下载你感兴趣的模型。例如:

ollama run llama3.2其它常见模型及命令如下:

| 模型名 | 命令 |

| DeepSeek-R1 | ollama run deepseek-r1 |

| DeepSeek-R1 | ollama run deepseek-r1:671b |

| Llama 3.2 | ollama run llama3.2 |

| Llama 3.2 Vision | ollama run llama3.2-vision |

| Phi 4 | ollama run phi4 |

| Mistral | ollama run mistral |

| Code Llama | ollama run codellama |

运行命令后会自动下载模型文件(体积较大,请耐心等待,取决于网络速度和模型大小)。

下载完成后,终端会显示输入提示,即可直接与模型进行对话:

> Send a message:

三、本地对话体验

你可以在终端直接和模型互动,例如输入:

你是谁?模型会即时响应。每次对话结束,可通过 Ctrl+D 退出,或直接关闭窗口。若日后还需对话,只需重新运行对应命令即可。

四、图形化界面(可选)

若觉得在命令行对话不便,Ollama 社区和第三方开发了多种 Web/桌面前端。你可以在 Ollama 官方插件列表中找到并选择合适的 GUI 项目,按说明进行安装配置,从而享受更友好的视觉体验。

五、Ollama API 本地调用详解

Ollama 内置 HTTP RESTful API,默认监听在 localhost:11434。你可以通过 Apifox 等工具或直接用代码访问。

1. 调试入门(以 Apifox 为例)

假设你的模型名为 llama3.2,可用如下 cURL 方式实现一次问答测试:

curl --location --request POST 'http://localhost:11434/api/generate' \

--header 'Content-Type: application/json' \

--data-raw '{

"model": "llama3.2",

"prompt": "Why is the sky blue?",

"stream": false

}'在 Apifox 创建新接口,将以上 cURL 粘贴导入,即可自动解析参数和地址。

2. 发送请求并获取响应

点击「发送」后,等待模型生成的回复。结果会直接显示在接口调试工具中。你也可以将 "stream": false 改为 true,体验流式输出(适合长文本)。

请求参数说明

-

model: 需调用的已下载模型名。 -

prompt: 输入的提示文本,即你想问的问题。 -

stream: 是否流式输出。

响应结构

通常返回如下 JSON(简化示例):

{ "model": "llama3.2", "created_at": "...", "response": "Because of Rayleigh scattering...", "done": true }六、结合应用开发

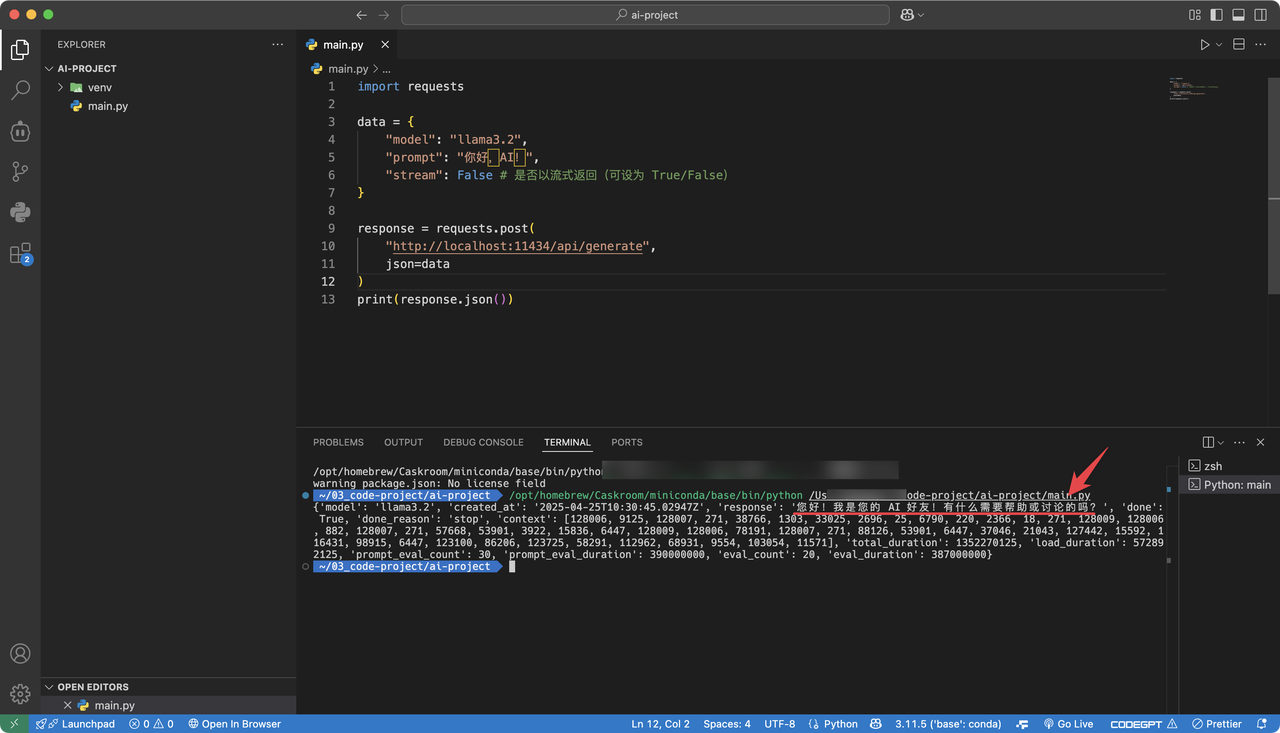

你可以直接用 Python、JavaScript 等主流编程语言调用 Ollama API,将其集成到你的 Web 应用、聊天机器人或者自动化脚本中。例如,使用 Python:

import requests

data = {

"model": "llama3.2",

"prompt": "你好,AI!",

"stream": False # 是否以流式返回(可设为 True/False)

}

response = requests.post(

"http://localhost:11434/api/generate",

json=data

)

print(response.json())

总结

本文全面介绍了本地部署 Ollama、下载并加载 AI 大模型以至于如何通过 API 调用模型实现问答功能的全过程。无论你是 AI 初学者还是开发者,都可以通过本指南在本地构建属于自己的智能对话体验,免除对云服务的依赖,实现数据和隐私的完全自主。

13万+

13万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?