目录

Netron初印象

Netron,是一个非常直观和流行的神经网络模型可视化工具。它是一个开源项目,主要用于可视化深度学习模型的结构,包括各层的参数和连接关系。Netron 支持多种模型文件格式,并提供友好的用户界面,方便研究人员和工程师快速查看和分析模型。

体验链接:Netron

Netron 功能是什么?

Netron,主要功能是:帮助用户快速理解和调试深度学习模型的结构。Netron 提供了一个图形界面,展示模型的各层、各节点,以及它们之间的连接关系。

Netron 的来源

Netron 由 Lutz Roeder 开发并开源,最初发布于 2017 年。它使用 Electron 框架构建,因此可以在 Windows、macOS 和 Linux 上运行。Netron 的开发初衷是为了提供一个简单、直观的工具,让用户能够轻松查看和理解复杂的神经网络结构。

支持的模型文件格式

Netron 支持多种深度学习模型文件格式,包括但不限于:

ONNX (.onnx)

TensorFlow (.pb, .meta, .tflite)

Keras (.h5, .keras)

Caffe (.caffemodel, .prototxt)

PyTorch (.pth, .pt, .pkl)

Core ML (.mlmodel)

Darknet (.cfg)

PaddlePaddle (.pdmodel)

TNN (.tnnproto)

MXNet (.json, .params)

Barracuda (.nn)

如何使用 Netron 打开和查看模型文件?

- 安装 Netron:你可以通过官方网站下载 Netron 的安装包,或者使用 npm 安装:

npm install -g netron - 启动 Netron:你可以通过运行以下命令启动 Netron:

netron - 打开模型文件:在启动的 Netron 应用程序中,点击“Open File”按钮,选择你要查看的模型文件。Netron 会自动解析文件内容并展示模型的结构。

- 查看模型结构:在 Netron 的图形界面中,你可以看到模型的各层和节点。点击特定的节点,可以查看该层的详细信息,包括层类型、输入输出尺寸、参数等。

要掌握哪些知识才能看懂模型结构?

要读懂和理解 Netron 展示的模型结构,通常需要掌握以下知识:

- 神经网络基础:了解基本的神经网络概念,如层(layer)、节点(node)、权重(weights)、激活函数(activation function)等。

- 深度学习框架:熟悉你所使用的深度学习框架(如 TensorFlow、PyTorch、Keras 等)的基本使用方法和模型定义方式。

- 模型架构:了解常见的神经网络架构,如卷积神经网络(CNN)、循环神经网络(RNN)、全连接网络(FCN)等。

- 数据流:理解数据在模型中的流动过程,即如何从输入数据经过各层处理最终得到输出结果。

- 参数和超参数:能够识别和理解模型中的参数和超参数,如卷积核大小、步长、池化层、dropout 率等。

通过这些知识,你可以更好地理解和调试深度学习模型,利用 Netron 的可视化功能快速发现和解决潜在问题。

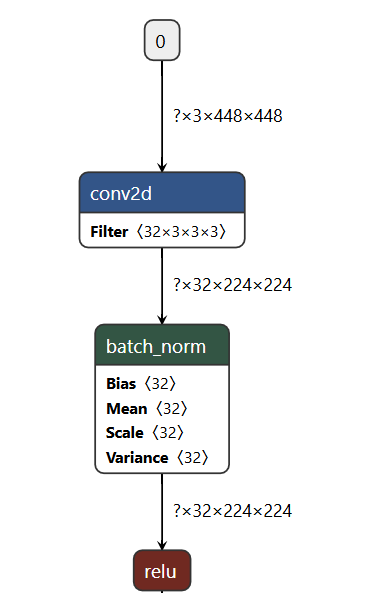

模型结构解释

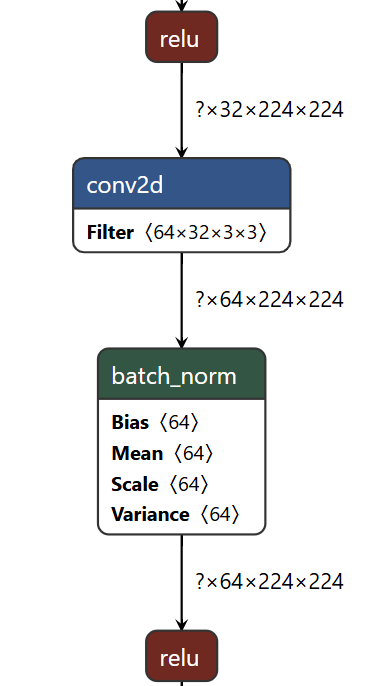

part1

0:表示的是输入层

输入形状:`?x3x448x448`

这里的 `?` 通常表示批次大小(batch size),在很多情况下这一维度不是固定的。

输入的图片为3个通道(通常是 RGB 三个通道的彩色图像),高度和宽度分别为 448 像素。

第一层:卷积层(conv2d)

卷积核数量为 32(输出通道数)。

每个卷积核的大小为 `3x3x3`,即 3x3 的空间维度和 3 个输入通道。

输出形状:`?x32x224x224`

经过卷积操作后,输出的特征图的通道数变为 32,空间维度减半(此处假设使用步幅为2或者有一些边界处理,如 padding)。

第二层:Batch Normalization(批量归一化层)

批量归一化层能够加速训练并稳定模型。参数:

`Bias`(偏置):大小为 32(与通道数一致)。

`Mean`(均值):大小为 32。

`Scale`(缩放):大小为 32。

`Variance`(方差):大小为 32。

输出形状:`?x32x224x224`。输出形状与输入形状一致,因为批量归一化层不会改变数据的维度。

第三层:激活层(ReLU)

Rectified Linear Unit(ReLU)激活函数,主要用于引入非线性。

输出形状:`?x32x224x224`

输出形状与输入形状一致,因为激活函数不会改变数据的维度。

part2

- 上一层输出:

- 输入数据形状为

?x32x224x224,经过之前ReLU激活函数的处理。

- 输入数据形状为

- 卷积层:

- 使用 64 个

3x3x32的卷积核,提取64个通道的特征图,每个卷积核生成一个新的特征图。 - 输出数据形状为

?x64x224x224。

- 使用 64 个

- 批量归一化层:

- 对每个通道进行批量归一化,包括调整均值、方差、缩放因子和偏置。

- 批量归一化后的形状保持不变:

?x64x224x224。

- 激活层:

- 应用 ReLU 激活函数,引入非线性。

- 输出数据形状保持不变:

?x64x224x224。

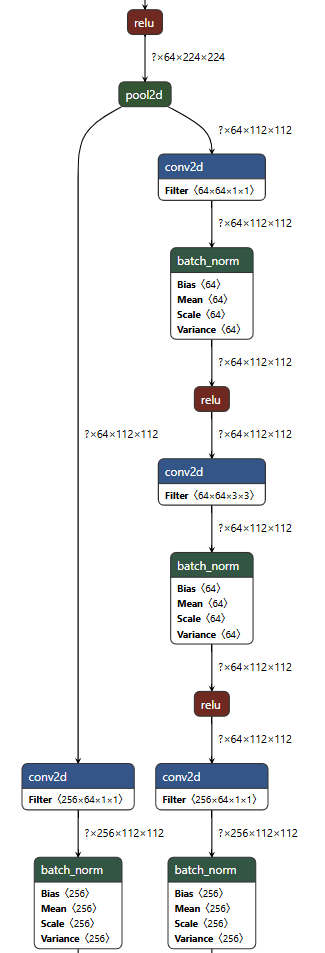

part3

上一层输出

- 形状:

?x64x224x224- 上一层

ReLU激活函数的输出。

- 上一层

池化层(pool2d)

- 池化(Pooling):

- 池化层通常用于下采样,减小特征图的尺寸,同时保留主要的特征。

- 假设使用的是 2x2 的最大池化(Max Pooling),步长为 2。

- 输出形状:

?x64x112x112- 空间维度减半,通道数保持不变,即 64 个通道,空间维度变为112x112。

分支路径1

第一层卷积层(conv2d)

- 卷积核(Filter):

- 64 个

1x1x64大小的卷积核。

- 64 个

- 输出形状:

?x64x112x112- 通道数保持为 64,空间维度不变。

批量归一化层(batch_norm)

- 参数:

Bias(偏置):大小为 64。Mean(均值):大小为 64。Scale(缩放因子):大小为 64。Variance(方差):大小为 64。

- 输出形状:

?x64x112x112- 输出形状与输入形状一致。

激活层(ReLU)

- 输出形状:

?x64x112x112- 输出形状与输入形状一致。

第二层卷积层(conv2d)

- 卷积核(Filter):

- 64 个

3x3x64大小的卷积核。

- 64 个

- 输出形状:

?x64x112x112- 通道数保持为 64,空间维度不变。

批量归一化层(batch_norm)

- 输出形状:

?x64x112x112- 输出形状与输

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2745

2745

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?