前言

近期回顾LSTM 做时间序列数据预测,网上也有很多的教程,在跑这个程序时,遇到一些问题,特此记录分享一下。

使用LSTM 进行单步预测和多步预测,LSTM 的输出格式要重新调整,简单演示,不调参数。

这篇文章加入注意力机制的LSTM 对航空乘客预测,加了注意力机制的东西,有兴趣可以看看。

本文参考文章:

Time Series Prediction with LSTM Recurrent Neural Networks in Python with Keras

外国学者写的文章,比较具体,有兴趣可以进去看看。

我喜欢直接代码+ 结果展示

先代码可以跑通,才值得深入研究每个部分之间的关系;进而改造成自己可用的数据。

1. 数据集获取

链接: https://pan.baidu.com/s/1jv7A2JvIhA6oqvtYnYh9vQ

提取码: m5j5

2. 模型实验

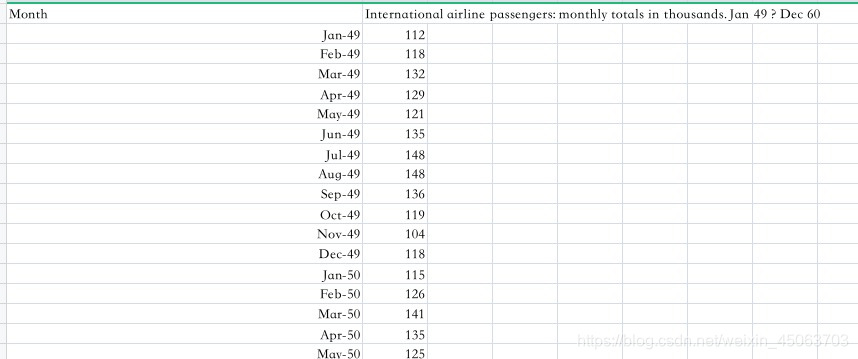

数据展示

1949 到 1960 一共 12 年,每年 12 个月的数据,一共 144 个数据,单位是 1000

2.1 单步预测 1—》1

用当前数据预测下一个数据

目标:预测国际航班未来 1 个月的乘客数

- 导入包

# 单变量,1---》1

import numpy

import matplotlib.pyplot as plt

from pandas import read_csv

import math

from keras.models import Sequential

from keras.layers import Dense

from keras.layers import LSTM

from sklearn.preprocessing import MinMaxScaler

from sklearn.metrics import mean_squared_error

- 导入数据

# load the dataset

dataframe = read_csv('airline-passengers.csv', usecols=[1], engine='python')

# print(dataframe)

print("数据集的长度:",len(dataframe))

dataset = dataframe.values

# 将整型变为float

dataset = dataset.astype('float32')

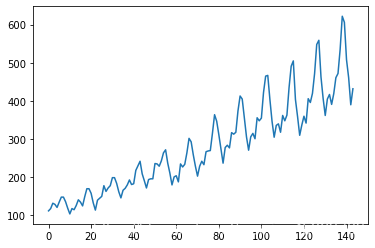

plt.plot(dataset)

plt.show()

- 数据格式转换为监督学习,归一化数据,训练集和测试集划分

# X是给定时间(t)的乘客人数,Y是下一次(t + 1)的乘客人数。

# 将值数组转换为数据集矩阵,look_back是步长。

def create_dataset(dataset, look_back=1):

dataX, dataY = [], []

for i in range(len(dataset)-look_back-1):

a = dataset[i:(i+look_back), 0]

# X按照顺序取值

dataX.append(a)

# Y向后移动一位取值

dataY.append(dataset[i + look_back, 0])

return numpy.array(dataX), numpy.array(dataY)

# fix random seed for reproducibility

numpy.random.seed(7)

# 数据缩放

scaler = MinMaxScaler(feature_range=(0, 1))

dataset = scaler.fit_transform(dataset)

# 将数据拆分成训练和测试,2/3作为训练数据

train_size = int(len(dataset) * 0.67)

test_size = len(dataset) - train_size

train, test = dataset[0:train_size,:], dataset[train_size:len(dataset),:]

print("原始训练集的长度:",train_size)

print("原始测试集的长度:",test_size)

- 构建模型、预测

训练集长度96 ,监督学习之后变为94

原因:一是因为第96个数据没有预测值,这个值忽略;而是因为构建监督学习时,代码自动过滤一个值。所以变成94个数据。代码那块也可以不自动过滤一个值,对代码修改一下也行。

我当时在这里耗费很大的精力

# 构建监督学习型数据

look_back = 1

trainX, trainY = create_dataset(train, look_back)

testX, testY = create_dataset(test, look_back)

print("转为监督学习,训练集数据长度:", len(trainX))

# print(trainX,trainY)

print("转为监督学习,测试集数据长度:",len(testX))

# print(testX, testY )

# 数据重构为3D [samples, time steps, features]

trainX = numpy.reshape(trainX, (trainX.shape[0], 1, trainX.shape[1]))

testX = numpy.reshape(testX, (testX.shape[0], 1, testX.shape[1]))

print('构造得到模型的输入数据(训练数据已有标签trainY): ',trainX.shape,testX.shape)

# create and fit the LSTM network

model = Sequential()

model.add(LSTM(4, input_shape=(1, look_back)))

model.add(Dense(1))

model.compile(loss='mean_squared_error', optimizer='adam')

model.fit(trainX, trainY, epochs=100, batch_size=1, verbose=2)

# 打印模型

model.summary()

# 开始预测

trainPredict = model.predict(trainX)

testPredict = model.predict(testX)

# 逆缩放预测值

trainPredict = scaler.inverse_transform(trainPredict)

trainY = scaler.inverse_transform([trainY])

testPredict = scaler.inverse_transform(testPredict)

testY = scaler.inverse_transform([testY])

# 计算误差

trainScore = math.sqrt(mean_squared_error(trainY[0], trainPredict[:,0]))

print('Train Score: %.2f RMSE' % (trainScore))

testScore = math.sqrt(mean_squared_error(testY[0], testPredict[:,0]))

print('Test Score: %.2f RMSE' % (testScore))

# shift train predictions for plotting

trainPredictPlot = numpy.empty_like(dataset)

trainPredictPlot[:, :] = numpy.nan

trainPredictPlot[look_back:len(trainPredict)+look_back, :] = trainPredict

# shift test predictions for plotting

testPredictPlot = numpy.empty_like(dataset)

testPredictPlot[:, :] = numpy.nan

testPredictPlot[len(trainPredict)+(look_back*2)+1:len(dataset)-1, :] = testPredict

# plot baseline and predictions

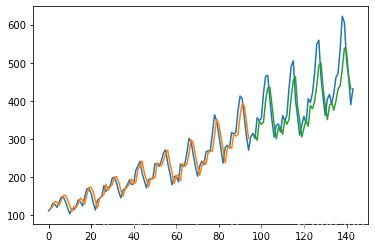

plt.plot(scaler.inverse_transform(dataset))

plt.plot(trainPredictPlot)

plt.plot(testPredictPlot)

plt.show()

这里说下LSTM的输入格式为:samples, time steps, features

input_shape的格式为:time steps, features

这两个地方容易出错

- 打印输出结果

原始训练集的长度: 96

原始测试集的长度: 48

转为监督学习,训练集数据长度: 94 # 这两个地方需要重点注意一下,

转为监督学习,测试集数据长度: 46

构造得到模型的输入数据(训练数据已有标签trainY): (94, 1, 1) (46, 1, 1)

Epoch 1/100

此过程省略

Model: "sequential_49"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

lstm_49 (LSTM) (None, 4) 96

_________________________________________________________________

dense_49 (Dense) (None, 1) 5

=================================================================

Total params: 101

Trainable params: 101

Non-trainable params: 0

_________________________________________________________________

Train Score: 22.62 RMSE

Test Score: 51.93 RMSE

- 预测下一个月的数据

# 预测未来的数据

#测试数据的最后一个数据没有预测,这里补上

finalX = numpy.reshape(test[-1], (1, 1, testX.shape[1]))

#预测得到标准化数据

featruePredict = model.predict(finalX)

#将标准化数据转换为人数

featruePredict = scaler.inverse_transform(featruePredict)

#原始数据是1949-1960年的数据,下一个月是1961年1月份

print('模型预测1961年1月份的国际航班人数是: ',featruePredict)

结果:

模型预测1961年1月份的国际航班人数是: [[252.41042]]

2.2 单步预测 3—》1

前三步预测下一步数据

- 直接代码

# 单变量,3---》1

import numpy

import matplotlib.pyplot as plt

from pandas import read_csv

import math

from keras.models import Sequential

from keras.layers import Dense

from keras.layers import LSTM

from sklearn.preprocessing import MinMaxScaler

from sklearn.metrics import mean_squared_error

#matplotlib inline

# load the dataset

dataframe = read_csv('airline-passengers.csv', usecols=[1], engine='python')

# print(dataframe)

print("数据集的长度:",len(dataframe))

dataset = dataframe.values

# 将整型变为float

dataset = dataset.astype('float32')

plt.plot(dataset)

plt.show()

# X是给定时间(t)的乘客人数,Y是下一次(t + 1)的乘客人数。

# 将值数组转换为数据集矩阵,look_back是步长。

def create_dataset(dataset, look_back=1):

dataX, dataY = [], []

for i in range(len(dataset)-look_back-1):

a = dataset[i:(i+look_back), 0]

# X按照顺序取值

dataX.append(a)

# Y向后移动一位取值

dataY.append(dataset[i + look_back, 0])

return numpy.array(dataX), numpy.array(dataY)

# fix random seed for reproducibility

numpy.random.seed(7)

# 数据缩放

scaler = MinMaxScaler(feature_range=(0, 1))

dataset = scaler.fit_transform(dataset)

# 将数据拆分成训练和测试,2/3作为训练数据

train_size = int(len(dataset) * 0.67)

test_size = len(dataset) - train_size

train, test = dataset[0:train_size,:], dataset[train_size:len(dataset),:]

print("原始训练集的长度:",train_size)

print("原始测试集的长度:",test_size)

# 构建监督学习型数据

look_back = 3

trainX, trainY = create_dataset(train, look_back)

testX, testY = create_dataset(test, look_back)

print("转为监督学习,训练集数据长度:", len(trainX))

# print(trainX,trainY)

print("转为监督学习,测试集数据长度:",len(testX))

# print(testX, testY )

# 数据重构为3D [samples, time steps, features]

# trainX = numpy.reshape(trainX, (trainX.shape[0], 1, trainX.shape[1]))

# testX = numpy.reshape(testX, (testX.shape[0], 1, testX.shape[1]))

trainX = numpy.reshape(trainX, (trainX.shape[0], trainX.shape[1],1))

testX = numpy.reshape(testX, (testX.shape[0], testX.shape[1], 1))

print('构造得到模型的输入数据(训练数据已有标签trainY): ',trainX.shape,testX.shape)

# create and fit the LSTM network

model = Sequential()

# model.add(LSTM(4, input_shape=(1, look_back)))

model.add(LSTM(4, input_shape=( look_back,1))) # 与上面的重构格式对应,要改都改,才能跑通代码

model.add(Dense(1))

model.compile(loss='mean_squared_error', optimizer='adam')

model.fit(trainX, trainY, epochs=100, batch_size=1, verbose=2)

# 打印模型

model.summary()

# 开始预测

trainPredict = model.predict(trainX)

testPredict = model.predict(testX)

# 逆缩放预测值

trainPredict = scaler.inverse_transform(trainPredict)

trainY = scaler.inverse_transform([trainY])

testPredict = scaler.inverse_transform(testPredict)

testY = scaler.inverse_transform([testY])

# 计算误差

trainScore = math.sqrt(mean_squared_error(trainY[0], trainPredict[:,0]))

print('Train Score: %.2f RMSE' % (trainScore))

testScore = math.sqrt(mean_squared_error(testY[0], testPredict[:,0]))

print('Test Score: %.2f RMSE' % (testScore))

# shift train predictions for plotting

trainPredictPlot = numpy.empty_like(dataset)

trainPredictPlot[:, :] = numpy.nan

trainPredictPlot[look_back:len(trainPredict)+look_back, :] = trainPredict

# shift test predictions for plotting

testPredictPlot = numpy.empty_like(dataset)

testPredictPlot[:, :] = numpy.nan

testPredictPlot[len(trainPredict)+(look_back*2)+1:len(dataset)-1, :] = testPredict

# plot baseline and predictions

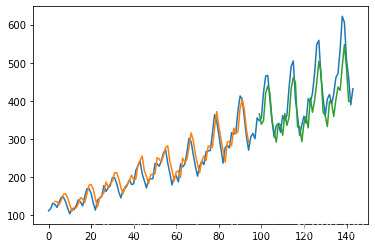

plt.plot(scaler.inverse_transform(dataset))

plt.plot(trainPredictPlot)

plt.plot(testPredictPlot)

plt.show()

- 结果展示

原始训练集的长度: 96

原始测试集的长度: 48

转为监督学习,训练集数据长度: 92

转为监督学习,测试集数据长度: 44

构造得到模型的输入数据(训练数据已有标签trainY): (92, 3, 1) (44, 3, 1)

Epoch 1/100

92/92 - 2s - loss: 0.0203

此过程省略

Model: "sequential_48"

_________________________________________________________________

Layer (type) Output Shape Param #

=================================================================

lstm_48 (LSTM) (None, 4) 96

_________________________________________________________________

dense_48 (Dense) (None, 1) 5

=================================================================

Total params: 101

Trainable params: 101

Non-trainable params: 0

_________________________________________________________________

Train Score: 22.11 RMSE

Test Score: 50.08 RMSE

- 最后三个月预测下一个月的数据

# 预测未来的数据

#测试数据的最后一个数据没有预测,这里补上

finalX = numpy.reshape(test[-3:], (1, testX.shape[1], 1))

#预测得到标准化数据

featruePredict = model.predict(finalX)

#将标准化数据转换为人数

featruePredict = scaler.inverse_transform(featruePredict)

#原始数据是1949-1960年的数据,下一个月是1961年1月份

print('模型预测1961年1月份的国际航班人数是: ',featruePredict)

- 结果展示

模型预测1961年1月份的国际航班人数是: [[461.36993]]

不要在意结果,你懂的!!!

3. 总结

- 使用LSTM网络,数据要归一化处理, 格式要处理

- 输入格式:samples, time steps, features(维度)

input_shape的格式为:time steps, features - LSTM内部超参数可以调节,层数可以增加

- 从数据的角度,考虑数据预处理的情况,比如差值填充之类的,这里没有用到。

- 在划分数据集时,训练集长度,转为监督学习后长度会缩小。

有个疑问:

多步预测时

# trainX = numpy.reshape(trainX, (trainX.shape[0], 1, trainX.shape[1]))

# testX = numpy.reshape(testX, (testX.shape[0], 1, testX.shape[1]))

# model.add(LSTM(4, input_shape=(1, look_back)))

这个三个部分对应修改,程序也可以正常运行,预测结果和上述也差不多。

上面肯定是对的,这里的处理,我认为是数据处理的格式不同;比如说上面是前三步预测下一步,这里处理的话就是前一步预测下三步,模型都能跑通。

有大佬走过路过的话,烦请解答一下,万分感激。

9858

9858

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?