pytorch的tensor排序为:batch、channel、height、width

lenet的结构先后顺序为:卷积、下采样、卷积、下采样、3个全连接层

以下控制台的截图有两个颜色是在两台电脑实现截图的(本篇文章非一次写完)。

网络的大概结构如图:

目录结构

准备

首先在pytorch官网下载对应自己电脑的pytorch

推荐用conda下载,然后使用nvidia-smi或者nvcc -V查看自己的cuda版本。

选择好后复制底下的命令在新建的虚拟环境中运行。

编写网络结构

model.py

import torch.nn as nn

import torch.nn.functional as F

class LeNet(nn.Module): # 创建一个类继承于nn.Module

def __init__(self): # 初始函数,初始化参数

super(LeNet, self).__init__()

# 实现搭建网络所需要的结构

self.conv1 = nn.Conv2d(3, 16, 5) # nn.Conv2d(in_c, out_c, kernel_sz)

self.pool1 = nn.MaxPool2d(2, 2) # nn.MaxPool2d(kernel_sz, stride)

self.conv2 = nn.Conv2d(16, 32, 5)

self.pool2 = nn.MaxPool2d(2, 2)

self.fc1 = nn.Linear(32*5*5, 120) # nn.Linear(input, output)

self.fc2 = nn.Linear(120, 84)

self.fc3 = nn.Linear(84, 10)

def forward(self, x): # 定义正向传播的过程

x = F.relu(self.conv1(x)) # input(3, 32, 32) output(16, 28, 28)

x = self.pool1(x) # output(16, 14, 14)

x = F.relu(self.conv2(x)) # output(32, 10, 10)

x = self.pool2(x) # output(32, 5, 5)

x = x.view(-1, 32*5*5) # output(32*5*5)

x = F.relu(self.fc1(x)) # output(120)

x = F.relu(self.fc2(x)) # output(84)

x = self.fc3(x) # output(10)

return x

torch.nn.Conv2d(卷积层):

in_c为输入图片的通道,out_c为经过本层卷积输出的通道(即卷积核个数),kernel_sz为卷积核大小。

卷积后输出的维度:

dilation默认为1

简化一下:out_sz = (in_sz - kernel_sz + 2padding) / stride + 1(没有特别说明的话,padding为0,stride为1)

输出的通道数 = 卷积核的个数

eg.第一层卷积输入的是3通道、32×32的图片,经过16个5×5的卷积核卷积,输出的宽高 = (32 - 5 + 0) / 1 + 1 = 28,输出的通道数为16,即输出为16×28×28。

torch.nn.MaxPool2d(池化层):

kernel_sz为池化核大小,stride为步长。

池化层只影响特征矩阵的宽高,不影响深度。输出的宽高 = 输入的宽高 / 步长

eg.第一层卷积输出的是16×28×28,接下来的池化层步长为2,则输出的宽高 = 28 / 2 = 14,输出的深度不变,即经过下采样之后的输出为16×14×14。

torch.nn.Linear(全连接层):

输入的是一维向量,所以上一层下采样后的输出(32维的向量32×5×5)需要先展平为一个一维的tensor(3255)。

输出是节点个数,比如第一层全连接层的节点个数为120,输出即为120,输出又作为下一层全连接层的输入。最后一层的输出为数据集的类别个数,比如我们本次使用的数据集有10个类别,输出即为10。

模型测试

编写代码进行模型测试:

import torch

input = torch.rand([32, 3, 32, 32])

model = LeNet()

print(model)

ouput = model(input)

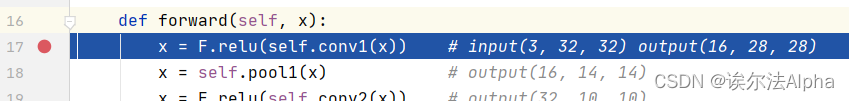

并在正向传播的第一个卷积这行代码打个断点:

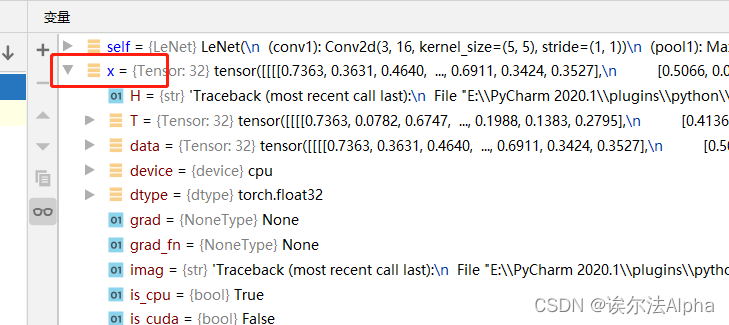

进行debug测试:

可以看到x(即input)底下的shape为32×3×32×32,即输入的向量。

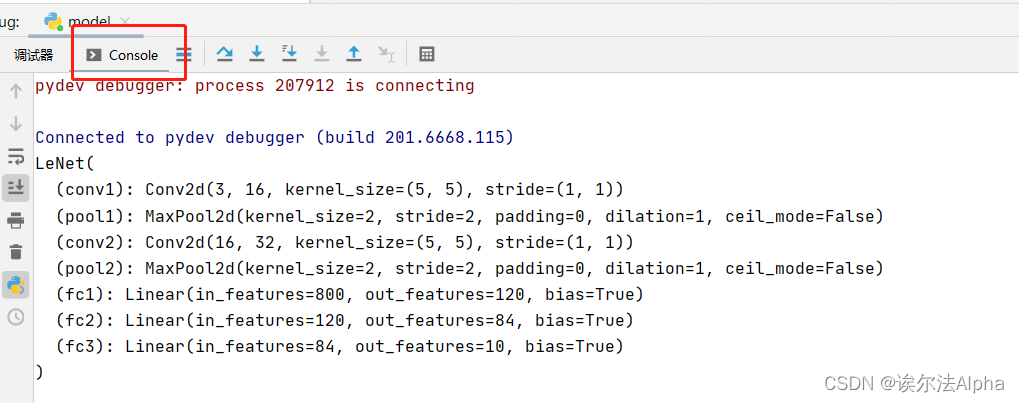

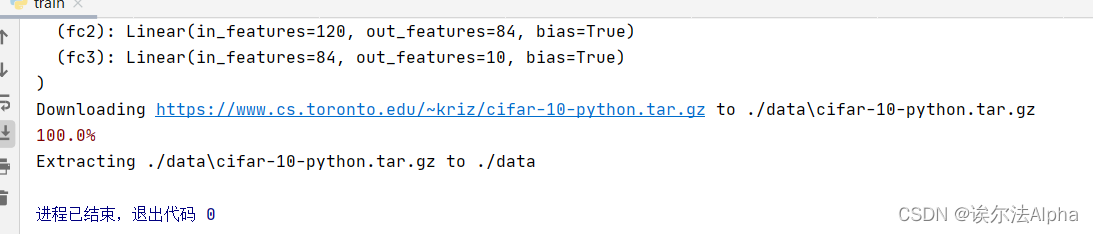

可以看到终端中将每个层的信息给打印出来:

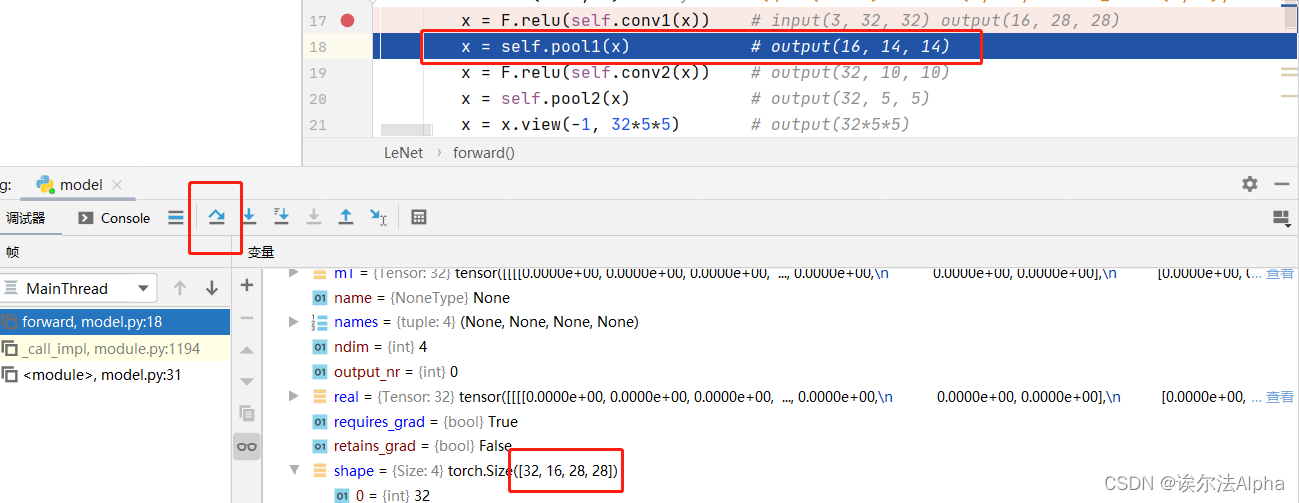

单拨运行一步一步查看正向传播的过程的“x”:

可以看到经过第一层的卷积之后“x”的shape变为32×16×28×28。

一步一步debug,可以看到shape就是每层后面注释的output。

训练代码

train.py

数据集下载与预处理

使用CIFAR10数据集,一共有10个类别:飞机、汽车、小鸟、猫、鹿、狗、青蛙、马、船、卡车,所有图像都是3×32×32。

import torch

import torchvision

import torch.nn as nn

from model import LeNet

import torch.optim as optim

import torchvision.transforms as transforms

transform = transforms.Compose(

[transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))])

train_set = torchvision.datasets.CIFAR10(root='./data', train=True, download=True, transform=transform)

运行此文件,数据集会下载到当前目录的data目录中。运行完记得将download改为False,不然加上下面代码再次运行就会重新下载。

使用torchvision.datasets.CIFAR10()函数下载CIFAR10数据集,download参数设为True;

train参数为True,下载50000张的训练集;

transform进行图像预处理,使用Compose()函数将ToTensor()、Normalize()两个预处理方法打包为整体:

1)ToTensor()函数将PIL图像或numpy数据(一般都是H×W×C的排序,每个像素范围都是0 ~ 255)转为tensor(C×H×W,每个像素范围是0 ~ 1)。

2)Normalize()函数使用均值和标准差来标准化tensor:输出=(原始数据 - 均值)/ 标准差。

接下来使用torch.utils.data.DataLoader()进行数据初始化,分批次(每批batch_size张)导入数据:

train_loader = torch.utils.data.DataLoader(train_set, batch_size=36, shuffle=True, num_workers=0)

shuffle为True,每次将数据集打乱从中随机挑选batch_size张图片;

num_workers为载入数据的线程数,如果是windows系统只能为0,linux可以设多线程。

按照同样的方法下载测试集(10000张)以及测试集的初始化:

val_set = torchvision.datasets.CIFAR10(root='./data', train=False, download=True, transform=transform)

val_loader = torch.utils.data.DataLoader(val_set, batch_size=4, shuffle=False, num_workers=0)

train为False,下载的为非训练集,即测试集。

运行此文件下载测试集,运行完记得将download设为False。

生成迭代器,并获取测试图像及相应标签:

val_data_iter = iter(val_loader)

val_image, val_label = next(val_data_iter)

导入类别,设置元组类型,因为类别的顺序是不可变的:

classes = ('plane', 'car', 'bird', 'cat', 'deer', 'dog', 'frog', 'horse', 'ship', 'truck')

查看测试图片及相应标签:

import numpy as np

import matplotlibdef imshow(img):

img = img / 2 + 0.5 # unnormalize 对图像进行反标准化处理

npimg = img.numpy()

plt.imshow(np.transpose(npimg, (1, 2, 0)))

plt.show()

# print labels

print(' '.join(f'{classes[val_label[j]]:5s}' for j in range(4)))

# show images

imshow(torchvision.utils.make_grid(val_image)).pyplot as plt

因为标准化处理是(原始数据 - 均值)/ 标准差,根据上面的代码:(img - 0.5) / 0.5,所以反标准化就进行一次反向处理:标准化的img × 0.5 + 0.5,即img / 2 + 0.5;

img.numpy()转为numpy数据格式;

因为标准化后的shape是C×H×W,我们要还原为载入时初始shape的C×H×W,即将最前面(第0)的C调到最后(第2),所以是(1, 2, 0)。

运行代码,可以看到载入的4(batch_size)张图片以及打印的相应标签:

运行完,相关查看图片的代码要删除或注释,不然影响后面代码的运行。

定义训练过程

net = LeNet() # 实例化模型

loss_function = nn.CrossEntropyLoss() # 定义损失函数

optimizer = optim.Adam(net.parameters(), lr=0.001) # 定义优化器

net.parameters()将网络中可训练的参数都进行训练;lr为学习率。

然后将验证集的batch_size改为10000,通过next()函数直接一次性将所有的验证图片拿出来。(之前设为4只是想要imshow出来看一下)

接下来是训练过程:

for epoch in range(5): # loop over the dataset multiple times 训练5轮

running_loss = 0.0 # 累加训练过程中的损失

for step, data in enumerate(train_loader, start=0): # 遍历训练集样本

# get the inputs; data is a list of [inputs, labels]

inputs, labels = data

# zero the parameter gradients 将历史损失梯度清0

optimizer.zero_grad()

# forward + backward + optimize

outputs = net(inputs) # 将训练图片输入到网络进行正向传播

loss = loss_function(outputs, labels) # 计算损失 loss_function(预测值, 真实值)

loss.backward() # 将loss反向传播

optimizer.step() # 参数更新

# print statistics

running_loss += loss.item() # 累加loss

# 以下进行验证

if step % 500 == 499: # print every 500 mini-batches 每隔500步打印一次验证信息

with torch.no_grad(): # 以下的计算不去计算每个节点的损失梯度

outputs = net(val_image) # [batch, 10] 验证集正向传播

predict_y = torch.max(outputs, dim=1)[1] # 取到(概率)最大的类别的index

accuracy = torch.eq(predict_y, val_label).sum().item() / val_label.size(0)

print('[%d, %5d] train_loss: %.3f test_accuracy: %.3f' %

(epoch + 1, step + 1, running_loss / 500, accuracy))

running_loss = 0.0

print('Finished Training')

save_path = './Lenet.pth'

torch.save(net.state_dict(), save_path) # 保存模型,保存网络所有的参数

optimizer.zero_grad()

为什么每轮训练都要进行损失梯度清0?因为这样可以变相的实现很大的batch数值的训练。

都知道batch的值越大,对训练效果其实是越好的,但是受到硬件的影响并不是想提高batch就能提高的,具体在这篇知乎上有说明。

optimizer.zero_grad()就可以一次性计算多个小的batch的损失梯度进行反向传播。比如batch_size为32,可以一次性计算3个batch的话,batch_size就相当于96了。

with torch.no_grad()

在这个函数以内的计算都不会去计算每个节点的损失梯度,在验证、测试阶段都要用到。

若不使用此方法会有两个缺点:占用更多的算力消耗更多的资源;要存储每个节点的损失梯度,占用更多的内存。

predict_y

predict_y是获取验证集正向传播后输出值当中最大的index,即概率最大的类别所对应的index。

dim=1是要在维度为1上面寻找最大值,因为验证集正向传播输出为[batch, 10],第0维度为batch,第1维度才是10个节点。

accuracy

torch.eq(predict_y, val_label)将预测的标签类别与真实的标签类别进行比较,相同则为True才进行后面的操作。

sum()将预测对的累加,体现在本次当中预测对了多少样本,通过item()拿到对应的数值,然后处以测试样本的数目得到最终的准确率accuracy。

然后运行代码:

打印的4个值分别为:第几轮、第几步、训练损失、测试准确率。

运行完生成的模型权重文件(Lenet.pth)保存在当前目录下。

测试代码

predict.py

首先随便下载一张测试的图片到当前目录中,例如我下了张飞机。

注意:如果是linux系统在百度下载的只能是webp格式的图片,可以用dwebp plane.webp -o plane.jpg命令转为jpg。

编写测试代码:

import torch

import torchvision.transforms as transforms

from PIL import Image

from model import LeNet

transform = transforms.Compose(

[transforms.Resize((32, 32)), # resize为32×32

transforms.ToTensor(),

transforms.Normalize((0.5, 0.5, 0.5), (0.5, 0.5, 0.5))])

classes = ('plane', 'car', 'bird', 'cat', 'deer', 'dog', 'frog', 'horse', 'ship', 'truck')

net = LeNet()

net.load_state_dict(torch.load('Lenet.pth')) # 载入训练好的模型

im = Image.open('plane.jpg') # 载入测试的图片

im = transform(im) # 图片预处理为网络需要的tensor格式 [C, H, W]

im = torch.unsqueeze(im, dim=0) # 对数据的第0位增加一个新的维度 变成pytorch tensor的[N, C, H, W]

with torch.no_grad(): # 不计算损失梯度

outputs = net(im) # 测试图片正向传播

predict = torch.max(outputs, dim=1)[1].numpy() # 取到(概率)最大的类别的index

# predict = torch.softmax(outputs, dim=1)

print(classes[int(predict)]) # 打印出index所对应的类别

运行测试代码:

可以看到预测正确。

如果predict使用的是下面一句softmax函数,打印的predict则是概率分布:

可以看到第0个的概率最大(e-01代表×10的-1次方),查看一下定义的类

第0个对应的是飞机“plane”,即预测结果就为plane。

reference

此次demo是根据一个大佬的b站视频和csdn学习的笔记成果,并自己成功实现了。

大佬的csdn:https://blog.csdn.net/qq_37541097?type=blog。

2676

2676

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?