书生·浦语大模型实战营笔记系列`

4)XTuner大模型单卡低成本微调实战笔记和作业

文章目录

前言

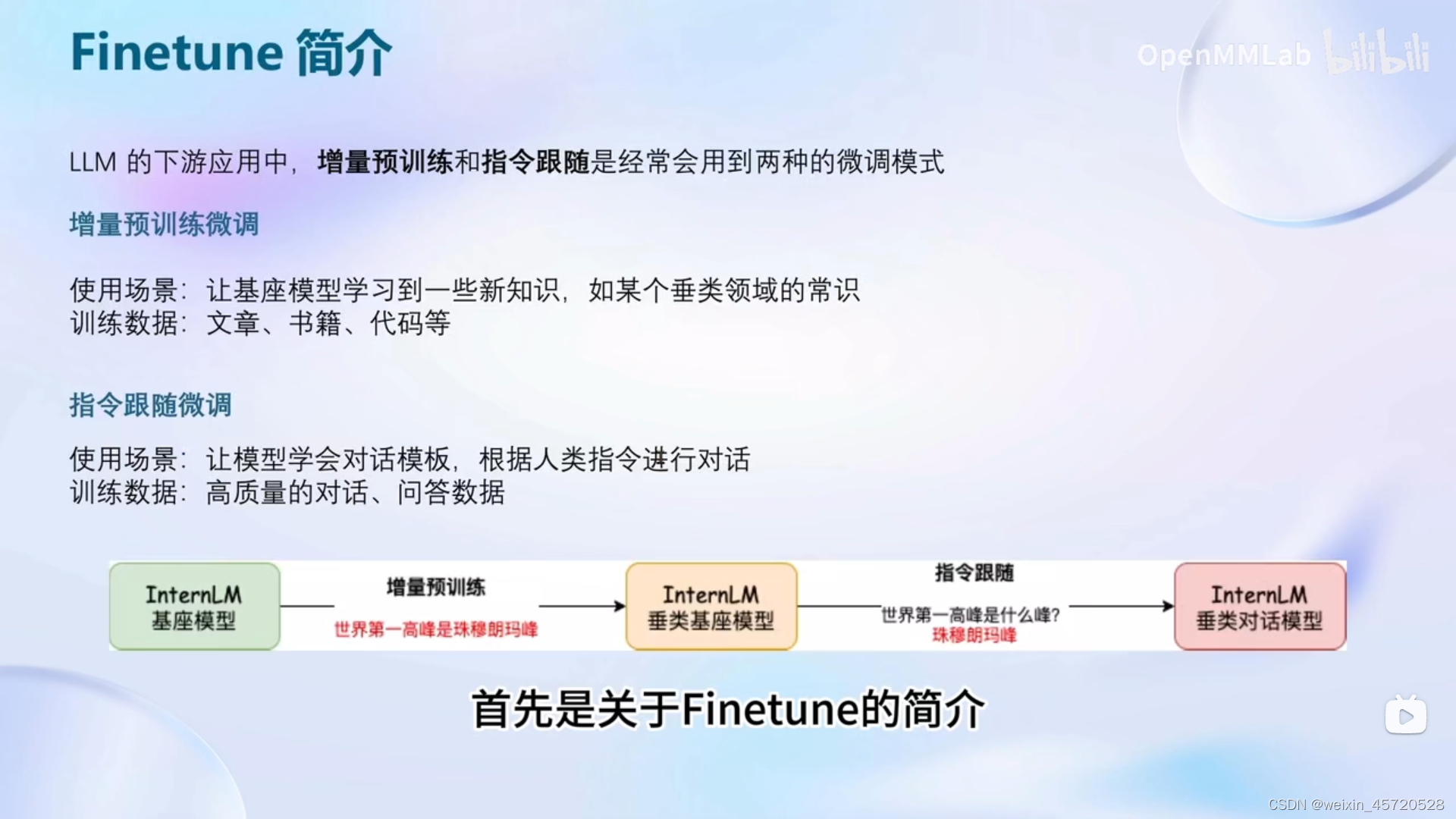

承接第三节课这节课来展开讲讲Finetune以及xtuner这个框架

一、Finetune

包括增量预训练微调和指令跟随微调

1.指令跟随微调

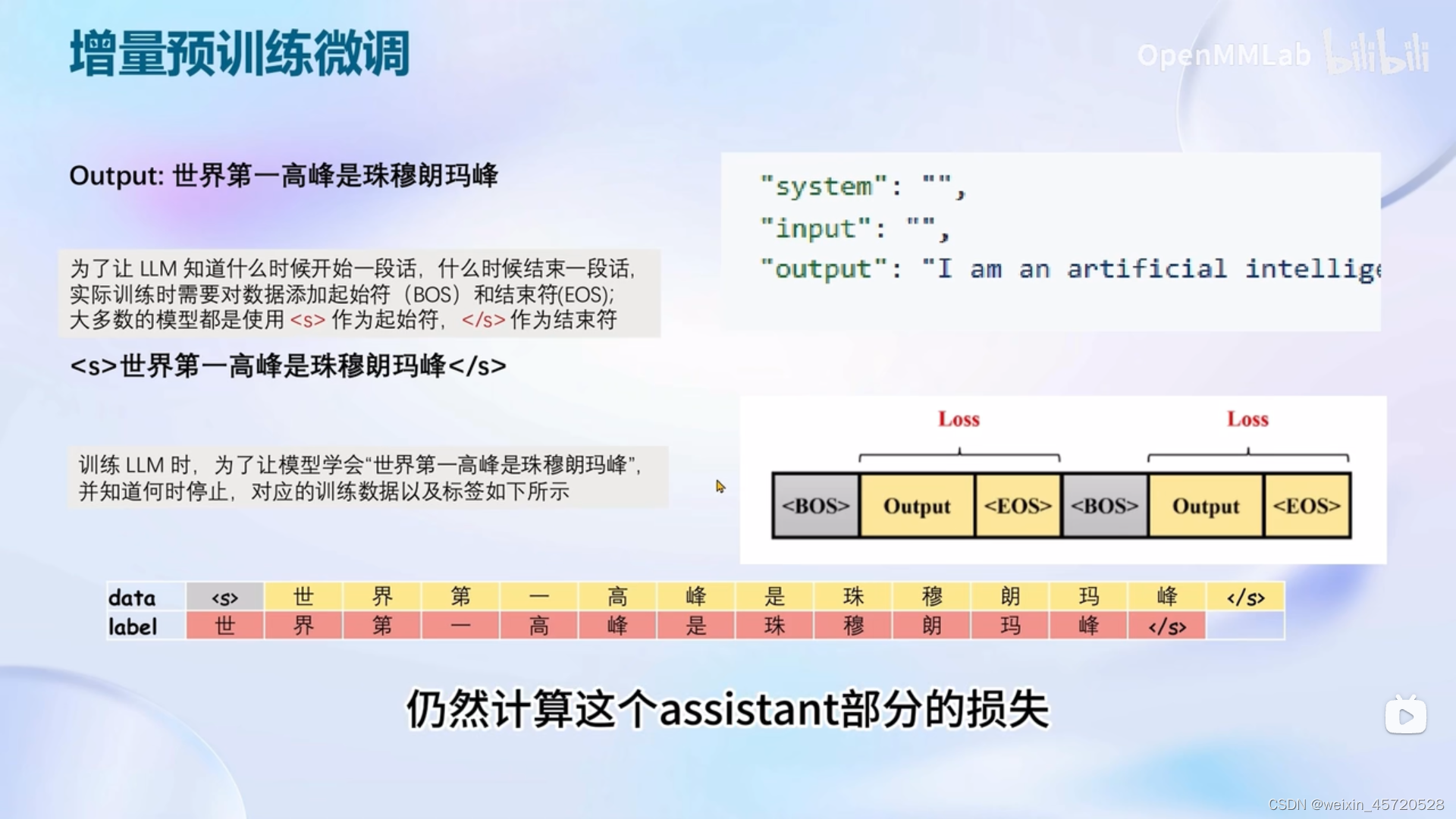

2.增量预训练微调

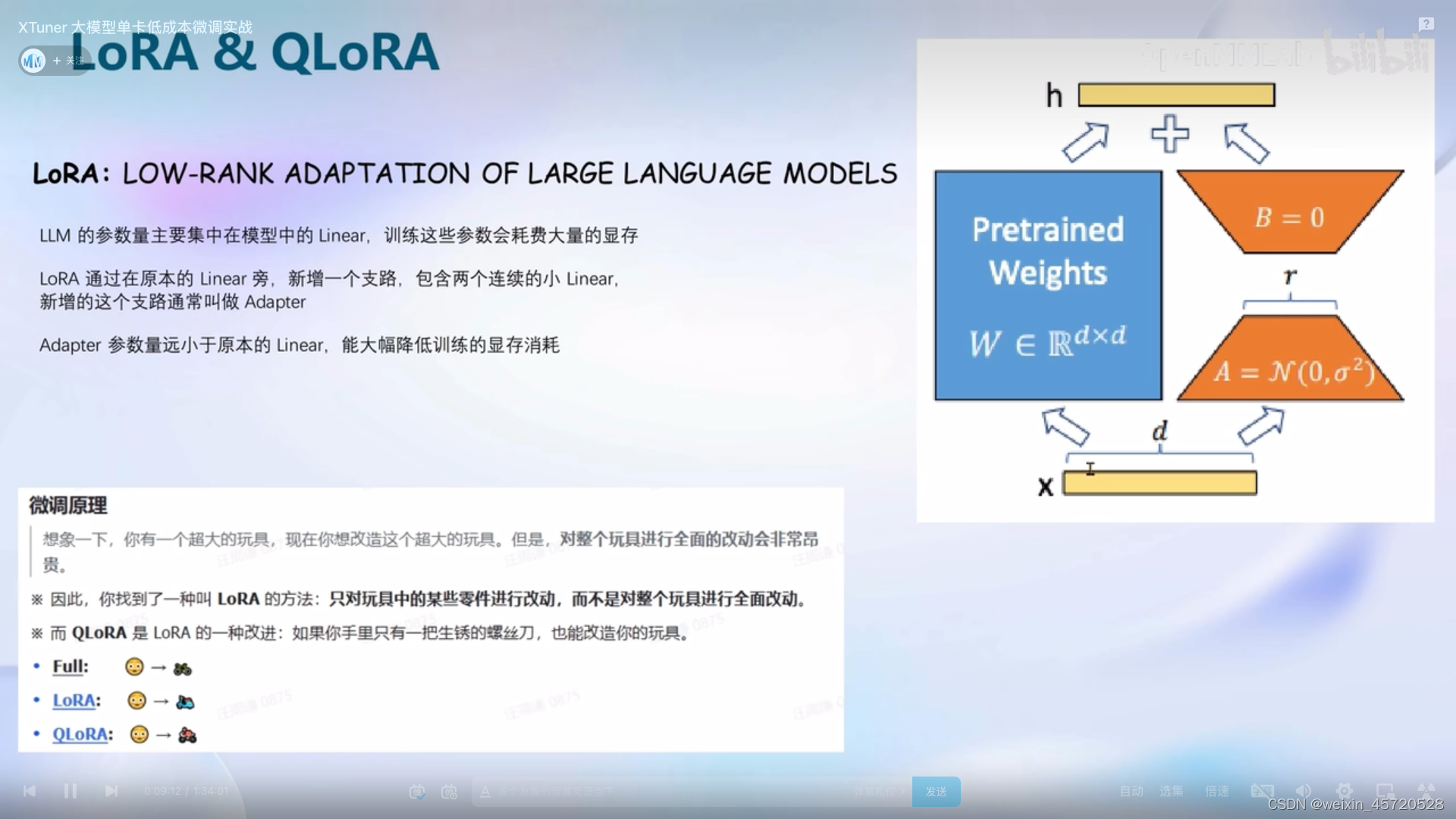

3.LoRA和QLoRA

xtuner中使用的微调原理是LoRA和QLoRA

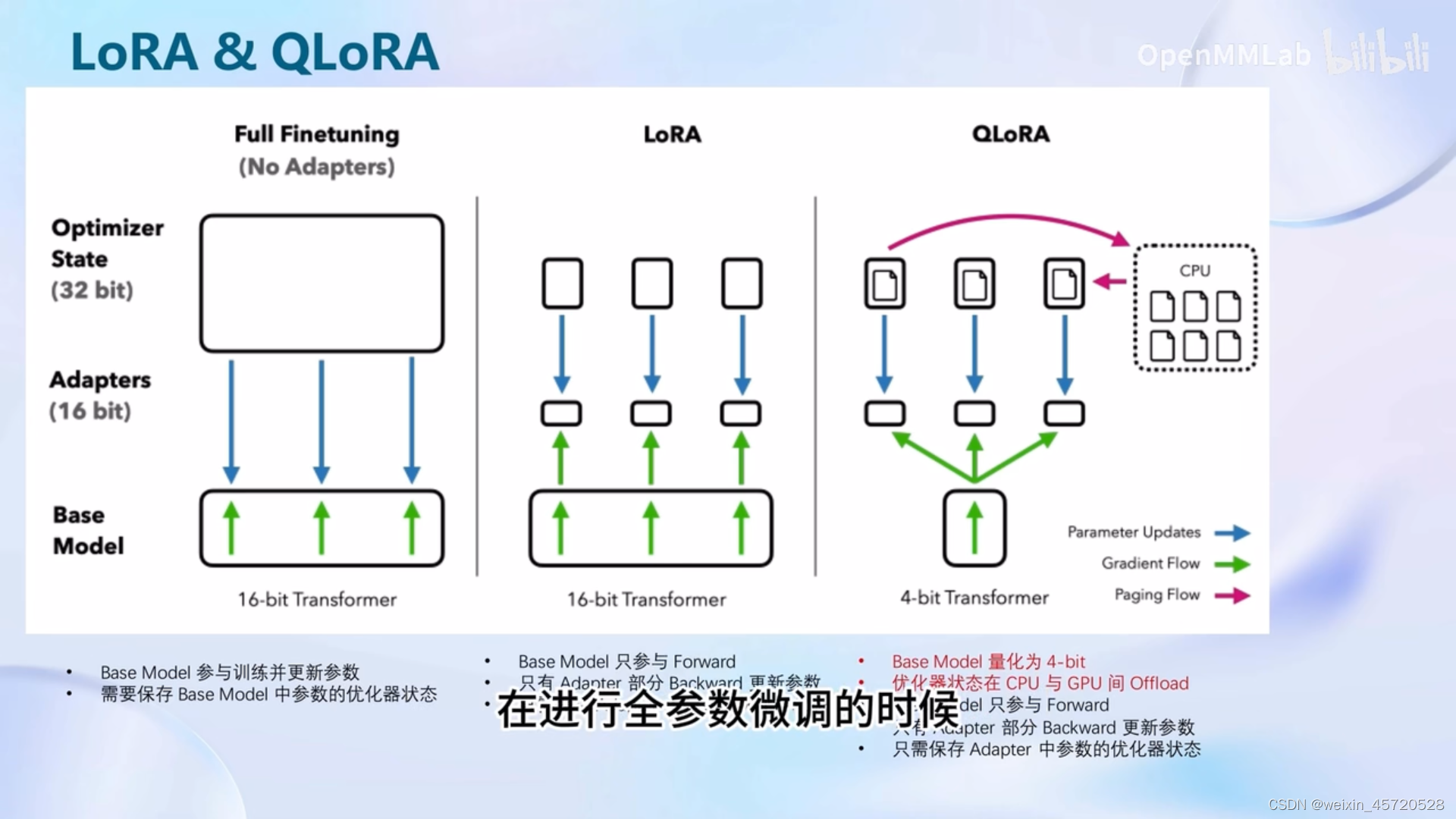

全参数微调 vs LoRA微调 vs QLoRA微调

二、Xtuner

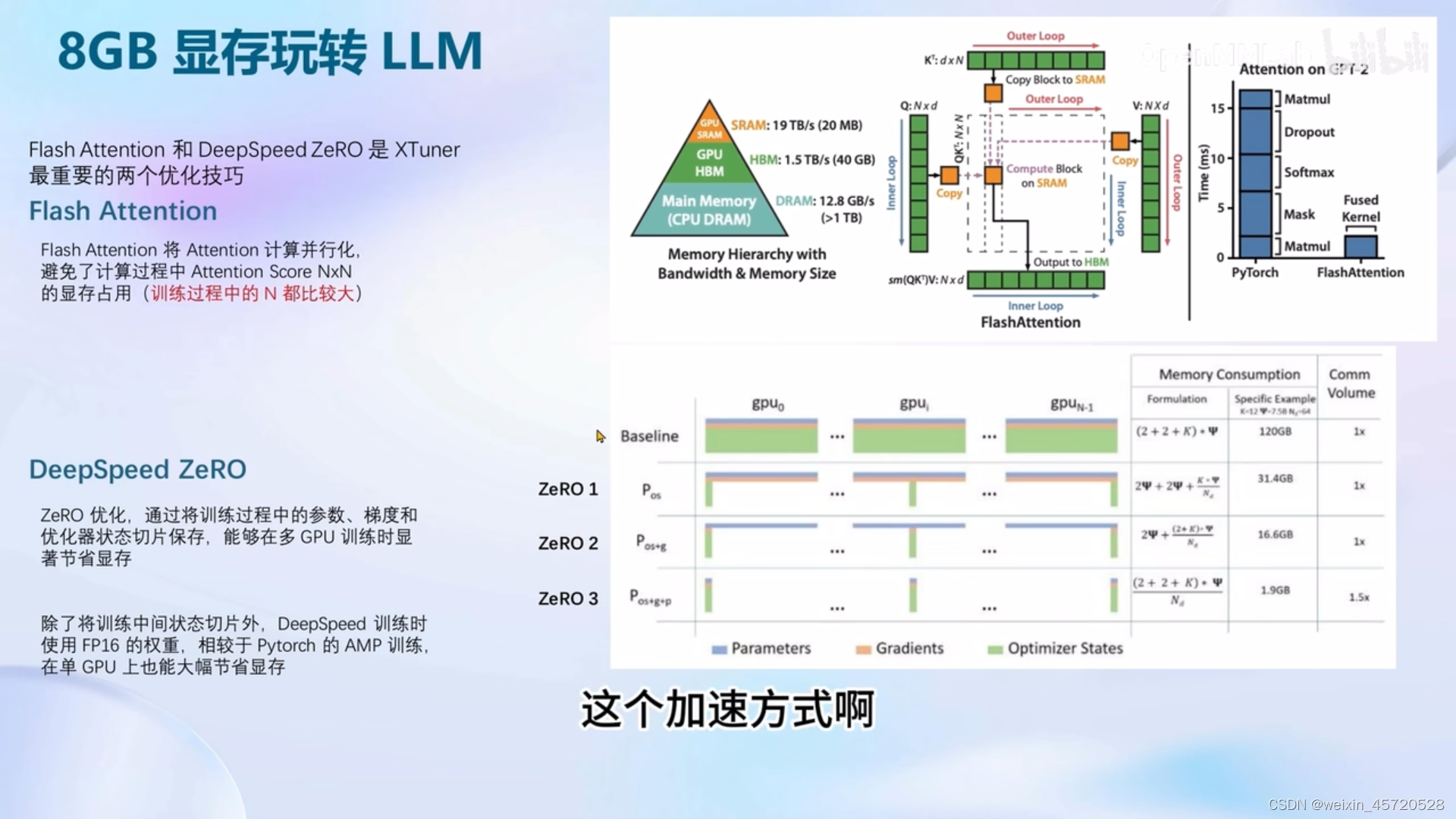

三、8GB玩转LLM

xtuner默认启动了flash attention

四、动手实战部分

这部分继续放上源文档

源视频

作业是一个更好的动手操作验证的例子

如果只做课后作业来实践的话,感觉这里可以着重看看那配置文件的常用超参部分,区分一下用基础模型的chat和基础模型加Adapter的chat以及merge后的chat,最后就是课程里补充的Ms-Agent 数据集赋予的LLM以Agent能力,可以学一下怎么训练到模型学会调用Agent。

五、课后作业

训练的时候可以改下batch也可以加快哦,我好像改到8了

若要开启 deepspeed 加速,增加 --deepspeed deepspeed_zero2 即可

作业参考源文档

作业源视频

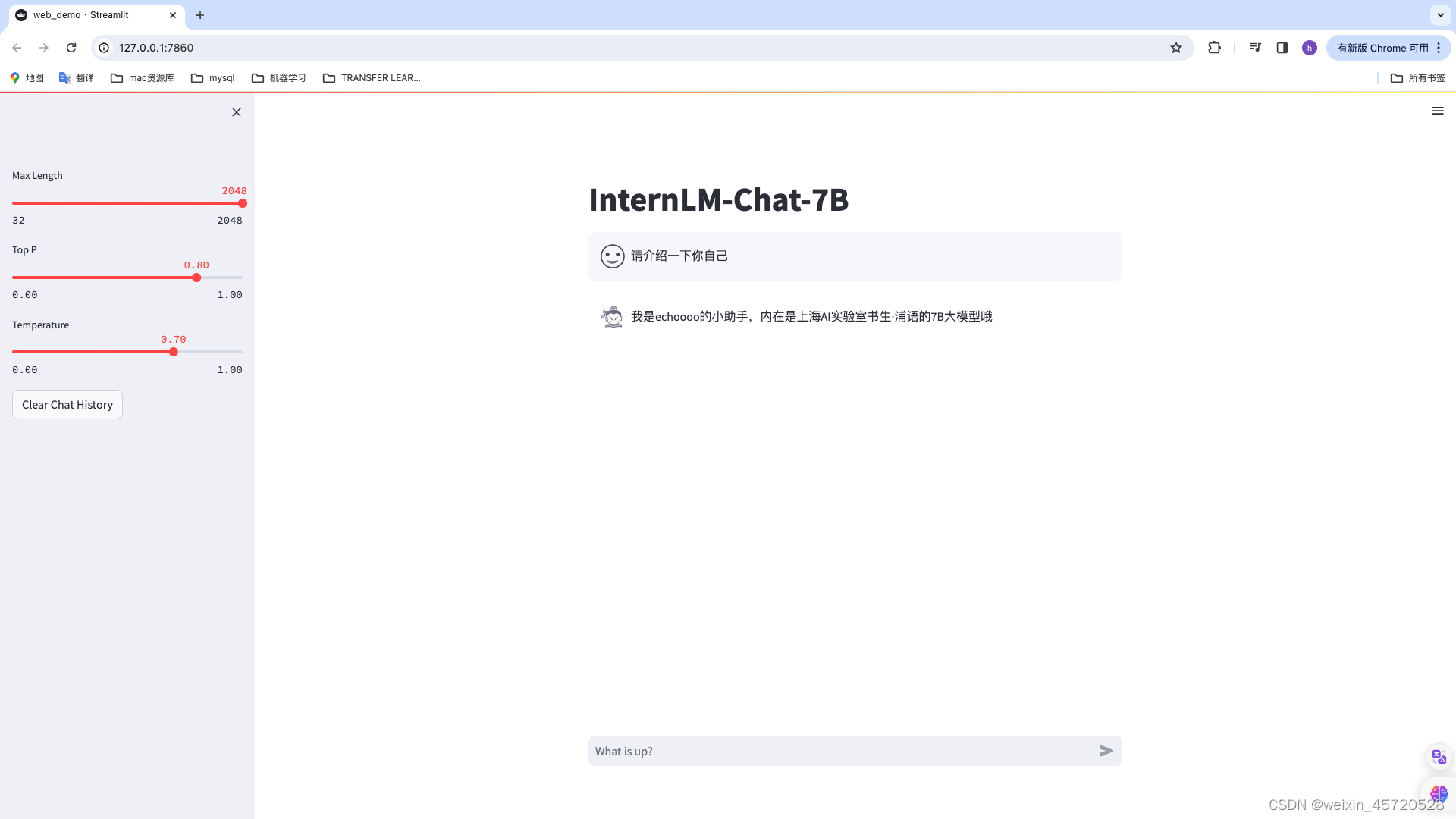

跟着这个微调的效果有点差强人意(过拟合了哈哈,如果不想过拟合训练的时候可以加点别的内容

以下是我的作业截图

总结

学习了一下对大模型的微调,估计还是要对数据集进行实操一下才能更深刻的理解,不过看看吧(希望不懒哈哈

115

115

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?