平替 GPT?谷歌 Gemini 本地化部署教程,轻松实现国内直联!附 Gemini API 使用的三种方法

你好,我是清风徐来

这是《ChatGPT ,从入门到精通》 系列第 161 篇原创文章。

今天,我将为您介绍如何申请 Gemini API Key 并使用开源项目 GeminiProChat,通过 Vercel 完成本地化部署,以便更好地利用 Gemini 的功能。

另外,GPT4.5 即将开放,注册 PLUS 会员看这里《支付宝申请 ChatGPT plus》

一、Gemini Pro 简介

大型语言模型的 AI 江湖,有五大门派:

"南帝"谷歌、"北丐"亚马逊,"东邪"马斯克、"西毒"开源的 LLAMA、"中神通" OpenAI,“老顽童”Newbing

Gemini 是"南帝"谷歌继巴德之后,推出的又一个大型文字模型

分为三个版本 Ultra,Pro, Nano

在谷歌的计划里,Ultra 对标 GPT-4 ;Pro 对抗 GPT3.5; Nano 剑指移动段。

Ultra 将于 2024 年初发布,

Gemini Pro 已于 12 月 8 日发布;Gemini Pro API 12 月 20 日左右发布

OpenAI 3.5 在官网使用是免费的,但 3.5 的 API KEY 是收费的!

Gemini Pro 无论官网、API 都是免费的,不过只支持欧美部分国家使用!

整个流程为:

-

① 申请 Gemini pro 的 API key; -

② 在 github(全球最大开源软件仓库)fork 开源项目 GeminiProChat; -

③GeminiProChat 部署到 vercle(全球主流免费服务部署网站)免费服务器上;将第 ① 步取得的 KEY 填入安装后的 GeminiProChat; -

④ 申请二级域名,达到国内直联的目的。

完成以上工作后,你就可以全部免费,国内直联使用 Genimi

二、准备工作

需要完成以下工作:

-

1、申请谷歌账号

详见《谷歌账号注册及切换语言的方法》

网址:google.com

-

2、申请 github 账号

网址:github.com

-

3、申请 vercel 账号

建议用 github 账号注册 vercel 账号,后面操作会简单一些

网址:vercel.com

-

4、稳定的上网环境,要求同 Gemini 网页版

部署期间需要,部署后国内直联

-

5、申请一个国内的二级域名

推荐腾讯云:buy.cloud.tencent.com/domain

注意:第 1-3 步都要科学!

三、具体部署

(一)第一步:申请 Gemini API Key

首先,我们需要在 Gemini 官方网站上申请 API Key。这个 API Key 将允许我们访问 Gemini。请按照以下步骤操作:

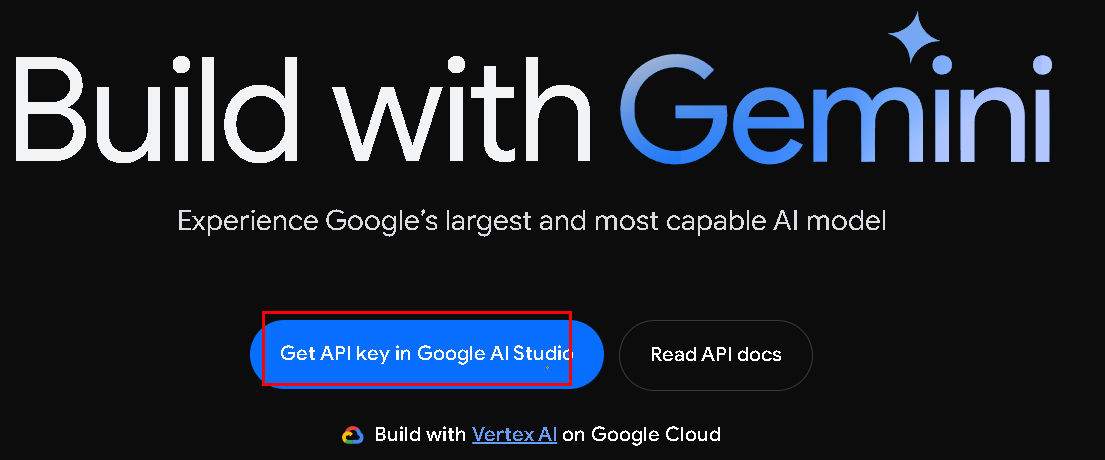

1、登录谷歌开发者平台

成功登陆谷歌账号后,点击以下网址:

ai.google.dev

界面如下:

点击“Get API key in google AI Studio”

2、进入创建 API 界面

点击:Creat new

3、复制 API key

与 openAI 不同,谷歌允许你到上述网址查看 key 值

在案例中,我取得 key 值如下:

AIzaSyBHiTTsDhtTmicC9eaAS4ZsIhbL-3W9gM4

第二步:fork GeminiProChat

GeminiProChat 是一个基于 Gemini API 构建的开源项目,它可以帮助您创建一个实时的聊天应用,用于使用 Gemini

网址: github.com/babaohuang/GeminiProChat

点击进入上述网址,界面如下:

点击“fork”。fork 的意思是复制

你注册了 github 空间,点击 fork 就会复制一个到你的 github 空间

第三步:在 vercel 中部署 GeminiProChat

1、导入 GeminiProChat

用 github 账号注册 vercel 账号后,可以直接从 vercel 中导入 github 你 fork 过的项目

登录:vercel.com/new

点击“continue with github"

进入以下界面,在“GeminiProChat”后点击导入 import

2、配置环境变量

-

Project Name:可按默认,也可自定义

Environment Variables:在“Key”中填入“GEMINI_API_KEY”;"Value" 中录入刚才申请的 KEY 后,点击 add.

-

其他参数不做修改

3、部署

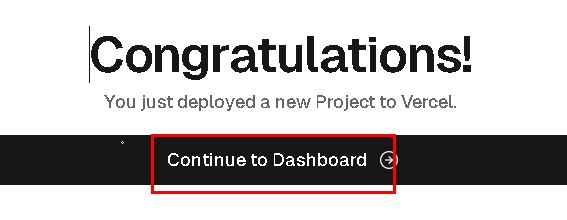

完成后点击“Deploy”

部署时间大概半分钟

出现以下祝贺页面,表示你已经部署成功!

vercel 会默认给你部署的系统一个二级域名,点击右上角 visit 或者网址进入

界面如下:

完成以上步骤后,您将能够通过 Vercel 提供的 URL 访问 GeminiProChat

(四)申请二级域名,达到国内直联的目的

1、生成二级域名

登录你的域名解析网站,如腾讯云,进入 DNS 解析界面

“主机记录”可自定义;“记录类型”,必须是“CNAME",“记录值”必须”cname.vercel-dns.com.“ ,其他默认

2、到 vercle 录入二级域名

假设我们设置的二级域名是https://gemini.yourdomon.com

录入后,点击“add”

过 1、2 分钟,搞定。Good news! Your DNS records are set up correctly, but it can take some time for them to propagate globally.

至此,我们完成了本地化部署并可以通过国内域名访问!

四、GeminiProChat 的初步测试

1、对话

2、不足

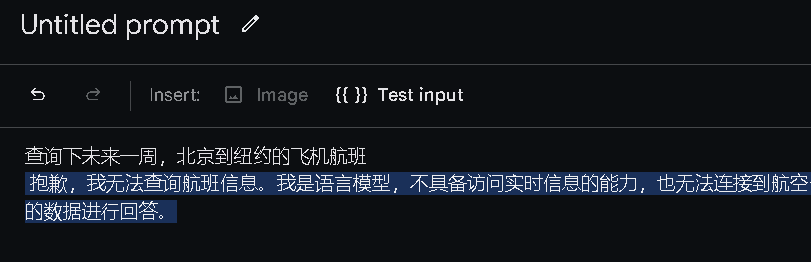

(1)未联网

(2)不能识图

点击图片上传按钮,提示 coming soon,估计还在开发

五、其他

我们还有其他方法可以使用 API

1、沉浸式翻译

很多第三方软件开始跟进 gemini,比如沉浸式翻译

2、官网 API 使用

进入 makersuite.google.com

有两个模型

(1)普通对话模型

(2)切换到 gemini pro v

可以查看谷歌云盘的文件(不支持其他地方图片)

(3)联网测试

看来,API 模式下,暂时都不能联网

好啦,这就是如何申请 Gemini API Key 并使用 GeminiProChat,通过 Vercel 完成本地化部署的步骤。

希望这个指南对您有所帮助,让您更好地利用 Gemini 的功能。如果您有任何问题或需要进一步的帮助,请随时联系我们。谢谢您的阅读!

祝愿您在 Gemini 交易中取得成功!

- END -本文由 mdnice 多平台发布

24万+

24万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?