《白话机器学习的数学》笔记02

目前以立石贤吾的《白话机器学习的数学》一书来作为深度学习的入门基础第一本参考书。意在了解机器学习与深度学习中所用到的基础数学知识与数学模型。

逻辑回归

上次看到感知机只能解决线性可分问题,本次来讨论如何解决线性不可分问题。

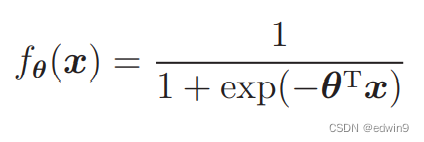

之前我们学习的是通过判别函数直接对图像进行分类,而本次所学习的分类则是通过概率来进行分类的算法,所用到的函数也是神经网络中的“老朋友”,sigmoid。

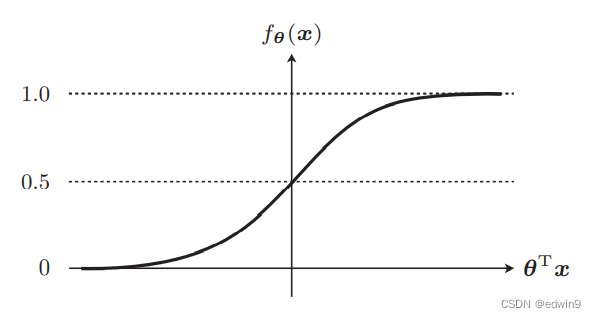

θTx = 0 时,fθ(x)=0.5,以及 0 < fθ(x) < 1 是 sigmoid 函数的两个特征。

根据函数图像我们可以知道θTx的正负关系着函数值究竟大于还是小于0.5,也就是说会影响我们判断的结果。

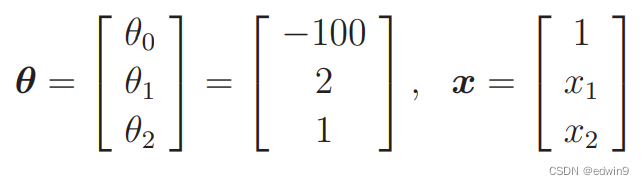

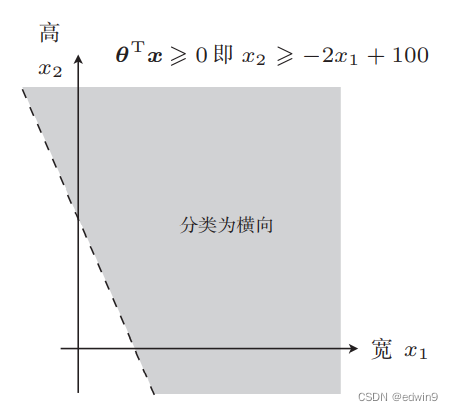

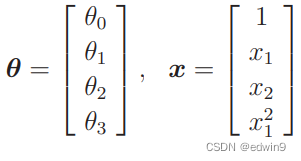

例如给定一组θ数值,令θTx≥0。

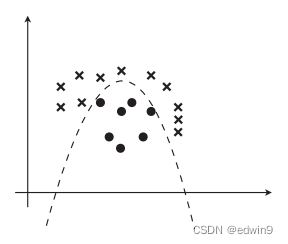

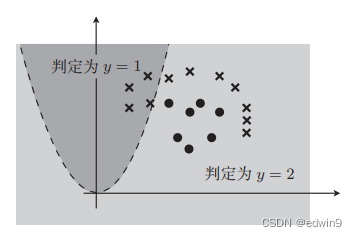

那么即可得到上图中阴影区域为可能性大的数据区域。其他区域则为可能性小于0.5的数值区域,这条分界线就被称之为决策边界。

上述例子的θ值为随便选择的一组值,而为了准确分类,需要对θ进行参数更新。

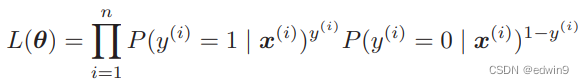

似然函数

上一节所使用的参数更新的目标函数是误差函数,目标为越小越好,本次由于函数值为0-1之间的概率,所以目标为判断正确的概率越大越好。此外,上一节的误差是将数据中的每个数据的误差进行平方后相加,而概率函数用这个显然不太合适,概率中的连续往往是以乘积的形式来体现的,所以本节目标函数的逻辑为将每次判断的概率进行连乘,越高说明判断正确的次数越多,准确性越高。

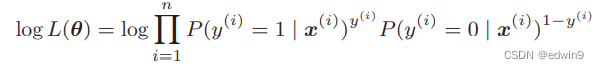

但是像联合概率这种概率乘法的值会越来越小,会出现计算量和计算精度的问题,所以采用对数函数,将乘法转化为加法,由于log函数本身单调递增,所以取对数后并不会影响取最大值。

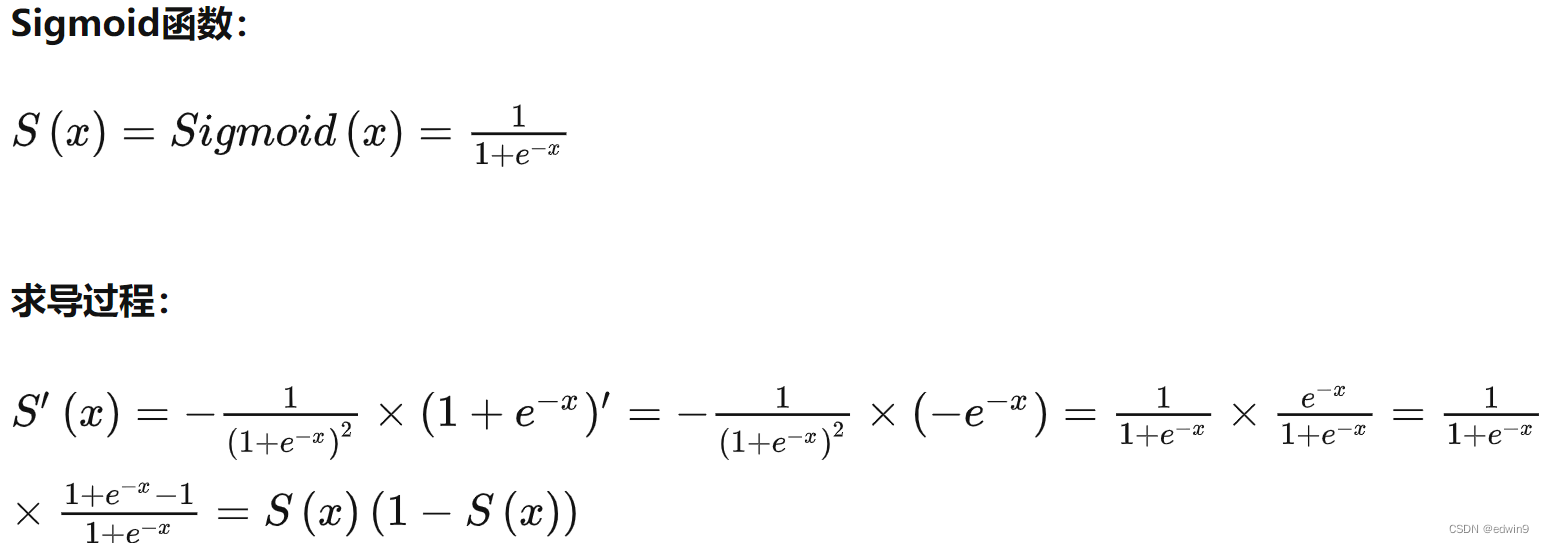

接下来仿照上一节的做法,让目标函数对参数θj做微分,求出参数更新式。此处过程大体与上节相同,有个sigmoid函数微分可以注意下。

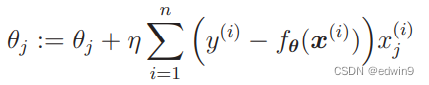

最终结果如下,注意,此处参数是为寻找最大值,所以方向与导数方向相同。

线性不可分

对于线性不可分的问题,因为分类也是在寻找一条线,所以我们可以参考上一篇笔记中多项式回归的思想,增加x的高次项。

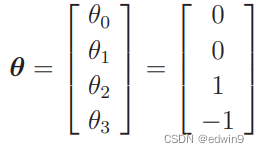

例如将θ设置为下面的向量

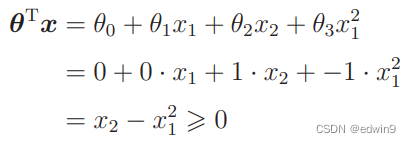

代入可得

那么分类曲线就是这种结果

所以通过这种办法,就可以完成复杂形状的决策边界,实现复杂的分类效果。

345

345

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?