目录

Compressive Expansion: Feature Space Support

Self-Activated Node Compression

Old Class Recalling: Feature Distribution Support

New Class Distribution Estimation.

Old Class Distribution Sampling

摘要

少样本类别增量学习Few-shot class-incremental learning (FSCIL) 面临着灾难性遗忘旧类别和过拟合新类别的挑战。分析表明,这些问题是由于特征分布崩溃造成的,当将少量样本连续嵌入到固定的特征空间时,会导致类混淆。作者提出了一个动态支持网络Dynamic Support Network(DSN),它是一个具有压缩节点扩展的自适应更新网络来“支持”特征空间。在每个训练环节中,DSN暂时扩展网络节点,以扩大增量类的特征表示能力。然后通过节点自激活动态压缩扩展的网络,追求紧凑的特征表示,从而缓解了过拟合。同时,DSN在增量学习过程中选择性地回忆旧类分布,以支持特征分布,避免类之间的混淆。具有压缩节点扩展和类分布召回的DSN为灾难性遗忘和过拟合问题提供了一个系统的解决方案。

introduction

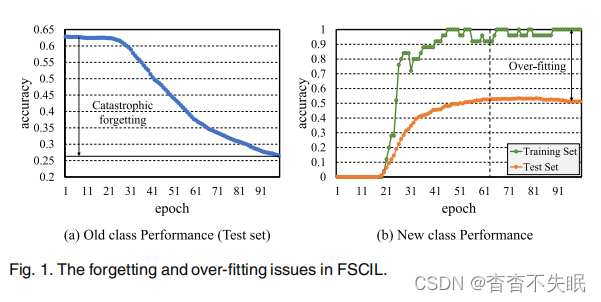

FSCIL面临着超越传统学习范式的挑战,一方面,用新的类对模型进行微调会扰乱旧类的特征分布,从而导致“灾难性遗忘”;另一方面,仅使用来自新类的少数样本进行的训练会将模型偏向旧类,从而导致分布崩溃和模型过度拟合,如图一所示

由于特征分布崩溃而引起的问题,图二(a),在很大程度上被忽略了,当不断地将样本很少的新类嵌入到基于旧类训练的特征空间时,这种疏忽极大地阻碍了模型的可伸缩性

论文提出了一个自适应但最小限度扩展的网络,称为动态支持网络(DSN),以在执行FSCIL任务时“支持”特征分布。在增量学习过程中,DSN暂时的扩展网络节点以聚合新类的表示能力,然后通过在节点扩展之前 (即,从旧类学习的表示) 和之后 (即,从新类学习的表示) 合并网络输出来获得新的特征表示。然后使用node self-activation mechanism节点自激活机制对扩展的网络进行压缩,以追求紧凑的特征表示,该特征表示不仅支持类分布,而且避免过拟合。具体来说,网络输出用于预测an indicator vector指标向量来突出网络节点重要性。然后,预测向量更新网络输出。通过迭代节点激活,DSN追求具有最小节点扩展的稀疏指标向量。同时,DSN在每个增量session中有选择地reca旧类。它首先估计当前session中的新类分布。在下一个session中,增量新类将更改为旧类,并执行采样过程以从旧类分布生成特征向量以进行模型训练。通过这种方式,支持特征分布,从而避免类混淆,图二(b)

主要贡献:

(1)提出了动态支持网络 (DSN),该网络为在FSCIL中观察到的遗忘和过拟合提供了特征空间正则化解决方案。

(2)设计了一种node self-activation mechanism节点自激活机制来产生sparse indicator vectors稀疏的指标向量,并追求最小的节点扩展以缓解过度拟合。

(3)设计了一种distribution recalling strategy分布召回策略,该策略从类分布中自适应地采样特征向量,并支持特征分布以避免类混淆。

(4)大大提高了FSCIL性能,并在常用基准上实现了最新的性能。

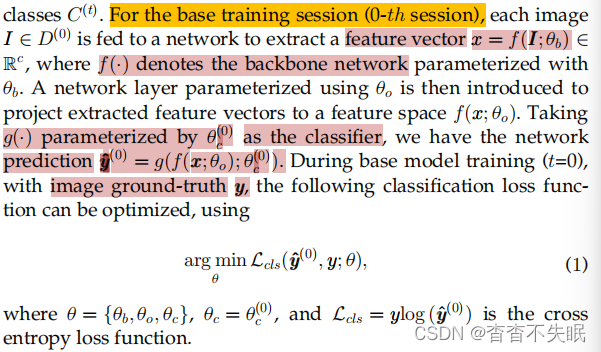

preliminary

FSCIL的一个解决方案是,首先用基类训练网络,然后使用来自增类的streaming datasets微调网络,在base training session阶段,每个图片被送入网络提取一个特征向量,然后引入一个利用![]() 参数化的网络层,将提取的特征向量投影到特征空间

参数化的网络层,将提取的特征向量投影到特征空间![]() 中

中

在增量学习阶段,为了分类新类,将附加的参数![]() 添加到网络的分类层,因此网络预测变为

添加到网络的分类层,因此网络预测变为![]() ,为避免忘记旧类,采用了知识蒸馏方法来保留从旧类中学习到的参数,蒸馏损失表示为Ldis

,为避免忘记旧类,采用了知识蒸馏方法来保留从旧类中学习到的参数,蒸馏损失表示为Ldis

通过知识蒸馏,上述方法减少了灾难性遗忘,但当只有少数训练例子可用时,仍然受到过拟合的挑战。然而,来自新类的少数样本使得很难保留旧的类分布,这将由下面介绍的DSN来解决。

DYNAMIC SUPPORT NETWORK

DSN是指一个自适应扩展的网络,在执行少样本类增量学习时“支持”特征空间。在每个增量session中,DSN利用压缩网络扩展来丰富特征表示,并recal旧类分布来动态地规范特征空间。

Compressive Expansion: Feature Space Support

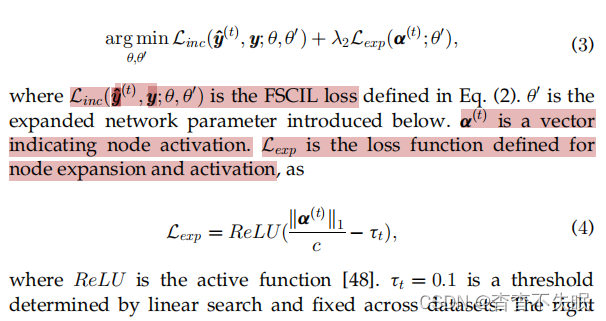

在训练增量类之前,不知道应该扩展多少个节点。论文建议暂时扩展网络,使其能够适应增量类。然后引入一种自激活机制来判断扩展的节点是否需要保留,即自激活的网络压缩。通过这种方式,DSN构建了一个最小的网络来支持所有类的分布,并正则化了特征空间,见图3。这是通过优化来实现的

Tentative Node Expansion

这是通过暂时向网络层中添加节点来实现的,见图3b。扩展层可以是最后一个卷积层,也可以是全连接(FC)层。扩展的节点数设置为等于扩展前的层数,从而丰富每个节点的特征。参数![]() 表示第t个训练session中的扩展层,扩展节点的特征输出和扩展前的节点输出结合起来

表示第t个训练session中的扩展层,扩展节点的特征输出和扩展前的节点输出结合起来 扩展网络的输出

扩展网络的输出

Self-Activated Node Compression

为了最小化扩展节点,变量向量a用来表示哪个节点代表了新类,有了indicator vector指示向量,扩展特征计算为

![]() 表示第i个扩展节点对于增量类别重要,

表示第i个扩展节点对于增量类别重要, 表示第i个扩展节点是没有意义的,为了实现自适应,a被设计为以一种积极的自激活的方式依赖于节点的输出,如

表示第i个扩展节点是没有意义的,为了实现自适应,a被设计为以一种积极的自激活的方式依赖于节点的输出,如

只有少数的新类样本可用时,额外的网络参数会聚集过拟合的风险。论文中指标向量a被设计为无参数的,即它们以正自激活的方式定义为网络节点值,保留与重要特征对应的稀疏网络节点,而丢弃与平凡特征对应的稀疏网络节点。这样,DSN实现了向紧凑特征表示方向的网络压缩

Old Class Recalling: Feature Distribution Support

虽然压缩网络扩展有助于支持特征空间,但缺乏对旧类分布的约束可能会导致新旧类之间的混淆。根据FSCIL的设置,在增量学习过程中,旧类样本将不可用。与此同时,记忆所有旧类数据是很昂贵的。为了解决这个问题,论文建议recal旧类分布来支持特征空间,图4。

New Class Distribution Estimation.

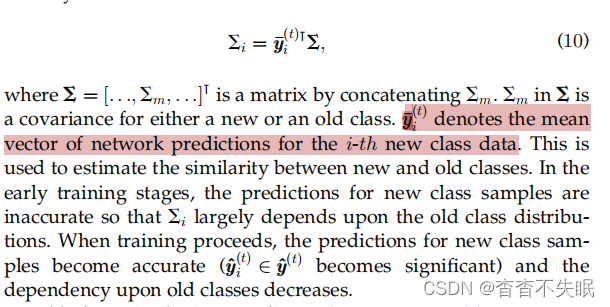

为了获得旧类分布,新类分布需要在当前的学习过程中进行估计。假设每个基类遵循高斯分布,一个基类的分布(即均值和协方差)可以由属于该类的所有样本来估计。假设少数样本遵循无偏分布,则可以根据这些例子计算出平均向量,xi表示为网络在第t次训练中生成的第i个新类的平均特征向量,xi的网络预测为![]() ,少样本的样本不足以精确地估计新类的协方差。受分布校准方法的启发,论文利用类似的旧类的分布来估计新类的协方差。对于第i个新类,协方差是由

,少样本的样本不足以精确地估计新类的协方差。受分布校准方法的启发,论文利用类似的旧类的分布来估计新类的协方差。对于第i个新类,协方差是由

Old Class Distribution Sampling

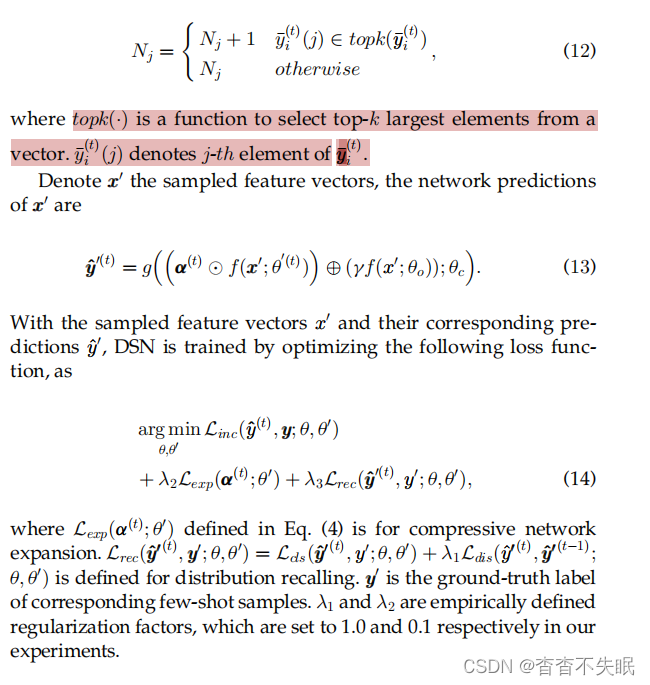

当增量学习进行时,在上一节中估计其分布的新类将变为旧类,然后在下一个增量会话中召回具有估计分布的旧类,以避免类混淆,这是通过从第j个旧类分布中采样nj特征向量来执行的

为了减少特征分布的混淆,从与新类接近的旧类中采样更多的特征向量。第j个类的采样数Nj由对第i个新类数据的预测的平均向量决定,分别为

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?