你学过电路吗?

你学过模电吗?

你学过数电吗?

你想自己做一个功放机吗?

跟着我们一起来学习一下呗!

首先来了解一下SK18752芯片:

SK18752功放芯片

最大不失真功率为25W,

电压在AC18~25V范围内均可正常工作,

音质比较均衡且中音比较迷人,

整流后电压在DC 25~33V正常工作。

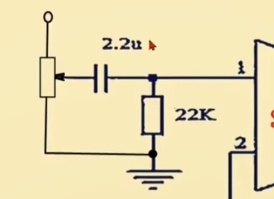

模块2调音量:

音量定位器箭头向上滑动,音量变大,

音量定位器箭头向下滑动,音量变小,

滑到最底,没有声音。

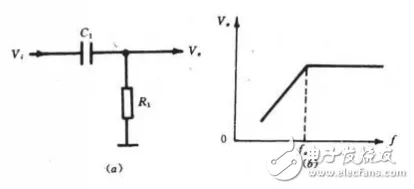

2.2uF电容与22k电阻组成高通滤波器,

其允许信号中的高频或交流分量通过,

而将低频或直流分量抑制住。

即滤除低频、保留高频。

当频率低于f。的信号输入这一滤波器时,

由于C1的容抗很大而受到阻止,输出减小,

且频率愈低输出愈小。

当频率高于f。的信号输入这一滤波器时,

由于C1容抗已很小,故对信号无衰减作用,

这样该滤波器具有让高频信号通过,

阻止低频信号的作用。这一电路的转折频率f。

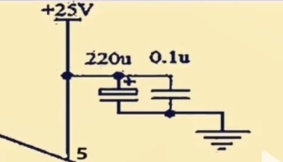

模块3电源滤波:

220uF电容并0.1uF电容

低高频滤波

电容并联放在IC电源脚到地,

一般是为了滤除那些对系统不利的交流信号。

220uF的电容和0.1uF一起

是为了使电源(或者是信号)对地的交流阻抗在很宽的频率范围内都很小,

这样交流成分能可以被滤除得更干净。

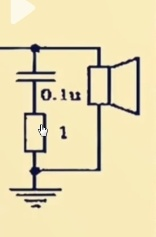

模块4负反馈电路:

22k为负反馈电阻,

输出放大倍数为:A=1+R22/(R1+1/wc),

1k与22uF的电容串联,对低频信号有衰减作用,

从而运放对低频信号有一定的提升作用。

模块5消除自激电路:

自激振荡:输入信号为零,输出端有一定频率一定幅值的交流信号

消除自激振荡:RC滞后补偿

1168

1168

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?